redis 缓存应用

第1章 部署与安装

wget http://download.redis.io/releases/redis-3.2.10.tar.gz

tar xf redis-3.2.10.tar.gz

cd redis-3.2.10/deps/

make geohash-int hiredis jemalloc linenoise lua

cd ..

make

简化路径

[root@db-03 data]# tail -1 /etc/profile

export PATH=$PATH:/server/tools/redis-3.2.10/src

开启注意路径

./redis-server &

进入

redis-cli (本机进入)

[root@db2 src]# pwd

/root/redis-3.2.10/src

[root@db2 src]# ./redis-cli -h 10.0.0.53 -a root(密码)(远程进入)

或者

redis-cli -h 10.0.0.52

auth 123

1.1 修改配置

首先关闭redis

[root@redis ~]# redis-cli

127.0.0.1:6379> auth 123

OK

127.0.0.1:6379> shutdown

创建data目录

vim /etc/redis.conf

daemonize no/yes #是否后台运行:

port 6379 #默认端口:

appendonly no/yes # AOF日志开关是否打开:

logfile /data/6379/redis.log #日志文件位置

dbfilename dump.rdb #RDB持久化数据文件:

===================================================================================================

三种设置链接策略(配置文件中)

Bind

指定IP进行监听 bind 10.0.0.52 ip2 ip3 ip4 常用

禁止protected-mode

protected-mode yes/no (保护模式,是否只允许本地访问) 不常用

增加requirepass {password} 常用

requirepass root

在redis-cli中使用

auth {password} 进行认证

===================================================================================================

在线查询配置信息:

127.0.0.1:6379> config get *

获取的的信息一般两行为一对儿,上面是是键,下面是值。修改键值的时候config set *

127.0.0.1:6379> config get requirepass 密码

在线修改

127.0.0.1:6379> config set requirepass 123

第2章 Redis数据持久化

2.1 RDB

持久化:基于快照的持久化功能。保存一个时刻的数据状态。企业常用的持久化功能,一般还可以用作备份。

配置如下黑体部分

命令行每次执行一次save就相当于是持久化一次,但是在配置文件中可以使用指定时间+次数的持久化。

[root@db-03 ~]# cat /etc/redis.conf

daemonize yes

port 6379

logfile /data/6379/redis.log

requirepass root

dbfilename dump.rdb #持久化文件名

dir /data/6379 #持久化文件存放位置

save 900 1 #900秒(15分钟)内有1个更改

save 300 10 #300秒(5分钟)内有10个更改

save 60 10000 #60秒内有10000个更改

appendfsync everysec

stop-writes-on-bgsave-error yes #后台备份进程出错时,主进程停不停止写入? 主进程不停止容易造成数据不一致

rdbcompression yes #导出的rdb文件是否压缩 如果rdb的大小很大的话建议这么做

rdbchecksum yes #导入rbd恢复时数据时,要不要检验rdb的完整性 验证版本是不是一致

2.2 AOF

持久化:只追加日志的模式,会将redis一段时间内修改命令记录下来。较为安全的一种持久化方式。

appendonly yes #是否打开aof日志功能

appendfilename "appendonly.aof" # aof文件名字

以下配置三选一:

appendfsync always #每1个命令,都立即同步到aof

appendfsync everysec #每秒写1次

appendfsync no #写入工作交给操作系统,由操作系统判断缓冲区大小,统一写入到aof.

===================================================================================================

额外的配置参数:

no-appendfsync-on-rewrite yes/no

auto-aof-rewrite-percentage 100

auto-aof-rewrite-min-size 64mb 一般会用到

正在导出rdb快照的过程中,要不要停止同步aof

aof文件大小比起上次重写时的大小,增长率100%时重写,缺点:业务开始的时候,会重复重写多次。

aof文件,至少超过64M时,重写

第3章 五种数据类型

String 字符串类型

Hash 字典类型

List 列表

Set 集合

Sorted set 有序集合

3.1 全局key

key: value

键 : 值

name : zhang3

stu: id 1 name zhang3

name: [zhangsan,lisi,wangwu]

---------------------------

KEYS * 查看KEY支持通配符

DEL 删除给定的一个或多个key

EXISTS 检查是否存在

RENAME 变更KEY名

SORT 键值排序,有非数字时报错

TYPE 返回键所存储值的类型

DUMP RESTORE 序例化与反序列化

EXPIRE\ PEXPIRE 以秒\毫秒设定生存时间

TTL\ PTTL 以秒\毫秒为单位返回生存时间

PERSIST 取消生存实现设置

RANDOMKEY 返回数据库中的任意键

3.2 String 字符串类型

String 字符串类型

应用场景

常规计数:微博数,粉丝数等

incr 加

decr 减

INCRBY jnl 10000

decrby jnl 5000

set test hello 设置单个键值对儿

get test

mset bq wangbaoqiang yf chengyufan 设置多个键值对儿

mget bq yf 取出多个键值对儿的值

APPEND bq shigehaoren 追加键值对的值

===================

增

set mykey "test" 为键设置新值,并覆盖原有值

getset mycounter 0 设置值,取值同时进行

setex mykey 10 "hello" 设置指定 Key 的过期时间为10秒,在存活时间可以获取value

setnx mykey "hello" 若该键不存在,则为键设置新值

mset key3 "zyx" key4 "xyz" 批量设置键

删

del mykey 删除已有键

改

append mykey "hello" 若该键并不存在,返回当前 Value 的长度

该键已经存在,返回追加后 Value的长度

incr mykey 值增加1,若该key不存在,创建key,初始值设为0,增加后结果为1

decrby mykey 5 值减少5

setrange mykey 20 dd 把第21和22个字节,替换为dd, 超过value长度,自动补0

查

exists mykey 判断该键是否存在,存在返回 1,否则返回0

get mykey 获取Key对应的value

strlen mykey 获取指定 Key 的字符长度

ttl mykey 查看一下指定 Key 的剩余存活时间(秒数)

getrange mykey 1 20 获取第2到第20个字节,若20超过value长度,则截取第2个和后面所有的

mget key3 key4 批量获取键

3.3 hash

应用场景:

存储部分变更的数据,如用户信息等。

stu1:

id name age gender filed

1 2 3 4 value

hmset stu id 1 name zhang3 age 20 gender male

hmget stu id name age gender

hgetall stu

增

hset myhash field1 "s"

若字段field1不存在,创建该键及与其关联的Hashes, Hashes中,key为field1 ,并设value为s ,若存在会覆盖原value

hsetnx myhash field1 s

若字段field1不存在,创建该键及与其关联的Hashes, Hashes中,key为field1 ,并设value为s, 若字段field1存在,则无效

hmset myhash field1 "hello" field2 "world 一次性设置多个字段

删

hdel myhash field1 删除 myhash 键中字段名为 field1 的字段

del myhash 删除键

改

hincrby myhash field 1 给field的值加1

查

hget myhash field1 获取键值为 myhash,字段为 field1 的值

hlen myhash 获取myhash键的字段数量

hexists myhash field1 判断 myhash 键中是否存在字段名为 field1 的字段

hmget myhash field1 field2 field3 一次性获取多个字段

hgetall myhash 返回 myhash 键的所有字段及其值

hkeys myhash 获取myhash 键中所有字段的名字

hvals myhash

3.4 List列表

应用场景

消息队列系统

比如sina微博:

在Redis中我们的最新微博ID使用了常驻缓存,这是一直更新的。

但是做了限制不能超过5000个ID,因此获取ID的函数会一直询问Redis。

只有在start/count参数超出了这个范围的时候,才需要去访问数据库。

系统不会像传统方式那样“刷新”缓存,Redis实例中的信息永远是一致的。

SQL数据库(或是硬盘上的其他类型数据库)只是在用户需要获取“很远”的数据时才会被触发,

而主页或第一个评论页是不会麻烦到硬盘上的数据库了。

lpush weibo "today is happy day"

LRANGE weibo 0 -1 从0开始到-1结束

增

lpush mykey a b 若key不存在,创建该键及与其关联的List,依次插入a ,b, 若List类型的key存在,则插入value中

lpushx mykey2 e 若key不存在,此命令无效, 若key存在,则插入value中

linsert mykey before a a1 在 a 的前面插入新元素 a1

linsert mykey after e e2 在e 的后面插入新元素 e2

rpush mykey a b 在链表尾部先插入b,在插入a

rpushx mykey e 若key存在,在尾部插入e, 若key不存在,则无效

rpoplpush mykey mykey2 将mykey的尾部元素弹出,再插入到mykey2 的头部(原子性的操作)

删

del mykey 删除已有键

lrem mykey 2 a 从头部开始找,按先后顺序,值为a的元素,删除数量为2个,若存在第3个,则不删除

ltrim mykey 0 2 从头开始,索引为0,1,2的3个元素,其余全部删除

改

lset mykey 1 e 从头开始, 将索引为1的元素值,设置为新值 e,若索引越界,则返回错误信息

rpoplpush mykey mykey 将 mykey 中的尾部元素移到其头部

查

lrange mykey 0 -1 取链表中的全部元素,其中0表示第一个元素,-1表示最后一个元素。

lrange mykey 0 2 从头开始,取索引为0,1,2的元素

lrange mykey 0 0 从头开始,取第一个元素,从第0个开始,到第0个结束

lpop mykey 获取头部元素,并且弹出头部元素,出栈

lindex mykey 6 从头开始,获取索引为6的元素 若下标越界,则返回nil

3.5 Set集合

应用场景:

案例:

在微博应用中,可以将一个用户所有的关注人存在一个集合中,将其所有粉丝存在一个集合。

Redis还为集合提供了求交集、并集、差集等操作,可以非常方便的实现如共同关注、共同喜好、二度好友等功能.

对上面的所有集合操作,你还可以使用不同的命令选择将结果返回给客户端还是存集到一个新的集合中。

sadd jnl a b c

sadd lxl x y z b a

siner

sdiff

sunion

增

sadd myset a b c

若key不存在,创建该键及与其关联的set,依次插入a ,b,若key存在,则插入value中,若a 在myset中已经存在,则插入了 d 和 e 两个新成员。

删

spop myset 尾部的b被移出,事实上b并不是之前插入的第一个或最后一个成员

srem myset a d f 若f不存在, 移出 a、d ,并返回2

改

smove myset myset2 a 将a从 myset 移到 myset2,

查

sismember myset a 判断 a 是否已经存在,返回值为 1 表示存在。

smembers myset 查看set中的内容

scard myset 获取Set 集合中元素的数量

srandmember myset 随机的返回某一成员

sdiff myset1 myset2 myset3 1和2得到一个结果,拿这个集合和3比较,获得每个独有的值

sdiffstore diffkey myset myset2 myset3 3个集和比较,获取独有的元素,并存入diffkey 关联的Set中

sinter myset myset2 myset3 获得3个集合中都有的元素

sinterstore interkey myset myset2 myset3 把交集存入interkey 关联的Set中

sunion myset myset2 myset3 获取3个集合中的成员的并集

sunionstore unionkey myset myset2 myset3 把并集存入unionkey 关联的Set中

3.6 Sorted set有序集合

应用场景:

排行榜应用,取TOP N操作

这个需求与上面需求的不同之处在于,前面操作以时间为权重,这个是以某个条件为权重,比如按顶的次数排序,

这时候就需要我们的sorted set出马了,将你要排序的值设置成sorted set的score,将具体的数据设置成相应的value,

每次只需要执行一条ZADD命令即可。

zadd top10 1000 tm 2000 by

zadd top10 6000000 bjjsxh

ZINCRBY top10 10000000000 by

ZREVRANGE top10 0 -1 withscores

------------------------------------

增

zadd myzset 2 "two" 3 "three" 添加两个分数分别是 2 和 3 的两个成员

删

zrem myzset one two 删除多个成员变量,返回删除的数量

改

zincrby myzset 2 one 将成员 one 的分数增加 2,并返回该成员更新后的分数

查

zrange myzset 0 -1 WITHSCORES 返回所有成员和分数,不加WITHSCORES,只返回成员

zrank myzset one 获取成员one在Sorted-Set中的位置索引值。0表示第一个位置

zcard myzset 获取 myzset 键中成员的数量

zcount myzset 1 2 获取分数满足表达式 1 <= score <= 2 的成员的数量

zscore myzset three 获取成员 three 的分数

zrangebyscore myzset 1 2 获取分数满足表达式 1 < score <= 2 的成员

#-inf 表示第一个成员,+inf最后一个成员

#limit限制关键字

#2 3 是索引号

zrangebyscore myzset -inf +inf limit 2 3 返回索引是2和3的成员

zremrangebyscore myzset 1 2 删除分数 1<= score <= 2 的成员,并返回实际删除的数量

zremrangebyrank myzset 0 1 删除位置索引满足表达式 0 <= rank <= 1 的成员

zrevrange myzset 0 -1 WITHSCORES 按位置索引从高到低,获取所有成员和分数

#原始成员:位置索引从小到大

one 0

two 1

#执行顺序:把索引反转

位置索引:从大到小

one 1

two 0

#输出结果: two

one

zrevrange myzset 1 3 获取位置索引,为1,2,3的成员

#相反的顺序:从高到低的顺序

zrevrangebyscore myzset 3 0 获取分数 3>=score>=0的成员并以相反的顺序输出

zrevrangebyscore myzset 4 0 limit 1 2 获取索引是1和2的成员,并反转位置索引

------------------------------------

3.7 发布订阅

PUBLISH channel msg

将信息 message 发送到指定的频道 channel?

SUBSCRIBE channel [channel ...]

订阅频道,可以同时订阅多个频道

UNSUBSCRIBE [channel ...]

取PSUBSCRIBE消订阅指定的频道, 如果不指定频道,则会取消订阅所有频道

pattern [pattern ...]

订阅一个或多个符合给定模式的频道,每个模式以 * 作为匹配符,比如 it* 匹配所 有以 it 开头的频道( it.news 、 it.blog 、 it.tweets 等等), news.* 匹配所有 以 news. 开头的频道( news.it 、 news.global.today 等等),诸如此类

PUNSUBSCRIBE [pattern [pattern ...]]

退订指定的规则, 如果没有参数则会退订所有规则

PUBSUB subcommand [argument [argument ...]]

查看订阅与发布系统状态

注意:使用发布订阅模式实现的消息队列,当有客户端订阅channel后只能收到后续发布到该频道的消息,之前发送的不会缓存,必须Provider和Consumer同时在线。

-------------------------------------

DISCARD

取消事务,放弃执行事务块内的所有命令。

EXEC

执行所有事务块内的命令。

MULTI

标记一个事务块的开始。

UNWATCH

取消 WATCH 命令对所有 key 的监视。

WATCH key [key ...]

监视一个(或多个) key ,如果在事务执行之前这个(或这些) key 被其他命令所改动,那么事务将被打断。

---------------------------------

ZADD salary 2000 user1

ZADD salary 3000 user2

ZRANGE salary 0 -1 WITHSCORES

MULTI

ZINCRBY salary 1000 user1

ZINCRBY salary -1000 user2

EXEC

3.8 常用命令

Info 列出信息

Clinet list

Client kill ip:port 杀掉远程redis服务

config get *

CONFIG RESETSTAT 重置统计

CONFIG GET/SET 动态修改

Dbsize 统计多少个键

FLUSHALL 清空所有数据

select 1

FLUSHDB 清空当前库

MONITOR 监控实时指令

redis默认0-15 个库。高可用的时候默认是在0号库

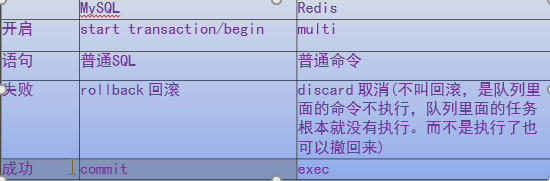

第4章 redis的事物

redis中的事务跟关系型数据库中的事务是一个相似的概念,但是有不同之处。关系型数据库事务执行失败后面的sql语句不在执行,而redis中的一条命令执行失败,其余的命令照常执行。

redis中开启一个事务是使用multi,相当于begin\start transact ion, exec:提交事务,discard取消队列命令(非回滚操作)

127.0.0.1:6379> multi 开启一个事物(母体)

OK

127.0.0.1:6379> set num 1 以消息队列的方式开始执行

QUEUED

127.0.0.1:6379> exec 输入exec结束

1) OK

127.0.0.1:6379> get num

"1"

127.0.0.1:6379> multi

OK

127.0.0.1:6379> set a 1

QUEUED

127.0.0.1:6379> sr 4 2

(error) ERR unknown command 'sr'

127.0.0.1:6379> exec

(error) EXECABORT Transaction discarded because of previous errors.

在开启事务的过程中如果输入的有错误就会在exec的时候提示discard掉了。全部取消,不同于MySQL中的滚。

MySQL是通过日志事物的方式执行的,redis中是通过消息队列的方式。

4.1 redis事物中的锁机制

举例:我正在买票

Ticket -1 money -100

而票只有1张,如果在我multi之 后,和exec之前,票被别人买了---即ticket变成0了.

我该如何观察这种情景,并不再提交

悲观的想法:

世界充满危险,肯定有人和我抢,给ticket. 上锁,只有我能操作. [悲观锁]

乐观的想法:

没有那么人和我抢,因此,我只需要注意,有没有人更改ticket的值就可以了[乐观锁]

Redis的事务中,启用的是乐观锁,只负责监测key没有被改动.

实验

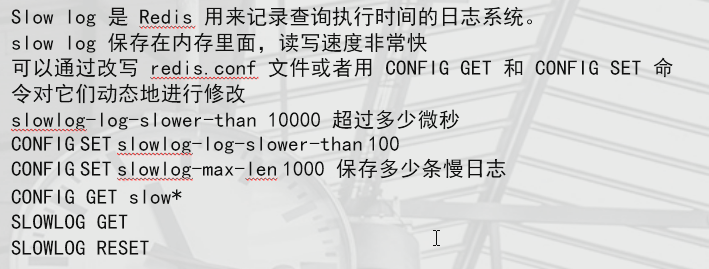

第5章 慢日志查询

slowlog-log-slower-than 10000 超过多少微秒

CONFIG SET slowlog-log-slower-than 100

CONFIG SET slowlog-max-len 1000 保存多少条慢日志

CONFIG GET slow*

SLOWLOG GET

SLOWLOG RESET

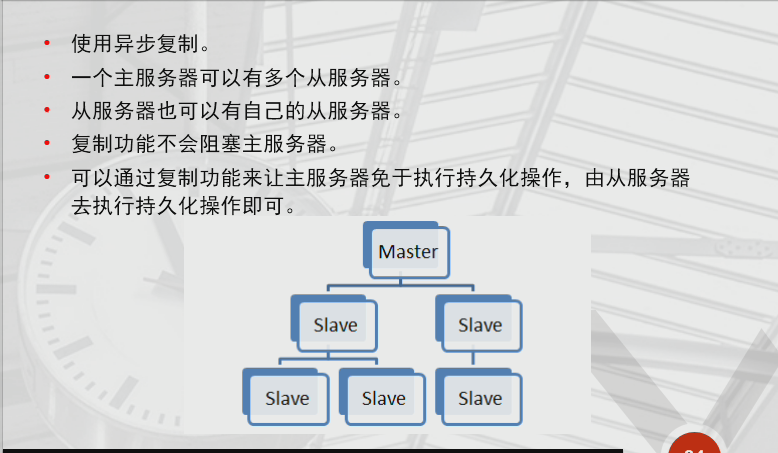

第6章 Redis主从复制

6.1 原理

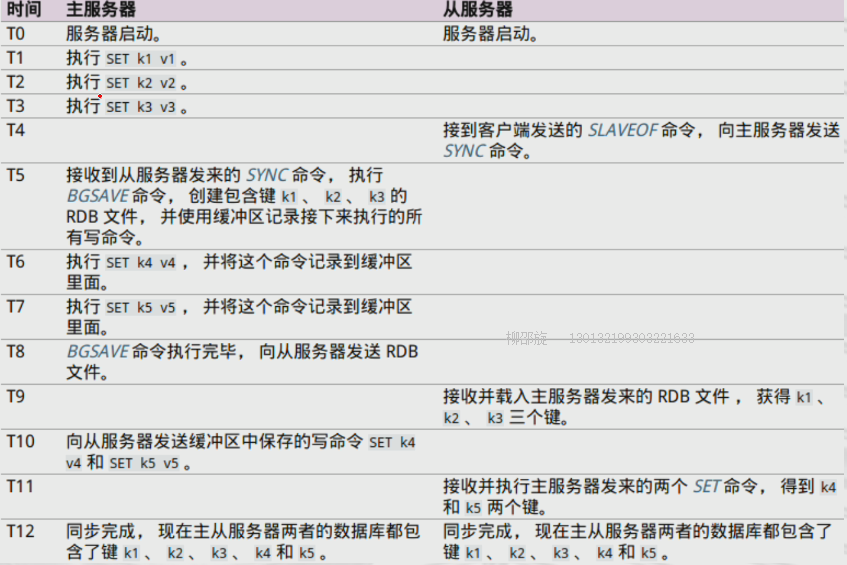

6.2 SYNC执行实例

6.3 命令传播

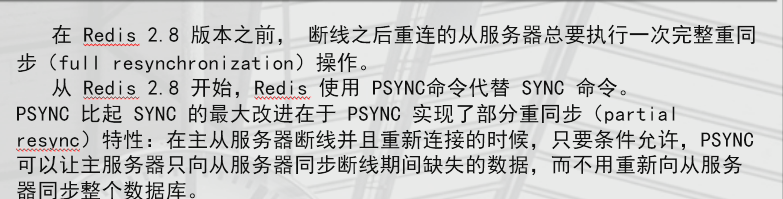

6.4 SYNC和PSYNC的比较

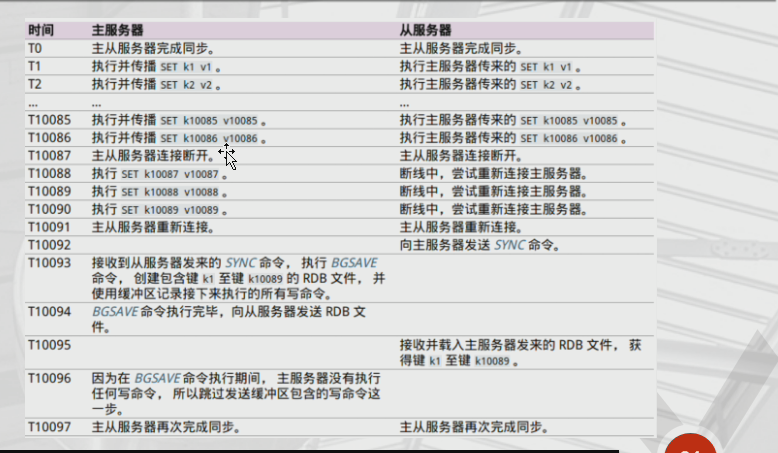

6.5 SYNC处理断线示例

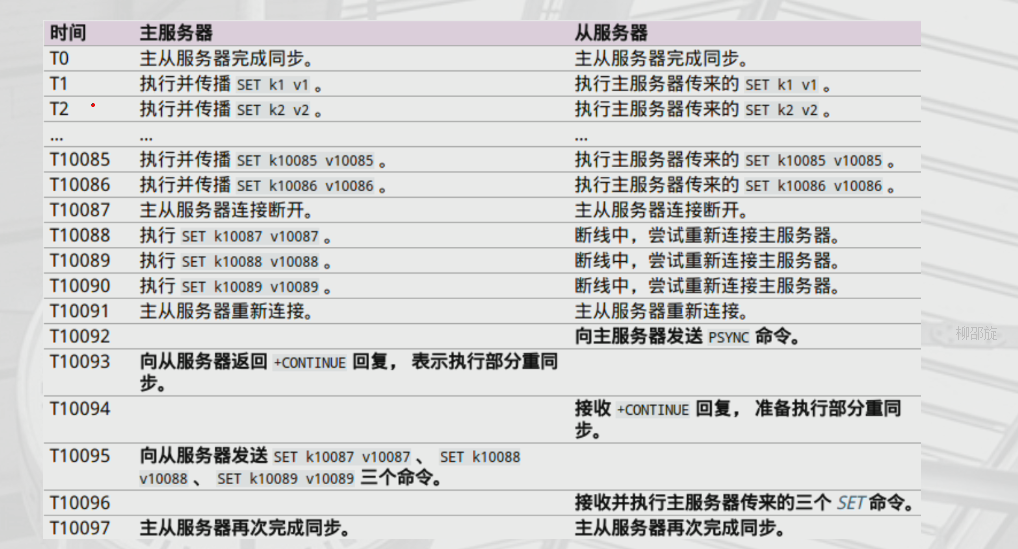

6.6 PSYNC处理断线示例

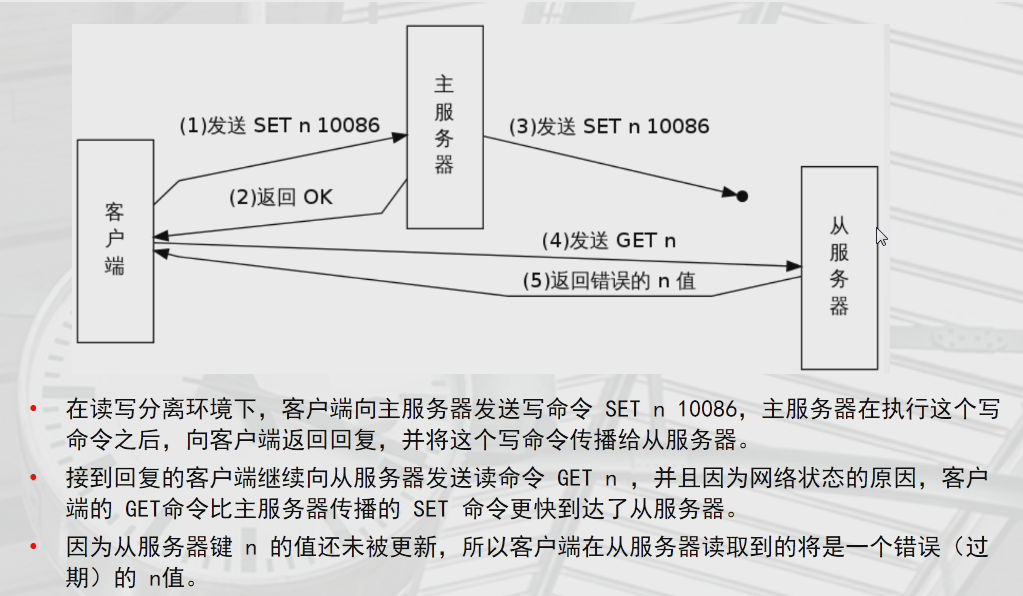

6.7 针对以读写分离架构的复制的一致性问题

6.7.1 复制安全性的提升

6.8 目录规划

原理:通过RDB快照技术实现的主从复制

6380:

/data/6380

/data/6380/redis.conf

6381

/data/6380

/data/6380/redis.conf

6382

/data/6380

/data/6380/redis.conf

创建目录

mkdir -p /data/638{0..2}

配置文件

vim /data/6380/redis.conf

port 6380

daemonize yes

pidfile /data/6380/redis.pid

loglevel notice

logfile "/data/6380/redis.log"

dbfilename dump.rdb

dir /data/6380

protected-mode no

vim /data/6381/redis.conf

port 6381

daemonize yes

pidfile /data/6381/redis.pid

loglevel notice

logfile "/data/6381/redis.log"

dbfilename dump.rdb

dir /data/6381

protected-mode no

vim /data/6382/redis.conf

port 6382

daemonize yes

pidfile /data/6382/redis.pid

loglevel notice

logfile "/data/6382/redis.log"

dbfilename dump.rdb

dir /data/6382

protected-mode no

6.9 启动多个实例

redis-server /data/6380/redis.conf &\

redis-server /data/6381/redis.conf &\

redis-server /data/6382/redis.conf &

6.10 开启主从复制

从库6381、6382 主库6380

[root@db-03 ~]# redis-cli -p 6381

127.0.0.1:6381> SLAVEOF 127.0.0.1 6380

[root@db-03 ~]# redis-cli -p 6382

127.0.0.1:6382> SLAVEOF 127.0.0.1 6380

---------------------主库状态

[root@ db-03 ~]# redis-cli -p 6380

127.0.0.1:6380> info replication

# Replication

role:master

connected_slaves:2

slave0:ip=127.0.0.1,port=6381,state=online,offset=57,lag=1

slave1:ip=127.0.0.1,port=6382,state=online,offset=57,lag=1

master_repl_offset:57

repl_backlog_active:1

repl_backlog_size:1048576

repl_backlog_first_byte_offset:2

repl_backlog_histlen:56

127.0.0.1:6380>

----------------------从库状态

127.0.0.1:6382> info replication

# Replication

role:slave

master_host:127.0.0.1

master_port:6380

master_link_status:up

master_last_io_seconds_ago:9

master_sync_in_progress:0

slave_repl_offset:71

slave_priority:100

slave_read_only:1

connected_slaves:0

master_repl_offset:0

repl_backlog_active:0

repl_backlog_size:1048576

repl_backlog_first_byte_offset:0

repl_backlog_histlen:0

127.0.0.1:6382>

第7章 redis sentinel哨兵,实现redis主从高可用自动切换

7.1 sentinel 介绍

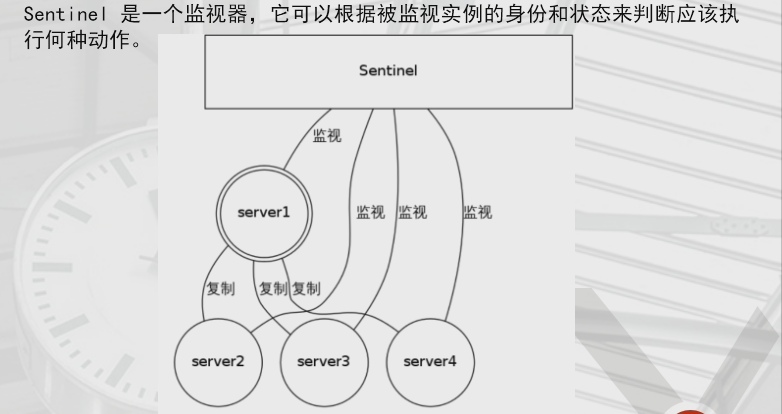

7.2 sentinel 构造

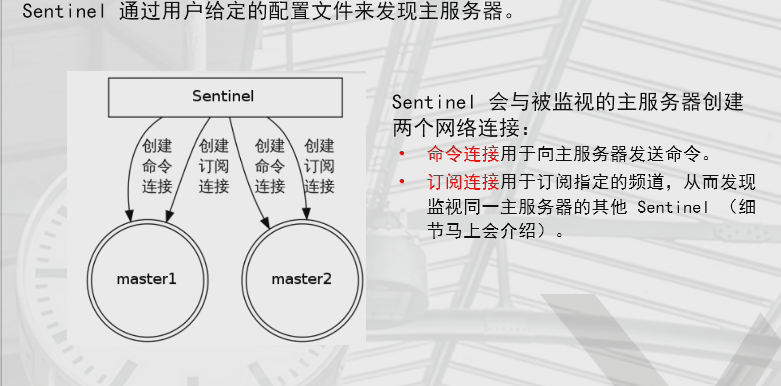

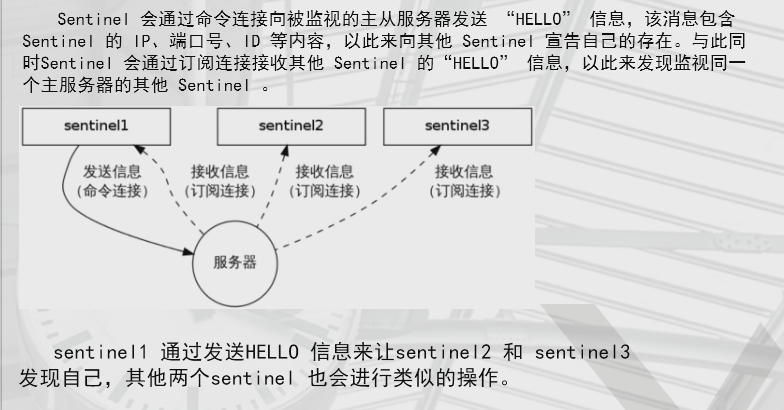

7.2.1 发现并连接主服务器

7.3 发现其他sentinel

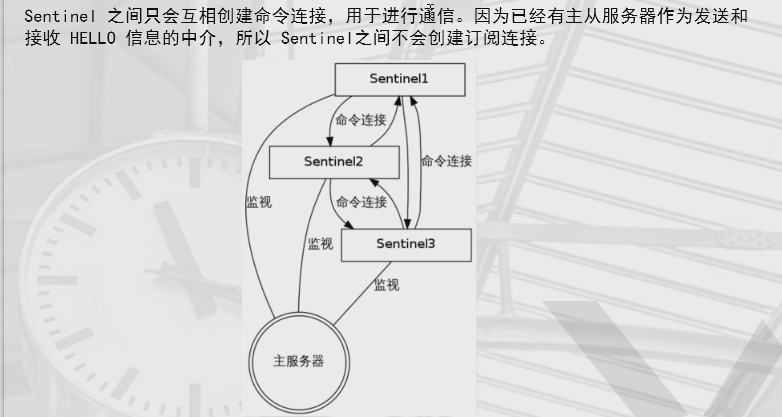

7.3.1 多个sentinel之间的连系

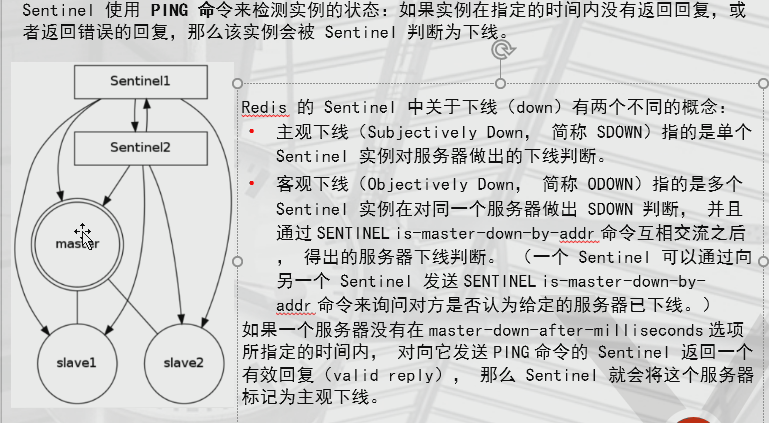

7.3.2 检测示例的状态

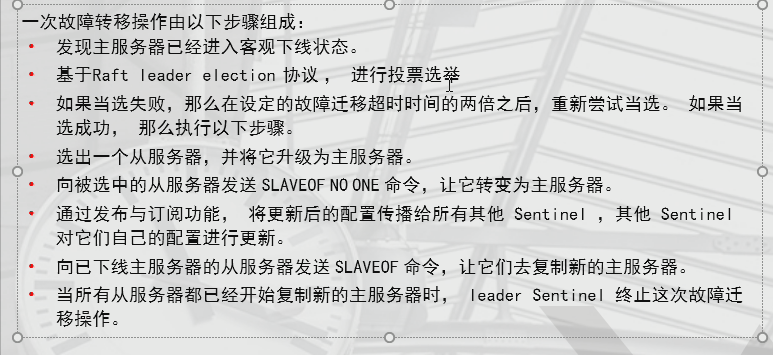

7.3.3 故障转移FAILOVER

7.4 sentinel基本配置

首先构建1主2从redis主从复制

主节点:6380

从节点:6381、6382

mkdir /data/26380

vim /data/26380/sentinel.conf

port 26380

dir "/data/26380/"

sentinel monitor mymaster 127.0.0.1 6380 1 这里就只有一题sentnel,假如有三台,如果改为2意味着只要有两台sentnel认为他当了就切换

sentinel down-after-milliseconds mymaster 60000

---->单位是毫秒,换算过来是60秒

启动

redis-sentinel /data/26380/sentinel.conf &

sentinel 管理

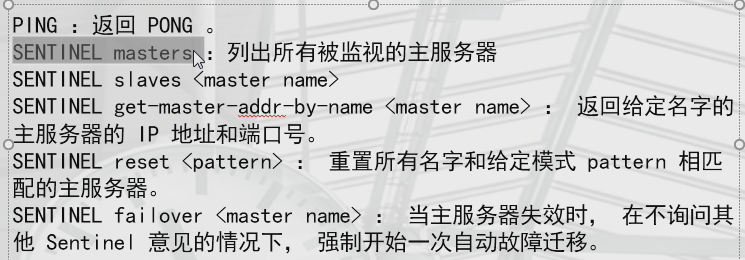

PING :返回 PONG 。

SENTINEL masters :列出所有被监视的主服务器

SENTINEL slaves <master name>

SENTINEL get-master-addr-by-name <master name> : 返回给定名字的主服务器的 IP 地址和端口号。

SENTINEL failover <master name> : 当主服务器失效时, 在不询问其他 Sentinel 意见的情况下, 强制开始一次自动故障迁移。

测试:

宕掉主库6380

redis-cli -p 6380

shutdown

观察切换过程和结果(通过info replication命令查看slave是否切换成master)

7.5 sentinel命令

127.0.0.1:26380> sentinel failover mymaster 强制切换master

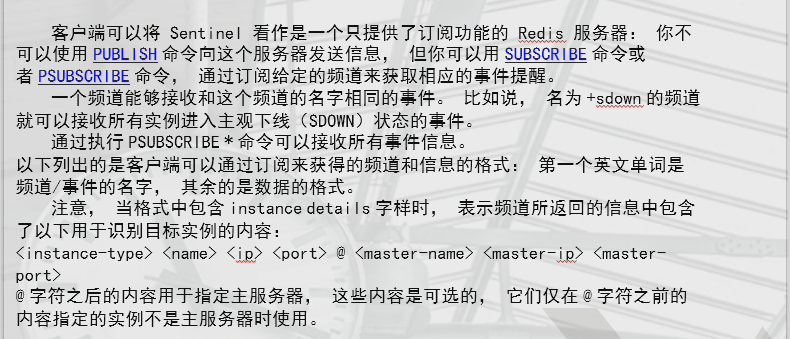

7.6 发布与订阅信息

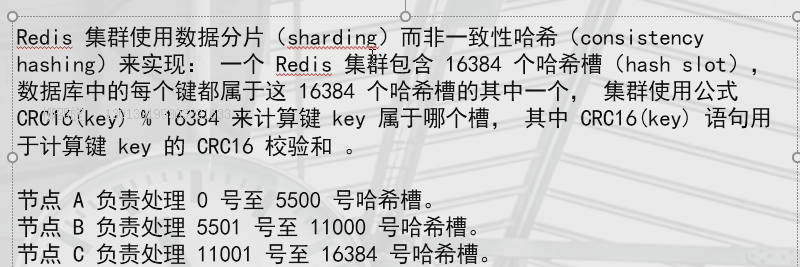

第8章 集群的实现redis cluster

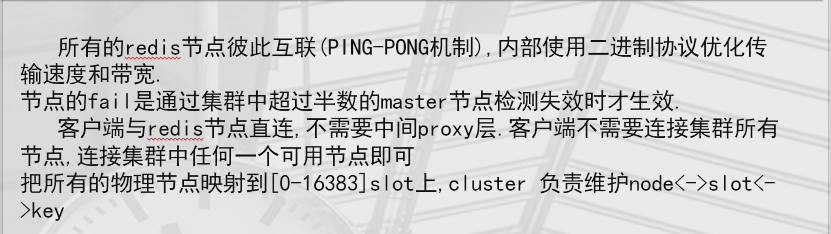

8.1 原生态支持的分布式的自动分片集群

1、自动分片

2、高可用

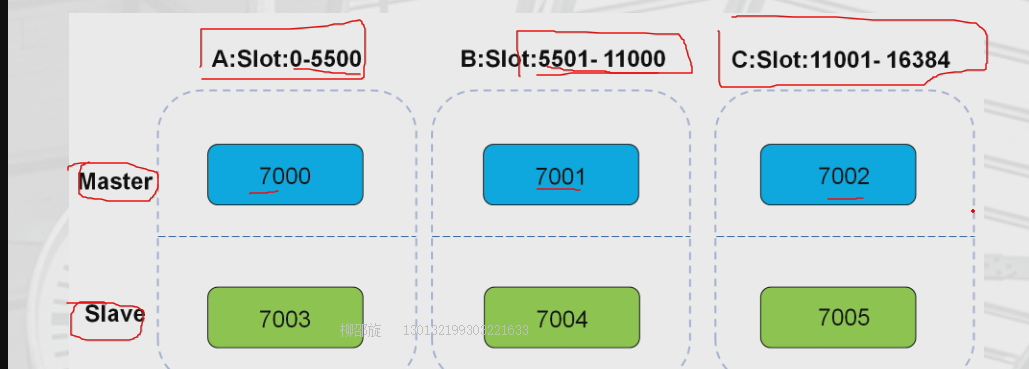

8.2 节点划分(主备错开)

7000 --7004 7001—7005 7002—7003

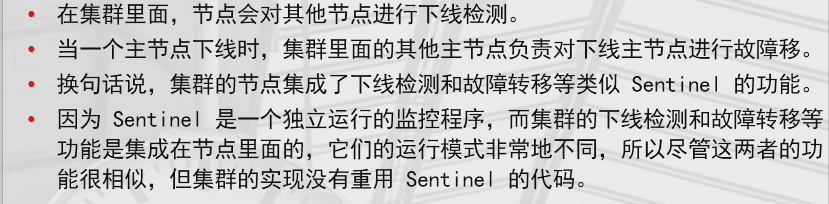

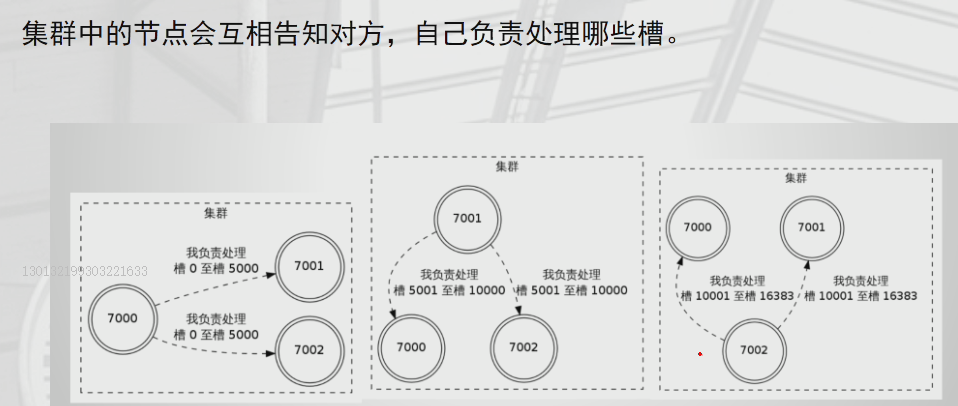

8.3 运行机制

8.4 集群的复制

8.5 集群的故障转移

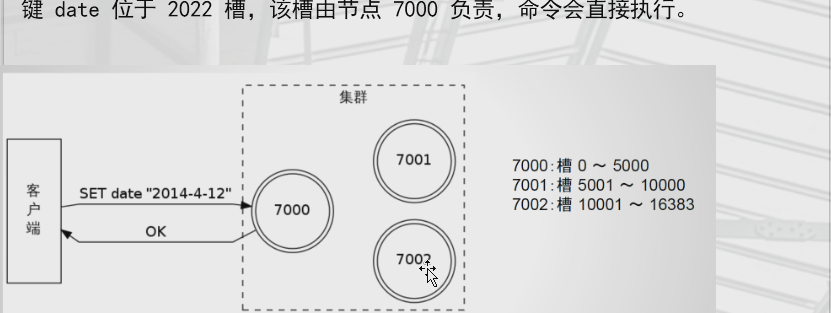

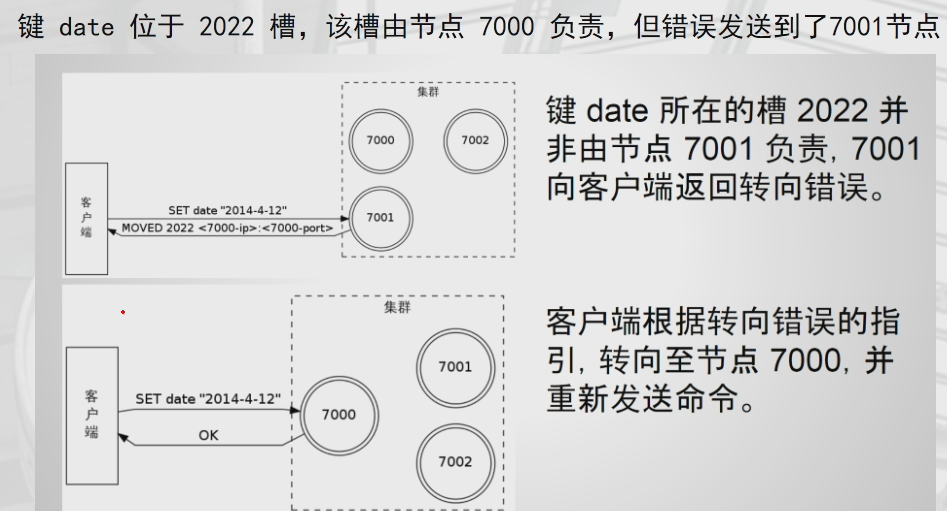

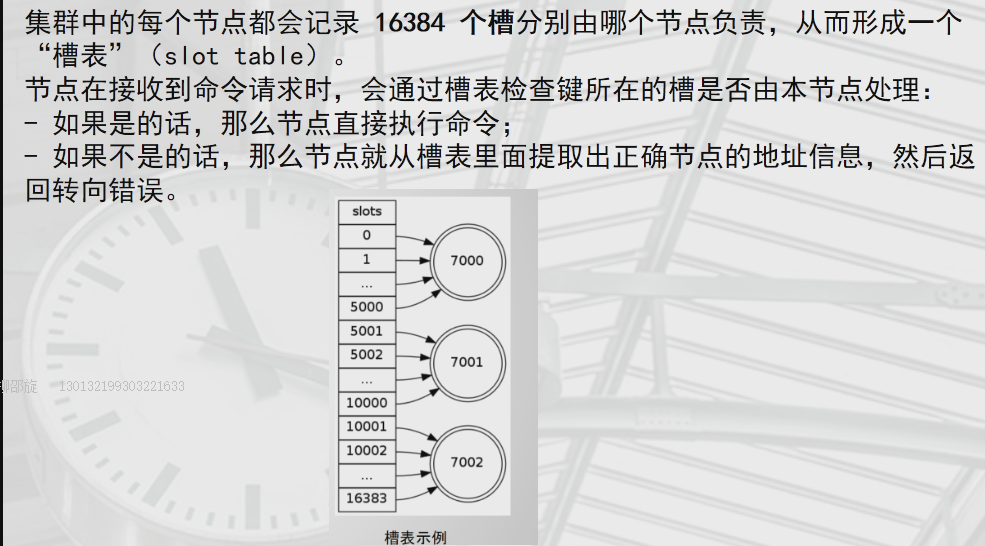

8.6 命令发送给正确的节点

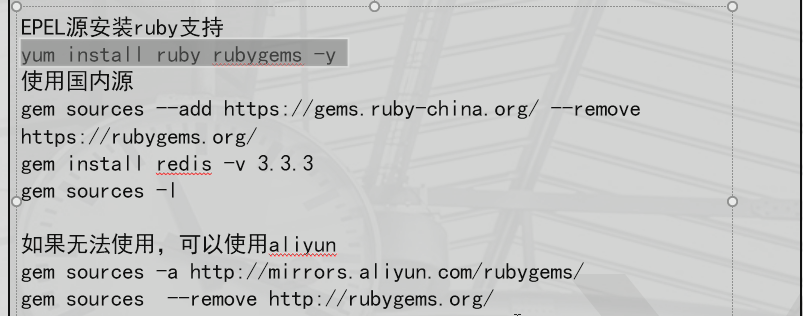

8.7 安装集群软件

yum install ruby rubygems -y

[root@redis yum.repos.d]# gem sources -a https://mirrors.ustc.edu.cn/rubygems/ 替换为阿里云的或者科技大学的

https://mirrors.ustc.edu.cn/rubygems/ added to sources

[root@redis yum.repos.d]# gem sources --remove http://rubygems.org/

source http://rubygems.org/ not present in cache

[root@redis yum.repos.d]# gem sources -l

*** CURRENT SOURCES ***

https://rubygems.org/

https://mirrors.ustc.edu.cn/rubygems/gem

[root@redis yum.repos.d]# yum install redis -v 3.3.3

8.8 准备集群所需节点(7001-7005)

mkdir -p /data/700{0..5}

-----------------------------------------------

vim /data/7000/redis.conf

port 7000

daemonize yes

pidfile /data/7000/redis.pid

loglevel notice

logfile "/data/7000/redis.log"

dbfilename dump.rdb

dir /data/7000

protected-mode no

cluster-enabled yes

cluster-config-file nodes.conf

cluster-node-timeout 5000

appendonly yes

-----------------------------------------------

vim /data/7001/redis.conf

port 7001

daemonize yes

pidfile /data/7001/redis.pid

loglevel notice

logfile "/data/7001/redis.log"

dbfilename dump.rdb

dir /data/7001

protected-mode no

cluster-enabled yes

cluster-config-file nodes.conf

cluster-node-timeout 5000

appendonly yes

------------------------------------------------

vim /data/7002/redis.conf

port 7002

daemonize yes

pidfile /data/7002/redis.pid

loglevel notice

logfile "/data/7002/redis.log"

dbfilename dump.rdb

dir /data/7002

protected-mode no

cluster-enabled yes

cluster-config-file nodes.conf

cluster-node-timeout 5000

appendonly yes

-----------------------------------------------

vim /data/7003/redis.conf

port 7003

daemonize yes

pidfile /data/7003/redis.pid

loglevel notice

logfile "/data/7003/redis.log"

dbfilename dump.rdb

dir /data/7003

protected-mode no

cluster-enabled yes

cluster-config-file nodes.conf

cluster-node-timeout 5000

appendonly yes

-----------------------------------------------

vim /data/7004/redis.conf

port 7004

daemonize yes

pidfile /data/7004/redis.pid

loglevel notice

logfile "/data/7004/redis.log"

dbfilename dump.rdb

dir /data/7004

protected-mode no

cluster-enabled yes

cluster-config-file nodes.conf

cluster-node-timeout 5000

appendonly yes

----------------------------------------------

vim /data/7005/redis.conf

port 7005

daemonize yes

pidfile /data/7005/redis.pid

loglevel notice

logfile "/data/7005/redis.log"

dbfilename dump.rdb

dir /data/7005

protected-mode no

cluster-enabled yes

cluster-config-file nodes.conf

cluster-node-timeout 5000

appendonly yes

--------------------------------------------

8.9 启动节点:

[root@redis data]# redis-server /data/7000/redis.conf

[root@redis data]# redis-server /data/7001/redis.conf

[root@redis data]# redis-server /data/7002/redis.conf

[root@redis data]# redis-server /data/7003/redis.conf

[root@redis data]# redis-server /data/7004/redis.conf

[root@redis data]# redis-server /data/7005/redis.conf

8.10 加载节点并启动集群:

redis-trib.rb create --replicas 1 127.0.0.1:7000 127.0.0.1:7001 \

127.0.0.1:7002 127.0.0.1:7003 127.0.0.1:7004 127.0.0.1:7005

replicas 副本

启动的时候遇到问题

/usr/share/rubygems/rubygems/core_ext/kernel_require.rb:55:in `require‘: cannot load such file -- redis (LoadError)

from /usr/share/rubygems/rubygems/core_ext/kernel_require.rb:55:in `require‘

from ./redis-trib.rb:25:in `<main>‘

Ruby的redis接口没有安装,需要安装Redis接口,输入命令 " gem install redis " 进行安装

在安装Redis接口的时候可能会遇到错误信息告诉我们Ruby版本太低

ruby升级见:https://blog.csdn.net/hello_world_qwp/article/details/78261618

8.11 集群管理:

集群状态查看

redis-cli -p 7000 cluster nodes | grep master

故障转移

redis-cli -p 7002 debug segfault

8.12 手动转移slot,手动删除节点。

需求:将7002节点上的所有slot(10923-16383,共5461个)转移到7000节点上

redis-trib.rb reshard 127.0.0.1:7000

How many slots do you want to move (from 1 to 16384)? 5461

--------------------------------------------------------

-

What is the receiving node ID? [7000的ID]

---------------------------------------------------------

Please enter all the source node IDs.

Type 'all' to use all the nodes as source nodes for the hash slots.

Type 'done' once you entered all the source nodes IDs.

Source node #1:[7002的ID]

Source node #2:done 结束

恢复的时候 如果7000和7001一样多的话。此处要写7001和7000合适,这样可以达到一个平均的效果

----------------------------------------------

删除一个节点(注意,先将删除节点的slot移到其他节点)

redis-trib.rb del-node 127.0.0.1:7002 '734ce9b78350addf12f760034150bd934f32486f' 删掉主节点

redis-trib.rb del-node 127.0.0.1:7005 '44bfd6c7f57890c2161ac003ec084157f9a57e1b' 删掉副节点

增加新的master节点(要保证7002是一个全新节点)将以前的清除

redis-trib.rb add-node 127.0.0.1:7002 127.0.0.1:7000

添加一个从节点

./redis-trib.rb add-node --slave --master-id MASTERID 127.0.0.1:7005 127.0.0.1:7000

第9章 redis的多API支持(链接redis)

python为例

9.1 安装Python-3.5.2

第二种用源码包

cd Python-3.5.2

./configure

make && make install

mv /usr/bin/python /usr/bin/pyhon2.6

vim /usr/bin/yum

#!/usr/bin/python2.6 ----修改这行为2.6

cp /usr/local/bin/python3.5 /usr/bin/pyhon

9.2 安装redis-cluser的客户端程序

此处Python版本有时候不支持要此出用的是Python-3.5.2

cd redis-py-cluster-unstable

python setup.py install

安装

cd redis-py-master

python setup.py install

9.3 对redis的单实例进行连接操作

python 链接

>>> import redis

>>> r = redis.StrictRedis(host='localhost', port=6379, db=0,password='root')

>>> r.set('foo', 'bar') 输入键值测试

True

>>> r.get('foo')

'bar'

9.4 sentinel集群连接并操作

>>> from redis.sentinel import Sentinel

>>> sentinel = Sentinel([('localhost', 26380)], socket_timeout=0.1)

>>> sentinel.discover_master('mymaster')

>>> sentinel.discover_slaves('mymaster')

>>> master = sentinel.master_for('mymaster', socket_timeout=0.1)

>>> slave = sentinel.slave_for('mymaster', socket_timeout=0.1)

>>> master.set('oldboy', '123')

>>> slave.get('oldboy')

'bar'

9.5 python连接rediscluster集群测试

redis cluster的连接并操作(python2.7以上版本才支持redis cluster,我们选择的是3.5)

https://github.com/Grokzen/redis-py-cluster

===================================================================================================

python

>>> from rediscluster import StrictRedisCluster

>>> startup_nodes = [{"host": "127.0.0.1", "port": "7000"}]

>>> # Note: decode_responses must be set to True when used with python3

>>> rc = StrictRedisCluster(startup_nodes=startup_nodes, decode_responses=True)

>>> rc.set("foo", "bar")

True

>>> print(rc.get("foo"))

'bar'

去另一个查看结果

redis 缓存应用的更多相关文章

- 缓存工厂之Redis缓存

这几天没有按照计划分享技术博文,主要是去医院了,这里一想到在医院经历的种种,我真的有话要说:医院里的医务人员曾经被吹捧为美丽+和蔼+可亲的天使,在经受5天左右相互接触后不得不让感慨:遇见的有些人员在挂 ...

- Windows下Redis缓存服务器的使用 .NET StackExchange.Redis Redis Desktop Manager

Redis缓存服务器是一款key/value数据库,读110000次/s,写81000次/s,因为是内存操作所以速度飞快,常见用法是存用户token.短信验证码等 官网显示Redis本身并没有Wind ...

- 总结:如何使用redis缓存加索引处理数据库百万级并发

前言:事先说明:在实际应用中这种做法设计需要各位读者自己设计,本文只提供一种思想.准备工作:安装后本地数redis服务器,使用mysql数据库,事先插入1000万条数据,可以参考我之前的文章插入数据, ...

- .NET基于Redis缓存实现单点登录SSO的解决方案[转]

一.基本概念 最近公司的多个业务系统要统一整合使用同一个登录,这就是我们耳熟能详的单点登录,现在就NET基于Redis缓存实现单点登录做一个简单的分享. 单点登录(Single Sign On),简称 ...

- Redis缓存连接池管理

import org.slf4j.Logger;import org.slf4j.LoggerFactory;import org.springframework.util.Assert;import ...

- ssm+redis 如何更简洁的利用自定义注解+AOP实现redis缓存

基于 ssm + maven + redis 使用自定义注解 利用aop基于AspectJ方式 实现redis缓存 如何能更简洁的利用aop实现redis缓存,话不多说,上demo 需求: 数据查询时 ...

- Windows Azure Redis 缓存服务

8月20日,Windows Azure (中国版)开始提供Redis缓存服务,比较国际版的Microsoft Azure晚了差不多一年的时间.说实话,微软真不应该将这个重要的功能delay这么长时间, ...

- .NET基于Redis缓存实现单点登录SSO的解决方案

一.基本概念 最近公司的多个业务系统要统一整合使用同一个登录,这就是我们耳熟能详的单点登录,现在就NET基于Redis缓存实现单点登录做一个简单的分享. 单点登录(Single Sign On),简称 ...

- spring boot redis缓存JedisPool使用

spring boot redis缓存JedisPool使用 添加依赖pom.xml中添加如下依赖 <!-- Spring Boot Redis --> <dependency> ...

- spring aop搭建redis缓存

SpringAOP与Redis搭建缓存 近期项目查询数据库太慢,持久层也没有开启二级缓存,现希望采用Redis作为缓存.为了不改写原来代码,在此采用AOP+Redis实现. 目前由于项目需要,只需要做 ...

随机推荐

- 数位dp 3943 二分法

转载:http://blog.csdn.net/wdcjdtc/article/details/39177905 #include"cstdlib" #include"c ...

- 【IntelliJ 】设置 IntelliJ IDEA 主题和字体的方法

2 主题修改 2.1 界面主题修改 如上图所示,依次点击Files -> Settings,进入如下界面: 标注1:主题选择区: 标注2:Darcula.IntelliJ 和 Windows,三 ...

- Pagodas 等差数列

nn pagodas were standing erect in Hong Jue Si between the Niushou Mountain and the Yuntai Mountain, ...

- Ubuntu16.04安装deb文件时提示:此软件来自第三方且可能包含非自由组件

解决方式: 1.在Ubuntu软件中心安装GDebi. 2.安装好之后,选择这个要安装的deb文件右键,打开方式选择GDebi,然后输入管理员密码等待安装,期间如果不行需要重试几次. 3.另外的方法, ...

- SHARP 加粉

http://v.ku6.com/show/7ufwm7pqfF8D_f13IdCaag...html

- 关于python内存管理里的引用计数算法和标记-清楚算法的讨论

先记录于此,后续有时间再深究吧: 1.https://www.zhihu.com/question/33529443 2.http://patshaughnessy.net/2013/10/30/ge ...

- oralce之复杂查询举例

表结构: S(SNO,SNAME) 代表 学号.学生姓名: C(CNO,CNAME,CTEACHER) 代表 课号,课程名称.授课老师 SC(SNO,CNO,SCGRADE) 代表 学号.课号.课程成 ...

- 查看yarn当前执行任务列表

Author: kwu 查看yarn当前执行任务列表.可使用例如以下命令查看: yarn application -list 如需杀死当前某个作业,使用kill application-id的命令例如 ...

- 杭电 3555 Bomb

Bomb Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 131072/65536 K (Java/Others) Total Subm ...

- CSDN-markdown编辑器之从本机导入Markdown文件(二)

CSDN-markdown编辑器支持从本机导入Markdown文件的功能,假设你有从其他站点上下载的博客文章或说明文档,或是用软件编写的博客文章或说明文档.想公布到CSDN博客中,就能够使用本功能 ...