Adversarial Detection methods

- Kernel Density (KD)

- Local Intrinsic Dimensionality (LID)

- Gaussian Discriminant Analysis (GDA)

- Gaussian Mixture Model (GMM)

- SelectiveNet

- Combined Abstention Robustness Learning (CARL)

- Energy-based Out-of-distribution Detection

- Confidence-Calibrated Adversarial Training: Generalizing to Unseen Attacks (CCAT)

Kernel Density (KD)

作者认为普通样本的特征和对抗样本的特征位于不同的流形中, 故可以通过密度估计的方法, 估计出普通样本的密度函数, 然后求得样本各自的置信度, 选择合适的阈值(通过ROC-AUC之类的), 便有了区分普通样本和对抗样本的方法.

假设

\]

为将样本\(x\)提取为特征\(z\)

- 选取合适的样本数目\(x_1, \cdots, x_N\);

- 提取特征\(z_1, \cdots, z_N\);

- 构建核密度估计函数:

k_{\sigma}(z, z') = \frac{1}{(2\pi)^{\frac{d}{2}}\sigma^d}\exp (-\frac{\|z' - z\|^2}{2\sigma^2}).

\]

选择合适的阈值\(t\), 对于样本\(x\), 判定其为对抗样本, 若\(\hat{f}(x) < t\).

有些时候, 可以对每一类构建一个\(\hat{f}(x)\), 但这个情况也就只能用在ROC-AUC了.

Local Intrinsic Dimensionality (LID)

Gaussian Discriminant Analysis (GDA)

作者假设特征\(z=h(x)\)(所属类别为\(c\))满足后验分布:

\]

即

\]

注意到对于不同的\(c\), 协方差矩阵\(\Sigma\)是一致的(这个假设是为了便于直接用于分类, 但是与detection无关, 便不多赘述).

均值和协方差矩阵通过如下方式估计:

\]

故可以用

\]

来区分\(x\)是否为abnormal的样本(对抗的或者偏离训练分布的样本).

在文中用的是log化(且去掉比例系数)的指标:

\]

改方法可以进一步拓展(实际上光用这个指标看实验结果似乎并不理想):

- Input pre-processing:

对于输入的样本进行如下变换:

\]

有点像fgsm生成对抗样本, 但感觉这么做的原因是让\(\hat{f}(x)\)之间的区别大一点.

- Feature ensemble:

即对不同层的特征\(h_l(x)\)都进行如上的操作, 然后得到\(\hat{f}_1, \cdots, \hat{f}_L\), 并通过SVM来训练得到权重\(\alpha_l\), 最后的score为

\]

注: 文中实际为\(M_l(x)\).

Gaussian Mixture Model (GMM)

类似的, 对于特征\(z=h(x)\), 假设其服从GMM:

\]

并用EM算法来估计.

注: 对每一个类别都需要估计一个GMM模型.

于是

\]

当其小于给定的threshold的时候, 便认为其不属于类别\(c\).

问: 所以当所有的\(c\)都被拒绝的时候, 就可以认为是对抗样本了?

SelectiveNet

本文的模型解释起来有点复杂, 在一个普通的判别网络\(f\)的基础上:

\left \{

\begin{array}{ll}

f(x) & \text{if } g(x) = 1, \\

\text{don't know} & \text{if } g(x) = 0.

\end{array}

\right .

\]

其中\(g\)是一个用来选择是否判断的模块.

作者给出了两个指标:

Coverage:

\]

以及

Selective Risk:

\]

Coverage不能太低, 因为如果全部拒绝判断模型就没有意义了, 然后\(R(f, g)\)自然是越低越好, 但是注意到, 虽然一味拒绝回答能够使得分子接近0, 但是分母也会接近0, 所以需要一个平衡.

二者的经验估计如下:

\phi(g|S_N):= \frac{1}{N}\sum_{i=1}^N g(x_i).

\]

注: 在实际使用中, \(g\)的取值往往在\([0, 1]\)间, 此时可以选取threshold t来选择是否判断.

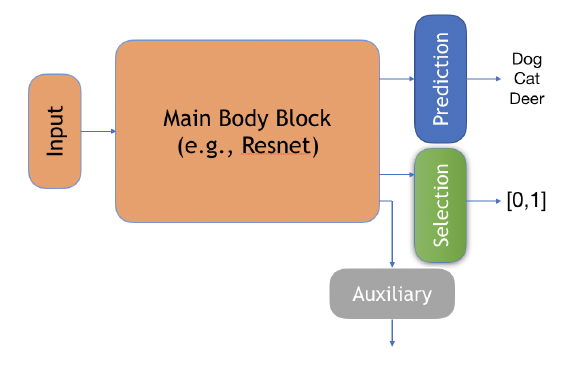

作者设计了一个结构如下:

其中:

Prediction: \(f\);

Selection: \(g\);

Auxiliary: \(h\), 作者说此为别的任务来帮助训练的.

最后的损失:

\mathcal{L}_{(f, g)} = \hat{r}_{\ell} (f, g|S_N) + \lambda \Psi(c - \hat{\phi}(g | S_N)) \\

\Psi(a) = \max(0, a)^2 \\

\mathcal{L}_h = \hat{r}(h|S_N) = \frac{1}{N}\sum_{i=1}^N \ell (h(x_i), y_i).

\]

Combined Abstention Robustness Learning (CARL)

假设\(f\)将样本\(x\)映射为\(\mathcal{Y} \bigcup \{a\}\), 其中\(a\)表示弃权(don't know).

则我们可以定义:

\mathcal{R}_{adv}(f) := \mathbb{E}_{(x, y) \sim \mathcal{D}} \max_{\tilde{x} \in \mathcal{B}_{\epsilon}(x)} \mathbf{1}\{f(\tilde{x} \not = y \text{ and } f(\tilde{x}) \not = a\}.

\]

很自然的, 我们可以通过优化下列损失

\]

来获得一个带有弃权功能的判别器. 并且通过权重\(c\)我们可以选择更好的natural精度或者更保守但更加安全的策略.

直接优化上面的损失是困难的, 故选择损失来替换. 作者采用普通的交叉熵损失来代替nat:

\]

用下列之一替代adv:

\ell = \{\ell^{(1)}, \ell^{(2)}\} \\

\ell^{(1)} = -\log (p_y (\tilde{x}) + p_a (\tilde{x})) \\

\ell^{(2)} = (-\log (p_y (\tilde{x})) \cdot (-\log p_a (\tilde{x})) \\

\]

Adversarial Training with a Rejection Option

凸relax.

Energy-based Out-of-distribution Detection

普通的softmax分类网络可以从energy-based model的角度考虑:

E(x, y) = -f_y(x), \\

\]

Helmholtz free energy:

\]

实际上, 通过\(E(x;f)\)我们可以构建\(x\)的能量模型:

\]

故我们可以通过\(p(x)\)来判断一个样本是不是OOD的.

特别的, 由于对于所有的\(x\)

\]

都是一致的, 所以我们只需要比较

\]

的大小就可以了.

特别的, 作者指出为什么用\(p(y|x)\)来作为判断是否OOD的依据不合适:

\log \max_y p(y|x) &= \log \max_y \frac{e^{f_y(x)}}{\sum_i e^{f_i(x)}} \\

&= \log \frac{e^{f_{\max}(x)}}{\sum_i e^{f_i(x)}} \\

&= E(x;f(x) - f^{\max}(x)) \\

&= E(x;f) + f^{max}(x) \\

&= -\log p(x) + f^{max}(x) - \log Z \\

&\not\propto -\log p(x).

\end{array}

\]

WOW!

Confidence-Calibrated Adversarial Training: Generalizing to Unseen Attacks (CCAT)

假设\(f(x)\)为预测的概率向量, CCAT通过如下算法优化:

- 输入: \((x_1, y_1), \cdots, (x_B, y_B)\);

- 将其中一半用于对抗训练, 一半用于普通训练:

\]

- 其中

\tilde{y}_b = \lambda(\delta_b) \text{ one\_hot}(y_b) + (1 - \lambda(\delta_b)) \frac{1}{K}, \\

\delta_b = \mathop{\arg \max} \limits_{\delta_{\infty} \le \epsilon} \max_{k \not= y_b} f_k(x_b + \delta), \\

\lambda (\delta_b) := (1 - \min(1, \frac{\|\delta_b\|_{\infty}}{\epsilon}))^{\rho}. \\

\]

\(\tilde{y}\)是真实标签和均匀分布的一个凸组合, 这个还是挺有道理的.

最后, 倘若如果

\]

即置信度比较小的话, 拒绝判断(这个可靠的原因是目标函数让对抗样本趋于均匀分布).

Adversarial Detection methods的更多相关文章

- 论文解读(ARVGA)《Learning Graph Embedding with Adversarial Training Methods》

论文信息 论文标题:Learning Graph Embedding with Adversarial Training Methods论文作者:Shirui Pan, Ruiqi Hu, Sai-f ...

- [转]Jailbreak Detection Methods

Source: http://blog.spiderlabs.com/2014/10/jailbreak-detection-methods.html Many iOS applications co ...

- 生成对抗网络资源 Adversarial Nets Papers

来源:https://github.com/zhangqianhui/AdversarialNetsPapers AdversarialNetsPapers The classical Papers ...

- CVPR 2011 Global contrast based salient region detection

Two salient region detection methods are proposed in this paper: HC AND RC HC: Histogram based contr ...

- 文本分类实战(七)—— Adversarial LSTM模型

1 大纲概述 文本分类这个系列将会有十篇左右,包括基于word2vec预训练的文本分类,与及基于最新的预训练模型(ELMo,BERT等)的文本分类.总共有以下系列: word2vec预训练词向量 te ...

- Anomaly Detection

数据集中的异常数据通常被成为异常点.离群点或孤立点等,典型特征是这些数据的特征或规则与大多数数据不一致,呈现出“异常”的特点,而检测这些数据的方法被称为异常检测. 异常数据根据原始数据集的不同可以分为 ...

- PP: Time series clustering via community detection in Networks

Improvement can be done in fulture:1. the algorithm of constructing network from distance matrix. 2. ...

- (转) AdversarialNetsPapers

本文转自:https://github.com/zhangqianhui/AdversarialNetsPapers AdversarialNetsPapers The classical Pap ...

- [转]GAN论文集

really-awesome-gan A list of papers and other resources on General Adversarial (Neural) Networks. Th ...

随机推荐

- 零基础学习java------day18------properties集合,多线程(线程和进程,多线程的实现,线程中的方法,线程的声明周期,线程安全问题,wait/notify.notifyAll,死锁,线程池),

1.Properties集合 1.1 概述: Properties类表示了一个持久的属性集.Properties可保存在流中或从流中加载.属性列表中每个键及其对应值都是一个字符串 一个属性列表可包含另 ...

- 源码分析-Producer

消息生产者的代码都在client模块中,相对于RocketMQ来讲,消息生产者就是客户端,也是消息的提供者. 方法和属性 主要方法介绍 //创建主题 void createTopic(final St ...

- mysql之对象创建

1 --创建表空间 2 create tablespace tablespace_name 3 innodb and ndb: 4 add datafile 'file_name' 5 innodb ...

- apply 和 call 的区别

相同点: 都能够改变方法的执行上下文(执行环境),将一个对象的方法交给另一个对象来执行,并且是立即执行 不同点: call方法从第二个参数开始可以接收任意个参数,每个参数会映射到相应位置的func的参 ...

- Mysql资料 xtrabackup

目录 一.简介 原理 优缺点 二.安装 三.日常使用 备份所有库 增量备份 远程备份 四.参数 一.简介 原理 其实XtraBackup也是基于INNODB的 crash-recovery功能来实现的 ...

- [BUUCTF]PWN——babyfengshui_33c3_2016

babyfengshui_33c3_2016 附件 步骤: 例行检查,32位程序,开启了cannary和nx 本地运行一下看看大概的情况,熟悉的堆的菜单布局 32位ida载入,看main函数 add ...

- java nio 写一个完整的http服务器 支持文件上传 chunk传输 gzip 压缩 使用过程 和servlet差不多

java nio 写一个完整的http服务器 支持文件上传 chunk传输 gzip 压缩 也仿照着 netty处理了NIO的空轮询BUG 本项目并不复杂 代码不多 ...

- CF667A Pouring Rain 题解

Content 一个水桶直径为 \(d\) 厘米,初始时水面高度为 \(h\) 厘米.你每秒钟喝 \(v\) 毫升水,而由于下雨,水桶里面的水在不喝水的时候每秒会上升 \(e\) 厘米.求你最少需要多 ...

- java 8 启动脚本优化

1 #!/bin/bash 2 3 JAVA_HOME=/usr/java/default 4 5 #java虚拟机启动参数 6 JAVA_OPTS="-server -Xms1366m - ...

- Boost Asio要点概述(一)

[注]本文不是boost asio的完整应用讲述,而是仅对其中要点的讲解,主要参考了Boost Asio 1.68的官方文档(https://www.boost.org/doc/libs/1_68_0 ...