go单任务版爬虫

go单任务版爬虫(爬取珍爱网)

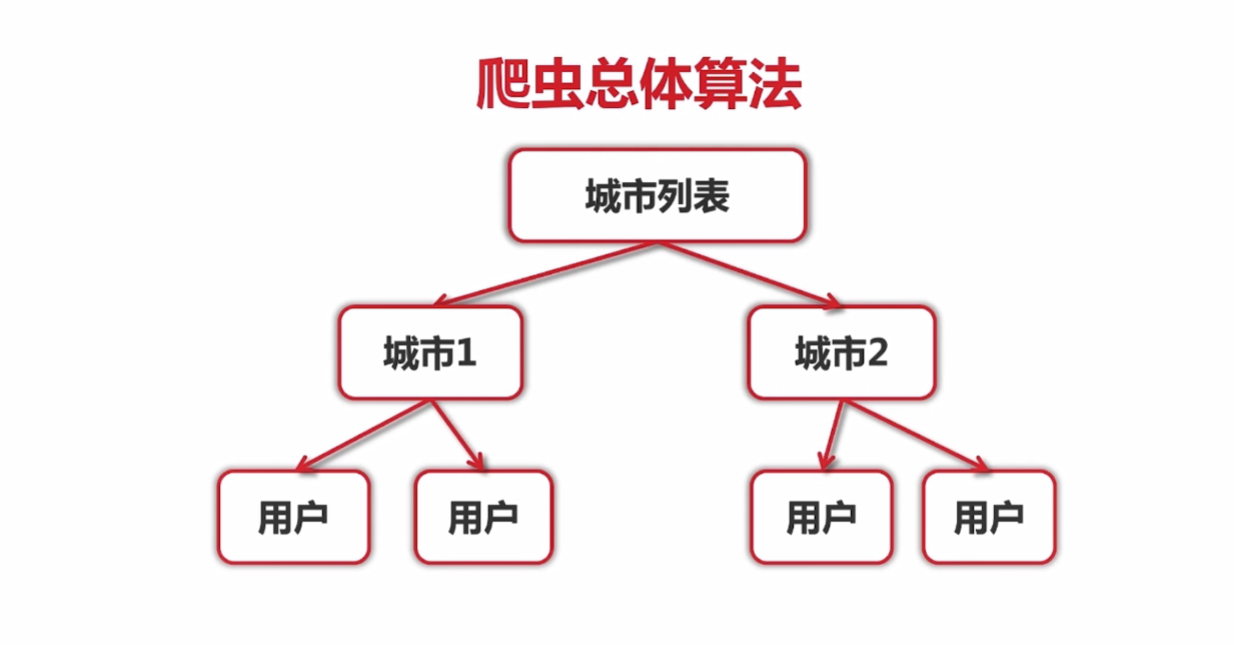

爬虫总体算法

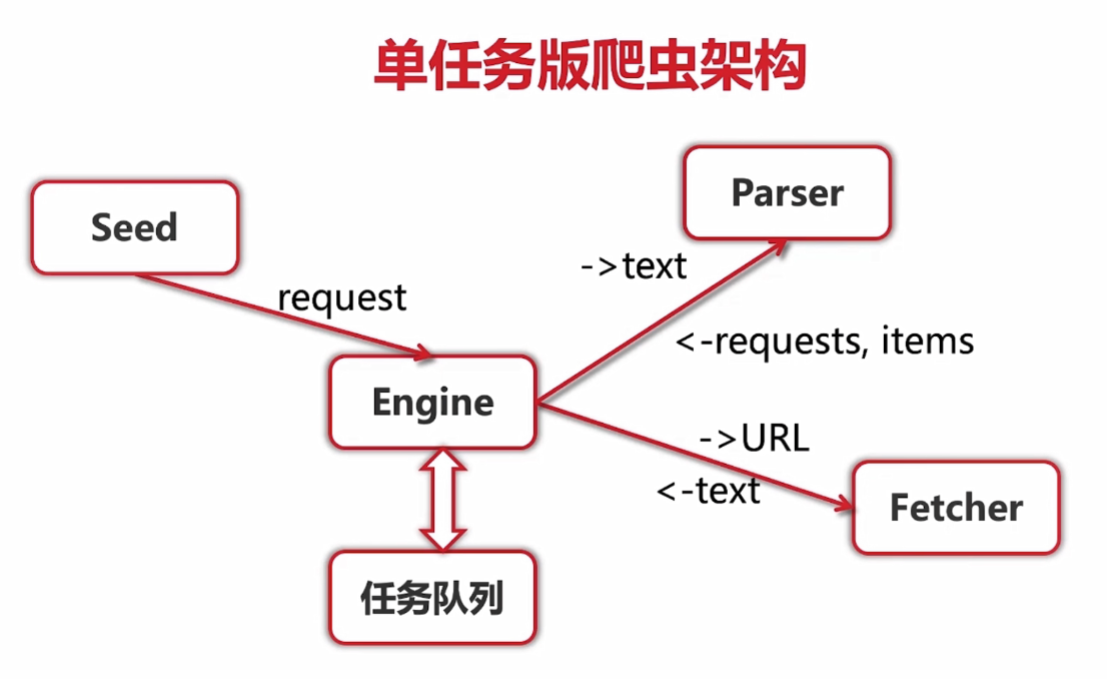

单任务版爬虫架构

任务

获取并打印所在城市第一页用户的详细信息

代码实现

/crawler/main.go

package main

import (

"crawler/engine"

"crawler/zhenai/parser"

)

func main() {

engine.Run(engine.Request{

Url:"http://www.zhenai.com/zhenghun",

ParseFunc: parser.ParseCityList,

})

}

/crawler/engine/engine.go

package engine

import (

"crawler/fetcher"

"log"

)

// seeds:url种子

func Run(seeds ...Request) {

var requests []Request

for _, r := range seeds {

requests = append(requests, r)

}

for len(requests) > 0 {

r := requests[0]

requests = requests[1:]

log.Printf("Fetching: %s", r.Url)

body, err := fetcher.Fetch(r.Url)

if err != nil {

log.Printf("Fetcher: error" + "fetching url %s: %v", r.Url, err)

continue

}

parseResult := r.ParseFunc(body)

requests = append(requests, parseResult.Requests...)

for _, item := range parseResult.Items{

log.Printf("Got item %v", item)

}

}

}

/crawler/engine/types.go

package engine

type Request struct {

Url string

ParseFunc func([]byte) ParseResult

}

type ParseResult struct {

Requests []Request

Items []interface{}

}

func NilParser([]byte) ParseResult{

return ParseResult{}

}

/crawler/fetcher/fetcher.go

package fetcher

import (

"bufio"

"fmt"

"golang.org/x/net/html/charset"

"golang.org/x/text/encoding"

"golang.org/x/text/encoding/unicode"

"golang.org/x/text/transform"

"io/ioutil"

"log"

"net/http"

)

//获取内容

func Fetch(url string) ([]byte, error) {

client := &http.Client{}

req, err := http.NewRequest("GET", url, nil)

if err != nil {

return nil, err

}

req.Header.Set("User-Agent", "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/66.0.3359.181 Safari/537.36")

resp, err := client.Do(req)

if err != nil {

return nil, err

}

defer resp.Body.Close()

if resp.StatusCode != http.StatusOK {

return nil, fmt.Errorf("Wrong status code: %d", resp.StatusCode)

}

bodyReader := bufio.NewReader(resp.Body)

e := determineEncoding(bodyReader)

utf8Reader := transform.NewReader(bodyReader, e.NewDecoder())

return ioutil.ReadAll(utf8Reader)

}

//转换编码

func determineEncoding(r *bufio.Reader) encoding.Encoding {

bytes, err := r.Peek(1024)

if err != nil {

log.Printf("Fetcher error: %v", err)

return unicode.UTF8

}

e, _, _ := charset.DetermineEncoding(bytes, "")

return e

}

/crawler/zhenai/parser/citylist.go

package parser

import (

"crawler/engine"

"regexp"

)

//解析UTF8文本,获取城市url列表

const cityListRe = `<a href="(http://www.zhenai.com/zhenghun/[0-9a-z]+)" [^>]*>([^<]+)</a>`

func ParseCityList(contents []byte) engine.ParseResult {

re := regexp.MustCompile(cityListRe)

matches := re.FindAllSubmatch(contents, -1)

result := engine.ParseResult{}

limit := 5 //设置限制,便于测试

for _, m := range matches {

result.Items = append(result.Items, "City: "+string(m[2]))

result.Requests = append(result.Requests, engine.Request{

Url: string(m[1]),

ParseFunc: ParseCity,

})

limit--

if limit == 0 {

break

}

}

return result

}

/crawler/zhenai/parser/city.go

package parser

import (

"crawler/engine"

"regexp"

)

//解析单个城市,获取用户

const cityRe = `<a href="(http://album.zhenai.com/u/[0-9]+)" [^>]*>([^<]+)</a>`

func ParseCity(contents []byte) engine.ParseResult {

re := regexp.MustCompile(cityRe)

matches := re.FindAllSubmatch(contents, -1)

result := engine.ParseResult{}

for _, m := range matches {

name := string(m[2])

result.Items = append(result.Items, "User: "+name)

result.Requests = append(result.Requests, engine.Request{

Url: string(m[1]),

ParseFunc: func(c []byte) engine.ParseResult {

return ParseProfile(c, "name:"+name)

},

})

}

return result

}

/crawler/zhenai/parser/profile.go

package parser

import (

"crawler/engine"

"crawler/model"

"regexp"

)

//获取用户信息

const all = `<div class="m-btn purple" data-v-8b1eac0c>([^<]+)</div>`

func ParseProfile(contents []byte, name string) engine.ParseResult {

profile := model.Profile{}

profile.User = append(profile.User, name)

re := regexp.MustCompile(all)

match := re.FindAllSubmatch(contents,-1)

if match != nil {

for _, m := range match {

profile.User = append(profile.User, string(m[1]))

}

}

result := engine.ParseResult{

Items: []interface{}{profile},

}

return result

}

/crawler/model/profile.go

package model

type Profile struct {

User []string

}

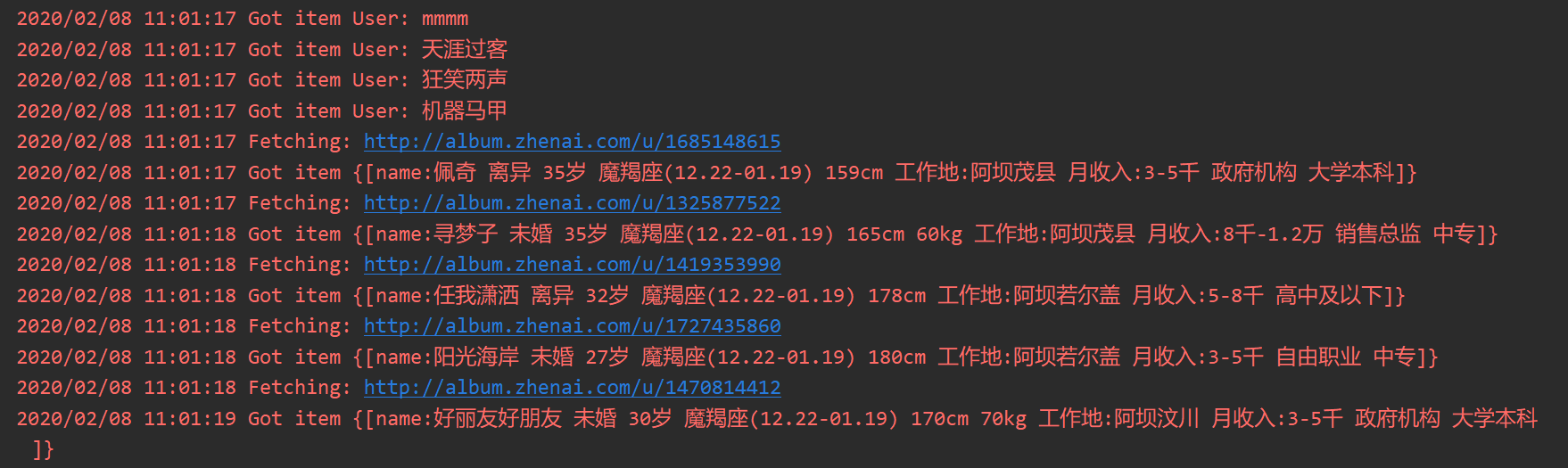

任务结果

完整代码

https://gitee.com/FenYiYuan/golang-oncrawler.git

go单任务版爬虫的更多相关文章

- go并发版爬虫

并发版爬虫 代码实现 /crawler/main.go package main import ( "learn/crawler/engine" "learn/crawl ...

- golang实现并发爬虫一(单任务版本爬虫功能)

目的是写一个golang并发爬虫版本的演化过程. 那么在演化之前,当然是先跑通一下单任务版本的架构. 正如人走路之前是一定要学会爬走一般. 首先看一下单任务版本的爬虫架构,如下: 这是单任务版本爬虫的 ...

- 区划代码 node 版爬虫尝试

前言 对于区划代码数据,很多人都不会陌生,大多公司数据库都会维护一份区划代码,包含省市区等数据.区划信息跟用户信息息息相关,往往由于历史原因很多数据都是比较老的数据,且不会轻易更改.网上也有很多人提供 ...

- python学习_新闻联播文字版爬虫(V 1.0版)

python3的爬虫练习,爬取的是新闻联播文字版网站 #!/usr/bin/env python # -*- coding: utf-8 -*- ''' __author__ = 'wyf349' _ ...

- {每日一题}:tcp协议实现简单的文件下载器(单任务版)

文件下载器客户端 这个版本的只是为了方便回顾一下TCP客服端,服务端的创建流程,缺点就是 服务器一次只能让一个人访问下载,过两个写个使用面向对象写一个多线程版的强化一下. from socket i ...

- python3版 爬虫了解

摘要:本文将使用Python3.4爬网页.爬图片.自动登录.并对HTTP协议做了一个简单的介绍.在进行爬虫之前,先简单来进行一个HTTP协议的讲解,这样下面再来进行爬虫就是理解更加清楚. 一.HTTP ...

- 从0开始学golang--2.2--如何去爬园子的数据👉进阶篇,面向对象的单任务版

执行页main.go-----------------------------------代码

- python学习_新闻联播文字版爬虫(V 1.0.1版)

更新记录: 1.新增了headers头的随机获取: 2.新增了logging模块添加日志信息(学习用): #!/usr/bin/env python # -*- coding: utf-8 -*- ' ...

- golang实现并发爬虫二(简单调度器)

上篇文章当中实现了单任务版爬虫. 那么这篇文章就大概说下,如何在上一个版本中进行升级改造,使之成为一个多任务版本的爬虫.加快我们爬取的速度. 话不多说,先看图: 其实呢,实现方法就是加了一个sched ...

随机推荐

- mysql--->B+tree索引的设计原理

1.什么是数据库的索引 每种查找算法都只能应用于特定的数据结构之上,例如二分查找要求被检索数据有序,而二叉树查找只能应用于二叉查找树上,但是数据本身的组织结构不可能完全满足各种数据结构(例如,理论上不 ...

- discuz如何修改主题列表页增加最后发表用户调用

首页有点问题,我觉得摘要实在太长了,我调整了一下 <!--{if is_array($group['lastpost'])}--> <a href="forum.php?m ...

- asp.net core 3.x 身份验证-1涉及到的概念

前言 从本篇开始将围绕asp.net core身份验证写个小系列,希望你看完本系列后,脑子里对asp.net core的身份验证原理有个大致印象.至于身份验证是啥?与授权有啥联系?就不介绍了,太啰嗦. ...

- springboot整合druid和配置资源监控

1.添加依赖,在maven repository中搜索 <dependency> <groupId>com.alibaba</groupId> <artifa ...

- 题解 NOI2004【郁闷的出纳员】

\[ Preface \] 之前用 treap 打,交了四遍才过. 自学了 fhq treap 后,才意识到是一道 fhq treap 板子题,直接码上,一遍就过. 本题解提供的是 fhq treap ...

- 快速应用开发(RAD)平台 - 20 年的演进

过去几年中,现代软件开发的整体环境发生了巨大的变化.对我个人来说,这种变化与宇宙的加速膨胀差不多.第二个千年刚到来时,产业的发展看起来还不是那么快,只是逐步在前进.现在技术发展的复杂度和多样性已经可以 ...

- ORACLE-SQLLOAD导入外部数据详解

今天公司需要把外部文本的一些数据导入到数据库.这里把相关步骤和注意的地方记录,供需要的人参考学习!这里的环境是在windows下的数据库,linux或者其他数据库同理! 1.准备工作:创建需要导入数据 ...

- 什么?接口中方法可以不是抽象的「JDK8接口新语法的深度思考」

先赞后看,养成习惯 文本已收录至GitHub开源仓库 Lu_JavaNodes 码云仓库地址Lu_JavaNodes,包含教程涉及所有思维导图,案例代码和后续讲解视频,欢迎Star增砖添瓦. 前言 在 ...

- win10电脑搭建网站

新建网站之后,IIS错误提示是:在计算机“.”上没有找到服务W3SVC,需要在“启动或关闭windows功能”添加.net 3.5下面的两个程序. https://img-blog.csdn.net/ ...

- 虚拟机ubuntu的网络连接类型

图很好 https://jingyan.baidu.com/article/91f5db1b17e8a01c7f05e3e6.html 很详细,有实例 https://www.cnblogs.com/ ...