scrapy中对于item的把控

其实很简单,就是想要存储的位置发生改变。直接看例子,然后触类旁通。

以大众点评 评论的内容为例 ,位置:http://www.dianping.com/shop/77489519/review_more?pageno=1

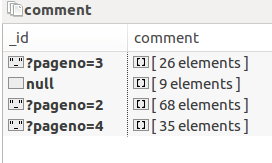

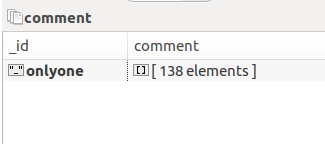

数据存储形式由A 变成B

A:

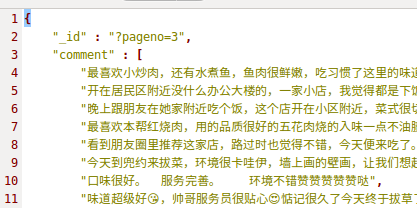

展开的话这样子:

B:

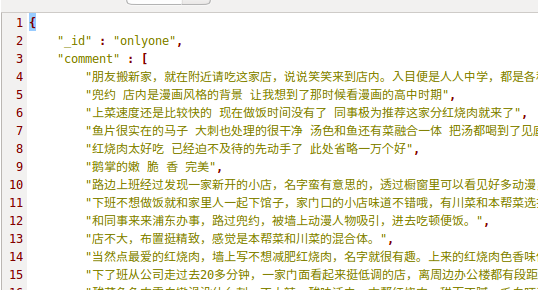

本质上看,就是多个相同类型的item可以合并,不需要那么多,分别来看下各自的代码:

A:

class GengduopinglunSpider(scrapy.Spider):

name = 'gengduopinglun'

start_urls = ['http://www.dianping.com/shop/77489519/review_more?pageno=1'] def parse(self, response):

item=PinglunItem()

comment = item['comment'] if "comment" in item else []

for i in response.xpath('//div[@class="content"]'):

for j in i.xpath('.//div[@class="J_brief-cont"]/text()').extract():

comment.append(j.strip())

item['comment']=comment

next_page = response.xpath(

'//div[@class="Pages"]/div[@class="Pages"]/a[@class="NextPage"]/@href').extract_first()

item['_id']=next_page

# item['_id']='onlyone'

if next_page != None:

next_page = response.urljoin(next_page)

# yield Request(next_page, callback=self.shop_comment,meta={'item': item})

yield Request(next_page, callback=self.parse,)

yield item

B:

class GengduopinglunSpider(scrapy.Spider):

name = 'gengduopinglun'

start_urls = ['http://www.dianping.com/shop/77489519/review_more?pageno=1'] def parse(self, response):

item=PinglunItem()

comment = item['comment'] if "comment" in item else []

for i in response.xpath('//div[@class="content"]'):

for j in i.xpath('.//div[@class="J_brief-cont"]/text()').extract():

comment.append(j.strip())

item['comment']=comment

next_page = response.xpath(

'//div[@class="Pages"]/div[@class="Pages"]/a[@class="NextPage"]/@href').extract_first()

# item['_id']=next_page

item['_id']='onlyone'

if next_page != None:

next_page = response.urljoin(next_page)

yield Request(next_page, callback=self.shop_comment,meta={'item': item})

# yield Request(next_page, callback=self.parse,)

# yield item def shop_comment(self, response):

item = response.meta['item']

comment = item['comment'] if "comment" in item else []

for i in response.xpath('//div[@class="content"]'):

for j in i.xpath('.//div[@class="J_brief-cont"]/text()').extract():

comment.append(j.strip())

item['comment']=comment

next_page = response.xpath(

'//div[@class="Pages"]/div[@class="Pages"]/a[@class="NextPage"]/@href').extract_first()

if next_page != None:

next_page = response.urljoin(next_page)

yield Request(next_page, callback=self.shop_comment,meta={'item': item})

yield item

B里面是有重复代码的,这个无关紧要,只是演示,注意看两个yield 的区别

以上只是演示scrapy中yield的用法,用来控制item,其余pipline,setting未展示.

scrapy中对于item的把控的更多相关文章

- Scrapy中的item是什么

这两天看Scrapy,看到item这个东西,觉得有点抽象,查了一下,有点明白了. Item 是保存爬取到的数据的容器:其使用方法和python字典类似, 并且提供了额外保护机制来避免拼写错误导致的未定 ...

- 关于ListView中item与子控件抢夺焦点的解决方法

1.在开发中,listview可以说是我们使用最频繁的控件之一了,但是关于listview的各种问题也是很多.当我们使用自定义布局的Listview的时候,如果在item的布局文件里面存在Button ...

- 手把手教你进行Scrapy中item类的实例化操作

接下来我们将在爬虫主体文件中对Item的值进行填充. 1.首先在爬虫主体文件中将Item模块导入进来,如下图所示. 2.第一步的意思是说将items.py中的ArticleItem类导入到爬虫主体文件 ...

- 第十七节:Scrapy爬虫框架之item.py文件以及spider中使用item

Scrapy原理图: item位于原理图的最左边 item.py文件是报存爬取数据的容器,他使用的方法和字典很相似,但是相比字典item多了额外的保护机制,可以避免拼写错误或者定义错误. 1.创建it ...

- Scrapy中使用cookie免于验证登录和模拟登录

Scrapy中使用cookie免于验证登录和模拟登录 引言 python爬虫我认为最困难的问题一个是ip代理,另外一个就是模拟登录了,更操蛋的就是模拟登录了之后还有验证码,真的是不让人省心,不过既然有 ...

- scrapy中的request

scrapy中的request 初始化参数 class scrapy.http.Request( url [ , callback, method='GET', headers, body, cook ...

- [转]scrapy中的request.meta

作者:知乎用户链接:https://www.zhihu.com/question/54773510/answer/146971644 meta属性是字典,字典格式即{'key':'value'},字典 ...

- 论Scrapy中的数据持久化

引入 Scrapy的数据持久化,主要包括存储到数据库.文件以及内置数据存储. 那我们今天就来讲讲如何把Scrapy中的数据存储到数据库和文件当中. 终端指令存储 保证爬虫文件的parse方法中有可迭代 ...

- 使用scrapy中xpath选择器的一个坑点

情景如下: 一个网页下有一个ul,这个ur下有125个li标签,每个li标签下有我们想要的 url 字段(每个 url 是唯一的)和 price 字段,我们现在要访问每个li下的url并在生成的请求中 ...

随机推荐

- P3355 骑士共存问题

P3355 骑士共存问题 题目描述 在一个 n*n (n <= 200)个方格的国际象棋棋盘上,马(骑士)可以攻击的棋盘方格如图所示.棋盘上某些方格设置了障碍,骑士不得进入 对于给定的 n*n ...

- asp.net获取当前页面的url地址

设当前页完整地址是:http://www.jb51.net/aaa/bbb.aspx?id=5&name=kelli "http://"是协议名 "www.jb5 ...

- Sql Server 优化技巧

1.查看执行时间和cpu占用时间 set statistics time on select * from dbo.Product set statistics time off 打开你查询之后的消息 ...

- KVM基本实现原理

KVM 虚拟化技术概述 http://blog.csdn.net/yearn520/article/details/6461047 KVM 虚拟化技术在 AMD 平台上的实现 1.http://www ...

- Kafka 0.8 Consumer Rebalance

1 Rebalance时机 0.10kafka的rebalance条件 条件1:有新的consumer加入 条件2:旧的consumer挂了 条件3:coordinator挂了,集群选举出新的coor ...

- solr配置中文分词器——(十二)

aaarticlea/png;base64,iVBORw0KGgoAAAANSUhEUgAAAqcAAAGzCAIAAACdKClDAAAgAElEQVR4nOydd5gUxdbGx5xASZKXLB

- 【Linux技术】autotools制作makefile过程详解【转】

转自:http://www.cnblogs.com/lcw/p/3159461.htmlPreface Makefile固然可以帮助make完成它的使命,但要承认的是,编写Makefile确实不是一件 ...

- Pytorch数据读取框架

训练一个模型需要有一个数据库,一个网络,一个优化函数.数据读取是训练的第一步,以下是pytorch数据输入框架. 1)实例化一个数据库 假设我们已经定义了一个FaceLandmarksDataset数 ...

- 五、springcloud之客户端负载均衡Ribbon

一.简介 在微服务架构中,业务都会被拆分成一个独立的服务,服务与服务的通讯是基于http restful的.Spring cloud有两种服务调用方式: 一种是ribbon+restTemplate, ...

- 数据结构之 栈 (Python 版)

数据结构之 栈 (Python 版) -- 利用线性表实现栈 栈的特性: 后进先出 基于顺序表实现栈 class SStack(): ''' 基于顺序表 实现的 栈类 ''' def __init__ ...