map reduce程序示例

map reduce程序示例

package test2; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat; import java.io.IOException; /**

样例数据中包含了年份和温度,提出年份里温度最大的

(0, 0067011990999991950051507+0000+),

(33, 0043011990999991950051512+0022+),

(66, 0043011990999991950051518-0011+),

(99, 0043012650999991949032412+0111+),

(132, 0043012650999991949032418+0078+),

(165, 0067011990999991937051507+0001+),

(198, 0043011990999991937051512-0002+),

(231, 0043011990999991945051518+0001+),

(264, 0043012650999991945032412+0002+),

(297, 0043012650999991945032418+0078+),

* */

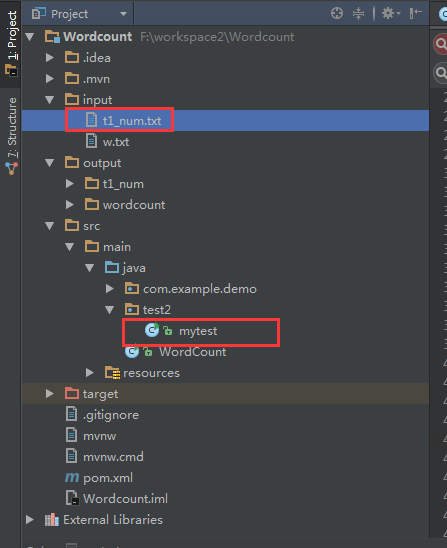

public class mytest { static String INPUT_PATH="input/t1_num.txt"; //待统计的文件路径

static String OUTPUT_PATH="output/t1_num"; //统计结果存放的路径 static class MyMapper extends Mapper <Object,Object,Text,IntWritable> { //定义继承mapper类

protected void map(Object key, Object value, Context context) throws IOException, InterruptedException{ //定义map方法 String[] arr=value.toString().split("\\),"); //文件中的单词是以“),”分割的,并将每一行定义为一个数组

for(int i=0;i<arr.length;i++){ //遍历循环每一行,统计单词出现的数量

String line = arr[i].toString();

String year = line.substring(line.length()-16, line.length()-12);

String airTemperature = line.substring(line.length()-6, line.length()-1);

context.write(new Text(year),new IntWritable(Integer.valueOf(airTemperature)));

}

/**

map过程中,通过对字符串的解析,得到年-温度的key-value对作为输出

(1950, 0)

(1950, 22)

(1950, -11)

(1949, 111)

(1949, 78)

(1937, 1)

(1937, -2)

(1945, 1)

(1945, 2)

(1945, 78)

*/

}

} static class MyReduce extends Reducer<Text,IntWritable,Text,IntWritable>{ //定义继承reducer类

protected void reduce(Text key,Iterable<IntWritable> values,Context context) throws IOException,InterruptedException{ //定义reduce方法

int max = 0;

for(IntWritable c:values){ //统计同一个单词的数量

if(c.get()>max){

max = c.get();//获取value值

}

}

IntWritable outValue=new IntWritable(max);//挨个输出

context.write(key,outValue);

}

/**

在reduce过程,将map过程中的输出,按照相同的key(年份)将value放到同一个列表中作为reduce的输入

(1950, [0, 22, –11])

(1949, [111, 78])

(1937, [1, -2])

(1945, [1, 2, 78]) 在reduce过程中,在列表中选择出最大的温度,将年-max温度的key-value作为输出:

(1950, 22)

(1949, 111)

(1937, 1)

(1945, 78)

*/ } public static void main(String[] args) throws Exception{ //main函数

System.setProperty("hadoop.home.dir", "D:\\hadoop-2.7.6");//这一行一定要

Path outputpath=new Path(OUTPUT_PATH); //输出路径

Configuration conf=new Configuration();

Job job=Job.getInstance(conf); //定义一个job,启动任务

FileInputFormat.setInputPaths(job, INPUT_PATH);

FileOutputFormat.setOutputPath(job,outputpath); job.setMapperClass(MyMapper.class);

job.setReducerClass(MyReduce.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

job.waitForCompletion(true);

} }

map reduce程序示例的更多相关文章

- Hadoop学习笔记2 - 第一和第二个Map Reduce程序

转载请标注原链接http://www.cnblogs.com/xczyd/p/8608906.html 在Hdfs学习笔记1 - 使用Java API访问远程hdfs集群中,我们已经可以完成了访问hd ...

- eclipse 中运行 Hadoop2.7.3 map reduce程序 出现错误(null) entry in command string: null chmod 0700

运行map reduce任务报错: (null) entry in command string: null chmod 0700 解决办法: 在https://download.csdn.net/d ...

- 使用Python实现Map Reduce程序

使用Python实现Map Reduce程序 起因 想处理一些较大的文件,单机运行效率太低,多线程也达不到要求,最终采用了集群的处理方式. 详细的讨论可以在v2ex上看一下. 步骤 MapReduce ...

- 第一个map reduce程序

完成了第一个mapReduce例子,记录一下. 实验环境: hadoop在三台ubuntu机器上部署 开发在window7上进行 hadoop版本2.2.0 下载了hadoop-eclipse-plu ...

- Hadoop 使用Combiner提高Map/Reduce程序效率

众所周知,Hadoop框架使用Mapper将数据处理成一个<key,value>键值对,再网络节点间对其进行整理(shuffle),然后使用Reducer处理数据并进行最终输出. 在上述过 ...

- Hadoop实战:使用Combiner提高Map/Reduce程序效率

好不easy算法搞定了.小数据測试也得到了非常好的结果,但是扔到进群上.挂上大数据就挂了.无休止的reduce不会结束了. .. .. .... .. ... .. ================= ...

- Hadoop Map/Reduce教程

原文地址:http://hadoop.apache.org/docs/r1.0.4/cn/mapred_tutorial.html 目的 先决条件 概述 输入与输出 例子:WordCount v1.0 ...

- Map/Reduce 工作机制分析 --- 作业的执行流程

前言 从运行我们的 Map/Reduce 程序,到结果的提交,Hadoop 平台其实做了很多事情. 那么 Hadoop 平台到底做了什么事情,让 Map/Reduce 程序可以如此 "轻易& ...

- Map/Reduce个人实战--生成数据测试集

背景: 在大数据领域, 由于各方面的原因. 有时需要自己来生成测试数据集, 由于测试数据集较大, 因此采用Map/Reduce的方式去生成. 在这小编(mumuxinfei)结合自身的一些实战经历, ...

随机推荐

- u3d摇杆

using UnityEngine; using System.Collections; public class JoystickController : MonoBehaviour { priva ...

- a.py

#!/usr/bin/python # -*- coding: UTF-8 -*- import os import sys import re import shutil import glob d ...

- codeforces411div.2

每日CF: 411div2 Solved A CodeForces 805A Fake NP Solved B CodeForces 805B 3-palindrome Solved C CodeFo ...

- .net 项目与网站区别

背景 .net 的又一个杰作,我作为资深开发人员,好久没搞明白两者关系,后来慢慢总算琢磨明白了.在2003和2005的时候,都是用的网站方式,后来见到某同事用的项目方式,当时还很不理解,真是个傻瓜程序 ...

- MySQL--表操作(innodb表字段数据类型、约束条件)、sql_mode操作

一.创建表的完整语法 #[]内的可有可无,即创建表时字段名和类型是必须填写的,宽度与约束条件是可选择填写的.create table 表名(字段名1 类型[(宽度) 约束条件],字段名2 类型[(宽度 ...

- kafka组件makemirror处理跨机房业务的应用

业务背景:app分散在不同的idc厂商不同的地域,产生业务数据都向一个kafka中进行处理,这些数据比较分散,如果一时网络抖动或者其他因素,数据就丢失了app --> kafka --> ...

- 修改svn默认端口

Subversion有两种不同的配置方式,一种基于它自带的轻量级服务器svnserve,一种基于非常流行的Web服务器Apache. 根据不同的配置方式,Subversion使用不同的端口对外提供服务 ...

- mac 上如何安装非app store上的下载的软件-------打开未知来源

打开了 Terminal 终端后 ,在命令提示后输入 sudo spctl --master-disable 并按下回车执行,如下图所示. 随后再输入当前 Mac 用户的密码,如下图所示. 如 ...

- 基于centos7下appium环境搭建

事件背景: 前几日在群里看到关总说他的server端是搭建在linux环境下,包括对客户端与服务端的交互处理,感觉整体思路清晰可鉴,于是就想尝试,动手实践,接着从环境搭建开始搞起,于是就有了这篇文章, ...

- PHP字符串比较,看起来值完全一样,但是就是不相等的解决方案(‌)

1 前言 字符串比较,看起来完全一样,然后用strcmp比较,永远不相等,用var_dump查看才知道,其中一个字符多了看不见的特殊符号,而我长度是3. 2 样例 当你选中它,显示出来的就是人眼所见 ...