.Net HttpWebRequest 爬虫核心爬取

1 爬虫,爬虫攻防

2 下载html

3 xpath解析html,获取数据和深度抓取(和正则匹配)

4 多线程抓取

熟悉http协议

提供两个方法Post和Get

public static string HttpGet(string url, Encoding encoding = null, Dictionary<string,string> headDic=null)

{

string html = string.Empty;

try

{

HttpWebRequest request = HttpWebRequest.Create(url) as HttpWebRequest;//模拟请求

request.Timeout = * ;

request.UserAgent = "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/51.0.2704.106 Safari/537.36";

request.ContentType = "text/html; charset=utf-8";

if (headDic != null)

{

foreach (var item in headDic)

{

request.Headers.Add(item.Key, item.Value);

}

}

if(encoding==null)

encoding = Encoding.UTF8; // 如果是乱码就改成 utf-8 / GB2312

else

encoding=Encoding.GetEncoding("GB2312");

using (HttpWebResponse response = request.GetResponse() as HttpWebResponse)

{

if (response.StatusCode != HttpStatusCode.OK)

{

log.Warn(string.Format("抓取{0}地址返回失败,response.StatusCode为{1}", url, response.StatusCode));

}

else

{

try

{

StreamReader sr = new StreamReader(response.GetResponseStream(), encoding);

html = sr.ReadToEnd();//读取数据

sr.Close();

}

catch (Exception ex)

{

log.Error(string.Format("DownloadHtml抓取{0}保存失败", url), ex);

html = null;

}

}

} }

catch (WebException ex)

{

if (ex.Message.Equals("远程服务器返回错误: (306)。"))

{

log.Error("远程服务器返回错误: (306)。", ex);

return null;

}

}

catch (Exception ex)

{

log.Error(string.Format("DownloadHtml抓取{0}出现异常", url), ex);

html = null;

}

return html;

}

/// <summary>

/// Post 调用借口

/// </summary>

/// <param name="url">接口地址</param>

/// <param name="value">接口参数</param>

/// <returns></returns>

public static string HttpPost(string url, string value)

{

string param = value;

Stream stream = null;

byte[] postData = Encoding.UTF8.GetBytes(param);

try

{

HttpWebRequest myRequest = (HttpWebRequest)WebRequest.Create(url); myRequest.Method = "POST";

myRequest.ContentType = "application/x-www-form-urlencoded";

myRequest.ContentLength = postData.Length;

stream = myRequest.GetRequestStream();

stream.Write(postData, , postData.Length); HttpWebResponse myResponse = (HttpWebResponse)myRequest.GetResponse();

if (myResponse.StatusCode == HttpStatusCode.OK)

{

StreamReader sr = new StreamReader(myResponse.GetResponseStream(), Encoding.UTF8);

string rs = sr.ReadToEnd().Trim();

sr.Close();

return rs;

}

else

{

return "失败:Status:" + myResponse.StatusCode.ToString();

}

}

catch (Exception ex)

{

return "失败:ex:" + ex.ToString();

}

finally

{

if (stream != null)

{

stream.Close();

stream.Dispose();

}

}

}

下载Html

StreamWriter sw = new StreamWriter("路径.txt", true, Encoding.GetEncoding("utf-8"));

sw.Write("爬取的html字符串");

sw.Close();

xpath

http://www.cnblogs.com/zhaozhan/archive/2009/09/09/1563617.html

http://www.cnblogs.com/zhaozhan/archive/2009/09/09/1563679.html

http://www.cnblogs.com/zhaozhan/archive/2009/09/10/1563703.html

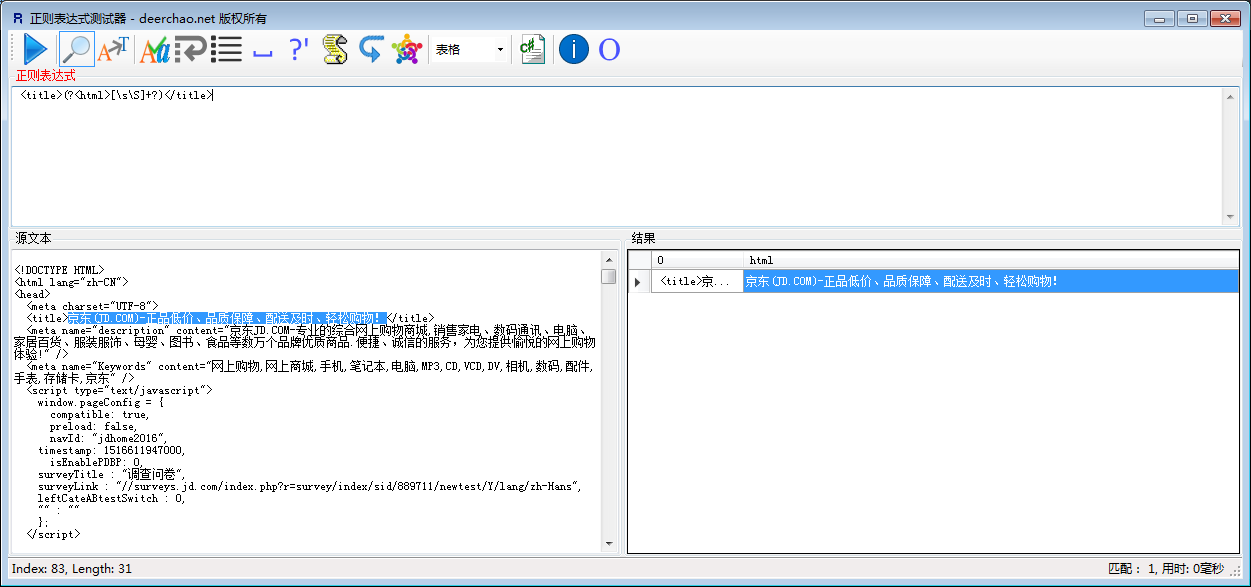

正则匹配

目前使用起来最好用的正则

<title>(?<html>[\s\S]+?)</title> 意思是匹配 <title> *********</title>标签里面的任意字符串

Regex reTitle = new Regex(@"<title>(?<html>[\s\S]+?)</title>"/>");

string title = reTitle.Match(html).Groups["html"].Value;

多个选择

Regex rgInfo = new Regex(@"<td align=""left"">(?<company>[^<>]+)</td><td align=""center"">(?<id>[\dA-Z]+)</td><td align=""center"">(?<cat>[^<>]+)</td><td align=""center"">(?<grade>[A-Z]+)</td><td align=""center"">(?<date>[^\s&]*)");

MatchCollection mchInfos = rgInfo.Matches(strHtml);

foreach (Match m in mchInfos)

{

string strCompany = m.Groups["company"].Value;

string strId = m.Groups["id"].Value;

string strCat = m.Groups["cat"].Value.Replace(" ", "");

string grade = m.Groups["grade"].Value;

string date = m.Groups["date"].Value;

}

多线程

List<Task> taskList = new List<Task>();

TaskFactory taskFactory = new TaskFactory();

for(int i=;i<;i++)

{

taskList.Add(taskFactory.StartNew(Crawler));//将一个执行Crawler方法的线程放到集合里面,创建并启动 任务

if (taskList.Count > ) //线程池启动15个线程

{

taskList = taskList.Where(t => !t.IsCompleted && !t.IsCanceled && !t.IsFaulted).ToList();

Task.WaitAny(taskList.ToArray());//有线程执行完毕

}

}

Task.WaitAll(taskList.ToArray());//100个线程全部执行完成

Console.WriteLine("抓取全部完成 - -", DateTime.Now);

该文档只是自己记录,纯属记事本

.Net HttpWebRequest 爬虫核心爬取的更多相关文章

- 使用htmlparse爬虫技术爬取电影网页的全部下载链接

昨天,我们利用webcollector爬虫技术爬取了网易云音乐17万多首歌曲,而且还包括付费的在内,如果时间允许的话,可以获取更多的音乐下来,当然,也有小伙伴留言说这样会降低国人的知识产权保护意识,诚 ...

- [Python爬虫] Selenium爬取新浪微博客户端用户信息、热点话题及评论 (上)

转载自:http://blog.csdn.net/eastmount/article/details/51231852 一. 文章介绍 源码下载地址:http://download.csdn.net/ ...

- scrapy进阶(CrawlSpider爬虫__爬取整站小说)

# -*- coding: utf-8 -*- import scrapy,re from scrapy.linkextractors import LinkExtractor from scrapy ...

- 使用htmlparser爬虫技术爬取电影网页的全部下载链接

昨天,我们利用webcollector爬虫技术爬取了网易云音乐17万多首歌曲,而且还包括付费的在内,如果时间允许的话,可以获取更多的音乐下来,当然,也有小伙伴留言说这样会降低国人的知识产权保护意识,诚 ...

- scrapy-redis实现爬虫分布式爬取分析与实现

本文链接:http://blog.csdn.net/u012150179/article/details/38091411 一 scrapy-redis实现分布式爬取分析 所谓的scrapy-redi ...

- 网络爬虫之定向爬虫:爬取当当网2015年图书销售排行榜信息(Crawler)

做了个爬虫,爬取当当网--2015年图书销售排行榜 TOP500 爬取的基本思想是:通过浏览网页,列出你所想要获取的信息,然后通过浏览网页的源码和检查(这里用的是chrome)来获相关信息的节点,最后 ...

- python 爬虫之爬取大街网(思路)

由于需要,本人需要对大街网招聘信息进行分析,故写了个爬虫进行爬取.这里我将记录一下,本人爬取大街网的思路. 附:爬取得数据仅供自己分析所用,并未用作其它用途. 附:本篇适合有一定 爬虫基础 crawl ...

- Python爬虫之爬取慕课网课程评分

BS是什么? BeautifulSoup是一个基于标签的文本解析工具.可以根据标签提取想要的内容,很适合处理html和xml这类语言文本.如果你希望了解更多关于BS的介绍和用法,请看Beautiful ...

- python爬虫项目-爬取雪球网金融数据(关注、持续更新)

(一)python金融数据爬虫项目 爬取目标:雪球网(起始url:https://xueqiu.com/hq#exchange=CN&firstName=1&secondName=1_ ...

随机推荐

- Chrome性能分析工具lightHouse用法指南

本文主要讲如何使用Chrome开发者工具linghtHouse进行页面性能分析. 1.安装插件 非常简单,点击右上角的“添加至Chrome”即可. 2.使用方式 1)打开要测试的页面,点击浏览器右上角 ...

- ubuntu中设置wireshark抓包

安装wireshark软件后,打开进行抓包的时候会提示权限不足.原因是普通用户没有执行权限,也打不开网络端口捕捉,因为dumpcap需要root权限. 产生这种问题的原因:比如:wireshark在进 ...

- 3款Linux网络监视工具

1 iftop: 如果你想看到现在你的带宽到底是哪些应用在使用,并且各个应用占据了多少带宽的时候,可以用iftop显示出来.使用的参数如下: -h display t ...

- 微信小程序开发:学习笔记[3]——WXSS样式

微信小程序开发:学习笔记[3]——WXSS样式 快速开始 介绍 WXSS(WeiXin Style Sheets)是一套用于小程序的样式语言,用于描述WXML的组件样式,也就是视觉上的效果. WXSS ...

- 【python】用python脚本Paramiko实现远程执行命令、下载、推送/上传文件功能

Paramiko: paramiko模块,基于SSH用于连接远程服务器并执行相关操作. SSHClient: 用于连接远程服务器并执行基本命令 SFTPClient: 用于连接远程服务器并执行上传下载 ...

- mvc Bundling 学习记录(一)

参考博客:http://www.cnblogs.com/xwgli/p/3296809.html 这里要详细记录的是对于现有MVC项目进行Bundling功能 1 如果没有System.Web.Op ...

- <算法导论>高级数据结构--以我的角度看B树(Balanced-Tree)的建增删查

题外话:在博客园看了几篇关于B树的博文确实很有帮助,但是也看到有一些Funny的博文- -比如拿二叉树堂(BinaryTree)而皇之写上B树的帽子. 好了题归正传,B树(Balanced-Tree) ...

- smokeping 出现的问题

Global symbol "%Config" requires explicit package name at /usr/lib64/perl5/lib.pm line 10. ...

- 鸟哥的linux私房菜 - 第三章 主机规划与磁盘分区

各硬件装置在linux中的文件名 在linux系统中,每个装置都被当成一个档案来对待. 常见的装置与其在linux中的档名: 磁盘分区 磁盘链接的方式与装置文件名的关系 个人计算机常见的磁盘接口有两种 ...

- python做简易记事本

以下内容参考<辛星tkinter教程第二版>: from tkinter import * from tkinter.filedialog import * from tkinter.me ...