spark学习3(sqoop1.4.6安装)

sqoop目前有两个版本sqoop1和sqoop2,这里安装的是sqoop1版本

1)将软件上传到spark1节点

2)修改权限

[root@spark1 sqoop]# chmod u+x sqoop-1.4.6.bin__hadoop-2.0.4-alpha.tar.gz

3)解压安装

[root@spark1 sqoop]# tar -zxvf sqoop-1.4.6.bin__hadoop-2.0.4-alpha.tar.gz

4)重命名

[root@spark1 sqoop]# mv sqoop-1.4.6.bin__hadoop-2.0.4-alpha.tar.gz sqoop-1.4

5)配置环境变量

[root@spark1 sqoop]# vi /etc/profile

export SQOOP_HOME=/usr/sqoop/sqoop-1.4

export PATH=$PATH:$SQOOP_HOME/bin

export LOGDIR=$SQOOP_HOME/logs #一定要加上这个

6)使环境变量生效并验证是否配置成功

[root@spark1 sqoop-1.4]# source /etc/profile

[root@spark1 sqoop-1.4]# which sqoop

7)修改配置文件 sqoop-env.sh

[root@spark1 conf]# mv sqoop-env-template.sh sqoop-env.sh

#重命名

[root@spark1 conf]# vi sqoop-env.sh

#Set path to where bin/hadoop is available

export HADOOP_COMMON_HOME=/usr/hadoop/hadoop-2.6.0

#Set path to where hadoop-*-core.jar is available

export HADOOP_MAPRED_HOME=/usr/hadoop/hadoop-2.6.0

#Set the path to where bin/hive is available

export HIVE_HOME=/usr/hive/hive-1.2

暂时没安装hbase和zookeeper就不修改了

8)将所需要的mysql驱动包拷贝到Sqoop/lib下

#先在网上下载驱动包mysql-connector-java-5.1.10.jar

[root@spark1 sqoop]# cp mysql-connector-java-5.1.10.jar /usr/sqoop/sqoop-1.4/lib

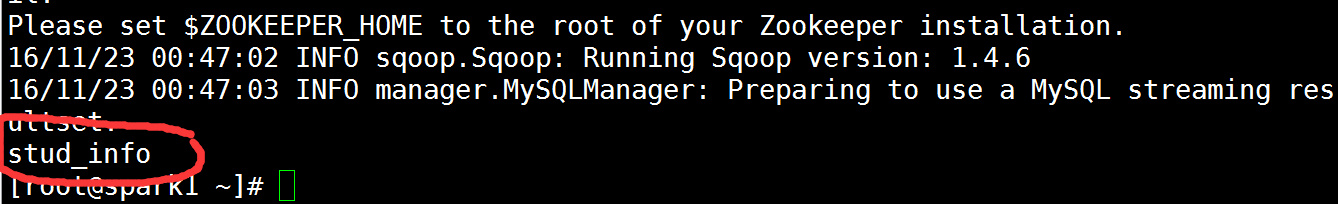

9)测试sqoop

显示mysql下所有数据库

[root@spark1 sqoop]# sqoop list-databases --connect jdbc:mysql://spark1:3306 --username root

查看mysql wujiadong数据库中的表

[root@spark1 ~]# sqoop list-tables --connect jdbc:mysql://spark1:3306/wujiadong -username root

注释

1)因为暂时没安装hbase和zookeeper,没修改sqoop中的配置文件内容,运行时出现警示,不过问题不大。

2)命令sqoop list-databases --connect jdbc:mysql://spark1:3306 --username root --password xxx中

username和password使mysql的用户名和密码,我因为没去设置mysql的密码,所以直接无密码登录

spark学习3(sqoop1.4.6安装)的更多相关文章

- spark学习(2)--hadoop安装、配置

环境: 三台机器 ubuntu14.04 hadoop2.7.5 jdk-8u161-linux-x64.tar.gz (jdk1.8) 架构: machine101 :名称节点.数据节点.Secon ...

- spark学习2-1(hive1.2安装)

由于前面安装版本过老,导致学习过程中出现了很多问题,今天安装了一个新一点的版本.安装结束启动时遇到一点问题,记录在这里. 第一步:hive-1.2安装 通过WinSCP将apache-hive-1.2 ...

- spark学习2(hive0.13安装)

第一步:hive安装 通过WinSCP将apache-hive-0.13.1-bin.tar.gz上传到/usr/hive/目录下 [root@spark1 hive]# chmod u+x apac ...

- Spark学习(一) -- Spark安装及简介

标签(空格分隔): Spark 学习中的知识点:函数式编程.泛型编程.面向对象.并行编程. 任何工具的产生都会涉及这几个问题: 现实问题是什么? 理论模型的提出. 工程实现. 思考: 数据规模达到一台 ...

- Spark学习笔记--Linux安装Spark集群详解

本文主要讲解如何在Linux环境下安装Spark集群,安装之前我们需要Linux已经安装了JDK和Scala,因为Spark集群依赖这些.下面就如何安装Spark进行讲解说明. 一.安装环境 操作系统 ...

- 用Spark学习FP Tree算法和PrefixSpan算法

在FP Tree算法原理总结和PrefixSpan算法原理总结中,我们对FP Tree和PrefixSpan这两种关联算法的原理做了总结,这里就从实践的角度介绍如何使用这两个算法.由于scikit-l ...

- 用Spark学习矩阵分解推荐算法

在矩阵分解在协同过滤推荐算法中的应用中,我们对矩阵分解在推荐算法中的应用原理做了总结,这里我们就从实践的角度来用Spark学习矩阵分解推荐算法. 1. Spark推荐算法概述 在Spark MLlib ...

- Spark学习笔记2(spark所需环境配置

Spark学习笔记2 配置spark所需环境 1.首先先把本地的maven的压缩包解压到本地文件夹中,安装好本地的maven客户端程序,版本没有什么要求 不需要最新版的maven客户端. 解压完成之后 ...

- spark 学习路线及参考课程

一.Scala编程详解: 第1讲-Spark的前世今生 第2讲-课程介绍.特色与价值 第3讲-Scala编程详解:基础语法 第4讲-Scala编程详解:条件控制与循环 第5讲-Scala编程详解:函数 ...

随机推荐

- jQuery之获取select选中的值

本来以为jQuery("#select1").val();是取得选中的值, 那么jQuery("#select1").text();就是取得的文本. 这是不正确 ...

- Java多线程同步锁的理解

java主要通过synchronized的关键字来实现的.让我们从一个买票程序说起吧. package com.day04; /** * * @author Administrator 问题描述:使用 ...

- django-websocket 安装及配置

1.安装 dwebsocket (venv) C:\code_object\websocketTest>pip install dwebsocket -i https://pypi.douban ...

- django项目部署在Apache服务器中,静态文件路径的注意点

django Apache部署静态文件的路径注意点 静态文件放在对应的 app 下的 static 文件夹中 或者 STATICFILES_DIRS 中的文件夹中. 当 DEBUG = True 时, ...

- velocity 的 escape实现

EscapeHtmlReference的escape方法调用以下方法实现: StringEscapeUtils.escapeHtml(param); 再调用 org.apache.commons.la ...

- 数据库之MySQL(四)

数据库中的范式: 第一范式(1NF): 数据表中的每一列(字段),必须是不可拆分的最小单元,也就是确保每一列的原子性. 例如: userInfo: '山东省烟台市 1318162008' 依照第一范式 ...

- python多线程(三)

同步锁 两个需要注意的点: 线程抢的是GIL锁,GIL锁相当于执行权限,拿到执行权限后才能拿到互斥锁Lock,其他线程也可以抢到GIL,但如果发现Lock仍然没有被释放则阻塞,即便是拿到执行权限GIL ...

- MySQL 5.6 死锁演示 及 日志分析

1. 表结构 CREATE TABLE dead_update ( a ) ', PRIMARY KEY (a) ) ENGINE=InnoDB DEFAULT CHARSET=utf8 ; ), ...

- Linux中的grep和cut

提取行: grep --color 着色 -v 不包含 提取列: cut -f 列号 提取第几列 -d 分隔符 以什么为分隔符,默认是制表键 局限性:如果分隔符不那 ...

- windows下 安装python_ldap MySQL-python

//////////////////////////////////////////////////// 失败 ---------------------------------------- F ...