爬虫之scrapy简单案例之猫眼

在爬虫py文件下

class TopSpider(scrapy.Spider):

name = 'top'

allowed_domains = ['maoyan.com']

start_urls = ['https://maoyan.com/board/4'] def parse(self, response):

dds = response.xpath('//dl/dd')

for dd in dds:

dic = MaoyanItem()

# dic = {}

dic['name'] = dd.xpath('.//p[@class="name"]//text()').extract_first()

dic['star'] = dd.xpath('.//p[@class="star"]/text()').extract_first().replace('\n', '').replace(' ', '')

dic['releasetime'] = dd.xpath('.//p[@class="releasetime"]/text()').extract_first()

score1 = dd.xpath('.//p[@class="score"]/i[1]/text()').extract_first()

score2 = dd.xpath('.//p[@class="score"]/i[2]/text()').extract_first()

dic['score'] = score1 + score2

# 详情页

xqy_url = 'https://maoyan.com' + dd.xpath('.//p[@class="name"]/a/@href').extract_first()

yield scrapy.Request(xqy_url, callback=self.xqy_parse, meta={'dic': dic})

# 翻页

next_url = response.xpath('//a[text()="下一页"]/@href').extract_first()

if next_url:

url = 'https://maoyan.com/board/4' + next_url

yield scrapy.Request(url, callback=self.parse) def xqy_parse(self,response):

dic = response.meta['dic']

dic['type'] = response.xpath('//ul/li[@class="ellipsis"][1]/text()').extract_first()

dic['area_time'] = response.xpath('//ul/li[@class="ellipsis"][2]/text()').extract_first().replace('\n', '').replace(' ', '')

yield dic

在items.py 文件中写入要展示的字段

class DoubanItem(scrapy.Item):

title = scrapy.Field()

inf = scrapy.Field()

score = scrapy.Field()

peo = scrapy.Field()

brief = scrapy.Field()

在pipelines.py文件写入要打印的文本

class DoubanPipeline(object):

def open_spider(self, spider):

self.file = open('douban.txt', 'a', encoding='utf-8') def process_item(self, item, spider):

self.file.write(str(item)+'\n') def close_spider(self, spider):

self.file.close()

pipelines.py文件也可用MongoDB书写

from pymongo import MongoClient class DoubanPipeline(object):

def open_spider(self,spider):

# self.file = open('douban.txt','a',encoding='utf8')

self.client = MongoClient()

self.collection = self.client['库名']['集合名']

self.count = 0 def process_item(self, item, spider):

# self.file.write(str(item)+'\n')

item['_id'] = self.count

self.count += 1

self.collection.insert_one(item)

return item def close_spider(self, spider):

# self.file.close()

self.client.close()

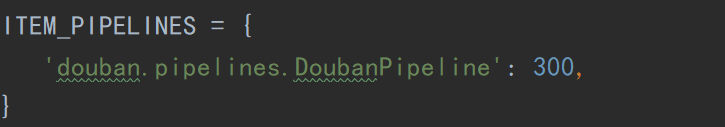

另外,记得在setting.py文件中配置一些信息,如

或者ROBOTS协议以及其他

爬虫之scrapy简单案例之猫眼的更多相关文章

- python自动化之爬虫原理及简单案例

[爬虫案例]动态地图里的数据如何抓取:以全国PPP综合信息平台网站为例 http://mp.weixin.qq.com/s/BXWTf5hmq8vp91ZvgaphEw [爬虫案例]动态页面的抓取! ...

- 爬虫框架Scrapy之案例二

新浪网分类资讯爬虫 爬取新浪网导航页所有下所有大类.小类.小类里的子链接,以及子链接页面的新闻内容. 效果演示图: items.py import scrapy import sys reload(s ...

- 爬虫框架Scrapy之案例三图片下载器

items.py class CoserItem(scrapy.Item): url = scrapy.Field() name = scrapy.Field() info = scrapy.Fiel ...

- 爬虫框架Scrapy之案例一

阳光热线问政平台 http://wz.sun0769.com/index.php/question/questionType?type=4 爬取投诉帖子的编号.帖子的url.帖子的标题,和帖子里的内容 ...

- 爬虫之CrawlSpider简单案例之读书网

项目名py文件下 class DsSpider(CrawlSpider): name = 'ds' allowed_domains = ['dushu.com'] start_urls = ['htt ...

- scrapy爬虫学习系列二:scrapy简单爬虫样例学习

系列文章列表: scrapy爬虫学习系列一:scrapy爬虫环境的准备: http://www.cnblogs.com/zhaojiedi1992/p/zhaojiedi_python_00 ...

- Python爬虫框架--Scrapy安装以及简单实用

scrapy框架 框架 -具有很多功能且具有很强通用性的一个项目模板 环境安装: Linux: pip3 install scrapy Windows: ...

- Python 爬虫之Scrapy框架

Scrapy框架架构 Scrapy框架介绍: 写一个爬虫,需要做很多的事情.比如:发送网络请求.数据解析.数据存储.反反爬虫机制(更换ip代理.设置请求头等).异步请求等.这些工作如果每次都要自己从零 ...

- Python逆向爬虫之scrapy框架,非常详细

爬虫系列目录 目录 Python逆向爬虫之scrapy框架,非常详细 一.爬虫入门 1.1 定义需求 1.2 需求分析 1.2.1 下载某个页面上所有的图片 1.2.2 分页 1.2.3 进行下载图片 ...

随机推荐

- SpringBootSecurity学习(17)前后端分离版之 OAuth2.0 数据库(JDBC)存储客户端

自动批准授权码 前面我们授权的流程中,第一步获取授权码的时候,都会经历一个授权是否同意页面: 这个流程就像第三方登录成功后,提问是否允许获取昵称和头像信息的页面一样,这个过程其实是可以自动同意的,需要 ...

- scalikejdbc 学习笔记(3)

重用connection: package com.citi.scalikejdbc import scalikejdbc._ import scalikejdbc.config._ object C ...

- 【MySQL】 用户授权

启动mysql命令符 grant all privileges on mysql.* to 'root'@'%' identified by '123456'; 给mysql用户root授权,'%'表 ...

- 小程序webview跳转页面后没有返回按钮完美解决方案

随着小程序越来越火爆,使一个产品如果只有公众号H5页面和APP显得不怎么完美,总感觉不搭上小程序这趟流量车,就会少了点什么,心里别扭地很.在此驱动下,我所在公司也决定赶紧上车. 但是,如果要按照小程序 ...

- PHP高效产生m个n范围内的不重复随机数(m<=n)

该算法非常巧妙的取随机数的位置(数组的下标),替代取随机数本身,每次取到一个随机数之后,就将其在取值范围中排除,下一次仅会在剩下的数字中取,一次遍历就可以完成随机数的选取,效率相当高. functio ...

- JAVA之类的动手动脑

1.默认构造方法与自定义的构造方法的冲突 package com.xu; class fool { int value; fool(int nowvalue) { value=nowvalue; } ...

- Redis之数据类型及命令

Redis(REmote DIctionary Server) 是一个遵守BSD协议.支持网络.可基于内存亦可持久化的日志型key-value存储系统. KEY 常用指令: 指令 注释 备注 exit ...

- requests模块(post)请求篇

'''利用parse模块模拟post请求分析百度词典分析步骤:1. 打开F122. 尝试输入单词girl,发现每敲一个字母后都有请求3. 请求地址是 http://fanyi.baidu.com/su ...

- maven解决无法从远程仓库获取ojdbc问题

原因 Oracle 的 ojdbc.jar 是收费的,Maven 中央库中实际上没有此资源 解决方法 手动下载相应的jar,然后将其安装到本地仓库.具体操作如下: 1\先去下载相关的jar包或者驱动 ...

- 代码审计-thinkphp3.2.3框架漏洞sql注入

开始复现审计一下tp3和tp5的框架漏洞,当个练习吧. 涉及注入的方法为where() table() delete()等. 环境 tp3.2.3 : 0x01 注入成因 测试代码: public f ...