关于在使用sparksql写程序是报错以及解决方案:org.apache.spark.sql.AnalysisException: Duplicate column(s): "name" found, cannot save to file.

说明:

spark --version : 2.2.0

我有两个json文件,分别是emp和dept:

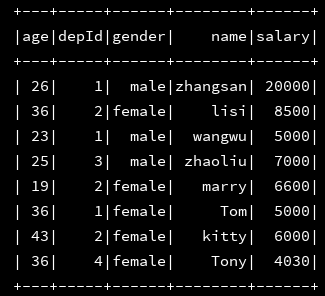

emp内容如下:

{"name": "zhangsan", "age": 26, "depId": 1, "gender": "male", "salary": 20000}

{"name": "lisi", "age": 36, "depId": 2, "gender": "female", "salary": 8500}

{"name": "wangwu", "age": 23, "depId": 1, "gender": "male", "salary": 5000}

{"name": "zhaoliu", "age": 25, "depId": 3, "gender": "male", "salary": 7000}

{"name": "marry", "age": 19, "depId": 2, "gender": "female", "salary": 6600}

{"name": "Tom", "age": 36, "depId": 1, "gender": "female", "salary": 5000}

{"name": "kitty", "age": 43, "depId": 2, "gender": "female", "salary": 6000}

{"name": "Tony","age": 36,"depId": 4,"gender":"female","salary": 4030}

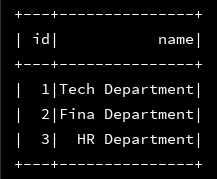

dept内容如下:

{"id": 1, "name": "Tech Department"}

{"id": 2, "name": "Fina Department"}

{"id": 3, "name": "HR Department"}

现在我需要通过sparksql将两个文件加载进来并做join,最后将结果保存到本地

下面是操作步骤:

1、初始化配置

val conf = new SparkConf().setMaster("local[2]").setAppName("Load_Data")

val sc = new SparkContext(conf)

val ssc = new sql.SparkSession.Builder()

.appName("Load_Data_01")

.master("local[2]")

.getOrCreate()

sc.setLogLevel("error") //测试环境为了少打印点日志,我将日志级别设置为error

2、将两个json文件加载进来

val df_emp = ssc.read.json("file:///E:\\javaBD\\BD\\json_file\\employee.json")

val df_dept = ssc.read.format("json").load("file:///E:\\javaBD\\BD\\json_file\\department.json")

3、分别将加载进来的两个json文件打印出来,看看是否成功载入

df_emp.show()

df_dept.show()

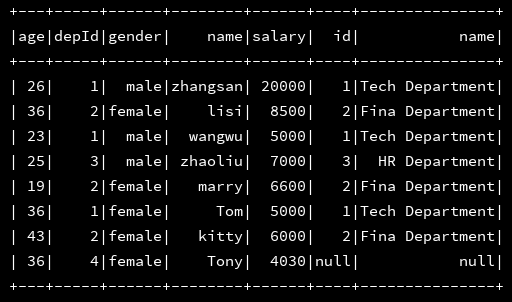

4、数据加载都没有问题,接下来二者进行join操作:

df_emp.join(df_dept,df_emp("depId") === df_dept("id"),"left").show()

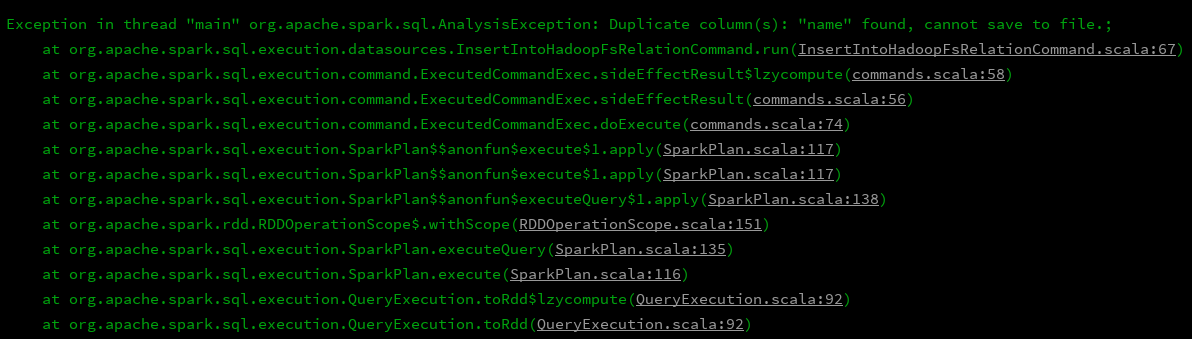

5、这样结果也可以正常打印出来了,貌似是没有什么问题了,接下来直接就save就可以了呗,但是进行save的时候就报错了:

df_emp.join(df_dept,df_emp("depId") === df_dept("id"),"left").write.mode(SaveMode.Append).csv("file:///E:\\javaBD\\BD\\json_file\\rs")

于是开始百度,找到了原因,论坛链接,大致的意思就是说,要保存的表中有相同的name字段,这样是不行的,那么解决方案就很明显了,让两个那么字段名称不相同么,那就分别给他们其别名呗,接下来开始修改代码:

1、初始化配置不变

2、读文件不变

3、跟别获取到两个DF(json文件加载加载进来之后就是两个DF)的列明,并进行分别设置别名

//分别拿出两张表的列名

val c_emp = df_emp.columns

val c_dept = df_dept.columns

//分别对两张表的别名进行设置

val emp = df_emp.select(c_emp.map(n => df_emp(n).as("emp_" + n)): _*)

val dept = df_dept.select(c_dept.map(n => df_dept(n).as("dept_" + n)): _*)

4、接着在进行保存,程序报错消失:

emp.join(dept,emp("emp_depId") === dept("dept_id"),"left").write.mode(SaveMode.Append).csv("file:///E:\\javaBD\\BD\\json_file\\rs")

这里的这个保存的路径说名一下:我是保存在windows本地,因为我配置了hadoop的环境变量,所以如果写本地需要这样写,如果去掉"file:///"的话,idea会认为是hdfs的路径,所有会报错路径找不到错误,如果要写入到hdfs的话,最好将地址写全:hdfs://namenode_ip:9000/file

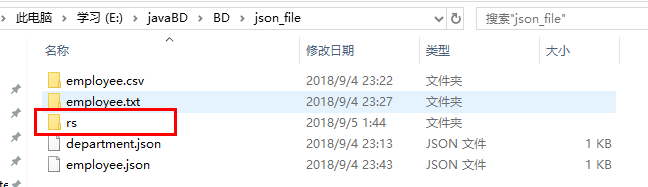

程序没有报错,然后到指定目录下查看,文件是否写入:

文件已经成功写入,over

关于在使用sparksql写程序是报错以及解决方案:org.apache.spark.sql.AnalysisException: Duplicate column(s): "name" found, cannot save to file.的更多相关文章

- Django(21)migrate报错的解决方案

前言 在讲解如何解决migrate报错原因前,我们先要了解migrate做了什么事情,migrate:将新生成的迁移脚本.映射到数据库中.创建新的表或者修改表的结构. 问题1:migrate怎么判断哪 ...

- vue-cesium中经纬度写反了,报错

vue-cesium中经纬度写反了,报错 [Vue warn]: Invalid prop: custom validator check failed for prop "position ...

- Spark程序编译报错error: object apache is not a member of package org

Spark程序编译报错: [INFO] Compiling 2 source files to E:\Develop\IDEAWorkspace\spark\target\classes at 156 ...

- 运行netcore2.2程序是报错

运行netcore2.2程序是报错 C:\myself\WuZhui\WuZhui\bin\Release\netcoreapp2.2>dotnet WuZhui.DLLError: An as ...

- 新手常见的python报错及解决方案

此篇文章整理新手编写代码常见的一些错误,有些错误是粗心的错误,但对于新手而已,会折腾很长时间才搞定,所以在此总结下我遇到的一些问题.希望帮助到刚入门的朋友们.后续会不断补充. 目录 1.NameErr ...

- 关于mybatis的xml文件中使用 >= 或者 <= 号报错的解决方案

当我们需要通过xml格式处理sql语句时,经常会用到< ,<=,>,>=等符号,但是很容易引起xml格式的错误,这样会导致后台将xml字符串转换为xml文档时报错,从而导致程序 ...

- 报错:SQLSTATE[23000]: Integrity constraint violation: 1062 Duplicate entry 'admin' for key 'username'

在提交注册信息的时候报错:SQLSTATE[23000]: Integrity constraint violation: 1062 Duplicate entry 'admin' for key ' ...

- 关于Entity Framework中的Attached报错相关解决方案的总结

关于Entity Framework中的Attached报错的问题,我这里分为以下几种类型,每种类型我都给出相应的解决方案,希望能给大家带来一些的帮助,当然作为读者的您如果觉得有不同的意见或更好的方法 ...

- Mysql only_full_group_by以及其他关于sql_mode原因报错详细解决方案

Mysql only_full_group_by以及其他关于sql_mode原因报错详细解决方案 网上太多相关资料,但是抄袭严重,有的讲的也是之言片语的,根本不连贯(可能知道的人确实不想多说) 我总共 ...

随机推荐

- 20145326蔡馨熤《网络对抗》—— Web基础

20145326蔡馨熤<网络对抗>—— Web基础 1.实验后回答问题 (1)什么是表单. 表单是一个包含表单元素的区域,表单元素是允许用户在表单中输入信息的元素,表单在网页中主要负责数据 ...

- JS、JAVA刷题和C刷题的一个很重要的区别

就是最近在做树方面的题时,发现JS和JAVA刷题和C刷题的一个很重要的区别就是传入null的区别 当遍历的时候,C传参数时可以传进去null的指针,因为递归进去,出来时,指针还是指着那个地方 但是JS ...

- 【Python029--一个任务】

一.文件编写 任务:将文件(record.txt)中的数据进行分割,并按照以下规律保存起来: --小甲鱼的对话单独保存为boy_*.txt的文件(去掉“小甲鱼:”) --小客服的对话单独保存为girl ...

- Restful framework【第一篇】RESTful 规范

什么是RESTful REST与技术无关,代表的是一种软件架构风格,REST是Representational State Transfer的简称,中文翻译为“表征状态转移” REST从资源的角度类审 ...

- Awesome Torch

Awesome Torch This blog from: A curated list of awesome Torch tutorials, projects and communities. T ...

- 【Hadoop 分布式部署 六:环境问题解决和集群基准测试】

环境问题: 出现Temporary failure in name resolutionp-senior-zuoyan.com 的原因有很多,主要就是主机没有解析到, 那就在hadoop的sl ...

- 【AI】微软人工智能学习笔记(三)

微软R服务 01|开源的R R实际上是统计学的编程语言,主要作用是对数据挖掘,统计,分析,可视化,机器学习等. 02|微软R 03| HDInsight R Spark集群存储在azure blob ...

- Redis架构设计

高可用Redis服务架构分析与搭建 各种web开发业务中最为常用的key-value数据库了 应用: 在业务中用其存储用户登陆态(Session存储),加速一些热数据的查询(相比较mysql而言,速度 ...

- Docker6之Network containers

how to network your containers. Launch a container on the default network Docker includes support fo ...

- 操作 html 的时候是使用 dom 方法还是字符串拼接?

比如一个列表里面有很多个 li,要给他们加上数据.但多少个 li 是不确定的,由后台数据确定.这时候,就要动态生成 html 内容了. 那么,这个过程, 是使用 += 方法把标签.数据进行一个个的字符 ...