python3.4学习笔记(十三) 网络爬虫实例代码,使用pyspider抓取多牛投资吧里面的文章信息,抓取政府网新闻内容

python3.4学习笔记(十三) 网络爬虫实例代码,使用pyspider抓取多牛投资吧里面的文章信息

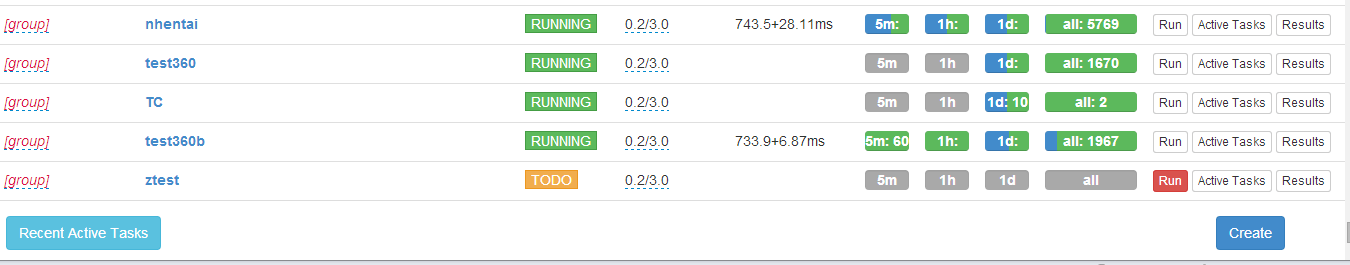

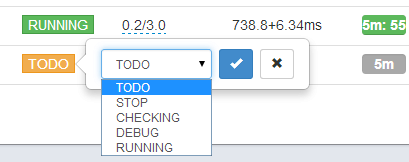

PySpider:一个国人编写的强大的网络爬虫系统并带有强大的WebUI,采用Python语言编写,分布式架构,支持多种数据库后端,强大的WebUI支持脚本编辑器,任务监视器,项目管理器以及结果查看器。

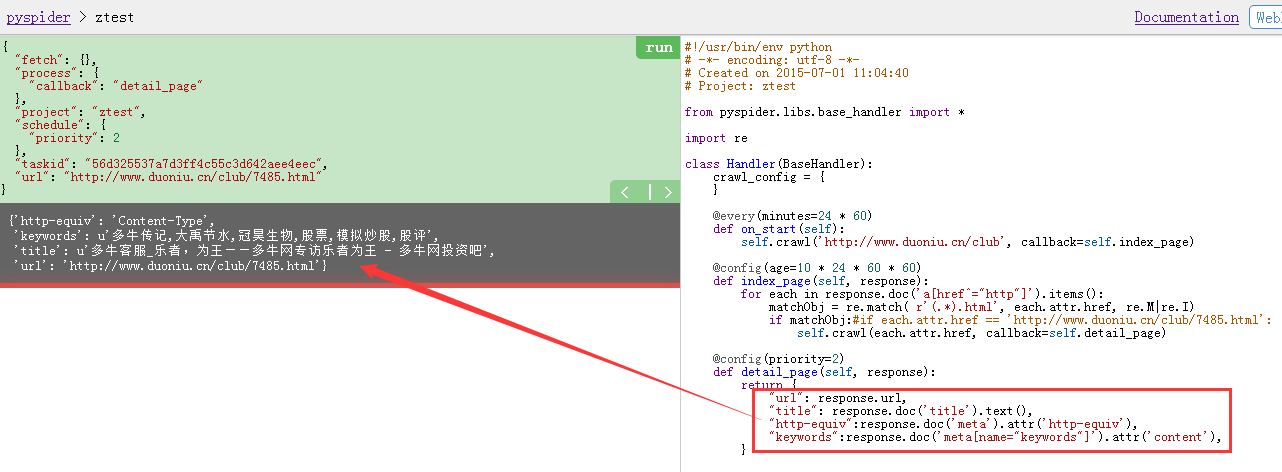

用pyspider的demo页面创建了一个爬虫,写一个正则表达式抓取多牛网站上特定的URL,很容易就得到想要的结果了,可以非常方便分析抓取页面里面的内容

binux/pyspider · GitHub

https://github.com/binux/pyspider

http://docs.pyspider.org/en/latest/

Dashboard - pyspider

http://demo.pyspider.org/

ztest - Debugger - pyspider

http://demo.pyspider.org/debug/ztest

那个demo网站还可以直接在线保存自己创建编辑过的代码的

看了pyspider的源码web端是用tornado框架做的,使用 PhantomJS 渲染带 JS 的页面

首页 - Binuxの杂货铺

http://blog.binux.me/

这个是作者的中文博客,有中文的教程文章

=================================

先上直观的效果图:

下面是相关代码:

#!/usr/bin/env python

# -*- encoding: utf-8 -*-

# Created on 2015-07-01 11:04:40

# Project: ztest from pyspider.libs.base_handler import * import re class Handler(BaseHandler):

crawl_config = {

} @every(minutes=24 * 60)

def on_start(self):

self.crawl('http://www.duoniu.cn/club', callback=self.index_page) @config(age=10 * 24 * 60 * 60)

def index_page(self, response):

for each in response.doc('a[href^="http"]').items():

matchObj = re.match( r'(.*).html', each.attr.href, re.M|re.I)

if matchObj:

self.crawl(each.attr.href, callback=self.detail_page) @config(priority=2)

def detail_page(self, response):

return {

"url": response.url,

"title": response.doc('title').text(),

"http-equiv":response.doc('meta').attr('http-equiv'),

"keywords":response.doc('meta[name="keywords"]').attr('content'),

} ===========================================

{

"fetch": {},

"process": {

"callback": "index_page"

},

"project": "ztest",

"schedule": {

"age": 864000

},

"taskid": "0a7f73fcbef54f29761aeeff6cc2ab68",

"url": "http://www.duoniu.cn/club/"

}

=============================================

{

"fetch": {},

"process": {

"callback": "detail_page"

},

"project": "ztest",

"schedule": {

"priority": 2

},

"taskid": "56d325537a7d3ff4c55c3d642aee4eec",

"url": "http://www.duoniu.cn/club/7485.html"

}

================================================

{'http-equiv': 'Content-Type',

'keywords': u'多牛传记,大禹节水,冠昊生物,股票,模拟炒股,股评',

'title': u'多牛客服_乐者,为王——多牛网专访乐者为王 - 多牛网投资吧',

'url': 'http://www.duoniu.cn/club/7485.html'}

新增一个抓取政府新闻的代码:

#!/usr/bin/env python

# -*- encoding: utf-8 -*-

# Created on 2015-10-09 13:51:35

# Project: xinwen

#http://demo.pyspider.org/debug/xinwen from pyspider.libs.base_handler import * import re class Handler(BaseHandler):

crawl_config = {

} @every(minutes=24 * 60)

def on_start(self):

self.crawl('http://www.gov.cn/xinwen/', callback=self.index_page) @config(age=10 * 24 * 60 * 60)

def index_page(self, response):

for each in response.doc('a[href^="http"]').items():

matchObj = re.match( r'(.*).htm', each.attr.href, re.M|re.I)

if matchObj:

self.crawl(each.attr.href, callback=self.detail_page) @config(priority=2)

def detail_page(self, response):

return {

"url": response.url,

"title": response.doc('title').text(),

"http-equiv":response.doc('meta').attr('http-equiv'),

"keywords":response.doc('meta[name="keywords"]').attr('content'),

}

python3.4学习笔记(十三) 网络爬虫实例代码,使用pyspider抓取多牛投资吧里面的文章信息,抓取政府网新闻内容的更多相关文章

- python3.4学习笔记(十七) 网络爬虫使用Beautifulsoup4抓取内容

python3.4学习笔记(十七) 网络爬虫使用Beautifulsoup4抓取内容 Beautiful Soup 是用Python写的一个HTML/XML的解析器,它可以很好的处理不规范标记并生成剖 ...

- python3.4学习笔记(十四) 网络爬虫实例代码,抓取新浪爱彩双色球开奖数据实例

python3.4学习笔记(十四) 网络爬虫实例代码,抓取新浪爱彩双色球开奖数据实例 新浪爱彩双色球开奖数据URL:http://zst.aicai.com/ssq/openInfo/ 最终输出结果格 ...

- python3.4学习笔记(二十三) Python调用淘宝IP库获取IP归属地返回省市运营商实例代码

python3.4学习笔记(二十三) Python调用淘宝IP库获取IP归属地返回省市运营商实例代码 淘宝IP地址库 http://ip.taobao.com/目前提供的服务包括:1. 根据用户提供的 ...

- python3.4学习笔记(二十六) Python 输出json到文件,让json.dumps输出中文 实例代码

python3.4学习笔记(二十六) Python 输出json到文件,让json.dumps输出中文 实例代码 python的json.dumps方法默认会输出成这种格式"\u535a\u ...

- python3.4学习笔记(二十五) Python 调用mysql redis实例代码

python3.4学习笔记(二十五) Python 调用mysql redis实例代码 #coding: utf-8 __author__ = 'zdz8207' #python2.7 import ...

- python3.4学习笔记(十一) 列表、数组实例

python3.4学习笔记(十一) 列表.数组实例 #python列表,数组类型要相同,python不需要指定数据类型,可以把各种类型打包进去#python列表可以包含整数,浮点数,字符串,对象#创建 ...

- python3.4学习笔记(十) 常用操作符,条件分支和循环实例

python3.4学习笔记(十) 常用操作符,条件分支和循环实例 #Pyhon常用操作符 c = d = 10 d /= 8 #3.x真正的除法 print(d) #1.25 c //= 8 #用两个 ...

- java之jvm学习笔记十三(jvm基本结构)

java之jvm学习笔记十三(jvm基本结构) 这一节,主要来学习jvm的基本结构,也就是概述.说是概述,内容很多,而且概念量也很大,不过关于概念方面,你不用担心,我完全有信心,让概念在你的脑子里变成 ...

- python3.4学习笔记(二十四) Python pycharm window安装redis MySQL-python相关方法

python3.4学习笔记(二十四) Python pycharm window安装redis MySQL-python相关方法window安装redis,下载Redis的压缩包https://git ...

随机推荐

- Hibernate映射一对多双向关联关系及部门关联属性

一对多双向关联关系:(Dept/Emp的案例) 既可以根据在查找部门时根据部门去找该部门下的所有员工,又能在检索员工时获取某个员工所属的部门. 步骤如下: 1.构建实体类(部门实体类加set员工集合) ...

- tab左右箭头切换

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/ ...

- map的用法

Map是c++的一个标准容器,她提供了很好一对一的关系,在一些程序中建立一个map可以起到事半功倍的效果,总结了一些map基本简单实用的操作!1. map最基本的构造函数: map<stri ...

- 应该掌握的MySQL命令、MySQL语句

一.MySQL常用的命令: 1. 连接数据库:mysql>mysql -uroot -p回车,再输入密码 mysql -h 192.168.0.200 -P 3306 -u root -p2 ...

- 面向对象static静态的属性和方法的调用

<?php header("content-type:text/html;charset=utf-8"); class Human{ static public $name ...

- Chrome开发,debug的使用方法。

怎样打开Chrome的开发者工具? 你可以直接在页面上点击右键,然后选择审查元素: 或者在Chrome的工具中找到: 或者,你直接记住这个快捷方式: Ctrl+Shift+I (或者Ctrl+Shif ...

- html只允许输入的数据校验,只允许输入字母汉字数字等

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/ ...

- JavaScript入门篇 编程练习

编程挑战 一.定义"改变颜色"的函数 提示: obj.style.color obj.style.backgroundColor 二.定义"改变宽高"的函数 提 ...

- BizTalk开发系列(十三) Schema设计之值约束

XML Schema 的作用是定义 XML 文档的合法构建模块.在开发过程中有时需要对XML文档做精确的约束.以保证XMl数据的准确性. 今天我们以一个班级Sample来讲探讨一下如何在开发BizTa ...

- Unity学习疑问记录之时间变量

1.Time.deltaTime 以秒计算,完成最后一帧的时间 放在Update()函数中的代码是以帧来执行的.如果我们需要物体的移动以秒来执行.我们需要将物体移动的值乘以Time.deltaTime ...