Node.js爬虫-爬取慕课网课程信息

第一次学习Node.js爬虫,所以这时一个简单的爬虫,Node.js的好处就是可以并发的执行

这个爬虫主要就是获取慕课网的课程信息,并把获得的信息存储到一个文件中,其中要用到cheerio库,它可以让我们方便的操作HTML,就像是用jQ一样

开始前,记得

npm install cheerio

为了能够并发的进行爬取,用到了Promise对象

//接受一个url爬取整个网页,返回一个Promise对象

function getPageAsync(url){

return new Promise((resolve,reject)=>{

console.log(`正在爬取${url}的内容`);

http.get(url,function(res){

let html = ''; res.on('data',function(data){

html += data;

}); res.on('end',function(){

resolve(html);

}); res.on('error',function(err){

reject(err);

console.log('错误信息:' + err);

})

});

})

}

在慕课网中,每个课程都有一个ID,我们事先要把想要获取课程的ID写到一个数组中,而且每个课程的地址都是一个相同的地址加上ID,所以我们只要把地址和ID拼接起来就是课程的地址

const baseUrl = 'http://www.imooc.com/learn/';

const baseNuUrl = 'http://www.imooc.com/course/AjaxCourseMembers?ids=';

//获取课程的ID

const videosId = [773,371];

为了使获取每个课程内容时并发执行,要使用Promise中的all方法

Promise

//当所有网页的内容爬取完毕

.all(courseArray)

.then((pages)=>{

//所有页面需要的内容

let courseData = []; //遍历每个网页提取出所需要的内容

pages.forEach((html)=>{

let courses = filterChapter(html);

courseData.push(courses);

}); //给每个courseMenners.number赋值

for(let i=0;i<videosId.length;i++){

for(let j=0;j<videosId.length;j++){

if(courseMembers[i].id +'' == videosId[j]){

courseData[j].number = courseMembers[i].numbers;

}

}

} //对所需要的内容进行排序

courseData.sort((a,b)=>{

return a.number > b.number;

}); //在重新将爬取内容写入文件中前,清空文件

fs.writeFileSync(outputFile,'###爬取慕课网课程信息###',(err)=>{

if(err){

console.log(err)

}

});

printfData(courseData);

});

在then方法中,pages是每个课程的HTML页面,我们还得从中提取出我们需要的信息,需要使用下面的函数

//接受一个爬取下来的网页内容,查找网页中需要的信息

function filterChapter(html){

const $ = cheerio.load(html); //所有章

const chapters = $('.chapter'); //课程的标题和学习人数

let title = $('.hd>h2').text();

let number = 0; //最后返回的数据

//每个网页需要的内容的结构

let courseData = {

'title':title,

'number':number,

'videos':[]

}; chapters.each(function(item){

let chapter = $(this);

//文章标题

let chapterTitle = Trim(chapter.find('strong').text(),'g'); //每个章节的结构

let chapterdata = {

'chapterTitle':chapterTitle,

'video':[]

}; //一个网页中的所有视频

let videos = chapter.find('.video').children('li');

videos.each(function(item){

//视频标题

let videoTitle = Trim($(this).find('a.J-media-item').text(),'g');

//视频ID

let id = $(this).find('a').attr('href').split('video/')[1];

chapterdata.video.push({

'title':videoTitle,

'id':id

})

}); courseData.videos.push(chapterdata); }); return courseData;

}

注意:在上面中将课程的学习人数设置为了0是因为学习课程人数是用Ajax动态获取,所以我在后面写了方法专门获取学习课程人数,其中用到的Trim()方法是去除文本中的空格

获取学习课程的人数:

//获取上课人数

function getNumber(url){ let datas = ''; http.get(url,(res)=>{

res.on('data',(chunk)=>{

datas += chunk;

}); res.on('end',()=>{

datas = JSON.parse(datas);

courseMembers.push({'id':datas.data[0].id,'numbers':parseInt(datas.data[0].numbers,10)});

});

});

}

这样就将想获取课程的学习人数都添加到了courseMembers数组中,在最后将学习课程的人数在赋值给相对应的课程

//给每个courseMenners.number赋值

for(let i=0;i<videosId.length;i++){

for(let j=0;j<videosId.length;j++){

if(courseMembers[i].id +'' == videosId[j]){

courseData[j].number = courseMembers[i].numbers;

}

}

}

我们获取到了数据,就要把它按照一定的格式存到一个文件中

//写入文件

function writeFile(file,string) {

fs.appendFileSync(file,string,(err)=>{

if(err){

console.log(err);

}

})

} //打印信息

function printfData(coursesData){ coursesData.forEach((courseData)=>{

// console.log(`${courseData.number}人学习过${courseData.title}\n`);

writeFile(outputFile,`\n\n${courseData.number}人学习过${courseData.title}\n\n`); courseData.videos.forEach(function(item){

let chapterTitle = item.chapterTitle;

// console.log(chapterTitle + '\n');

writeFile(outputFile,`\n ${chapterTitle}\n`); item.video.forEach(function(item){

// console.log(' 【' + item.id + '】' + item.title + '\n');

writeFile(outputFile,` 【${item.id}】 ${item.title}\n`);

})

}); }); }

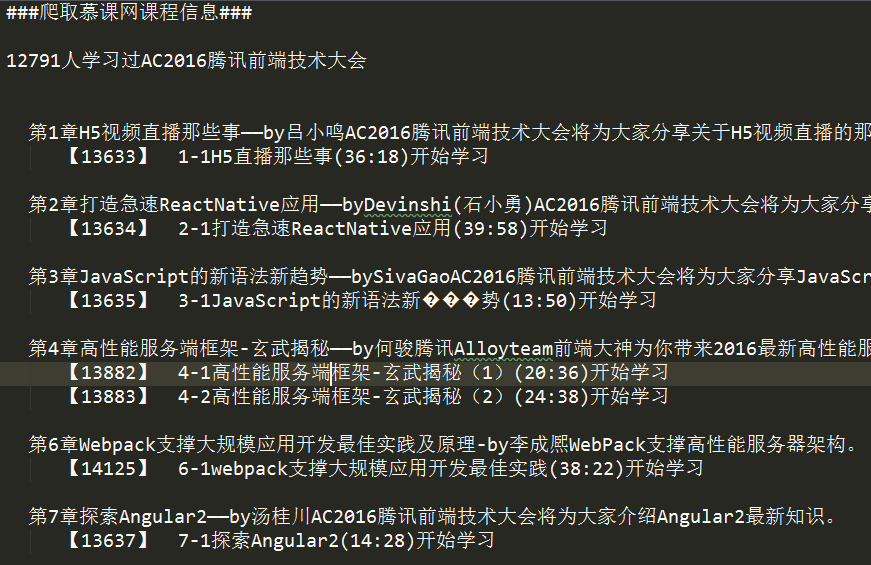

最后获取到的数据:

源码:

/**

* Created by hp-pc on 2017/6/7 0007.

*/

const http = require('http');

const fs = require('fs');

const cheerio = require('cheerio');

const baseUrl = 'http://www.imooc.com/learn/';

const baseNuUrl = 'http://www.imooc.com/course/AjaxCourseMembers?ids=';

//获取课程的ID

const videosId = [773,371];

//输出的文件

const outputFile = 'test.txt';

//记录学习课程的人数

let courseMembers = []; //去除字符串中的空格

function Trim(str,is_global)

{

let result;

result = str.replace(/(^\s+)|(\s+$)/g,"");

if(is_global.toLowerCase()=="g")

{

result = result.replace(/\s/g,"");

}

return result;

} //接受一个url爬取整个网页,返回一个Promise对象

function getPageAsync(url){

return new Promise((resolve,reject)=>{

console.log(`正在爬取${url}的内容`);

http.get(url,function(res){

let html = ''; res.on('data',function(data){

html += data;

}); res.on('end',function(){

resolve(html);

}); res.on('error',function(err){

reject(err);

console.log('错误信息:' + err);

})

});

})

} //接受一个爬取下来的网页内容,查找网页中需要的信息

function filterChapter(html){

const $ = cheerio.load(html); //所有章

const chapters = $('.chapter'); //课程的标题和学习人数

let title = $('.hd>h2').text();

let number = 0; //最后返回的数据

//每个网页需要的内容的结构

let courseData = {

'title':title,

'number':number,

'videos':[]

}; chapters.each(function(item){

let chapter = $(this);

//文章标题

let chapterTitle = Trim(chapter.find('strong').text(),'g'); //每个章节的结构

let chapterdata = {

'chapterTitle':chapterTitle,

'video':[]

}; //一个网页中的所有视频

let videos = chapter.find('.video').children('li');

videos.each(function(item){

//视频标题

let videoTitle = Trim($(this).find('a.J-media-item').text(),'g');

//视频ID

let id = $(this).find('a').attr('href').split('video/')[1];

chapterdata.video.push({

'title':videoTitle,

'id':id

})

}); courseData.videos.push(chapterdata); }); return courseData;

} //获取上课人数

function getNumber(url){ let datas = ''; http.get(url,(res)=>{

res.on('data',(chunk)=>{

datas += chunk;

}); res.on('end',()=>{

datas = JSON.parse(datas);

courseMembers.push({'id':datas.data[0].id,'numbers':parseInt(datas.data[0].numbers,10)});

});

});

} //写入文件

function writeFile(file,string) {

fs.appendFileSync(file,string,(err)=>{

if(err){

console.log(err);

}

})

} //打印信息

function printfData(coursesData){ coursesData.forEach((courseData)=>{

// console.log(`${courseData.number}人学习过${courseData.title}\n`);

writeFile(outputFile,`\n\n${courseData.number}人学习过${courseData.title}\n\n`); courseData.videos.forEach(function(item){

let chapterTitle = item.chapterTitle;

// console.log(chapterTitle + '\n');

writeFile(outputFile,`\n ${chapterTitle}\n`); item.video.forEach(function(item){

// console.log(' 【' + item.id + '】' + item.title + '\n');

writeFile(outputFile,` 【${item.id}】 ${item.title}\n`);

})

}); }); } //所有页面爬取完后返回的Promise数组

let courseArray = []; //循环所有的videosId,和baseUrl进行字符串拼接,爬取网页内容

videosId.forEach((id)=>{

//将爬取网页完毕后返回的Promise对象加入数组

courseArray.push(getPageAsync(baseUrl + id));

//获取学习的人数

getNumber(baseNuUrl + id);

}); Promise

//当所有网页的内容爬取完毕

.all(courseArray)

.then((pages)=>{

//所有页面需要的内容

let courseData = []; //遍历每个网页提取出所需要的内容

pages.forEach((html)=>{

let courses = filterChapter(html);

courseData.push(courses);

}); //给每个courseMenners.number赋值

for(let i=0;i<videosId.length;i++){

for(let j=0;j<videosId.length;j++){

if(courseMembers[i].id +'' == videosId[j]){

courseData[j].number = courseMembers[i].numbers;

}

}

} //对所需要的内容进行排序

courseData.sort((a,b)=>{

return a.number > b.number;

}); //在重新将爬取内容写入文件中前,清空文件

fs.writeFileSync(outputFile,'###爬取慕课网课程信息###',(err)=>{

if(err){

console.log(err)

}

});

printfData(courseData);

});

Node.js爬虫-爬取慕课网课程信息的更多相关文章

- 养只爬虫当宠物(Node.js爬虫爬取58同城租房信息)

先上一个源代码吧. https://github.com/answershuto/Rental 欢迎指导交流. 效果图 搭建Node.js环境及启动服务 安装node以及npm,用express模块启 ...

- Node.js 爬虫爬取电影信息

Node.js 爬虫爬取电影信息 我的CSDN地址:https://blog.csdn.net/weixin_45580251/article/details/107669713 爬取的是1905电影 ...

- Python爬虫之爬取慕课网课程评分

BS是什么? BeautifulSoup是一个基于标签的文本解析工具.可以根据标签提取想要的内容,很适合处理html和xml这类语言文本.如果你希望了解更多关于BS的介绍和用法,请看Beautiful ...

- python爬虫:爬取慕课网视频

前段时间安装了一个慕课网app,发现不用注册就可以在线看其中的视频,就有了想爬取其中的视频,用来在电脑上学习.决定花两天时间用学了一段时间的python做一做.(我的新书<Python爬虫开发与 ...

- 手把手教你用Node.js爬虫爬取网站数据

个人网站 https://iiter.cn 程序员导航站 开业啦,欢迎各位观众姥爷赏脸参观,如有意见或建议希望能够不吝赐教! 开始之前请先确保自己安装了Node.js环境,还没有安装的的童鞋请自行百度 ...

- node.js爬虫爬取拉勾网职位信息

简介 用node.js写了一个简单的小爬虫,用来爬取拉勾网上的招聘信息,共爬取了北京.上海.广州.深圳.杭州.西安.成都7个城市的数据,分别以前端.PHP.java.c++.python.Androi ...

- node js 爬虫爬取静态页面,

先打一个简单的通用框子 //根据爬取网页的协议 引入对应的协议, http||https var http = require('https'); //引入cheerio 简单点讲就是node中的jq ...

- node:爬虫爬取网页图片

代码地址如下:http://www.demodashi.com/demo/13845.html 前言 周末自己在家闲着没事,刷着微信,玩着手机,发现自己的微信头像该换了,就去网上找了一下头像,看着图片 ...

- Python爬虫项目--爬取自如网房源信息

本次爬取自如网房源信息所用到的知识点: 1. requests get请求 2. lxml解析html 3. Xpath 4. MongoDB存储 正文 1.分析目标站点 1. url: http:/ ...

随机推荐

- TCP/IP笔记(七)TCP详解

TCP的特点及其目的 为了通过数据包实现可靠性传输,需要考虑很多事情,例如数据的破坏.丢包.重复记忆分片顺序混乱等问题.如不能解决这些问题,也就无从谈起可靠传输. TCP通过检验和.序列号.确认应答. ...

- .NET插件技术-应用程序热升级

今天说一说.NET 中的插件技术,即 应用程序热升级.在很多情况下.我们希望用户对应用程序的升级是无感知的,并且尽可能不打断用户操作的. 虽然在Web 或者 WebAPI上,由于多点的存在可以逐个停用 ...

- 单片机下载芯片max232,ch340,pl2303,hl340与下载接线

开发板上的下载口位置一般都有很多 340,232等芯片,这些芯片都是干嘛用的呢? 普及:TTL电平 : 二进制电平,+5V等价于逻辑"1",0V等价于逻辑"0&qu ...

- Linux如何配置bond

Q:什么是BOND? A: 将多块网卡虚拟成为一块网卡的技术,通过bond技术让多块网卡看起来是一个单独的以太网接口设备并具有相同的ip地址. Q:为什么要配置bond? A: 在linux下配 ...

- Intellij IDEA注册server

版权声明:本文为博主原创文章,未经博主允许不得转载.转载请注明来源:http://blog.csdn.net/mingjie1212.欢迎交流学习!对于Intellij IDEA 2016.3.4 ...

- JS基础,你需要掌握的要点!

[循环控制语句]1.break:终止本层循环,继续执行循环后面的语句: 当循环有多层时,break只会跳过一层循环:2.continue:跳过本次循环,继续执行下一次循环: 对于for,continu ...

- cmd第一次推送github

echo off for %%i in ("%cd%") do set "name=%%~ni" git init git remote add origin ...

- 《JavaScript面向对象编程指南(第2版)》读书笔记(二)

<JavaScript面向对象编程指南(第2版)>读书笔记(一) <JavaScript面向对象编程指南(第2版)>读书笔记(二) 目录 一.基本类型 1.1 字符串 1.2 ...

- 使用CSS3中的input标签与lable标签组合实现banner图的切换

在做网页时,我们经常可以碰到banner图的切换.对于那些JS薄弱的同学来说,这就很尴尬了.今天,我来告诉大家如何使用CSS做出banner图切换的效果. 这里,用到了lable标签与input的组合 ...

- description方法的介绍及重写

Dog *d = [Dog new]; //查看对象地址 NSLog(@"\n d= %p ",d);//打印的为地址 例:0x1001002e0 //查看对象实例变量的值 NSL ...