Logstash+Kibana部署配置

Logstash是一个接收,处理,转发日志的工具。支持系统日志,webserver日志,错误日志,应用日志,总之包括所有可以抛出来的日志类型。

典型的使用场景下(ELK):

用Elasticsearch作为后台数据的存储,kibana用来前端的报表展示。Logstash在其过程中担任搬运工的角色,它为数据存储,报表查询和日志解析创建了一个功能强大的管道链。Logstash提供了多种多样的 input,filters,codecs和output组件,让使用者轻松实现强大的功能。

学习Logstash最好的资料就是官网,介绍三个学习地址:

1、ELK官网帮助文档

https://www.elastic.co/guide/en/logstash/5.1/plugins-outputs-stdout.html

2、Logstash匹配帮助文档

http://grokdebug.herokuapp.com/patterns#

3、Grok在线正则匹配

http://grokdebug.herokuapp.com/

4、国内grok在线正则匹配

http://grok.qiexun.net/

下面就正式开始主题~~

logstash部署配置

1、基础环境支持(JAVA)

yum -y install java-1.8*

java --version

2、下载解压logstash

logstash-5.0.1.tar.gz

tar -zxvf logstash-5.0.1.tar.gz

cd logstash-5.0.1

mkdir conf #创建conf文件夹存放配置文件

cd conf

3、配置文件

配置test文件(结合前面搭建好的ES集群测试)

[root@logstash1 conf]# cat test.conf

input {

stdin {

}

}

output {

elasticsearch {

hosts =>["172.16.81.133:9200","172.16.81.134:9200"]

index => "test-%{+YYYY.MM.dd}"

}

stdout {

codec => rubydebug

}

}

#检查配置文件语法

[root@logstash1 conf]# /opt/logstash-5.0.1/bin/logstash -f /opt/logstash-5.0.1/conf/test.conf --config.test_and_exit

Sending Logstash's logs to /opt/logstash-5.0.1/logs which is now configured via log4j2.properties

Configuration OK

[2017-12-26T11:42:12,816][INFO ][logstash.runner ] Using config.test_and_exit mode. Config Validati on Result: OK. Exiting Logstash

#执行命令

/opt/logstash-5.0.1/bin/logstash -f /opt/logstash-5.0.1/conf/test.conf

手动输入信息

2017.12.26 admin 172.16.81.82 200

结果:

{

"@timestamp" => 2017-12-26T03:45:48.926Z,

"@version" => "1",

"host" => "0.0.0.0",

"message" => "2017.12.26 admin 172.16.81.82 200",

"tags" => []

}

配置kafka集群的logstash配置文件

客户端logstash推送日志

#配置客户端logstash配置文件

[root@www conf]# cat nginx_kafka.conf

input {

file {

type => "access.log"

path => "/var/log/nginx/imlogin.log"

start_position => "beginning"

}

} output {

kafka {

bootstrap_servers => "172.16.81.131:9092,172.16.81.132:9092"

topic_id => 'summer'

}

}

配置服务端logstash过滤分割日志

[root@logstash1 conf]# cat kafka.conf

input {

kafka {

bootstrap_servers => "172.16.81.131:9092,172.16.81.132:9092"

group_id => "logstash"

topics => ["summer"]

consumer_threads => 50

decorate_events => true

}

} filter {

grok {

match => {

"message" => "%{NOTSPACE:accessip} \- \- \[%{HTTPDATE:time}\] %{NOTSPACE:auth} %{NOTSPACE:uri_stem} %{NOTSPACE:agent} %{WORD:status} %{NUMBER:bytes} %{NOTSPACE:request_url} %{NOTSPACE:browser} %{NOTSPACE:system} %{NOTSPACE:system_type} %{NOTSPACE:tag} %{NOTSPACE:system}"

}

}

date {

match => [ "accessip", "MMM dd YYYY HH:mm:ss" ]

}

} output {

elasticsearch {

hosts => ["172.16.81.133:9200","172.16.81.134:9200"]

index => "logstash-%{+YYYY.MM.dd}"

}

}

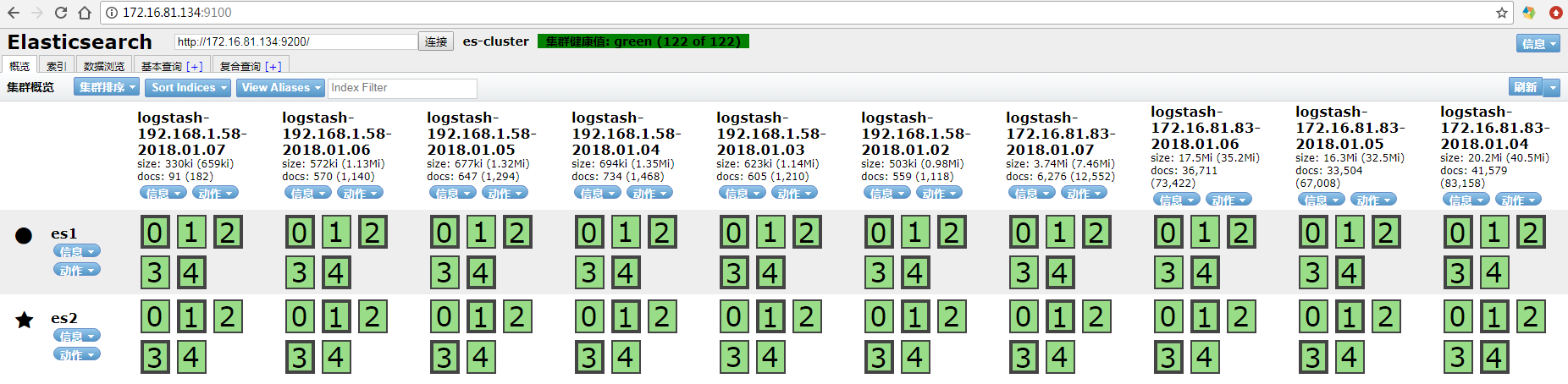

然后再es集群上观察消费情况

[root@es1 ~]# curl -XGET '172.16.81.134:9200/_cat/indices?v&pretty'

health status index uuid pri rep docs.count docs.deleted store.size pri.store.size

green open logstash-2017.12.29.03 waZfJChvSY2vcREQgyW7zA 5 1 1080175 0 622.2mb 311.1mb

green open logstash-2017.12.29.06 Zm5Jcb3DSK2Ws3D2rYdp2g 5 1 183 0 744.2kb 372.1kb

green open logstash-2017.12.29.04 NFimjo_sSnekHVoISp2DQg 5 1 1530 0 2.7mb 1.3mb

green open .kibana YN93vVWQTESA-cZycYHI6g 1 1 2 0 22.9kb 11.4kb

green open logstash-2017.12.29.05 kPQAlVkGQL-izw8tt2FRaQ 5 1 1289 0 2mb 1mb

配合ES集群的head插件使用!!观察日志生成情况!!

4、kibana安装部署

下载rpm包

kibana-5.0.1-x86_64.rpm

安装kibana软件

rpm -ivh kibana-5.0.1-x86_64.rpm

配置文件

[root@es1 opt]# cat /etc/kibana/kibana.yml | grep -v "^#" | grep -v "^$"

server.port: 5601

server.host: "172.16.81.133"

elasticsearch.url: "http://172.16.81.133:9200"

启动kibana

systemctl start kibana

systemctl enable kibana

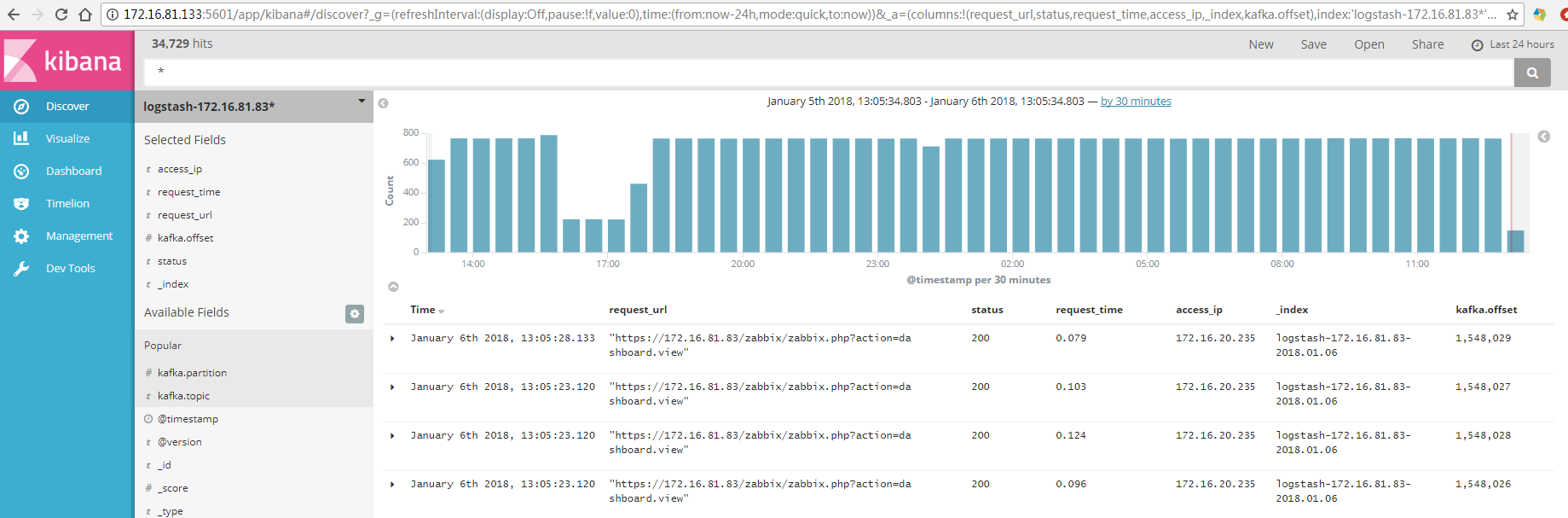

浏览器浏览

http://172.16.81.133:5601/

正常显示数据!!

有问题请指出!出现了很多IP地址不知道可以查看前面几篇!

Logstash+Kibana部署配置的更多相关文章

- elasticsearch+logstash+kibana部署

这篇博客讲的是elasticsearch+logstash+kibana部署的方法. 内容大纲: 1.elasticsearch+logstash+kibana部署 2.收集Tomcat日志 3.收集 ...

- ELK (Elasticsearch+Logstash+Kibana)部署

部署机器: 服务端:dev-server X.X.X.X ( logstash-1.5.4,elasticsearch-1.7.1,kibana-4.1.1 ) 客户端:dev-cli ...

- ELK(ElasticSearch+Logstash+Kibana)配置中的一些坑基于7.6版本

三个组件都是采用Docker镜像安装,过程简单不做赘述,直接使用Docker官方镜像运行容器即可,注意三个组件版本必须一致. 运行容器时最好将三个组件的核心配置文件与主机做映射,方便直接在主机修改不用 ...

- ELK( ElasticSearch+ Logstash+ Kibana)分布式日志系统部署文档

开始在公司实施的小应用,慢慢完善之~~~~~~~~文档制作 了好作运维同事之间的前期普及.. ~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~ 软件下载地址: https://www.e ...

- ELK6.0部署:Elasticsearch+Logstash+Kibana搭建分布式日志平台

一.前言 1.ELK简介 ELK是Elasticsearch+Logstash+Kibana的简称 ElasticSearch是一个基于Lucene的分布式全文搜索引擎,提供 RESTful API进 ...

- ELk(Elasticsearch, Logstash, Kibana)的安装配置

目录 ELk(Elasticsearch, Logstash, Kibana)的安装配置 1. Elasticsearch的安装-官网 2. Kibana的安装配置-官网 3. Logstash的安装 ...

- Elasticsearch + logstash + kibana 配置

Elasticsearch 配置 Elasticsearch不仅仅是Lucene和全文搜索,我们还能这样去描述它: 分布式的实时文件存储,每个字段都被索引并可被搜索 分布式的实时分析搜索引擎 可以扩展 ...

- ELK日志系统:Elasticsearch + Logstash + Kibana 搭建教程

环境:OS X 10.10.5 + JDK 1.8 步骤: 一.下载ELK的三大组件 Elasticsearch下载地址: https://www.elastic.co/downloads/elast ...

- 【转】ELK(ElasticSearch, Logstash, Kibana)搭建实时日志分析平台

[转自]https://my.oschina.net/itblog/blog/547250 摘要: 前段时间研究的Log4j+Kafka中,有人建议把Kafka收集到的日志存放于ES(ElasticS ...

随机推荐

- C#中MessageBox用法大全(附效果图)

1.最简单的,只显示提示信息 2. 可以给消息框加上标题. 3. "确定"和"取消" 4. 给MessageBox加上一个Icon,.net提供常见的Icon共 ...

- Java 银行家算法

实验存档,代码特别烂.. 测试.java package operating.test; import operating.entity.bank.Bank; import operating.ent ...

- Selinux安全机制

1.Selinux安全机制简介 Selinux是Google在Android 4.4上正式推出的一套以SELinux为基础于核心的系统安全机制.而SELinux则是由美国NSA(国安局)和一些公司(R ...

- lesson - 5 Linux用户和组管理

1. /etc/passwd由 : 分隔成7个字段(1) 用户名 规则:大小写字母.数字.减号(不能出现在首位).点以及下划线,其他字符不合法 (2) x 放密码,安全起见放到 /etc/shadow ...

- Java <clinit> & <init>

在编译生成class文件时,会自动产生两个方法,一个是类的初始化方法<clinit>, 另一个是实例的初始化方法<init>. <clinit>:在jvm第 ...

- 在win7下用net命令无法实现对用户的创建(未完成)

============================================================================================= 201307 ...

- 【开源】AspnetCore 2.0 自动API文档生成组件,支持protobuffer

本文地址 http://www.cnblogs.com/likeli/p/8204054.html 关于 API文档自动生成,用于对APP端的开发帮助文档生成,默认ProtoBuffer传输格式. 本 ...

- 房上的猫:经典排序算法 - 冒泡排序Bubble sort

原理是临近的数字两两进行比较,按照从小到大或者从大到小的顺序进行交换,这样一趟过去后,最大或最小的数字被交换到了最后一位,然后再从头开始进行两两比较交换,直到倒数第二位时结束,以此类推例子为从小到大排 ...

- PHP字符串处理与正则表达式

字符串 1. PHP中的字符串是一种基本数据类型,PHP对unicode没有本地支持. 2. 字符串可以可以通过花括号来访问每一个字符,并且每个花括号只能存放一个字符: $str = 'abc ...

- 关于t00ls的挂机脚本

0x00 前言 今天早上发现t00ls上有人发了个挂机脚本,二十四小时刷时间以及刷Tubi. 轻轻松松升级,坐收Tubi成富翁. 代码很简单,就是带上cookie每隔一段时间(比如60秒)去请求一下某 ...