Hadoop(16)-MapReduce框架原理-自定义FileInputFormat

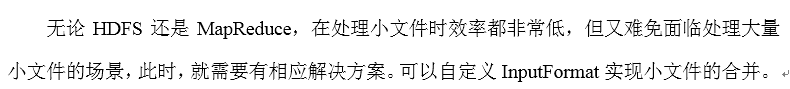

1. 需求

将多个小文件合并成一个SequenceFile文件(SequenceFile文件是Hadoop用来存储二进制形式的key-value对的文件格式),SequenceFile里面存储着多个文件,存储的形式为文件路径+名称为key,文件内容为value

三个小文件

one.txt

yongpeng weidong weinan

sanfeng luozong xiaoming

two.txt

shuaige changmo zhenqiang

dongli lingu xuanxuan

three.txt

longlong fanfan

mazong kailun yuhang yixin

longlong fanfan

mazong kailun yuhang yixin

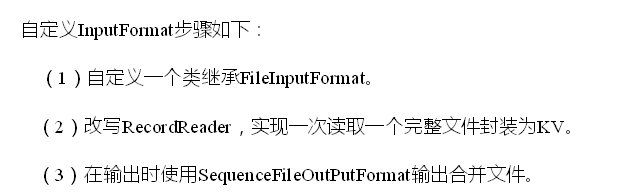

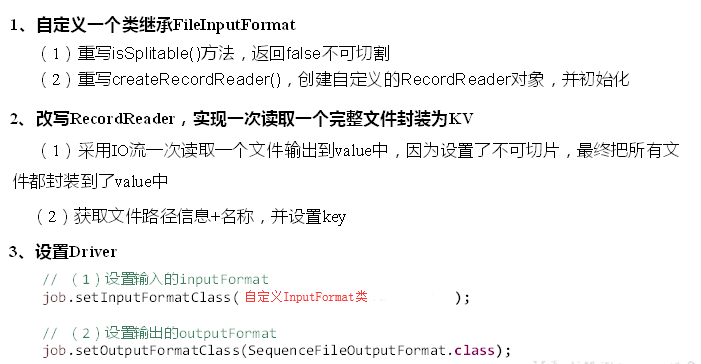

2. 需求分析

3.案例代码

1) 自定义RecordReader

package com.nty.inputformat; import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.BytesWritable;

import org.apache.hadoop.io.IOUtils;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.InputSplit;

import org.apache.hadoop.mapreduce.RecordReader;

import org.apache.hadoop.mapreduce.TaskAttemptContext;

import org.apache.hadoop.mapreduce.lib.input.FileSplit; import java.io.IOException; /**

* author nty

* date time 2018-12-11 9:10

*/

public class CustomRecordReader extends RecordReader<Text, BytesWritable> { /**

* 由于采用了FileInputFormat的输入方式,所以输入源3个文件,会分成三个切片,所以一个RecordReader只处理一个文件,一次读完

*/ //标记文件是否被读过,true表示没被读过

private boolean flag = true; private Text key = new Text();

private BytesWritable value = new BytesWritable(); //输入流

FSDataInputStream fis; private FileSplit fs; /**

* 初始化方法,只调用一次

* @param split

* @param context

* @throws IOException

* @throws InterruptedException

*/

public void initialize(InputSplit split, TaskAttemptContext context) throws IOException, InterruptedException {

//FileSplit是InputSplit的子类

fs = (FileSplit) split; //获取文件路径

Path path = fs.getPath(); //获取文件系统

FileSystem fileSystem = FileSystem.get(context.getConfiguration());

//FileSystem fileSystem = path.getFileSystem(context.getConfiguration()); //开流

fis = fileSystem.open(path);

} /**

* 读取下一组KV

* @return 读到了返回true,反之返回false

* @throws IOException

* @throws InterruptedException

*/

public boolean nextKeyValue() throws IOException, InterruptedException {

if(flag){

//读取文件进入key和value

String path = fs.getPath().toString();

key.set(path); //文件是一次性读完,bytes的长度不能为普遍的1024,当然这么写会涉及到大文件的问题,不做讨论.

byte[] bytes = new byte[(int) fs.getLength()];

fis.read(bytes);

value.set(bytes,0,bytes.length); //重新标记

flag = false; return true;

}

return false;

} /**

* 获取当前读到的key

* @return

* @throws IOException

* @throws InterruptedException

*/

public Text getCurrentKey() throws IOException, InterruptedException {

return this.key;

} /**

* 获取当前读到的value

* @return

* @throws IOException

* @throws InterruptedException

*/

public BytesWritable getCurrentValue() throws IOException, InterruptedException {

return this.value;

} /**

* 获取当前读取的进度

* @return

* @throws IOException

* @throws InterruptedException

*/

public float getProgress() throws IOException, InterruptedException {

//文件一次读完,只有0和1的进度,根据flag来判断

return flag ? 0f : 1f;

} /**

* 关闭资源

* @throws IOException

*/

public void close() throws IOException {

IOUtils.closeStream(fis);

}

}

2) 自定义Inputformat

package com.nty.inputformat; import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.BytesWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.InputSplit;

import org.apache.hadoop.mapreduce.JobContext;

import org.apache.hadoop.mapreduce.RecordReader;

import org.apache.hadoop.mapreduce.TaskAttemptContext;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat; import java.io.IOException; /**

* author nty

* date time 2018-12-11 9:09

*/

//需求中,key为文件路径+名称,所以key类型为Text,value为文件内容,用BytesWritable

public class CustomInputFormat extends FileInputFormat<Text, BytesWritable> { //最后输出的value为一个文件,所让文件不能被切分,返回false

@Override

protected boolean isSplitable(JobContext context, Path filename) {

return false;

} //返回自定义的 RecordReader

public RecordReader<Text, BytesWritable> createRecordReader(InputSplit split, TaskAttemptContext context) throws IOException, InterruptedException {

return new CustomRecordReader();

}

}

3) 编写Mapper类

package com.nty.inputformat; import org.apache.hadoop.io.BytesWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper; import java.io.IOException; /**

* author nty

* date time 2018-12-11 9:10

*/

public class CustomMapper extends Mapper<Text, BytesWritable, Text, BytesWritable> {

@Override

protected void map(Text key, BytesWritable value, Context context) throws IOException, InterruptedException {

context.write(key,value);

}

}

4) 编写Reducer类

package com.nty.inputformat; import org.apache.hadoop.io.BytesWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer; import java.io.IOException; /**

* author nty

* date time 2018-12-11 9:10

*/

public class CustomReducer extends Reducer<Text, BytesWritable, Text, BytesWritable> {

@Override

protected void reduce(Text key, Iterable<BytesWritable> values, Context context) throws IOException, InterruptedException {

for (BytesWritable value : values) {

context.write(key, value);

}

}

}

5) 编写Driver类

package com.nty.inputformat; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.BytesWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import org.apache.hadoop.mapreduce.lib.output.SequenceFileOutputFormat; /**

* author nty

* date time 2018-12-11 9:10

*/

public class CustomDriver { public static void main(String[] args) throws Exception{

//获取job

Configuration configuration = new Configuration();

Job job = Job.getInstance(configuration); //设置类

job.setJarByClass(CustomDriver.class);

//设置input和output

job.setInputFormatClass(CustomInputFormat.class);

job.setOutputFormatClass(SequenceFileOutputFormat.class); //设置Mapper和Reducer

job.setMapperClass(CustomMapper.class);

job.setReducerClass(CustomReducer.class); //设置Mapper和Reducer的输入输出

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(BytesWritable.class); job.setOutputKeyClass(Text.class);

job.setOutputValueClass(BytesWritable.class); //设置文件路径

FileInputFormat.setInputPaths(job, new Path("d:\\Hadoop_test"));

FileOutputFormat.setOutputPath(job, new Path("d:\\Hadoop_test_out"));

//提交

boolean b = job.waitForCompletion(true); System.exit(b ? 0 : 1); }

}

Hadoop(16)-MapReduce框架原理-自定义FileInputFormat的更多相关文章

- Hadoop(18)-MapReduce框架原理-WritableComparable排序和GroupingComparator分组

1.排序概述 2.排序分类 3.WritableComparable案例 这个文件,是大数据-Hadoop生态(12)-Hadoop序列化和源码追踪的输出文件,可以看到,文件根据key,也就是手机号进 ...

- Hadoop(12)-MapReduce框架原理-Hadoop序列化和源码追踪

1.什么是序列化 2.为什么要序列化 3.为什么不用Java的序列化 4.自定义bean对象实现序列化接口(Writable) 在企业开发中往往常用的基本序列化类型不能满足所有需求,比如在Hadoop ...

- Hadoop(20)-MapReduce框架原理-OutputFormat

1.outputFormat接口实现类 2.自定义outputFormat 步骤: 1). 定义一个类继承FileOutputFormat 2). 定义一个类继承RecordWrite,重写write ...

- Hadoop(15)-MapReduce框架原理-FileInputFormat的实现类

1. TextInputFormat 2.KeyValueTextInputFormat 3. NLineInputFormat

- Hadoop(17)-MapReduce框架原理-MapReduce流程,Shuffle机制,Partition分区

MapReduce工作流程 1.准备待处理文件 2.job提交前生成一个处理规划 3.将切片信息job.split,配置信息job.xml和我们自己写的jar包交给yarn 4.yarn根据切片规划计 ...

- Hadoop(13)-MapReduce框架原理--Job提交源码和切片源码解析

1.MapReduce的数据流 1) Input -> Mapper阶段 这一阶段的主要分工就是将文件切片和把文件转成K,V对 输入源是一个文件,经过InputFormat之后,到了Mapper ...

- Hadoop(19)-MapReduce框架原理-Combiner合并

1. Combiner概述 2. 自定义Combiner实现步骤 1). 定义一个Combiner继承Reducer,重写reduce方法 public class WordcountCombiner ...

- Hadoop(14)-MapReduce框架原理-切片机制

1.FileInputFormat切片机制 切片机制 比如一个文件夹下有5个小文件,切片时会切5个片,而不是一个片 案例分析 2.FileInputFormat切片大小的参数配置 源码中计算切片大小的 ...

- 【Hadoop】MapReduce自定义分区Partition输出各运营商的手机号码

MapReduce和自定义Partition MobileDriver主类 package Partition; import org.apache.hadoop.io.NullWritable; i ...

随机推荐

- 计算机二进制表示、cpu架构(x86_64)、cpu频率、核心、主板

计算机二进制表示 色彩二进制表示: 红色 255,0,0绿色 0,255,0蓝色 0,0,255 文字二进制表示:A 65a 97 cpu架构 cpu架构有精简指令集和复杂指令集两种精简指令集cpu有 ...

- 二、ionic如何使用外链

1.ionic如何使用外链并返回原有页面? html如下: 对应的controller如下: (function() { angular.module('app').controller('extra ...

- 5.FileWriter 和 BufferWriter

FileWriter 和 BufferWriter的使用场景 IO这块,各种Writer,Reader,让人眼晕 而在网上基本找不到在什么时候用哪个类,并且网上的IO demo 很多用法都是错的 在 ...

- SQL Server ->> 存储过程sp_describe_first_result_set解析T-SQL语句的结果集结构信息

返回 Transact-SQL 批处理的第一个可能结果集的元数据. 如果批处理没有返回结果,则返回一个空的结果集. 如果数据库引擎无法确定将通过执行静态分析来执行的第一个查询的元数据,则引发错误. E ...

- Java 两个日期间的天数计算

在Java中计算两个日期间的天数,大致有2种方法:一是使用原生JDK进行计算,在JDK8中提供了更为直接和完善的方法:二是使用第三方库. 1.使用原生的JDK private static long ...

- 我用的是python2,以后加python3的内容

可能有的不成功,比如print 'abc',这时候确定下python版本,3的方式是print('abc')

- Linux 系统其他重要文件

其他重要目录 /usr /usr/local 通过源码安装,没有特别指定,就在这个文件下用户自编译软件存放地方 /usr/src 源代码程序 + 内核源代码程序存放目录 /var /var/log/m ...

- Windows下使用Git Bash上传项目到GitHub

http://blog.csdn.net/qq_28304687/article/details/69959238?locationNum=8&fps=1

- 反射工具类.提供调用getter/setter方法, 访问私有变量, 调用私有方法, 获取泛型类型Class,被AOP过的真实类等工具函数.java

import org.apache.commons.lang3.StringUtils; import org.apache.commons.lang3.Validate; import org.ap ...

- Ubuntu 14.04安装QQ2012

GTkqq ,pidginQQ........等多多少少都存在一定的缺陷和问题. linuxQQ 有各种版本,这里介绍两种:linuxQQ(基本已不支持) 和 wineQQ (推荐使用) 1 ---- ...