Kafka和Stream架构的使用

Kafka的单节点运行

启动服务

Kafka 使用 ZooKeeper 如果你还没有 ZooKeeper 服务器,你需要先启动一个 ZooKeeper 服务器。 您可以通过与 kafka 打包在一起的便捷脚本来快速简单地创建一个单节点 ZooKeeper 实例。如果你有使用docker 的经验,你可以使用 docker-compose 快速搭建一个 zk 集群。

bin/zookeeper-server-start.shconfig/zookeeper.properties

现在启动 Kafka 服务器:

> bin/kafka-server-start.sh config/server.properties

创建一个topic

创建一个名为“test”的 topic,它有一个分区和一个副本:

bin/kafka-topics.sh --create --zookeeper localhost:2181 --replication-factor 1 --partitions 1 --topic test

运行 list(列表)命令来查看这个 topic:

bin/kafka-topics.sh --list --zookeeper localhost:2181 test

查询topic内容:

bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic topicName --from-beginning

除了手工创建 topic 外,你也可以配置你的 broker,当发布一个不存在的 topic 时自动创建 topic。

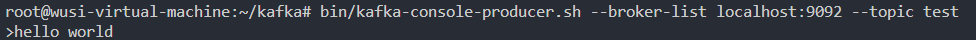

开启生产者 发送消息

Kafka 自带一个命令行客户端,它从文件或标准输入中获取输入,并将其作为 message(消息)发送到Kafka 集群。默认情况下,每行将作为单独的 message 发送。

运行 producer,然后在控制台输入一些消息以发送到服务器。

生产者不依赖zookeeper,都会发送给leader

bin/kafka-console-producer.sh --broker-list localhost:9092 --topic test

启动消费者

Kafka 还有一个命令行使用者,它会将消息转储到标准输出。

bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic test --from-beginning

如果在不同的终端中运行上述命令,能够在生产者终端中键入消息并看到它们出现在消费者终端中。

所有命令行工具都有选项; 运行不带参数的命令将显示使用信息

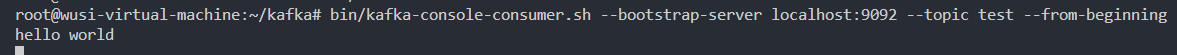

查看Topic信息

运行命令“describe topics” 查看集群中的 topic 信息

只有一个分区一个副本,Partition在broker0里面,后面的0都是borkerID

- “leader”是负责给定分区所有读写操作的节点。每个节点都是随机选择的部分分区的领导者。

- “replicas”是复制分区日志的节点列表,不管这些节点是 leader 还是仅仅活着。

- “isr”是一组“同步”replicas,是 replicas 列表的子集,它活着并被指到 leader。

Kafka Stream

Stream例子

Kafka Streams 是一个客户端库,用于构建任务关键型实时应用程序和微服务,其中输入和/或输出数据存储在 Kafka 集群中。Kafka Streams 结合了在客户端编写和部署标准 Java 和 Scala 应用程序的简单性以及 Kafka 服务器端集群技术的优势,使这些应用程序具有高度可扩展性,弹性,容错性,分布式等等。

以下是WordCountDemo示例代码的要点(为了方便阅读,使用的是 java8 lambda 表达式)。

启动 zk 和 kafka

bin/zookeeper-server-start.sh config/zookeeper.properties

bin/kafka-server-start.sh config/server.properties

准备输入主题并启动生产者

创建名为 streams-plaintext-input 的输入主题和名为 streams-wordcount-output 的输出主题:

> bin/kafka-topics.sh --create \

--zookeeper localhost:2181 \

--replication-factor 1 \

--partitions 1 \

--topic streams-plaintext-input

Created topic "streams-plaintext-input".

注意:我们创建输出主题并启用压缩,因为输出流是更改日志流

> bin/kafka-topics.sh --create \

--zookeeper localhost:2181 \

--replication-factor 1 \

--partitions 1 \

--topic streams-wordcount-output \

--config cleanup.policy=compact

Created topic "streams-wordcount-output".

使用相同的 kafka-topics 工具描述创建的主题:

bin/kafka-topics.sh --zookeeper localhost:2181 --describe

启动 Wordcount 应用程序

bin/kafka-run-class.sh org.apache.kafka.streams.examples.wordcount.WordCountDemo

演示应用程序将从输入主题 stream-plaintext-input 读取,对每个读取消息执行 WordCount 算法的计算,并将其当前结果连续写入输出主题 streams-wordcount-output。

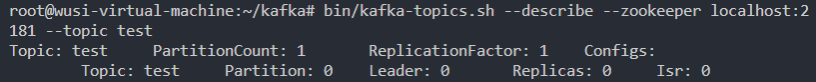

处理数据

开启一个生产者终端:

bin/kafka-console-producer.sh --broker-list localhost:9092 --topic streams-plaintext-input

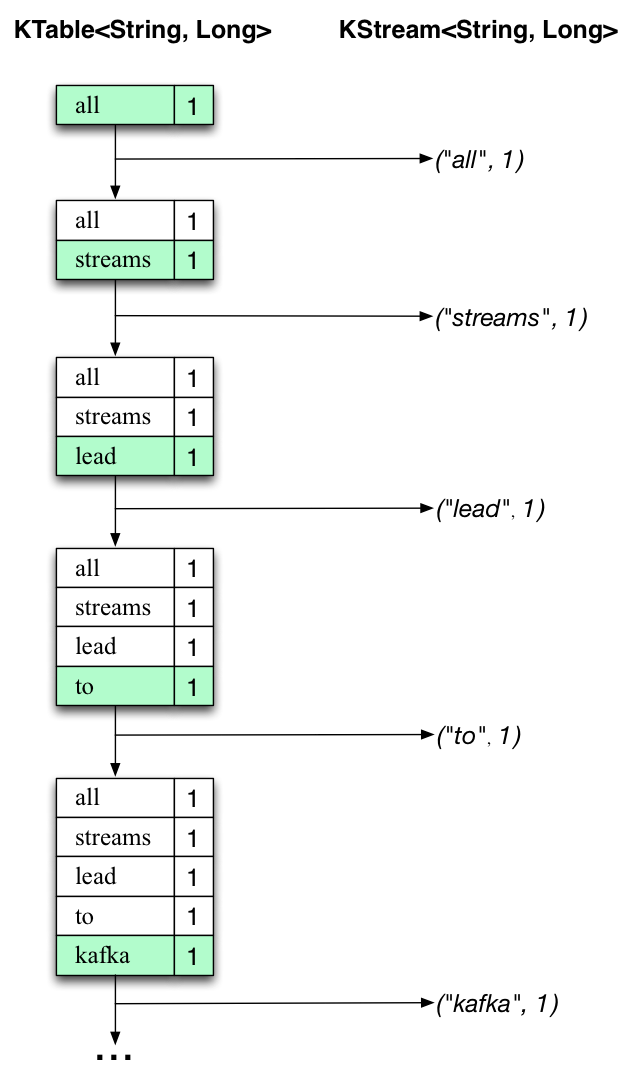

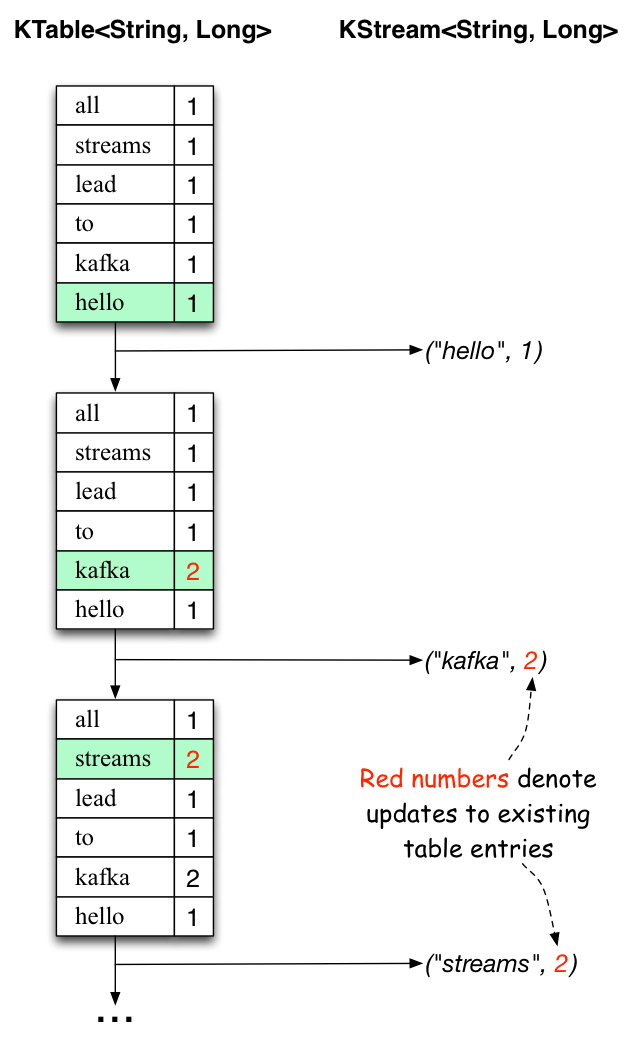

all streams lead to kafka

开启一个消费者终端:

bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 \

--topic streams-wordcount-output \

--from-beginning \

--formatter kafka.tools.DefaultMessageFormatter \

--property print.key=true \

--property print.value=true \

--property key.deserializer=org.apache.kafka.common.serialization.StringDeserializer \

--property value.deserializer=org.apache.kafka.common.serialization.LongDeserializer

这里,第一列是 java.lang.String 格式的 Kafka 消息键,表示正在计数的单词,第二列是 java.lang.Long

格式的消息值,表示单词的最新计数。

package com.study.kafka.stream.wordcount;

import org.apache.kafka.streams.StreamsConfig;

import org.apache.kafka.clients.consumer.ConsumerConfig;

import org.apache.kafka.common.serialization.Serdes;

import org.apache.kafka.streams.KafkaStreams;

import org.apache.kafka.streams.StreamsBuilder;

import org.apache.kafka.streams.StreamsConfig;

import org.apache.kafka.streams.kstream.KStream;

import org.apache.kafka.streams.kstream.KTable;

import org.apache.kafka.streams.kstream.Produced;

import java.util.Arrays;

import java.util.Locale;

import java.util.Properties;

import java.util.concurrent.CountDownLatch;

/**

* Demonstrates, using the high-level KStream DSL, how to implement the WordCount program

* that computes a simple word occurrence histogram from an input text.

* <p>

* In this example, the input stream reads from a topic named "streams-plaintext-input", where the values of messages

* represent lines of text; and the histogram output is written to topic "streams-wordcount-output" where each record

* is an updated count of a single word.

* <p>

* Before running this example you must create the input topic and the output topic (e.g. via

* {@code bin/kafka-topics.sh --create ...}), and write some data to the input topic (e.g. via

* {@code bin/kafka-console-producer.sh}). Otherwise you won't see any data arriving in the output topic.

*/

public final class WordCountDemo {

public static void main(final String[] args) {

final Properties props = new Properties();

props.put(StreamsConfig.APPLICATION_ID_CONFIG, "streams-wordcount");

props.put(StreamsConfig.BOOTSTRAP_SERVERS_CONFIG, "192.168.100.249:9092");

props.put(StreamsConfig.CACHE_MAX_BYTES_BUFFERING_CONFIG, 0);

props.put(StreamsConfig.DEFAULT_KEY_SERDE_CLASS_CONFIG, Serdes.String().getClass().getName());

props.put(StreamsConfig.DEFAULT_VALUE_SERDE_CLASS_CONFIG, Serdes.String().getClass().getName());

// setting offset reset to earliest so that we can re-run the demo code with the same pre-loaded data

// Note: To re-run the demo, you need to use the offset reset tool:

// https://cwiki.apache.org/confluence/display/KAFKA/Kafka+Streams+Application+Reset+Tool

props.put(ConsumerConfig.AUTO_OFFSET_RESET_CONFIG, "earliest");

final StreamsBuilder builder = new StreamsBuilder();

final KStream<String, String> source = builder.stream("streams-plaintext-input");

final KTable<String, Long> counts = source

.flatMapValues(value -> Arrays.asList(value.toLowerCase(Locale.getDefault()).split(" ")))

.groupBy((key, value) -> value)

.count();

// need to override value serde to Long type

counts.toStream().to("streams-wordcount-output", Produced.with(Serdes.String(), Serdes.Long()));

final KafkaStreams streams = new KafkaStreams(builder.build(), props);

final CountDownLatch latch = new CountDownLatch(1);

// attach shutdown handler to catch control-c

Runtime.getRuntime().addShutdownHook(new Thread("streams-wordcount-shutdown-hook") {

@Override

public void run() {

streams.close();

latch.countDown();

}

});

try {

streams.start();

latch.await();

} catch (final Throwable e) {

System.exit(1);

}

System.exit(0);

}

}

Kafka和Stream架构的使用的更多相关文章

- Kafka设计解析(一)Kafka背景及架构介绍

转载自 技术世界,原文链接 Kafka设计解析(一)- Kafka背景及架构介绍 本文介绍了Kafka的创建背景,设计目标,使用消息系统的优势以及目前流行的消息系统对比.并介绍了Kafka的架构,Pr ...

- Kafka剖析:Kafka背景及架构介绍

<Kafka剖析:Kafka背景及架构介绍> <Kafka设计解析:Kafka High Availability(上)> <Kafka设计解析:Kafka High A ...

- 1.1 Introduction中 Kafka for Stream Processing官网剖析(博主推荐)

不多说,直接上干货! 一切来源于官网 http://kafka.apache.org/documentation/ Kafka for Stream Processing kafka的流处理 It i ...

- 【原创】阿里三面:搞透Kafka的存储架构,看这篇就够了

阅读本文大约需要30分钟.这篇文章干货很多,希望你可以耐心读完. 你好, 我是华仔,在这个 1024 程序员特殊的节日里,又和大家见面了. 从这篇文章开始,我将对 Kafka 专项知识进行深度剖析, ...

- Kafka设计解析(一)- Kafka背景及架构介绍

本文转发自Jason’s Blog,原文链接 http://www.jasongj.com/2015/01/02/Kafka深度解析 背景介绍 Kafka简介 Kafka是一种分布式的,基于发布/订阅 ...

- Kafka剖析(一):Kafka背景及架构介绍

http://www.infoq.com/cn/articles/kafka-analysis-part-1/ Kafka是由LinkedIn开发的一个分布式的消息系统,使用Scala编写,它以可水平 ...

- [Big Data - Kafka] Kafka剖析(一):Kafka背景及架构介绍

Kafka是由LinkedIn开发的一个分布式的消息系统,使用Scala编写,它以可水平扩展和高吞吐率而被广泛使用.目前越来越多的开源分布式处理系统如Cloudera.Apache Storm.Spa ...

- Kafka学习笔记之Kafka背景及架构介绍

0x00 概述 本文介绍了Kafka的创建背景,设计目标,使用消息系统的优势以及目前流行的消息系统对比.并介绍了Kafka的架构,Producer消息路由,Consumer Group以及由其实现的不 ...

- kafka原理和架构

转载自: https://blog.csdn.net/lp284558195/article/details/80297208 参考: https://blog.csdn.net/qq_2059 ...

随机推荐

- 【PY从0到1】 一文掌握Pandas量化进阶

# 一文掌握Pandas量化进阶 # 这节课学习Pandas更深的内容. # 导入库: import numpy as np import pandas as pd # 制作DataFrame np. ...

- 你真的了解URLEncode吗?

使用浏览器进行Http网络请求时,若请求query中包含中文,中文会被编码为 %+16进制+16进制形式,但你真的深入了解过,为什么要进行这种转义编码吗?编码的原理又是什么? 例如,浏览器中进行百度搜 ...

- Django Admin 图片路径设置显示为图片(imageField显示方法设置)

一 使用环境 开发系统: windows IDE: pycharm 数据库: msyql,navicat 编程语言: python3.7 (Windows x86-64 executable in ...

- ProBuilder快速原型开发技术 ---不规则模型与材质

ProBuilder开发模型的强大之处,还在于可以按照要求精确定制不规则模型.克隆镜像模型.给模型着色以及添加材质等,下面笔者就这几方面进行讲解. 一:定制不规则模型 PB有一个专门定制不规则模型的功 ...

- mysql启动报错1067进程意外终止

查找了网上的很多种方法都没用,最终找到了我的mysql的安装路径,删除了my.ini配置文件,再重新启动就成功了!

- MySQL使用入门--初识数据库

MySQL使用入门 数据库概述 数据库是存放数据的仓库.在应用的开发中总是离不开数据的查询.处理.存储,例如图书管理系统就需要操纵和存储大量的数据.没有数据库之前我们使用文件存储数据,但是文件存储有很 ...

- Fedora一键安装NVIDIA显卡驱动Fedora28+

这是一篇以前写的文章,写在CSDN的,现在不想使用CSDN了,就把笔记写在了博客源,后续考虑建立自己的博客,每一个CRUD程序员都想建立自己的博客吧,我猜是的 进入正题 rpm fusion源包含Nv ...

- CVE-2017-12149-JBoss 5.x/6.x 反序列化

漏洞分析 https://www.freebuf.com/vuls/165060.html 漏洞原理 该漏洞位于JBoss的HttpInvoker组件中的 ReadOnlyAccessFilter 过 ...

- C# 应用 - 使用 HttpClient 发起上传文件、下载文件请求

1. 示例代码 using System; using System.IO; using System.Net.Http; /// <summary> /// 下载文件 /// </ ...

- 去哪找Java练手项目?

经常有读者在微信上问我: 在学编程的过程中,看了不少书.视频课程,但是看完.听完之后感觉还是不会编程,想找一些项目来练手,但是不知道去哪儿找? 类似的问题,有不少读者问,估计是大部分人的困惑. 练手项 ...