正则表达式_爬取豆瓣电影排行Top250

前言:

利用简单的正则表达式,获取响应内容爬取数据。

Part1 正则表达式(Regular Expression)

1.1 简介

正则表达式,又称规则表达式,它是一种文本模式,就是通过事先定义好的一些特定字符及这些特定字符的组合成一个规则,对文本字符串进行匹配筛选过滤。

比如:“A1bc23ef45”这个字符串,我只想要里面的数字,通过正则表达式中的“\d”就可以快速的提取出来。

注:正则表达式在线测试工具:开源中国——实用工具——https://tool.oschina.net

1.2 常用字符

| 字符 | 描述 |

| [...] | 匹配 [...] 中的所有字符,如[eno],将匹配Python is fun中的e n o字母(若有) |

| [^...] | 匹配除了 [...] 中字符的所有字符,上面的例子取反 |

| \w | 匹配字母、数字、下划线。等价于 [A-Za-z0-9_] |

| \s | 匹配任何空白字符,包括空格、制表符、换页符等 |

| \S | 匹配任何非空白字符 |

| ( ) | 标记一个子表达式的开始和结束位置。 |

| * | 匹配前面的子表达式零次或多次。 |

| . | 匹配除换行符 \n 之外的任何单字符。 |

| ? | 匹配前面的子表达式零次或一次,或指明一个非贪婪限定符 |

| \ | 转义字符 |

| ^ | 匹配输入字符串的开始位置 |

| $ | 匹配输入字符串的结尾位置 |

| + | 匹配前面的子表达式一次或多次 |

| \d | 匹配数字 |

| \D | 匹配非数字 |

| {n} | n 是一个非负整数,匹配确定的 n 次 |

| {n,} | n 是一个非负整数,至少匹配n 次 |

| {n,m} | m 和 n 均为非负整数,其中n <= m,最少匹配 n 次且最多匹配 m 次 |

| .* | 贪婪匹配,匹配所有内容 |

| .*? | 非贪婪匹配,在所有内容中匹配一次 |

1.3 re模块中的常用方法

1.3.1 findall 查找字符串中所有内容,返回符合条件的数据,返回的数据是列表形式

1 lst = re.findall('o','Python is fun otoy')

2 print(lst)

3 # 查找字符串中所有的o,返回三个['o', 'o', 'o']

1.3.2 search 返回匹配到的第一个结果,如果没有返回None

lst = re.search('o','Python is fun otoy')

print(lst)

# <re.Match object; span=(4, 5), match='o'>

lst = re.search('a','Python is fun otoy')

print(lst)

# None

1.3.3 match 只能从字符串开头进行匹配

1 lst = re.match('o','Python is fun otoy')

2 print(lst)

3 # None

4

5 lst = re.match('P','Python is fun otoyPPPP')

6 print(lst)

7 # <re.Match object; span=(0, 1), match='P'>

1.3.4 finditer 和findall差不多,但是返回值是一个迭代器

1 lst = re.finditer('o','Python is fun otoy')

2 print(lst)

3 # <callable_iterator object at 0x000002820BCF6B20>

4

5 # 获取迭代器里的内容

6 for i in lst:

7 print(i)

8 # <re.Match object; span=(4, 5), match='o'>

9 # <re.Match object; span=(14, 15), match='o'>

10 # <re.Match object; span=(16, 17), match='o'>

11

12 # 只想要o

13 for i in lst:

14 print(i.group())# o# o# o

注:从finditer中获取内容,使用group方法,从search中获取也是使用这个方法

Part2 思路

2.1 目标

地址:https://movie.douban.com/top250

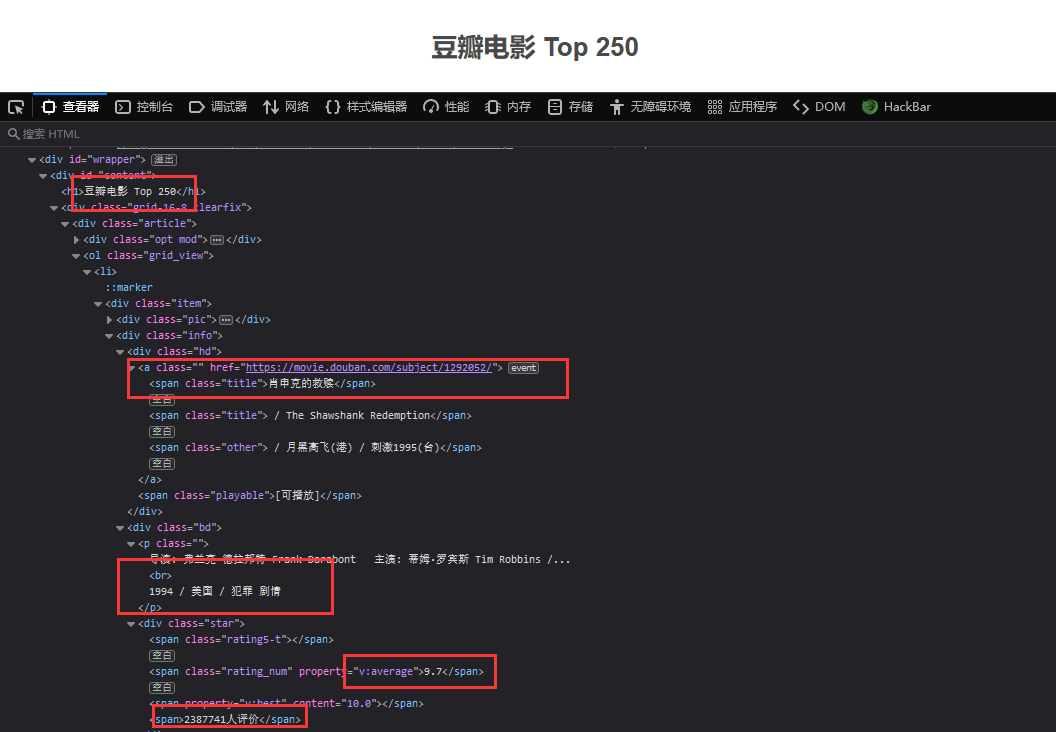

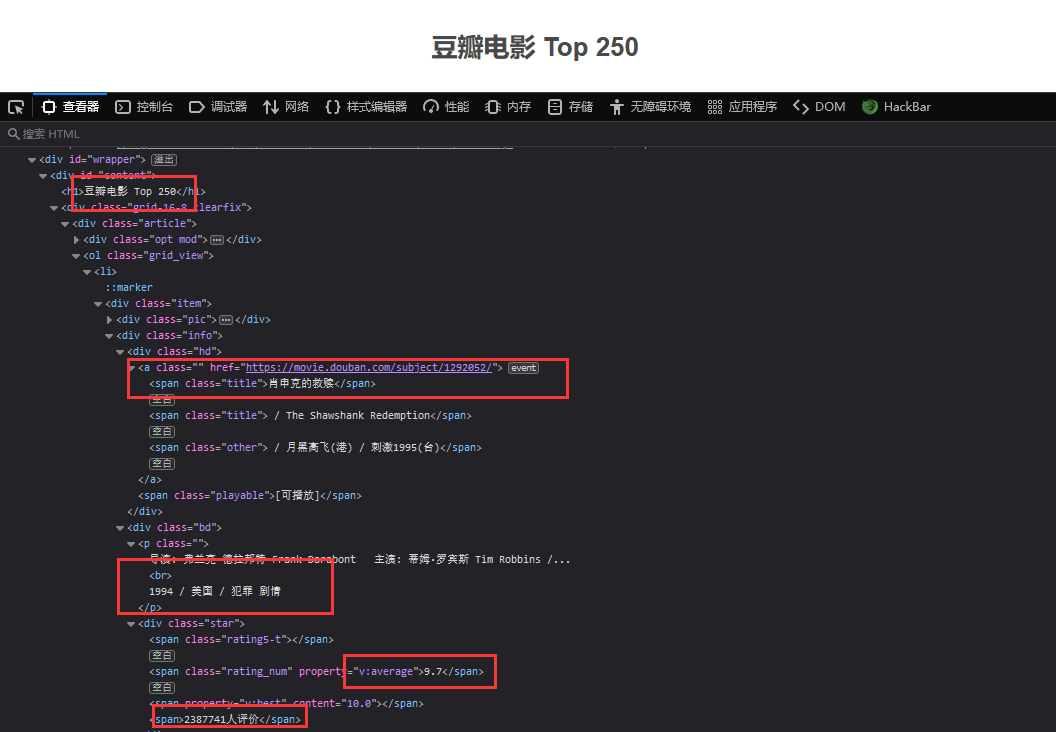

访问地址,F12打开开发者工具查看源代码,可以看到需要数据都在前端页面,开始分析需要的数据所在位置

2.2 步骤

发起请求——获取响应文本——正则表达式解析获取数据——数据存储

Part3 编写脚本

3.1 导入库

1 import requests

2 import re

3 import csv

re模块和csv为python自带,不需要安装,这里使用csv文本模式储存数据,是因为csv储存数据的特点:a,b,c 以逗号分割的格式,方便爬取数据后做进一步的处理分析。

3.2 撸代码

1 url = 'https://movie.douban.com/top250'

2 headers = {

3 "user-agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:85.0)Gecko/20100101 Firefox/85.0"

4 }

5

6 resp = requests.get(url=url, headers=headers).text

7 # 获取到响应数据之后,转换成text文本数据,这样才能使用re来进行操作

3.3 分析

需要获取到电影的链接,电影名字,年份/地区/分类,评分,评价人数

3.4 提前定义一个正则表达式,方便后面调用

1 obj = re.compile(r'<li>.*?<div class="item">.*?<a href="(?P<link>.*?)">.*?<span class="title">(?P<name>.*?)</span>.*?<br>(?P<year>.*?)</p>.*?<span class="rating_num" property="v:average">(?P<score>.*?)</span>.*?<span>(?P<comments>.*?)</span>', re.S)

注:使用 .*? 匹配过滤掉中间的所有的内容,使用(.*?)将匹配到内容提取,(?P<name>.*?)将匹配到的内容赋值给"name"

3.5 获取数据,写入保存

1 result = obj.finditer(resp)

2 fp = open('data.csv', 'w', encoding='utf-8')

3 wp = csv.writer(fp)

4

5 for it in result:

6 dic = it.groupdict()

7 dic['year'] = dic['year'].strip().replace(" ", "")

8 # 去除空格,替换字符

9 wp.writerow(dic.values())

10 fp.close()

注:从响应的文本里匹配到数据,使用groupdict()方法,将数据放到字典里,“year”匹配到的数据里含有空格和特殊字符,使用strip()方法去除空格,然后使用replace()方法把特殊字符替换成空

Part4 完整代码

4.1 说明

按照上面的代码,爬取到的是第一页的内容,只有25条数据,通过分析URL参数,改变参数内容发起请求即可获取全部的数据。

1 import requests

2 import re

3 import csv

4

5 fp = open('data.csv', 'w', encoding='utf-8')

6 wp = csv.writer(fp)

7

8 for i in range(0, 256, 25):

9 url = f'https://movie.douban.com/top250?start={i}&filter='

10 headers = {

11 "user-agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:85.0) Gecko/20100101 Firefox/85.0"

12 }

13

14 resp = requests.get(url=url, headers=headers).text

15

16 # 数据解析

17 obj = re.compile(r'<li>.*?<div class="item">.*?<a href="(?P<link>.*?)">.*?'

18 r'<span class="title">(?P<name>.*?)</span>.*?<br>(?P<year>.*?)</p>.*?'

19 r'<span class="rating_num" property="v:average">(?P<score>.*?)</span>.*?'

20 r'<span>(?P<comments>.*?)</span>', re.S)

21

22 result = obj.finditer(resp)

23

24 for it in result:

25 dic['year'] = dic['year'].strip().replace(" ", "")

26 # 去除空格,替换字符

27 wp.writerow(dic.values())

28

29 fp.close()

30 print('top250已下载完成')

4.2 运行结果

奇盛测试攻城狮 专业就是不断地学习,除去偶然性,你永远无法发现认知以外的BUG。——C_N_Candy 公众号

正则表达式_爬取豆瓣电影排行Top250的更多相关文章

- 爬取豆瓣电影排行top250

功能描述V1.0: 爬取豆瓣电影排行top250 功能分析: 使用的库 1.time 2.json 3.requests 4.BuautifulSoup 5.RequestException 上机实验 ...

- python2.7爬取豆瓣电影top250并写入到TXT,Excel,MySQL数据库

python2.7爬取豆瓣电影top250并分别写入到TXT,Excel,MySQL数据库 1.任务 爬取豆瓣电影top250 以txt文件保存 以Excel文档保存 将数据录入数据库 2.分析 电影 ...

- 一起学爬虫——通过爬取豆瓣电影top250学习requests库的使用

学习一门技术最快的方式是做项目,在做项目的过程中对相关的技术查漏补缺. 本文通过爬取豆瓣top250电影学习python requests的使用. 1.准备工作 在pycharm中安装request库 ...

- 爬虫——正则表达式爬取豆瓣电影TOP前250的中英文名

正则表达式爬取豆瓣电影TOP前250的中英文名 1.首先要实现网页的数据的爬取.新建test.py文件 test.py 1 import requests 2 3 def get_Html_text( ...

- urllib+BeautifulSoup无登录模式爬取豆瓣电影Top250

对于简单的爬虫任务,尤其对于初学者,urllib+BeautifulSoup足以满足大部分的任务. 1.urllib是Python3自带的库,不需要安装,但是BeautifulSoup却是需要安装的. ...

- scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250

scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250 前言 经过上一篇教程我们已经大致了解了Scrapy的基本情况,并写了一个简单的小demo.这次我会以爬取豆瓣电影TOP250为例进一步为大 ...

- scrapy爬取豆瓣电影top250

# -*- coding: utf-8 -*- # scrapy爬取豆瓣电影top250 import scrapy from douban.items import DoubanItem class ...

- python 爬虫&爬取豆瓣电影top250

爬取豆瓣电影top250from urllib.request import * #导入所有的request,urllib相当于一个文件夹,用到它里面的方法requestfrom lxml impor ...

- 【转】爬取豆瓣电影top250提取电影分类进行数据分析

一.爬取网页,获取需要内容 我们今天要爬取的是豆瓣电影top250页面如下所示: 我们需要的是里面的电影分类,通过查看源代码观察可以分析出我们需要的东西.直接进入主题吧! 知道我们需要的内容在哪里了, ...

随机推荐

- node.js的包加载机制

加载一个模块 require('moduleName'); 现在核心模块中加载,如果核心模块中没有,那么就去node_modules目录下去找,核心模块的优先级最高. 如果加载模块式省略了文件的后缀名 ...

- 一文详解 Linux 系统常用监控工一文详解 Linux 系统常用监控工具(top,htop,iotop,iftop)具(top,htop,iotop,iftop)

一文详解 Linux 系统常用监控工具(top,htop,iotop,iftop) 概 述 本文主要记录一下 Linux 系统上一些常用的系统监控工具,非常好用.正所谓磨刀不误砍柴工,花点时间 ...

- linux进程间通信-(转自 临水)

一.进程间通信概述进程通信有如下一些目的:A.数据传输:一个进程需要将它的数据发送给另一个进程,发送的数据量在一个字节到几M字节之间B.共享数据:多个进程想要操作共享数据,一个进程对共享数据的修改,别 ...

- BLDC 无刷电机FOC驱动 STM32官方培训资料

STM32 PMSM FOC SDK V3.2 培训讲座一http://v.youku.com/v_show/id_XNTM2NjgxMjU2.html?from=s1.8-1-1.2STM32 PM ...

- 关于Linux的一些基础命令

今天学习scala语言,在linux系统上运行,发现对Linux的命令不太熟悉,为了熟悉掌握,也便于查询,这些命令主要是为了收藏备用,,希望能帮助到大家 linux20个常用命令是: 1.显示日期的指 ...

- PTH的几种食用姿势

PTH PTH(pass the hash)也叫做hash传递.在内网渗透中是一种很经典的攻击方式,原理就是攻击者可以直接通过NTLM Hash(mimikatz或其他手段抓取到的密码hash)访问远 ...

- CAS(Compare and Swap)无锁算法-学习笔记

非阻塞同步算法与CAS(Compare and Swap)无锁算法 这篇问题对java的CAS讲的非常透彻! 锁的代价 1. 内核态的锁的时候需要操作系统进行一次上下文切换,加锁.释放锁会导致比较多的 ...

- eclipse集成processing、PApplet、proclipsing 问题

最近老是换应用平台,将processing里的代码转移到eclipse中. processing 关于转换成eclipse的介绍也可以使用,但是没有介绍具体怎么使用第三方库 Processing in ...

- 人脸标记检测:ICCV2019论文解析

人脸标记检测:ICCV2019论文解析 Learning Robust Facial Landmark Detection via Hierarchical Structured Ensemble 论 ...

- 编译器设计-RunTime运行时环境

编译器设计-RunTime运行时环境 Compiler Design - Run-Time Environment 作为源代码的程序仅仅是文本(代码.语句等)的集合,要使其活动,它需要在目标计算机上执 ...