python爬虫田康林

代码如下

import requests

import json

import time

import os

from threading import Timer

def getHTML(url):

try:

r=requests.get(url,timeout=30)

r.raise_for_status()

r.encoding=r.apparent_encoding

datas=json.loads(r.text)['data']

except:

print('连接失败')

else:

result=""

for data in datas:

result+=str(data['StudentNo'])+','+data['RealName']+','+data['DateAdded'].replace('T',' ')+','+data['Title']+','+data['Url']+'\n'

f=open('F:\羊车门爬虫作业\hwlist.csv','w')

f.write(result)

f.close()

os.mkdir('F:\羊车门爬虫作业\hwFolder')

os.chdir('F:\羊车门爬虫作业\hwFolder')

for data in datas:

os.mkdir(str(data['StudentNo']))

os.chdir(str(data['StudentNo']))

try:

web=requests.get(data['Url'],timeout=30)

web.raise_for_status()

web.encoding=web.apparent_encoding

except:

print('连接失败')

else:

f=open(str(data['StudentNo'])+'.html','wb')

f.write(web.content)

f.close()

os.chdir(os.path.pardir)

url='https://edu.cnblogs.com/Homework/GetAnswers?homeworkId=2420&_=1543216235911'

if __name__=='__main__':

t=Timer(300,getHTML(url))

t.start()

第一部分:

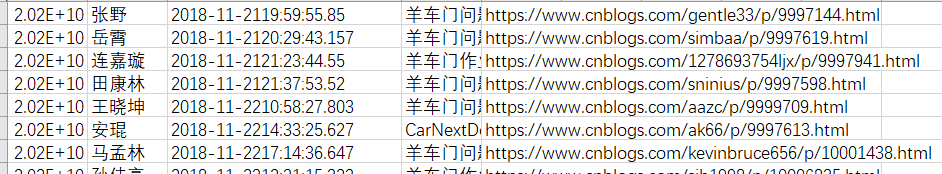

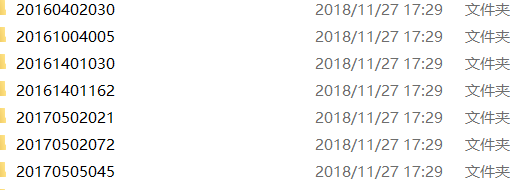

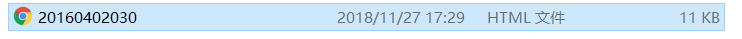

文件内容范例如下形式:

python爬虫田康林的更多相关文章

- Python选修课第一届Turtle绘图大赛田康林赵冰珂组

点击此处查看视频 from turtle import* setup(600,600,200,200) #脸 penup() goto(-190,0) seth(-90) pendown() penc ...

- [python爬虫] Selenium定向爬取海量精美图片及搜索引擎杂谈

我自认为这是自己写过博客中一篇比较优秀的文章,同时也是在深夜凌晨2点满怀着激情和愉悦之心完成的.首先通过这篇文章,你能学到以下几点: 1.可以了解Python简单爬取图片的一些思路和方法 ...

- python爬虫scrapy项目详解(关注、持续更新)

python爬虫scrapy项目(一) 爬取目标:腾讯招聘网站(起始url:https://hr.tencent.com/position.php?keywords=&tid=0&st ...

- FocusBI: 使用Python爬虫为BI准备数据源(原创)

关注微信公众号:FocusBI 查看更多文章:加QQ群:808774277 获取学习资料和一起探讨问题. <商业智能教程>pdf下载地址 链接:https://pan.baidu.com/ ...

- Python爬虫突破封禁的6种常见方法

转 Python爬虫突破封禁的6种常见方法 2016年08月17日 22:36:59 阅读数:37936 在互联网上进行自动数据采集(抓取)这件事和互联网存在的时间差不多一样长.今天大众好像更倾向于用 ...

- Python 爬虫模拟登陆知乎

在之前写过一篇使用python爬虫爬取电影天堂资源的博客,重点是如何解析页面和提高爬虫的效率.由于电影天堂上的资源获取权限是所有人都一样的,所以不需要进行登录验证操作,写完那篇文章后又花了些时间研究了 ...

- python爬虫成长之路(一):抓取证券之星的股票数据

获取数据是数据分析中必不可少的一部分,而网络爬虫是是获取数据的一个重要渠道之一.鉴于此,我拾起了Python这把利器,开启了网络爬虫之路. 本篇使用的版本为python3.5,意在抓取证券之星上当天所 ...

- python爬虫学习(7) —— 爬取你的AC代码

上一篇文章中,我们介绍了python爬虫利器--requests,并且拿HDU做了小测试. 这篇文章,我们来爬取一下自己AC的代码. 1 确定ac代码对应的页面 如下图所示,我们一般情况可以通过该顺序 ...

- python爬虫学习(6) —— 神器 Requests

Requests 是使用 Apache2 Licensed 许可证的 HTTP 库.用 Python 编写,真正的为人类着想. Python 标准库中的 urllib2 模块提供了你所需要的大多数 H ...

随机推荐

- Dubbo学习参考

参考博客: 小宝鸽:https://blog.csdn.net/u013142781/article/details/50387583 https://blog.csdn.net/u013142781 ...

- 委托的begininvoke

http://blog.csdn.net/cml2030/article/details/2172854 http://blog.163.com/weizhiyong_111/blog/static/ ...

- UVa 1630 串折叠

https://vjudge.net/problem/UVA-1630 题意: 给出一个由大写字母组成的长度为n的串,折叠成一个尽量短的串.例如:AAAAAAAAABABABCCD折叠成9(A)3(A ...

- mysql中index与Multiple-Column Indexes区别与联系

索引对提升SELECT/UPDATE语句查询速度有着立竿见影的效果,有索引和无索引,查询速度往往差几个数量级. 本次讨论一下index(每列作为一个索引,单列索引)和Multiple-Column I ...

- vuex到底是个啥

vuex总结 Vuex 是一个专为 Vue.js 应用程序开发的状态管理模式.它采用集中式存储管理应用的所有组件的状态,并以相应的规则保证状态以一种可预测的方式发生变化.Vuex 也集成到 Vue 的 ...

- ubuntu16.04上安装Jenkins,获取登陆密码

sudo cat /usr/share/tomcat7/.jenkins/secrets/initialAdminPassword

- [ios]ios画线 使用CGContextRef,CGPath和UIBezierPath来绘画

参考 :http://www.mgenware.com/blog/?p=493 这三种东西:CGContextRef,CGPath和UIBezierPath.本质上都是一样的,都是使用Quartz来绘 ...

- English trip -- Phonics 6 元音字母 u + Unit 5 B课 review

Vowel u [ʌ] 闭音节 bunny cut bug mushroom lunch ar er ur or ir = R (读音类似儿) e.g. dollar 美元 collar n. ...

- 012 - jstat命令查看jvm的GC情况 | jvm

jstat命令可以查看堆内存各部分的使用量,以及加载类的数量. 命令的格式如下: jstat -<option> [-t] [-h<lines>] <vmid> [ ...

- 20170731xlVba根据数据表和模板表生成新表

Public Sub SplitData() Dim Wb As Workbook Dim Sht As Worksheet Dim NewSht As Worksheet Dim arr As Va ...