flink连接hbase方法及遇到的问题

1、继承 RichSinkFunction 类

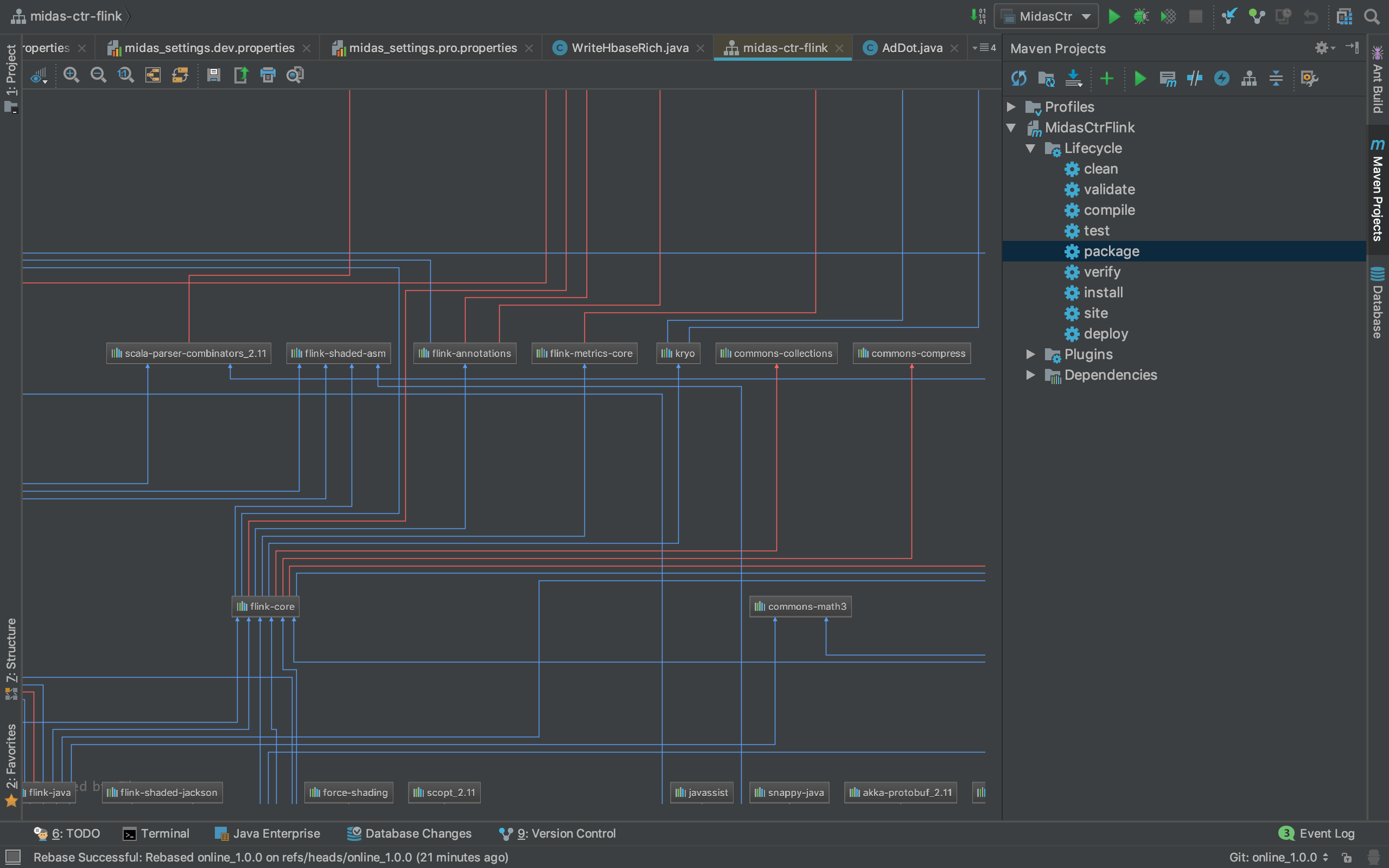

mvn配置:

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-hbase_2.12</artifactId>

<version>1.7.2</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.7.3</version>

<exclusions>

<exclusion>

<artifactId>xml-apis</artifactId>

<groupId>xml-apis</groupId>

</exclusion>

</exclusions>

</dependency>

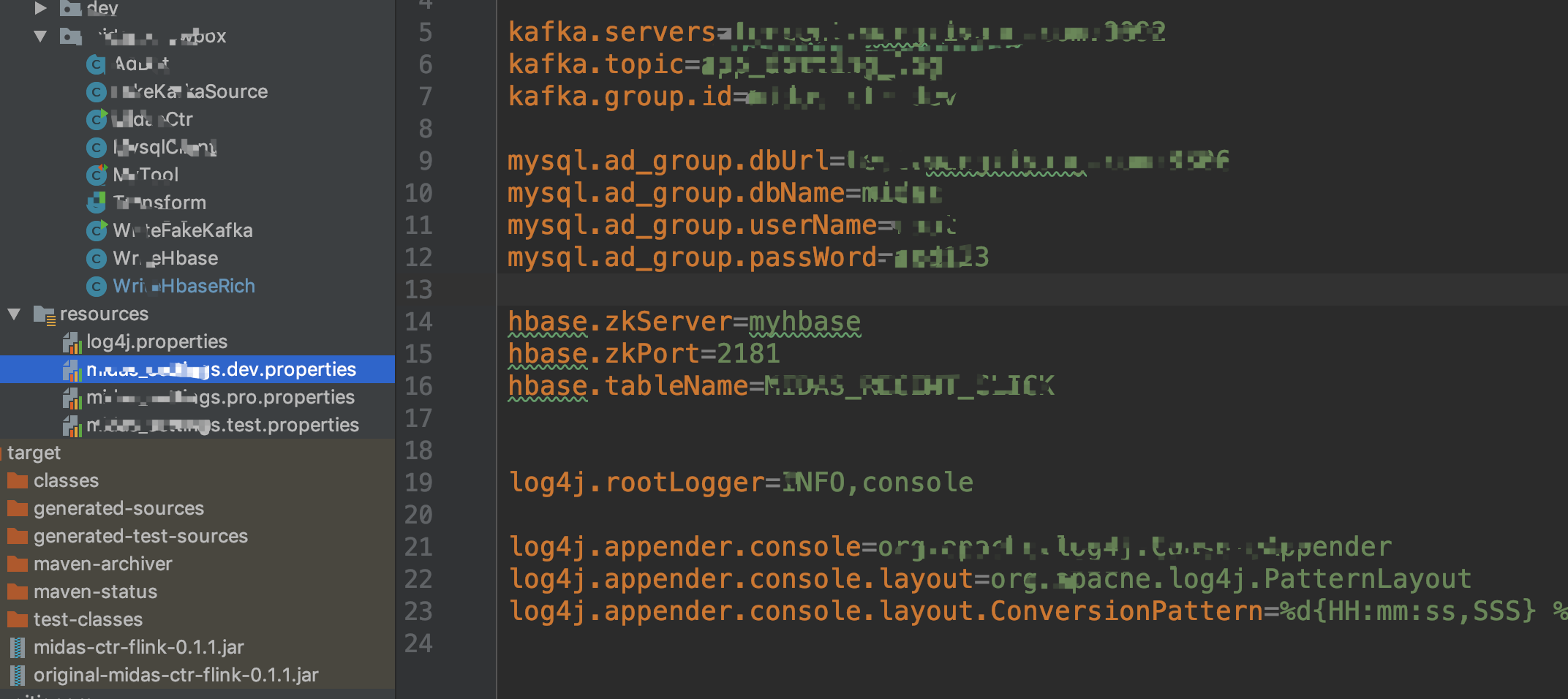

config配置:

flink接入config代码:

public static void main(String[] args) throws Exception {

/*

Env and Config

*/

if (args.length > 0) {

configEnv = args[0];

}

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

String confName = String.format("xxx.%s.properties", configEnv);

InputStream in = MidasCtr.class.getClassLoader().getResourceAsStream(confName);

ParameterTool parameterTool = ParameterTool.fromPropertiesFile(in);

env.getConfig().setGlobalJobParameters(parameterTool);

}

代码:

package midas.knowbox; import org.apache.flink.api.java.utils.ParameterTool;

import org.apache.flink.configuration.Configuration;

import org.apache.flink.streaming.api.functions.sink.RichSinkFunction;

import org.apache.hadoop.hbase.HBaseConfiguration;

import org.apache.hadoop.hbase.HColumnDescriptor;

import org.apache.hadoop.hbase.HTableDescriptor;

import org.apache.hadoop.hbase.TableName;

import org.apache.hadoop.hbase.client.*;

import org.apache.hadoop.hbase.util.Bytes; public class WriteHbaseRich extends RichSinkFunction<AdDot> {

private Connection conn = null;

private Table table = null; private static String zkServer;

private static String zkPort;

private static TableName tableName; private static final String click = "click";

BufferedMutatorParams params;

BufferedMutator mutator; @Override

public void open(Configuration parameters) throws Exception {

ParameterTool para = (ParameterTool)

getRuntimeContext().getExecutionConfig().getGlobalJobParameters();

zkServer = para.getRequired("hbase.zkServer");

zkPort = para.getRequired("hbase.zkPort");

String tName = para.getRequired("hbase.tableName");

tableName = TableName.valueOf(tName); org.apache.hadoop.conf.Configuration config = HBaseConfiguration.create(); config.set("hbase.zookeeper.quorum", zkServer);

config.set("hbase.zookeeper.property.clientPort", zkPort); conn = ConnectionFactory.createConnection(config);

Admin admin = conn.getAdmin();

admin.listTableNames();

if (!admin.tableExists(tableName)) {

HTableDescriptor tableDes = new HTableDescriptor(tableName); tableDes.addFamily(new HColumnDescriptor(click).setMaxVersions(3)); System.out.println("create table");

admin.flush(tableName);

}

// 连接表

table = conn.getTable(tableName); // 设置缓存

params = new BufferedMutatorParams(tableName);

params.writeBufferSize(1024);

mutator = conn.getBufferedMutator(params);

} @Override

public void invoke(AdDot record, Context context) throws Exception {

Put put = new Put(Bytes.toBytes(String.valueOf(record.userID)));

System.out.println("hbase write"); System.out.println(record.recent10Data);

put.addColumn(Bytes.toBytes(click),Bytes.toBytes("recent_click"),Bytes.toBytes(String.valueOf(record.toJson()))); mutator.mutate(put);

System.out.println("hbase write");

} @Override

public void close() throws Exception {

mutator.flush();

conn.close();

}

}

调用:

dataStream.addSink(new WriteHbaseRich());

2、实现接口OutputFormat(不知道如何使用flink的配置文件)

package midas.knowbox; import org.apache.flink.api.common.io.OutputFormat;

import org.apache.flink.configuration.Configuration; import org.apache.hadoop.hbase.HBaseConfiguration;

import org.apache.hadoop.hbase.HColumnDescriptor;

import org.apache.hadoop.hbase.HTableDescriptor;

import org.apache.hadoop.hbase.TableName;

import org.apache.hadoop.hbase.client.*;

import org.apache.hadoop.hbase.util.Bytes; import java.io.IOException;

import java.util.ArrayList; public class WriteHbase implements OutputFormat<AdDot> { private Connection conn = null;

private Table table = null; private static String zkServer = "";

private static String port = "2181";

private static TableName tableName = TableName.valueOf("test"); private static final String userCf = "user";

private static final String adCf = "ad"; @Override

public void configure(Configuration parameters) {

} @Override

public void open(int taskNumber, int numTasks) throws IOException {

org.apache.hadoop.conf.Configuration config = HBaseConfiguration.create(); config.set("hbase.zookeeper.quorum", zkServer);

config.set("hbase.zookeeper.property.clientPort", port); conn = ConnectionFactory.createConnection(config);

Admin admin = conn.getAdmin();

admin.listTableNames();

if (!admin.tableExists(tableName)) { // 添加表描述

HTableDescriptor tableDes = new HTableDescriptor(tableName); // 添加列族

tableDes.addFamily(new HColumnDescriptor(userCf));

tableDes.addFamily(new HColumnDescriptor(adCf)); // 创建表

admin.createTable(tableDes);

}

table = conn.getTable(tableName);

} @Override

public void writeRecord(AdDot record) throws IOException {

Put put = new Put(Bytes.toBytes(record.userID + "_" + record.adID + "_" + record.actionTime)); // 指定行

// 参数分别:列族、列、值

put.addColumn(Bytes.toBytes("user"), Bytes.toBytes("uerid"), Bytes.toBytes(record.userID));

put.addColumn(Bytes.toBytes("ad"), Bytes.toBytes("ad_id"), Bytes.toBytes(record.adID)); table.put(put);

} @Override

public void close() throws IOException {

conn.close()

}

}

3、遇到的问题

写入hbase的时候出现包引用错误 剔除 xml-apis 就好了

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.7.3</version>

<exclusions>

<exclusion>

<artifactId>xml-apis</artifactId>

<groupId>xml-apis</groupId>

</exclusion>

</exclusions>

</dependency>

flink连接hbase方法及遇到的问题的更多相关文章

- phoenix连接hbase数据库,创建二级索引报错:Error: org.apache.phoenix.exception.PhoenixIOException: Failed after attempts=36, exceptions: Tue Mar 06 10:32:02 CST 2018, null, java.net.SocketTimeoutException: callTimeou

v\:* {behavior:url(#default#VML);} o\:* {behavior:url(#default#VML);} w\:* {behavior:url(#default#VM ...

- JDBC连接MySQL 方法 实例及资料收集

JDBC连接MySQL 方法 实例及资料收集 准备工作 首先,安装MySQL,配置用户名和密码,创建数据库. 可参见之前的文章: http://www.cnblogs.com/mengdd/p/315 ...

- [转]配置mysql允许远程连接的方法

配置mysql允许远程连接的方法 vim /etc/my.cnf注释这一行:bind-address=127.0.0.1 ==> #bind-address=127.0.0.1保存退出.mysq ...

- docker 安装 hbase安装 java连接hbase (mac环境)

docker 安装 https://hub.docker.com/editions/community/docker-ce-desktop-mac 下载地址 下载完之后,安装app一样安装就好 安装完 ...

- 全网最详细的hive-site.xml配置文件里如何添加达到Hive与HBase的集成,即Hive通过这些参数去连接HBase(图文详解)

不多说,直接上干货! 一般,普通的情况是 全网最详细的hive-site.xml配置文件里添加<name>hive.cli.print.header</name>和<na ...

- Oracle字符串连接的方法

Oracle数据库中,使用“||”进行字符串连接,下面就让我们一起了解一下Oracle数据库中字符串连接的方法,希望对您能有所帮助. 和其他数据库系统类似,Oracle字符串连接使用“||”进行字符串 ...

- ambari安装集群下python连接hbase之安装thrift

简介: python连接hbase是需要通过thrift连进行连接的,ambari安装的服务中貌似没有自带安装hbase的thrift,我是看配置hbase的配置名称里面没有thrift,cdh版本的 ...

- windows平台kettle连接hbase的问题

我本机安装的环境是centos7,并在本机上安装了zookeeper,hadoop,hbase,hive等组件, 使用pdi7.1来连接hbase,把mysql表中的数据导出到hbase中去,没有问题 ...

- mysql设置指定ip远程访问连接的方法

本文实例讲述了mysql设置指定ip远程访问连接的方法,分享给大家供大家参考.具体实现方法如下: 1. 授权用户root使用密码jb51从任意主机连接到mysql服务器: 复制代码 代码如下: GRA ...

随机推荐

- oracle利用job创建一个定时任务,定时调用存储过程

--创建表 create table TESTWP ( ID ), C_DATE DATE ); select * from TESTWP; --2.创建一个sequence create seque ...

- 【JS】前端文件下载(无刷新)方法总结

#传统方法 利用iframe 或 form.submit 或 windows.open直接向后端发请求,后端返回文件流,后端处理成功后会直接返回到页面,浏览器会整理并打开自己的保存下载文件机制 . 1 ...

- OA系统开发人事模块关于请假跨月的处理

前言:其实对于跨月的数据单独处理是不难的,但是对于后台显示页面,肯定不是单纯拼接一个where条件的,因此在我的项目也是如此,并不能够用普遍的方法来处理,此时就想尽量用简单的方法来处理跨月数据的准确性 ...

- FPGA

FPGA(Field-Programmable Gate Array),即现场可编程门阵列,它是在PAL.GAL.CPLD等可编程器件的基础上进一步发展的产物.它是作为专用集成电路(ASIC)领域中的 ...

- Ireport5.0.1 从java后台接收list集合

作为ireport新手,开始使用时总有很多问题,说一下今天解决的一个问题,就是怎样从java后台接收list集合并显示出列表. 1.首先要在主dataset中的Paramerters 中创建参数lis ...

- Android相关面试题---初识

一 .Activity的生命周期 Android是使用任务(Task)来管理活动的,一个任务就是一组存放在栈里的活动的集合,这个栈也被称为返回栈(Back Stack).每当我们启动一个新的活动,它会 ...

- MySQL命令行查询乱码解决方法

转自Agoly的博客,原文链接https://www.cnblogs.com/qmfsun/p/4846467.html 感谢博主Agoly这篇文章说的很详细很透彻. MySQL会出现中文乱码的原因不 ...

- 解决select下拉框禁用(设置disabled属性),后台获取值为空

如果下拉框设置disabled属性后,提交表单到后台,后台获取的下拉框的值为空,以下有三种解决获取不到下拉框选项值的方法. 有下拉框html如:<select name="select ...

- iTOP-4418/6818开发板用户使用手册内容有哪些

更多内容分享,请继续期待 iTOP-6818开发板与4418开发板共兼容同一底板: 核心板:::::: 尺寸:50mm*60mm 高度:核心板连接器组合高度1.5mm ...

- python3随机数函数

随机数函数 choice(seq) 从序列的元素中随机挑选一个元素,比如random.choice(range(10)),从0到9中随机挑选一个整数. randrange ([start,] stop ...