openstack(Pike 版)集群部署(七)--- Cinder 部署

一、介绍

参照官网部署:https://docs.openstack.org/cinder/pike/install/index-rdo.html

继续上一博客进行部署:http://www.cnblogs.com/weijie0717/p/8641493.html

二、部署cinder 服务(controller 节点)

按照博客部署:https://docs.openstack.org/cinder/pike/install/cinder-controller-install-rdo.html

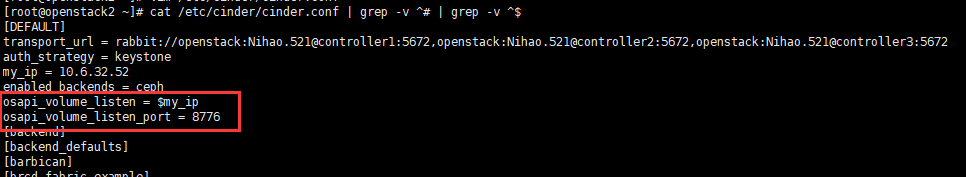

1、 需要作出修改的地方:(避免配置Haproxy 后 端口冲突。)

# vim /etc/cinder/cinder.conf

2、配置 Haproxy

博客:http://www.cnblogs.com/weijie0717/p/8530102.html

配置:cinder 服务。

三、验证配置

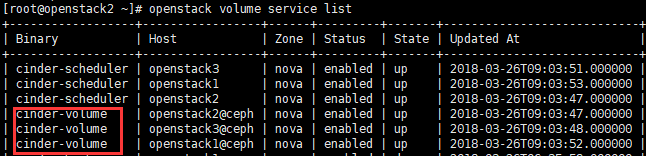

# openstack volume service list

基础服务到此处。配置完成。

四、部署cinder-volumes + ceph cluster

1、安装ceph包 (所有controller 节点)

# yum -y install ceph-common

2、 拷贝ceph集群配置文件到所有controller 节点 /etc/ceph/ceph.conf (ceph 集群 任意节点)

之前在配置 glance 时已经操作,在此处不在操作,具体命令如下:

# scp /etc/ceph/ceph.conf root@controller1:/etc/ceph/ceph.conf

# scp /etc/ceph/ceph.conf root@controller2:/etc/ceph/ceph.conf

# scp /etc/ceph/ceph.conf root@controller3:/etc/ceph/ceph.conf

3、 创建 Cinder 所需要的ceph 存储池:volumes (任意ceph-mon 节点 )

# ceph osd pool create volumes 128 128

4、 生成和导出证书到 controller节点 (任意ceph-mon 节点 )

# ceph auth get-or-create client.cinder mon 'allow r' osd 'allow class-read object_prefix rbd_children, allow rwx pool=volumes,allow rwx pool=vms,allow rx pool=images' -o /etc/ceph/ceph.client.cinder.keyring

5、 拷贝keying 文件至所有controller 节点 /etc/ceph/文件中

# scp /etc/ceph/ceph.client.cinder.keyring root@controller-all:/etc/ceph/ceph.client.cinder.keyring

6、controller 的 libvirt也需要这个key,创建Key:

# uuidgen

# cd /root

# vim secret.xml

<secret ephemeral = 'no' private = 'no'>

<uuid>953c13f7-76e1-48b3-a982-cf0ee5c51039</uuid> #此UUID 为 uuidgen 获取到的ID

<usage type = 'ceph'>

<name>client.cinder secret</name>

</usage>

</secret>

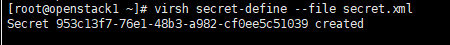

# virsh secret-define --file secret.xml

# virsh secret-set-value --secret 953c13f7-76e1-48b3-a982-cf0ee5c51039 --base64 AQB7TrhaDC6oLBAATxzn5wCRYZeR3XmU0FE9vQ==

# --secret 后的值 为 UUID值。

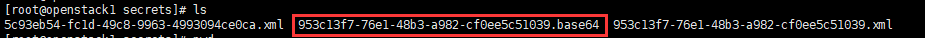

# base64 后的值为/etc/ceph/ceph.client.cinder.keyring 的KEY 值。生成的key保存在/etc/libvirt/secrets

Note: UUID 在controller 各节点上保持一致。 拷贝 secret.xml 到其他controller节点,然后继续 uuidgen 命令之后的所有操作。

7、配置 Cinder

# vim /etc/cinder/cinder.conf

[DEFAULT]

enabled_backends = ceph 配置文件最后添加,避免打乱其他标签项配置。

[ceph]

volume_driver = cinder.volume.drivers.rbd.RBDDriver

rbd_pool = volumes

rbd_ceph_conf = /etc/ceph/ceph.conf

rbd_flatten_volume_from_snapshot = false

rbd_max_clone_depth =

#rbd_store_chunk_size =

#rados_connect_timeout = -

rbd_user = cinder # 生成Key是所使用的用户

rbd_secret_uuid = 953c13f7-76e1-48b3-a982-cf0ee5c51039 # UUID

volume_backend_name = ceph

8、重启服务

# systemctl restart openstack-cinder-*

Note : (* 代表以下服务:openstack-cinder-api.service openstack-cinder-scheduler.service openstack-cinder-volume.service)查看 服务是否都正常启动。如果没有启动通过 start 启动,本实验过程中 openstack-cinder-volume.service 未能启动,通过start

# systemctl start openstack-cinder-volume.service

# systemctl enable openstack-cinder-volume.service

9、验证:

1、命令验证

# openstack volume service list

2、web 创建卷

项目--》卷--》卷--》创建卷:

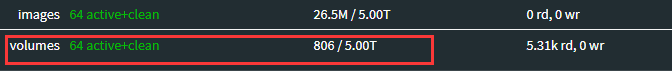

3、ceph 集群查看

ceph 集群中查看到有数据传入。

4、处理ceph 集群告警。参考 配置Glance 时的操作

博客:http://www.cnblogs.com/weijie0717/p/8563294.html

到此处,cinder-volumes + ceph 集群 配置完成。

附加:

1、配置 Volume-type。 (适用场景:具有多种类型的ceph 存储:ceph-sas 、ceph-ssd 集群 等等)

注:如果不指定volume type,cinder-scheduler会忽略volume type,按默认的调度器从所有cinder-volume调度。

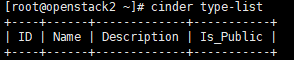

a、查看:

# cinder type-lis

b、配置:

# cinder type-create ceph # ceph 为type-name 自定义

# cinder type-key ceph set volume_backend_name=ceph # volume type关联 cinder.conf 配置文件中的volume_backend_name

c、 验证

# cinder type-lis

另外:web中创建卷。卷的类型中也可以看到。

openstack(Pike 版)集群部署(七)--- Cinder 部署的更多相关文章

- openstack高可用集群16-ceph介绍和部署

Ceph Ceph是一个可靠.自动重均衡.自动恢复的分布式存储系统,根据场景划分可以将Ceph分为三大块,分别是对象存储.块设备和文件系统服务.块设备存储是Ceph的强项. Ceph的主要优点是分布式 ...

- openstack pike 集群高可用 安装 部署 目录汇总

# openstack pike 集群高可用 安装部署#安装环境 centos 7 史上最详细的openstack pike版 部署文档欢迎经验分享,欢迎笔记分享欢迎留言,或加QQ群663105353 ...

- openstack高可用集群21-生产环境高可用openstack集群部署记录

第一篇 集群概述 keepalived + haproxy +Rabbitmq集群+MariaDB Galera高可用集群 部署openstack时使用单个控制节点是非常危险的,这样就意味着单个节 ...

- CentOS7.2非HA分布式部署Openstack Pike版 (实验)

部署环境 一.组网拓扑 二.设备配置 笔记本:联想L440处理器:i3-4000M 2.40GHz内存:12G虚拟机软件:VMware® Workstation 12 Pro(12.5.2 build ...

- VLAN 模式下的 OpenStack 管理 vSphere 集群方案

本文不合适转载,只用于自我学习. 关于为什么要用OpenStack 管理 vSphere 集群,原因可以有很多,特别是一些传统企业,VMware 的使用还是很普遍的,用 OpenStack 纳管至少会 ...

- Kubeadm 1.9 HA 高可用集群本地离线镜像部署【已验证】

k8s介绍 k8s 发展速度很快,目前很多大的公司容器集群都基于该项目,如京东,腾讯,滴滴,瓜子二手车,易宝支付,北森等等. kubernetes1.9版本发布2017年12月15日,每三个月一个迭代 ...

- [K8s 1.9实践]Kubeadm 1.9 HA 高可用 集群 本地离线镜像部署

k8s介绍 k8s 发展速度很快,目前很多大的公司容器集群都基于该项目,如京东,腾讯,滴滴,瓜子二手车,北森等等. kubernetes1.9版本发布2017年12月15日,每是那三个月一个迭代, W ...

- 实现CI/CDk8s高可用集群搭建总结以及部署API到k8s

实现CI/CD(Centos7.2)系列二:k8s高可用集群搭建总结以及部署API到k8s 前言:本系列博客又更新了,是博主研究很长时间,亲自动手实践过后的心得,k8s集群是购买了5台阿里云服务器部署 ...

- 使用fabric解决百度BMR的spark集群各节点的部署问题

前言 和小伙伴的一起参加的人工智能比赛进入了决赛之后的一段时间里面,一直在构思将数据预处理过程和深度学习这个阶段合并起来.然而在合并这两部分代码的时候,遇到了一些问题,为此还特意写了脚本文件进行处理. ...

- 3-3 Hadoop集群完全分布式配置部署

Hadoop集群完全分布式配置部署 下面的部署步骤,除非说明是在哪个服务器上操作,否则默认为在所有服务器上都要操作.为了方便,使用root用户. 1.准备工作 1.1 centOS6服务器3台 手动指 ...

随机推荐

- Android自定义View学习(四)

硬件加速 参考:HenCoder Android 自定义 View 1-8 硬件加速 硬件加速能够让绘制变快,主要有三个原因: 本来由 CPU 自己来做的事,分摊给了 GPU 一部分,自然可以提高效率 ...

- <记录> PHP Redis操作类

namespace common\controller; class Redis { public $redisObj = null; //redis实例化时静态变量 static protected ...

- 深度学习原理与框架-卷积网络细节-三代物体检测算法 1.R-CNN 2.Fast R-CNN 3.Faster R-CNN

目标检测的选框操作:第一步:找出一些边缘信息,进行图像合并,获得少量的边框信息 1.R-CNN, 第一步:进行图像的选框,对于选出来的框,使用卷积计算其相似度,选择最相似ROI的选框,即最大值抑制RO ...

- Spring cloud info信息显示

父工程添加配置如下 <build> <finalName>microservicecloud</finalName> <resources> <r ...

- 在Ubuntu下利用Eclipse调试FFmpeg《转》

参考原贴,其中编译命令有略微改动. 第一步:准备编译环境 #sudoapt-get update #-dev libspeex-dev libtheora-dev libtool libva-dev ...

- Scrapy框架--代理和cookie

如何发起post请求? 代理和cookie: cookie:豆瓣网个人登录,获取该用户个人主页这个二级页面的页面数据. 如何发起post请求? 一定要对start_requests方法进行重写. 1. ...

- Netty - 2

参考:Scalable IO in Java - http://gee.cs.oswego.edu/dl/cpjslides/nio.pdf mainReactor负责处理客户端的连接请求,并将acc ...

- ubuntu 使用命令行登录oracle

1.检查环境变量设置 echo $ORACLE_HOME 2.配置oracle数据库信息,将oracle地址端口等信息放在$ORACLE_HOME/network/admin目录下的tnsnames. ...

- CSS GRID ESSENTIALS

CSS GRID ESSENTIALS Review At this point, we've covered a great deal of different ways to manipulate ...

- Zeosdbo-Query使用

with DataModule1.Zlxz_zy_Query do begin Close; SQL.Clear; SQL.Add( ...