python爬虫数据解析之xpath

xpath是一门在xml文档中查找信息的语言。xpath可以用来在xml文档中对元素和属性进行遍历。

在xpath中,有7中类型的节点,元素,属性,文本,命名空间,处理指令,注释及根节点。

节点

首先看下面例子:

<?xml version="1.0" encoding="ISO-8859-1"?> <bookstore> <book>

<title lang="en">Harry Potter</title>

<author>J K. Rowling</author>

<year>2005</year>

<price>29.99</price>

</book> </bookstore>

上面的节点例子:

<bookstore> (文档节点)

<author>J K. Rowling</author> (元素节点)

lang="en" (属性节点)

父:在上面的例子里,book是title,author,year,price的父。

子:反过来,title,author,year,price是book的子。

同胞:title,author,year,price是同胞。

先辈:title的先辈是book,bookstore。

后代:bookstore的后代是book,tite,author,year,price。

再看一个例子:

<?xml version="1.0" encoding="ISO-8859-1"?> <bookstore> <book>

<title lang="eng">Harry Potter</title>

<price>29.99</price>

</book> <book>

<title lang="eng">Learning XML</title>

<price>39.95</price>

</book> </bookstore

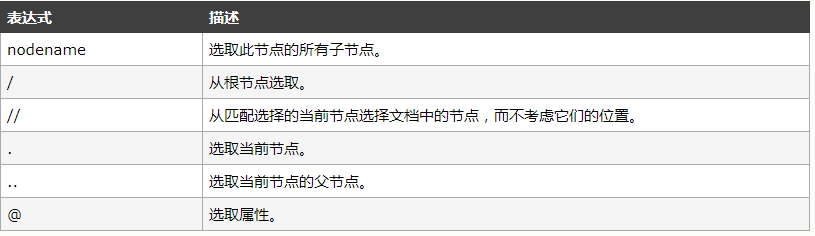

如何选取节点呢?

XPath 使用路径表达式在 XML 文档中选取节点。节点是通过沿着路径或者 step 来选取的。

对应上面的例子,得到结果:

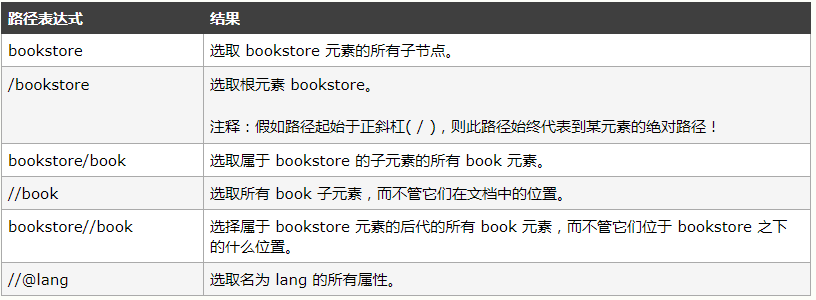

谓语:谓语用来查找某个特定节点或者包含某个指定值的节点。

比如:

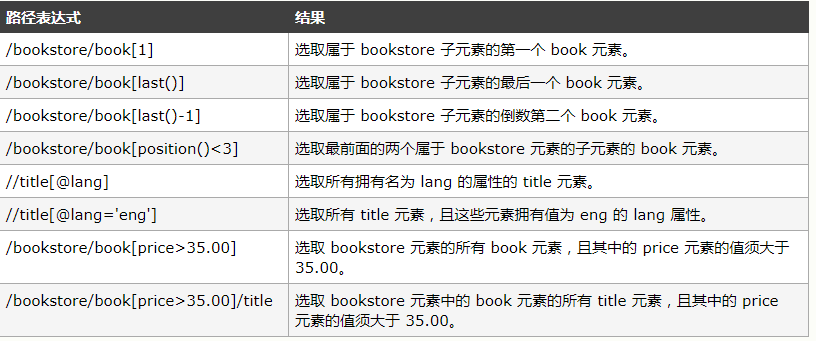

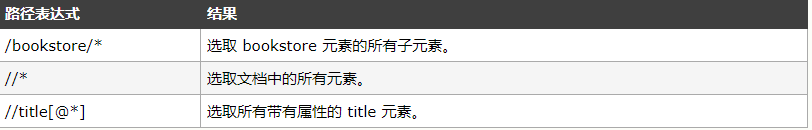

选取未知节点:

比如:

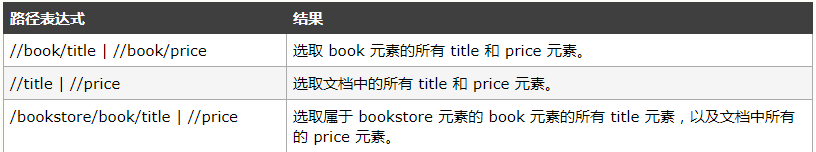

选取若干路径:通过在路径表达式中使用“|”运算符,您可以选取若干个路径。

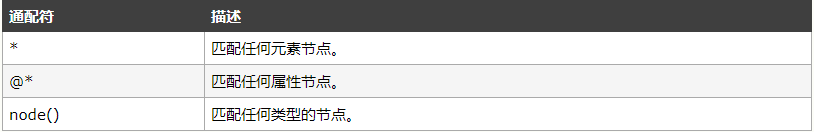

常用xpath属性:

# 找到class属性为song的div标签

//div[@class="song"]

层级定位:

# 找到class属性为tang的div直系字标签ul下的第二个字标签li下的直系字标签a

//div[@class='tang']/ul/li[2]/a

逻辑运算:

找到class属性为空且href属性为tang的a标签

//a[@class='' and @href='tang']

模糊定位

# 查找class属性值里包含'ng'字符串的div标签

//div[contains(@class, 'ng')]

# 配配class属性以ta为开头的div标签

//div[start_with(@class, 'ta')]

获取文本

//div[@class="song"]/p[1]/text()

获取属性

# 获取class属性为tang的div下的第二个li下面a标签的href属性

//div[@class="tang"]//li[2]/a/@href

在python中应用

将html文档或者xml文档转换成一个etree对象,然后调用对象中的方法查找指定节点。

1 本地文件:

tree = etree.parse(文档)

tree.xpath(xpath表达式)

2 网络数据:

tree = etree.HTML(网页字符串)

tree.xpath(xpath表达式)

例子1:随机爬取糗事百科糗图首页的一张图片

import requests

from lxml import etree

import random def main():

# 网页url

url = 'https://www.qiushibaike.com/pic/'

ua_headers = {"User-Agent": 'Mozilla/4.0 (compatible; MSIE 8.0; Windows NT 6.0; Trident/4.0)'}

# 网页代码

response = requests.get(url=url, headers=ua_headers).text

# 转换为etree对象

tree = etree.HTML(response)

# 匹配到所有class属性为thumb的div标签下的img标签的src属性值,返回一个列表

img_lst = tree.xpath('//div[@class="thumb"]//img/@src')

# 随机挑选一个图片并且下载下来

res = requests.get(url='https:'+random.choice(img_lst), headers=ua_headers).content

# 将图片保存到本地

with open('image.jpg', 'wb') as f:

f.write(res) if __name__ == '__main__':

main()

例子2:爬取煎蛋网首页的图片

import requests

from lxml import etree def main():

url = 'http://jandan.net/ooxx'

headers = {

"User-Agent": "Mozilla/5.0 (Macintosh; U; Intel Mac OS X 10_6_8; en-us) AppleWebKit/534.50 (KHTML, like Gecko) "

"Version/5.1 Safari/534.50"}

response = requests.get(url=url, headers=headers).text

tree = etree.HTML(response)

img_lst = tree.xpath('//div[@class="text"]//img/@src')

for one_image in img_lst:

res = requests.get(url='http:'+one_image, headers=headers).content

with open('image/' + one_image.split('/')[-1] + '.gif', 'wb') as f:

f.write(res) if __name__ == '__main__':

main()

python爬虫数据解析之xpath的更多相关文章

- python爬虫--数据解析

数据解析 什么是数据解析及作用 概念:就是将一组数据中的局部数据进行提取 作用:来实现聚焦爬虫 数据解析的通用原理 标签定位 取文本或者属性 正则解析 正则回顾 单字符: . : 除换行以外所有字符 ...

- python爬虫数据解析之BeautifulSoup

BeautifulSoup是一个可以从HTML或者XML文件中提取数据的python库.它能够通过你喜欢的转换器实现惯用的文档导航,查找,修改文档的方式. BeautfulSoup是python爬虫三 ...

- python爬虫数据解析的四种不同选择器Xpath,Beautiful Soup,pyquery,re

这里主要是做一个关于数据爬取以后的数据解析功能的整合,方便查阅,以防混淆 主要讲到的技术有Xpath,BeautifulSoup,PyQuery,re(正则) 首先举出两个作示例的代码,方便后面举例 ...

- python爬虫数据解析之正则表达式

爬虫的一般分为四步,第二个步骤就是对爬取的数据进行解析. python爬虫一般使用三种解析方式,一正则表达式,二xpath,三BeautifulSoup. 这篇博客主要记录下正则表达式的使用. 正则表 ...

- 070.Python聚焦爬虫数据解析

一 聚焦爬虫数据解析 1.1 基本介绍 聚焦爬虫的编码流程 指定url 基于requests模块发起请求 获取响应对象中的数据 数据解析 进行持久化存储 如何实现数据解析 三种数据解析方式 正则表达式 ...

- python爬虫+数据可视化项目(关注、持续更新)

python爬虫+数据可视化项目(一) 爬取目标:中国天气网(起始url:http://www.weather.com.cn/textFC/hb.shtml#) 爬取内容:全国实时温度最低的十个城市气 ...

- python 爬虫数据存入csv格式方法

python 爬虫数据存入csv格式方法 命令存储方式:scrapy crawl ju -o ju.csv 第一种方法:with open("F:/book_top250.csv" ...

- Python爬虫教程-22-lxml-etree和xpath配合使用

Python爬虫教程-22-lxml-etree和xpath配合使用 lxml:python 的HTML/XML的解析器 官网文档:https://lxml.de/ 使用前,需要安装安 lxml 包 ...

- python爬虫网页解析之lxml模块

08.06自我总结 python爬虫网页解析之lxml模块 一.模块的安装 windows系统下的安装: 方法一:pip3 install lxml 方法二:下载对应系统版本的wheel文件:http ...

随机推荐

- toFixed()一不小心踩了一个坑

toFixed,多么简单的一个函数,昨天突发奇想做两道算法题练练手.结果,踩到了一个从未遇到的坑! \n 简单来讲是要对输入的很多组数据,自己写一个函数做个处理,把每次函数处理的结果要相加求和.最后输 ...

- itchat库初探--微信好友全头像的拼接

代码: import itchat import math import PIL.Image as Image import os itchat.auto_login() friends = ...

- segmenter.go

; ;; ].minDistance ; ].text),, ;; ;; ;,) { output = append(output, toLower(text[alphanum ...

- JS代码检查工具ESLint

前面的话 ESLint是一个JavaScript代码静态检查工具,可以检查JavaScript的语法错误,提示潜在的bug,可以有效提高代码质量,维持前端团队高度一致的编码风格.ESLint不但提供一 ...

- B20J_2836_魔法树_树链剖分+线段树

B20J_2836_魔法树_树链剖分+线段树 题意: 果树共有N个节点,其中节点0是根节点,每个节点u的父亲记为fa[u].初始时,这个果树的每个节点上都没有果子(即0个果子). Add u v d ...

- iOS 8 中如何集成 Touch ID 功能

2013年9月,苹果为当时发布的最新iPhone产品配备了一系列硬件升级方案.在iPhone 5s当中,最具创新特性的机制无疑要数围绕Home按钮设计的超薄金属圈,也就是被称为Touch ID的指纹传 ...

- Java异常简介、异常捕获还是上抛总结

概要 本章对Java中的异常进行介绍.内容包括:1.Java异常简介2.Java异常框架 一.Java异常简介 Java异常是Java提供的一种识别及响应错误的一致性机制. Java异常机制可以使程序 ...

- MySQL--各版本DDL 操作总结

MySQL 5.5 DDL 在MySQL 5.5版本前,所有DDL操作都使用Copy Table的方式完成,操作过程中原表数据库不允许写入,只能读取,在MySQL 5.5版本中引入FIC(Fast i ...

- selenium IDE中log的保存与查看方法

下载selenium IDE的log保存插件为File Logging(selenium IDE),下载安装方式如下: (1)打开firefox浏览器----点击右上角----附加组件---插件--- ...

- Spring Framework学习要点摘抄

以下摘自Spring Framework官方文档,版本Spring 4.3. <context:annotation-config/> implicitly registered post ...