Hadoop_26_MapReduce_Reduce端使用GroupingComparator求同一订单中最大金额的订单

1. 自定义GroupingComparator

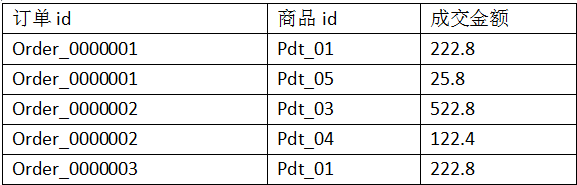

1.1.需求:有如下订单

现在需要求出每一个订单中成交金额最大的一笔交易

1.2.分析:

1、利用“订单id和成交金额”Bean作为key,可以将map阶段读取到的所有订单数据按照id分区,按照金额排序,

发送到reduce

2、在reduce端利用GroupingComparator将订单id相同的kv聚合成组,然后取第一个即是最大值

定义订单信息bean,实现CompareTo()方法用于排序

package cn.bigdata.hdfs.secondarySort; import java.io.DataInput;

import java.io.DataOutput;

import java.io.IOException; import org.apache.hadoop.io.DoubleWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.io.WritableComparable; /**

* 订单信息bean,实现hadoop的序列化机制

*/

public class OrderBean implements WritableComparable<OrderBean>{ private Text itemid;

private DoubleWritable amount; public OrderBean() {

} public OrderBean(Text itemid, DoubleWritable amount) {

set(itemid, amount); } public void set(Text itemid, DoubleWritable amount) { this.itemid = itemid;

this.amount = amount; } public Text getItemid() {

return itemid;

} public DoubleWritable getAmount() {

return amount;

}

//1.模型必须实现Comparable<T>接口

/*2.Collections.sort(list);会自动调用compareTo,如果没有这句,list是不会排序的,也不会调用compareTo方法

3.如果是数组则用的是Arrays.sort(a)方法*/

//implements WritableComparable必须要实现的方法,用于比较排序

@Override

public int compareTo(OrderBean o) {

//根據ID排序

int cmp = this.itemid.compareTo(o.getItemid());

//id相同根据金额排序

if (cmp == 0) {

cmp = -this.amount.compareTo(o.getAmount());

}

return cmp;

} @Override

public void write(DataOutput out) throws IOException {

out.writeUTF(itemid.toString());

out.writeDouble(amount.get());

} @Override

public void readFields(DataInput in) throws IOException {

String readUTF = in.readUTF();

double readDouble = in.readDouble(); this.itemid = new Text(readUTF);

this.amount= new DoubleWritable(readDouble);

} @Override

public String toString() {

return itemid.toString() + "\t" + amount.get();

}

}

自定义Partitioner用于分区

import org.apache.hadoop.io.NullWritable;

import org.apache.hadoop.mapreduce.Partitioner; public class ItemIdPartitioner extends Partitioner<OrderBean, NullWritable>{

@Override

public int getPartition(OrderBean bean, NullWritable value, int numReduceTasks) {

//相同id的订单bean,会发往相同的partition

//而且,产生的分区数,是会跟用户设置的reduce task数保持一致

return (bean.getItemid().hashCode() & Integer.MAX_VALUE) % numReduceTasks;

}

}

自定义GroupingComparator,在调用Reduce时对数据分组

package cn.bigdata.hdfs.secondarySort;

import org.apache.hadoop.io.WritableComparable;

import org.apache.hadoop.io.WritableComparator; /**

* 用于控制shuffle过程中reduce端对kv对的聚合逻辑

* 利用reduce端的GroupingComparator来实现将一组bean看成相同的key

*/

public class ItemidGroupingComparator extends WritableComparator { //传入作为key的bean的class类型,以及制定需要让框架做反射获取实例对象

protected ItemidGroupingComparator() {

super(OrderBean.class, true);

} @Override

public int compare(WritableComparable a, WritableComparable b) {

OrderBean abean = (OrderBean) a;

OrderBean bbean = (OrderBean) b;

//将item_id相同的bean都视为相同,从而聚合为一组

//比较两个bean时,指定只比较bean中的orderid

return abean.getItemid().compareTo(bbean.getItemid());

}

}

编写mapreduce处理流程

/**

* Order_0000001,Pdt_01,222.8

* Order_0000001,Pdt_05,25.8

* Order_0000002,Pdt_05,325.8

* Order_0000002,Pdt_03,522.8

* Order_0000002,Pdt_04,122.4

* Order_0000003,Pdt_01,222.8

*/

public class SecondarySort { static class SecondarySortMapper extends Mapper<LongWritable, Text, OrderBean, NullWritable>{ OrderBean bean = new OrderBean();

@Override

protected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException { String line = value.toString();

String[] fields = StringUtils.split(line, ","); bean.set(new Text(fields[0]), new DoubleWritable(Double.parseDouble(fields[2]))); context.write(bean, NullWritable.get());

}

} static class SecondarySortReducer extends Reducer<OrderBean, NullWritable, OrderBean, NullWritable>{ //到达reduce时,相同id的所有bean已经被看成一组,且金额最大的那个排在第一位

//在设置了groupingcomparator以后,这里收到的kv数据就是: <1001 87.6>,null <1001 76.5>,null ....

//此时,reduce方法中的参数key就是上述kv组中的第一个kv的key:<1001 87.6>

//要输出同一个item的所有订单中最大金额的那一个,就只要输出这个key

@Override

protected void reduce(OrderBean key, Iterable<NullWritable> values, Context context) throws IOException, InterruptedException {

context.write(key, NullWritable.get());

}

} public static void main(String[] args) throws Exception { Configuration conf = new Configuration();

Job job = Job.getInstance(conf); job.setJarByClass(SecondarySort.class); job.setMapperClass(SecondarySortMapper.class);

job.setReducerClass(SecondarySortReducer.class); job.setOutputKeyClass(OrderBean.class);

job.setOutputValueClass(NullWritable.class); FileInputFormat.setInputPaths(job, new Path("F:/secondary"));

FileOutputFormat.setOutputPath(job, new Path("F:/secondaryOut")); //在此设置自定义的Groupingcomparator类

job.setGroupingComparatorClass(ItemidGroupingComparator.class);

//在此设置自定义的partitioner类

job.setPartitionerClass(ItemIdPartitioner.class);

//设置Reduce的数量

job.setNumReduceTasks(2);

job.waitForCompletion(true);

}

}

文件:

Order_0000001,Pdt_01,222.8

Order_0000001,Pdt_05,25.8

Order_0000002,Pdt_05,325.8

Order_0000002,Pdt_03,522.8

Order_0000002,Pdt_04,122.4

Order_0000003,Pdt_01,222.8

Hadoop_26_MapReduce_Reduce端使用GroupingComparator求同一订单中最大金额的订单的更多相关文章

- MapReduce案例:统计共同好友+订单表多表合并+求每个订单中最贵的商品

案例三: 统计共同好友 任务需求: 如下的文本, A:B,C,D,F,E,OB:A,C,E,KC:F,A,D,ID:A,E,F,LE:B,C,D,M,LF:A,B,C,D,E,O,MG:A,C,D,E ...

- 【MM系列】SAP MM模块-控制采购订单中某些项目的输出显示

公众号:SAP Technical 本文作者:matinal 原文出处:http://www.cnblogs.com/SAPmatinal/ 原文链接:[MM系列]SAP MM模块-控制采购订单中某些 ...

- GPU端到端目标检测YOLOV3全过程(中)

GPU端到端目标检测YOLOV3全过程(中) 计算机视觉初级部分知识体系 总结了一下自己在计算机视觉初级部分的知识框架,整理如下. 个人所学并不全面( ...

- Luffy之结算订单页面(订单模型表的创建,订单的生成,以及订单详情展示等)

订单页面 在前面我们已经构建了,购物车的页面,接下来到了结算页面 1.首先,在购物车页面点击去结算按钮时,我们需要做如下动作 .前端发送生成订单的请求,点击标签内触发事件 create_order t ...

- Oracle EBS客户化程序中格式化金额

在Oracle EBS系统中,随处可见金额的显示格式,通常情况下都具有千分位符,同时有一定位数的精度,让我们先来看看一些现成的例子 上面这些列子中的金额都显示了千分位符,同时具备以2位小数,难道 ...

- Java订单号生成,唯一订单号(日均千万级别不重复)

Java订单号生成,唯一订单号 相信大家都可以搜索到很多的订单的生成方式,不懂的直接百度.. 1.订单号需要具备以下几个特点. 1.1 全站唯一性. 1.2 最好可读性. 1.3 随机性,不能重复,同 ...

- 微信公众号支付JSAPI网页,total_fee错误不正确,header重定向参数丢失,无法获取订单号和金额解决

微信公众号支付官方demo错误, 公众号支付只能用在微信里,也就是微信内部浏览器. 1.到WxPayHubHelper.php文件 JsApi_pub()类下createOauthUrlForCode ...

- js中进行金额计算

js中进行金额计算parseFloat 在js中进行以元为单位进行金额计算时 使用parseFloat会产生精度问题var price = 10.99;var quantity = 7;var n ...

- 为什么S/4HANA的销售订单创建会触发生产订单的创建

调用S/4HANA销售订单创建函数SD_SALES_DOCU_MAINTAIN创建一个销售订单时,会触发生产订单的创建. 销售订单的每个行项目对应一个独立的生产订单,SD_SALES_DOCU_MAI ...

随机推荐

- 解决 nginx 单点问题的方案【h】

一.问题域 nginx.lvs.keepalived.f5.DNS轮询,每每提到这些技术,往往讨论的是接入层的这样几个问题: 1)可用性:任何一台机器挂了,服务受不受影响 2)扩展性:能否通过增加机器 ...

- ssl证书泛域名

certbot certonly -d *.example.com --manual --preferred-challenges dns --server https://acme-v02.api. ...

- 【MOOC课程学习记录】数据结构

看了中国大学MOOC zju的<数据结构>2019夏的第九次开课.做了一些PTA上的习题,没有全做,因为做得慢,老是不会,加上并不能做到一有空就学习,所以做不完了,给跪了Orz. 以后有时 ...

- twig 模板控制器对应列表

{{ render(controller(metas.header,{request:app.request, course: course, member: member|default(null) ...

- [CF132C] Logo Turtle

[CF132C] Logo Turtle , Luogu A turtle moves following by logos.(length is \(N\)) \(F\) means "m ...

- Pebbles HDU 2167

Pebbles HDU 2167 大意:给定一个N*N的方格,让你在里面取出一些数使其和最大,要求每一个数不能与其相邻的8个数同时取出. 思路:和炮兵阵地那一题有点像,但我们只需要考虑上一行的情况,这 ...

- FGL内置函数大全

内置功能摘要: 内置的功能是什么?内置的功能列表支持的功能列表键代码表另请参阅:效用函数,变量,函数,操作符,内置类. ---------------------------------------- ...

- VNote: 一个舒适的Markdown笔记软件

Update: 支持macOSYunpan Update 2: 写在VNote半周岁 QQ群(487756074) Markdown标记语言一直是许多程序员的最爱.目前,有许多优秀的Markdown编 ...

- 怎样在浏览器端增加一条Cookie

可以使用 document.cookie, 这个属性可读可写, 读时是读取所有没有设置HttpOnly的cookie作为一个字符串返回, 写时是将一个cookie写入到document.cookie中 ...

- RedHat7 配置yum源

今天需要搭建一个测试环境,没办法只能找了个Linux服务器,但是之前的其他同事弄过是其他系统的,不是centos的,所以只能自己搞. 合计直接百度,怎么安装docker,结果一直报错,下载失败之类的 ...