flume从log4j收集日志输出到kafka

1. flume安装

(1)下载:wget http://archive.cloudera.com/cdh5/cdh/5/flume-ng-1.6.0-cdh5.7.1.tar.gz

(2)解压:tar zxvf flume-ng-1.6.0-cdh5.7.1.tar.gz

(3)环境变量:

export FLUME_HOME=/xxx/soft/apache-flume-1.6.0-cdh5.7.1-bin

export PATH=$PATH:$FLUME_HOME/bin

source /etc/profile

vim conf/flume-env.sh

export JAVA_HOME=/letv/soft/java

export HADOOP_HOME=/etc/hadoop

(4)创建avro.conf

vim conf/avro.conf a1.sources=source1

a1.channels=channel1

a1.sinks=sink1 a1.sources.source1.type=avro

a1.sources.source1.bind=10.112.28.240

a1.sources.source1.port=4141

a1.sources.source1.channels = channel1 a1.channels.channel1.type=memory

a1.channels.channel1.capacity=10000

a1.channels.channel1.transactionCapacity=1000

a1.channels.channel1.keep-alive=30 a1.sinks.sink1.type = org.apache.flume.sink.kafka.KafkaSink

a1.sinks.sink1.topic = hdtest.topic.jenkin.com

a1.sinks.sink1.brokerList = 10.11.97.57:9092,10.11.97.58:9092,10.11.97.60:9092

a1.sinks.sink1.requiredAcks = 0

a1.sinks.sink1.sink.batchSize = 20

a1.sinks.sink1.channel = channel1

source1.bind:flume安装的服务器

sink1.brokerList:kafka集群

sink1.topic:发往kafka的topic

(5)运行flume:

flume-ng agent --conf /xxx/soft/apache-flume-1.6.0-cdh5.7.1-bin/conf --conf-file /xxx/soft/apache-flume-1.6.0-cdh5.7.1-bin/conf/avro.conf --name a1 -Dflume.root.logger=INFO,console

2. 编写日志生产程序

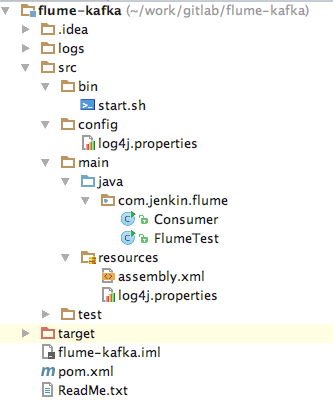

(1)工程结构

2. log4j.properties

log4j.rootLogger=INFO,console # for package com.demo.kafka, log would be sent to kafka appender.

log4j.logger.com.demo.flume=info,stdout,file,flume ### flume ###

log4j.appender.flume = org.apache.flume.clients.log4jappender.Log4jAppender

log4j.appender.flume.Hostname = 10.112.28.240

log4j.appender.flume.Port = 4141

log4j.appender.flume.UnsafeMode = true

log4j.appender.flume.layout=org.apache.log4j.PatternLayout

log4j.appender.flume.layout.ConversionPattern=%d{yyyy-MM-dd HH:mm:ss} %p [%c:%L] - %m%n # appender console

log4j.appender.console=org.apache.log4j.ConsoleAppender

log4j.appender.console.target=System.out

log4j.appender.console.layout=org.apache.log4j.PatternLayout

log4j.appender.console.layout.ConversionPattern=%d [%-5p] [%t] - [%l] %m%n ### file ###

log4j.appender.file=org.apache.log4j.DailyRollingFileAppender

log4j.appender.file.Threshold=INFO

log4j.appender.file.File=./logs/tracker/tracker.log

log4j.appender.file.Append=true

log4j.appender.file.DatePattern='.'yyyy-MM-dd

log4j.appender.file.layout=org.apache.log4j.PatternLayout

log4j.appender.file.layout.ConversionPattern=%d{yyyy-MM-dd HH:mm:ss} %c{1} [%p] %m%n ### stdout ###

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.Threshold=INFO

log4j.appender.stdout.Target=System.out

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d{yyyy-MM-dd HH:mm:ss} %c{1} [%p] %m%n

配置解释:flume服务器运行在10.112.28.240上,并且监听的端口为4141,在log4j中只需要将日志发送到10.112.28.240的4141端口就能成功的发送到flume上。flume会监听并收集该端口上的数据信息,然后将它转化成kafka event,并发送到kafka集群hdtest.topic.jenkin.com topic下。

3. 日志生产者

public class FlumeTest {

private static final Logger LOGGER = Logger.getLogger(FlumeTest.class);

public static void main(String[] args) throws InterruptedException {

for (int i = 20; i < 100; i++) {

LOGGER.info("Info [" + i + "]");

Thread.sleep(1000);

}

}

}

4. kafka日志消费者

public class Consumer {

public static void main(String[] args) {

System.out.println("begin consumer");

connectionKafka();

System.out.println("finish consumer");

}

@SuppressWarnings("resource")

public static void connectionKafka() {

Properties props = new Properties();

props.put("bootstrap.servers", "10.11.97.57:9092,10.11.97.58:9092,10.11.97.60:9092");

props.put("group.id", "testConsumer");

props.put("enable.auto.commit", "true");

props.put("auto.commit.interval.ms", "1000");

props.put("session.timeout.ms", "30000");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

consumer.subscribe(Arrays.asList("hdtest.topic.jenkin.com"));

while (true) {

ConsumerRecords<String, String> records = consumer.poll(100);

try {

Thread.sleep(2000);

} catch (InterruptedException e) {

e.printStackTrace();

}

for (ConsumerRecord<String, String> record : records) {

System.out.printf("===================offset = %d, key = %s, value = %s", record.offset(), record.key(),

record.value());

}

}

}

}

flume从log4j收集日志输出到kafka的更多相关文章

- 解决tomcat下面部署多个项目log4j的日志输出会集中输出到一个项目中的问题

在一次项目上线后,发现了一个奇怪的问题,经过对源码的阅读调试终于解决,具体经过是这样的: 问题描述:tomcat7下面部署多个项目,log4j的日志输出会集中输出到一个项目中,就算配置了日志文件的绝对 ...

- 《手把手教你》系列基础篇(八十六)-java+ selenium自动化测试-框架设计基础-Log4j实现日志输出(详解教程)

1.简介 自动化测试中如何输出日志文件.任何软件,都会涉及到日志输出.所以,在测试人员报bug,特别是崩溃的bug,一般都要提供软件产品的日志文件.开发通过看日志文件,知道这个崩溃产生的原因,至少知道 ...

- log4j 配置日志输出(log4j.properties)

轉: https://blog.csdn.net/qq_29166327/article/details/80467593 一.入门log4j实例 1.1 下载解压log4j.jar(地址:http: ...

- log4j分离日志输出 自定义过滤 自定义日志文件

普通的log4j.properties 定义: ### set log levels ### log4j.rootLogger = debug,D,E ## Disable other log log ...

- Flume用来收集日志,zeppelin用来展示

Flume:Flume是一个分布式,可依赖的,用于高效率的收集.聚类.移动大量数据的服务.Flume使用基于流数据的简单而且可扩展的架构.由于拥有可调的依赖机制和许多故障恢复机制,Flume是健壮而且 ...

- log4j将日志输出到控制台,文件,邮件

#将日志写到文件 log4j.appender.file=org.apache.log4j.DailyRollingFileAppender log4j.appender.file.File=e\:\ ...

- log4j 设置日志输出文件的路径

log4j.rootLogger=debug, A1 #输出到指定目录下 og4j.appender.A1.File=/log.log #输出到tomcat容器下的指定目录 log4j.appende ...

- 使用Log4J收集日志

一:搭建好Selenium+testNG+Maven环境,可参考 http://www.cnblogs.com/hc1020/p/8602863.html 二:百度搜索Maven仓库,然后搜索Log4 ...

- log4j。日志输出

log4j.rootLogger = debug , stdout , D , E log4j.appender.stdout = org.apache.log4j.ConsoleAppender l ...

随机推荐

- 如何让listview滚动到底部

方法一: // msgListView是ListView控件 // adapter是ListView绑定的Adapter,如果不方便直接使用,也可以通过ListView的getAdapter()方法获 ...

- HDU 4605 Magic Ball Game(可持续化线段树,树状数组,离散化)

Magic Ball Game Time Limit: 10000/5000 MS (Java/Others) Memory Limit: 65536/65536 K (Java/Others) ...

- FZU Moon Game(几何)

Accept: 710 Submit: 2038 Time Limit: 1000 mSec Memory Limit : 32768 KB Problem Description Fa ...

- 关于Springboot 中注入多个cacheManage 时候 存在报错

Caused by: org.springframework.beans.factory.BeanCreationException: Error creating bean with name 'e ...

- iOS中navigationItem修改标题的颜色

UIColor * color = [UIColor redColor];//这里我们设置的是颜色,NSDictionary * dict = [NSDictionary dictionaryWith ...

- MySQL给一个字段递增赋值

https://blog.csdn.net/kriszhang/article/details/72125203 首先设置一个变量,初始值为0: set @r:=0; 1 然后更新表中对应的ID列: ...

- 剑指Offer——链表中环的入口结点

题目描述: 一个链表中包含环,请找出该链表的环的入口结点. 分析: 设置两个指针p1,p2, 两个指针都从链表的头部开始走,不过p1每次走一步,p2每次走两步. 直到相遇的时候,p2走的长度是p1的两 ...

- Apache的访问控制

目录配置段 注释不能写在指令后面,下面这样是不行的,应当换行,但为了阅读方便我就这么写了 Alias /dir/ "/var/www/html/admin" #路径 ...

- LInux进程虚拟地址空间的管理

2017-04-07 脱离物理内存的管理,今天咱们来聊聊进程虚拟内存的管理.因为进程直接分配和使用的都是虚拟内存,而物理内存则是有系统“按需”分配给进程,在进程看来,只知道虚拟内存的存在! 前言: 关 ...

- Python标准库 之 turtle(海龟绘图)

turtle库介绍 首先,turtle库是一个点线面的简单图像库(也被人们成为海龟绘图),在Python2.6之后被引入进来,能够完成一些比较简单的几何图像可视化.它就像一个小乌龟,在一个横轴为x.纵 ...