5.安装hbase

下载安装包并解压

https://mirrors.tuna.tsinghua.edu.cn/apache/hbase/1.3.1/hbase-1.3.1-bin.tar.gz

…..

[hbase@hadoop1 opt]$ tar -zxvf hbase-1.3.1-bin.tar.gz

设置hbase环境变量

[hbase@hadoop1 opt]$ cd hbase-1.3.1/conf/

[hbase@hadoop1 conf]$ vi hbase-env.sh

#### 看情况设置以下环境变量:

#export JAVA_HOME=/usr/java/jdk1.6.0/

#export HBASE_HEAPSIZE=1G #堆内存

#export HBASE_OPTS="-XX:+UseConcMarkSweepGC" #jvm启动参数

#export HBASE_MASTER_OPTS="$HBASE_MASTER_OPTS -XX:PermSize=128m -XX:MaxPermSize=128m" #hmaster

#export HBASE_REGIONSERVER_OPTS="$HBASE_REGIONSERVER_OPTS -XX:PermSize=128m -XX:MaxPermSize=128m" #hregionserver

# export SERVER_GC_OPTS="-verbose:gc -XX:+PrintGCDetails -XX:+PrintGCDateStamps" #gc相关

# export SERVER_GC_OPTS="-verbose:gc -XX:+PrintGCDetails -XX:+PrintGCDateStamps -Xloggc:<FILE-PATH> -XX:+UseGCLogFileRotation -XX:NumberOfGCLogFiles=1 -XX:GCLogFileSize=512M" #java 参数不太懂,自行修正

…………….

https://mirrors.tuna.tsinghua.edu.cn/apache/hbase/1.3.1/hbase-1.3.1-bin.tar.gz

…..

[hbase@hadoop1 opt]$ tar -zxvf hbase-1.3.1-bin.tar.gz

[hbase@hadoop1 opt]$ cd hbase-1.3.1/conf/

[hbase@hadoop1 conf]$ vi hbase-env.sh

#### 看情况设置以下环境变量:

#export JAVA_HOME=/usr/java/jdk1.6.0/

#export HBASE_HEAPSIZE=1G #堆内存

#export HBASE_OPTS="-XX:+UseConcMarkSweepGC" #jvm启动参数

#export HBASE_MASTER_OPTS="$HBASE_MASTER_OPTS -XX:PermSize=128m -XX:MaxPermSize=128m" #hmaster

#export HBASE_REGIONSERVER_OPTS="$HBASE_REGIONSERVER_OPTS -XX:PermSize=128m -XX:MaxPermSize=128m" #hregionserver

# export SERVER_GC_OPTS="-verbose:gc -XX:+PrintGCDetails -XX:+PrintGCDateStamps" #gc相关

# export SERVER_GC_OPTS="-verbose:gc -XX:+PrintGCDetails -XX:+PrintGCDateStamps -Xloggc:<FILE-PATH> -XX:+UseGCLogFileRotation -XX:NumberOfGCLogFiles=1 -XX:GCLogFileSize=512M" #java 参数不太懂,自行修正

…………….参数较多,请逐个检查.

最重要的就是JAVA_HOME,但我在/etc/profile里设置了,这里就不管了.

由于是做实验,这里我就设置一下log目录.关于hbase-evn.sh的设置,以后会详细讲解.

export HBASE_LOG_DIR=/var/log/hbase/

注意:如果没有在/etc/profile中设置HADOOP_CONF_DIR,则需要在hbase-evn.sh中设置HADOOP_CONF_DIR,否则hbase读不到hdfs-site.xml,无法找到hdfs.或者将hdfs-site.xml复制到$HBASE_HOME/conf/下也行.这里的hdfs-site.xml用客户端的配置即可.

配置hbase-site.xml

<configuration>

<property>

<name>hbase.rootdir</name>

<value>hdfs://mycluster/hbase</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>hadoop3,hadoop4,hadoop5</value>

</property>

<property>

<name>hbase.zookeeper.property.dataDir</name>

<value>/hbase</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<name>HBASE_MANAGES_ZK</name>

<value>false</value>

</property>

</configuration>

<configuration>

<property>

<name>hbase.rootdir</name>

<value>hdfs://mycluster/hbase</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>hadoop3,hadoop4,hadoop5</value>

</property>

<property>

<name>hbase.zookeeper.property.dataDir</name>

<value>/hbase</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<name>HBASE_MANAGES_ZK</name>

<value>false</value>

</property>

</configuration>

上面的参数意思分别是:

hbase在hdfs的主目录

zookeeper服务器节点

hbase在zookeeper中的目录

hbase是否是分布式的

是否用hbase自带的zookeeper

启动hbase

首先使用hdfs账号为hbase授权:

[hdfs@hadoop2 root]$ hdfs dfs -mkdir /hbase

[hdfs@hadoop2 root]$ hdfs dfs -chown hbase:hbase /hbase在hadoop1上启动master:

[hbase@hadoop1 hbase-1.3.1]$ bin/hbase-daemon.sh start master在hadoop3 hadoop4 hadoop5上启动hreigonserver:

[hbase@hadoop3 hbase-1.3.1]$ bin/hbase-daemon.sh start regionserver在需要的节点上启动master备份节点:

bin/hbase-daemon.sh start master --backup检测hbase启动情况

1.jps检查

[hbase@hadoop1 hbase-1.3.1]$ jps

25914 HMaster

[hbase@hadoop3 hbase-1.3.1]$ jps

12623 HRegionServe看到master和regionserver都启动了

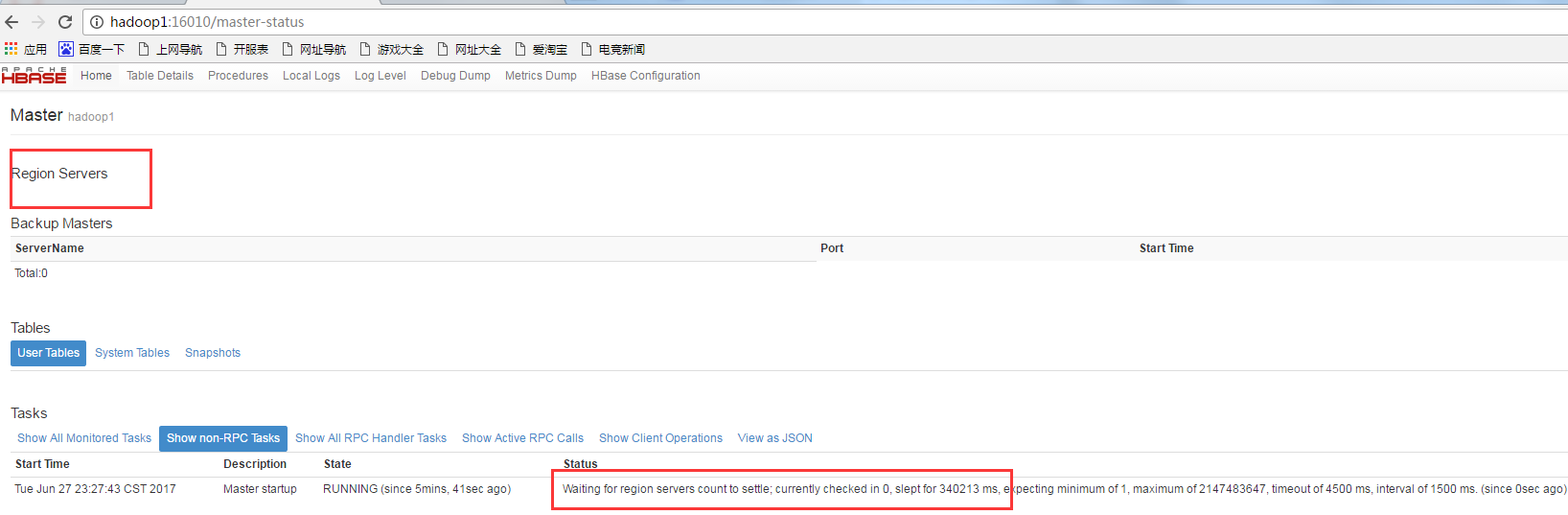

2.打开hbase web

打开:http://hadoop1:16010/

发现没有一个hregoinser连接上master!!!

好吧,打开/var/log/hbase/下的regionserver日志发现:

2017-06-27 23:16:51,039 FATAL [regionserver/hadoop3/192.168.0.12:16020] regionserver.HRegionServer: Master rejected startup because clock is out of sync

org.apache.hadoop.hbase.ClockOutOfSyncException: org.apache.hadoop.hbase.ClockOutOfSyncException: Server hadoop3,16020,1498576600617 has been rejected; Reported time is too far out of sync with master. Time difference of 54158ms > max allowed of 30000ms

at org.apache.hadoop.hbase.master.ServerManager.checkClockSkew(ServerManager.java:410)

at org.apache.hadoop.hbase.master.ServerManager.regionServerStartup(ServerManager.java:276)

at org.apache.hadoop.hbase.master.MasterRpcServices.regionServerStartup(MasterRpcServices.java:363)

at org.apache.hadoop.hbase.protobuf.generated.RegionServerStatusProtos$RegionServerStatusService$2.callBlockingMethod(RegionServerStatusProtos.java:8615)

at org.apache.hadoop.hbase.ipc.RpcServer.call(RpcServer.java:2339)

at org.apache.hadoop.hbase.ipc.CallRunner.run(CallRunner.java:123)

at org.apache.hadoop.hbase.ipc.RpcExecutor$Handler.run(RpcExecutor.java:188)

at org.apache.hadoop.hbase.ipc.RpcExecutor$Handler.run(RpcExecutor.java:168)

at sun.reflect.NativeConstructorAccessorImpl.newInstance0(Native Method)

at sun.reflect.NativeConstructorAccessorImpl.newInstance(NativeConstructorAccessorImpl.java:57)

at sun.reflect.DelegatingConstructorAccessorImpl.newInstance(DelegatingConstructorAccessorImpl.java:45)

at java.lang.reflect.Constructor.newInstance(Constructor.java:526)

at org.apache.hadoop.ipc.RemoteException.instantiateException(RemoteException.java:106)

at org.apache.hadoop.ipc.RemoteException.unwrapRemoteException(RemoteException.java:95)

at org.apache.hadoop.hbase.protobuf.ProtobufUtil.getRemoteException(ProtobufUtil.java:332)

at org.apache.hadoop.hbase.regionserver.HRegionServer.reportForDuty(HRegionServer.java:2337)

at org.apache.hadoop.hbase.regionserver.HRegionServer.run(HRegionServer.java:929)

at java.lang.Thread.run(Thread.java:745)

Caused by: org.apache.hadoop.hbase.ipc.RemoteWithExtrasException(org.apache.hadoop.hbase.ClockOutOfSyncException): org.apache.hadoop.hbase.ClockOutOfSyncException: Server hadoop3,16020,1498576600617 has been rejected; Reported time is too far out of sync with master. T

ime difference of 54158ms > max allowed of 30000ms

at org.apache.hadoop.hbase.master.ServerManager.checkClockSkew(ServerManager.java:410)

at org.apache.hadoop.hbase.master.ServerManager.regionServerStartup(ServerManager.java:276)原因是regionser和master的时间差太多了!又检查了一下,发现机器上的ntp服务挂了!!

设置各机器的时间:

date -s '2017-07-06 21:36:40'再次启动各进程,打开web页面,发现连接上master了:

测试hbase shell

[hbase@hadoop5 hbase-1.3.1]$ bin/hbase shell

hbase(main):001:0> create 'test','cf1'

0 row(s) in 4.9050 seconds

=> Hbase::Table - test

hbase(main):002:0> list

TABLE

test

hbase(main):004:0> put 'test', 'row1', 'cf1:a', 'value1'

0 row(s) in 0.0170 seconds

hbase(main):005:0> put 'test', 'row2', 'cf1:b', 'value2'

0 row(s) in 0.0090 seconds

hbase(main):012:0* scan test

ArgumentError: wrong number of arguments (0 for 2)

hbase(main):013:0> scan 'test'

ROW COLUMN+CELL

row1 column=cf1:a, timestamp=1499349174471, value=value1

row2 column=cf1:b, timestamp=1499349174533, value=value2

2 row(s) in 0.1140 seconds

[hbase@hadoop5 hbase-1.3.1]$ bin/hbase shell

hbase(main):001:0> create 'test','cf1'

0 row(s) in 4.9050 seconds

=> Hbase::Table - test

hbase(main):002:0> list

TABLE

test

hbase(main):004:0> put 'test', 'row1', 'cf1:a', 'value1'

0 row(s) in 0.0170 seconds

hbase(main):005:0> put 'test', 'row2', 'cf1:b', 'value2'

0 row(s) in 0.0090 seconds

hbase(main):012:0* scan test

ArgumentError: wrong number of arguments (0 for 2)

hbase(main):013:0> scan 'test'

ROW COLUMN+CELL

row1 column=cf1:a, timestamp=1499349174471, value=value1

row2 column=cf1:b, timestamp=1499349174533, value=value2

2 row(s) in 0.1140 seconds

说明hbase能正常使用

5.安装hbase的更多相关文章

- 安装HBase

安装HBase 1.默认已经安装好java+hadoop+zookeeper 2.下载对应版本的HBase 3.解压安装包 tar zxvf hbase-1.0.2-bin.tar.gz 4.配置环境 ...

- Mac下安装HBase及详解

Mac下安装HBase及详解 1. 千篇一律的HBase简介 HBase是Hadoop的数据库, 而Hive数据库的管理工具, HBase具有分布式, 可扩展及面向列存储的特点(基于谷歌BigTabl ...

- Hbase深入学习(二) 安装hbase

Hbase深入学习(二) 安装hbase This guidedescribes setup of a standalone hbase instance that uses the local fi ...

- CentOS7 安装Hbase集群

继续接上一章,已安装好Hadoop集群环境 http://www.cnblogs.com/dopeter/p/4612232.html 在此基础上继续安装Hbase集群 Hbase版本为1.0.1.1 ...

- Ubuntu 12.04上安装HBase并运行

Ubuntu 12.04上安装HBase并运行 作者:凯鲁嘎吉 - 博客园 http://www.cnblogs.com/kailugaji/ 一.HBase的安装 在官网上下载HBase-1.1.2 ...

- hadoop安装hbase

1.安装hadoop hadoop安装请参考我的centoos 安装hadoop集群 在安装hadoop的基础上新增了两台slave机器,新增后的配置为 H30(192.168.3.238) mast ...

- 通过tarball形式安装HBASE Cluster(CDH5.0.2)——Hadoop NameNode HA 切换引起的Hbase错误,以及Hbase如何基于NameNode的HA进行配置

通过tarball形式安装HBASE Cluster(CDH5.0.2)——Hadoop NameNode HA 切换引起的Hbase错误,以及Hbase如何基于NameNode的HA进行配置 配置H ...

- Windows下安装HBase

本文转载自:http://blog.csdn.net/kangkanglou/article/details/30748139 本文主要参照Hbase官网:http://hbase.apache.or ...

- 沉淀,再出发——在Hadoop集群之上安装hbase

在Hadoop集群之上安装hbase 一.安装准备 首先我们确保在ubuntu16.04上安装了以下的产品,java1.8及其以上,ssh,hadoop集群,其次,我们需要从hbase的官网上下载并安 ...

- HBase伪分布式安装(HDFS)+ZooKeeper安装+HBase数据操作+HBase架构体系

HBase1.2.2伪分布式安装(HDFS)+ZooKeeper-3.4.8安装配置+HBase表和数据操作+HBase的架构体系+单例安装,记录了在Ubuntu下对HBase1.2.2的实践操作,H ...

随机推荐

- 大专生自学iOS到找到工作的前前后后

先做个自我介绍,我13年考上一所很烂专科民办的学校,学的是生物专业,具体的学校名称我就不说出来献丑了.13年我就辍学了,我在那样的学校,一年学费要1万多,但是根本没有人学习,我实在看不到希望,我就退学 ...

- 常见web漏洞

常见的web漏洞——文件上传漏洞 一.文件上传漏洞概述 文件上传漏洞是指用户上传了一个可执行的脚本文件,并通过此脚本文件获得了执行服务器端命令的能力.这种攻击方式是最为直接和有效的,有时候几乎没 ...

- ie 兼容

ese,promise解决text/babel <script src="https://cdnjs.cloudflare.com/ajax/libs/babel-polyfill/7 ...

- Folyd + 路径存储

一.Folyd 算法原理 如果 AB + AC < BC 那么, BC最短路就要经过 A. 在算法进行过程中,应该是 ,B-A 有很多路径,B 代表这些路径权值之和,A-C也有很多路径,C是这些 ...

- 解决 LLVM 错误提示 may only occur zero or one times!

使用 LLVM 混淆器添加参数进行编译提示如下错误:clang (LLVM option parsing): for the -bcf option: may only occur zero or o ...

- python爬虫学习笔记(1)

一.请求一个网页内容打印 爬取某个网页: from urllib import request # 需要爬取的网页 url = "https://mbd.baidu.com/newspage ...

- 类型“Observable<Response>”上不存在属性“map”

出错提示: angular2 Property 'map' does not exist on type 'Observable<Response>' 类型“Observable<R ...

- 二、linux编译环境的搭建

1.linux编译工具安装 vim安装:apt-get install vim 注意:使用C语言源代码语法加亮功能,需要配置文件/etc/vim/vimrc,加入代码syntaxon.文件后缀必须为. ...

- 微信小程序登录以及注册用户信息得到token

先来一张登录时序图 总的大概就是 通过调用wx.login得到code 请求small_session获得sessionid 微信wx.getUserInfo获得encryptedData和iv 通过 ...

- Java学习笔记二十八:Java中的接口

Java中的接口 一:Java的接口: 接口(英文:Interface),在JAVA编程语言中是一个抽象类型,是抽象方法的集合,接口通常以interface来声明.一个类通过继承接口的方式,从而来继承 ...