node爬虫 -- 网页图片

相信大家都听说过爬虫,我们也听说过Python是可以很方便地爬取网络上的图片, 但是奈何本人不会Python,就只有通过 Node 来实践一下了。

接下来看我如何 板砖 ! !!

接下来看我如何 板砖 ! !!

01 前言

何谓爬虫

其实爬虫用很官方的语言来描述就是“自动化浏览网络程序”,我们不用手动去点击、去下载一些文章或者图片。大家或许用过抢票软件,其实就是不断地通过软件访问铁路官方的接口,达到抢票的效果。但是,这类抢票软件是违法的。

那么怎么判断爬虫是不是违法呢?关于爬虫是否非法其实没有很明确的说法,一直都是中立的态度。爬虫是一种技术,技术本身没有违法的。但是你使用这种技术去爬取不正当的信息、有版权的图片等用于商用,那么你就是违法了。其实我们只要在使用爬虫技术的时候不要去爬个人隐私信息,不要爬取有版权的图片,最重要的是信息不要用于商业化的行为,爬虫不得干扰网站的正常运行等。

说了这么多其实就是要大家谨慎使用这一项技术。

02 Node 基本思路

怎么爬

一:首先我们用的模块有以下几个:

- http || https ( 记不清的请点击 node官网 https://nodejs.org/dist/latest-v15.x/docs/api/http2.html)

- cheerio ( node 模块,和前端 jq用法 基本一摸一样 )

- download ( 下载图片 模块 )

二:基本思路

1. 示例网址 :https://view.inews.qq.com/w2/20200820A0AZTM00

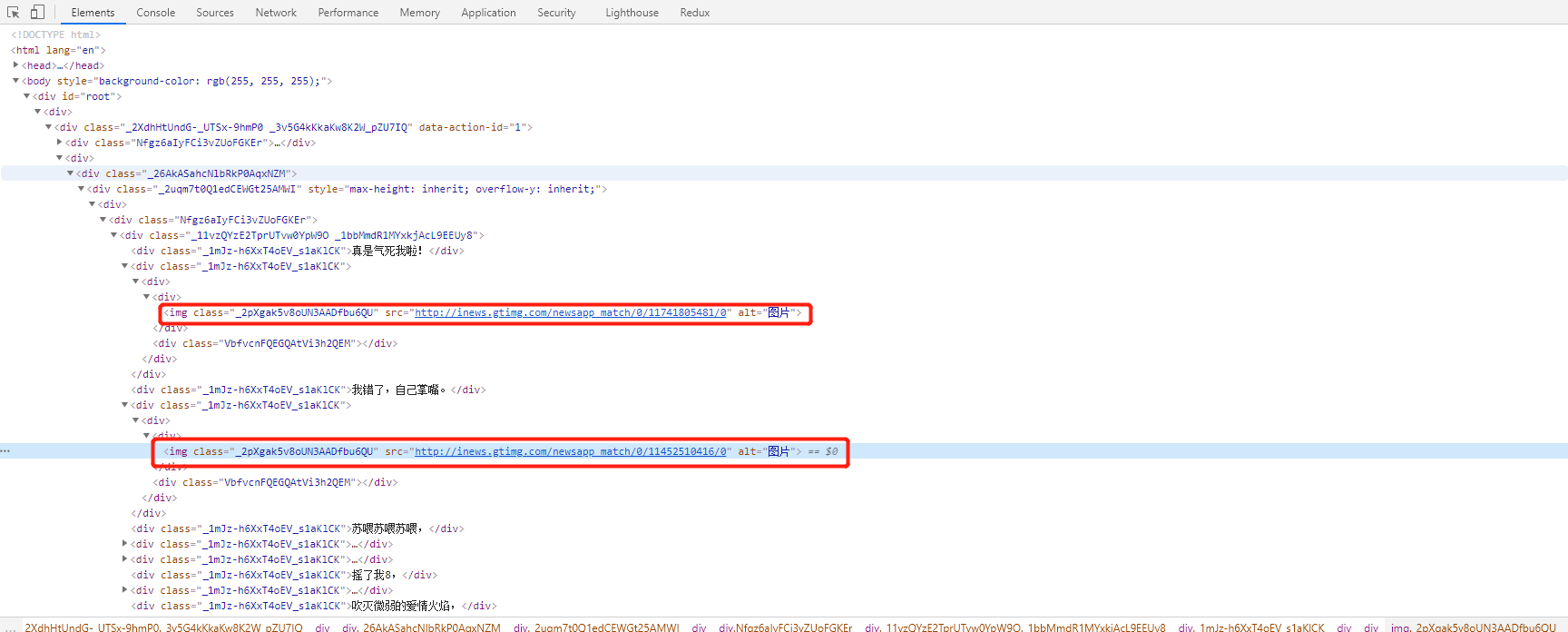

2.通过 F12 查看 网页结构

1)

2) 查询网页规律 div > img

3.右键 查看网页源码源代码

1) 如果源代码 和 网页内容一样,基本是服务端渲染

a. 通过cheerio 模块,直接操作,获取dom

2) 如果源代码 和 网页内容不一样,基本是前端渲染

a. 需要查看 network 的XHR,返回的json数据

4. 下载图片

1)通过request 获取网页内容

2)cheerio 转换,获取页面内容

3)通过 download () 加载每一条 img src 的网络请求,保存到本地

03 Node 贴代码

let https = require('https'); // https 安全协议请求

let fs = require('fs'); // fs 文件读写模块, 未用到,可以忽略。

let cheerio = require('cheerio'); // cheerio 获取的数据转换 为 html 模块

let download = require('download'); // 下载 图片的 模块

let url = 'https://view.inews.qq.com/w2/20200820A0AZTM00'; // 测试地址

// 函数内部的 步骤

function http_request (url) {

// 1. https.request() 只是创建请求 ,没有发送请求

// 2. app.end() 调用实例对象end() 方法才会发送请求. ( 看倒数第三行)

// 3. res.on('data',()=>{}) 获取网页data ,存入一个数组 chunks

// 4. res.on('end',()=>{}) ( 看 具体 步骤)

let app = https.request(url, res => {

let chunks = [];

res.on('data', chunk => {

chunks.push(chunk)

})

res.on('end', () => {

let html = Buffer.concat(chunks).toString('utf-8'); //获取到的data ,是buffer 。 需要通过 Buffer.concat(数组).tostring('utf-8') 转换为 我们认识的html 文档

let $ = cheerio.load(html); // cheerio.load() 像使用jquery 使用方式一样

let imgArr = Array.prototype.map.call($('.random_picture a img'), (item) => $(item).data('backup')); // $('').arrr('') 像jq一样获取 img 的src,存入一个数组。

let check = imgArr.filter((item, index, arr) => { // 有些网页img src 未加载成功,所以,filter 过滤掉 值 == undefined

return item != undefined

})

Promise.all(check.map(x => download(x, 'zhinan' + i))).then((res) => { // promise.all( x =>download( x, '保存文件的name' )) promisr.all 发送多个异步请求,

// download( ) ,第一个参数:当前请求的 x ,就是数组每一项,第二个参数: 当前保存文件的 名字

console.log('success file', check.length)

}).catch((err) => {

console.log(err)

})

})

})

app.end();

}

http_request(url)

node爬虫 -- 网页图片的更多相关文章

- java简单web爬虫(网页图片)

java简单web爬虫(网页图片)效果,执行main()方法后图片就下载道C盘的res文件夹中.没有的话创建一个文件夹代码里的常量根据自己的需求修改,代码附到下面. package com.sinit ...

- Python爬虫 网页图片

一 概述 参考http://www.cnblogs.com/abelsu/p/4540711.html 弄了个Python捉取单一网页的图片,但是Python已经升到3+版本了.参考的已经失效,基本用 ...

- node爬虫之图片下载

背景:针对一些想换头像的玩家,而又不知道用什么头像的,作为一名代码爱好者,能用程序解决的,就不用程序来换头像,说干就干,然后就整理了一下. 效果图 环境配置 安装node环境 node -v node ...

- node:爬虫爬取网页图片

代码地址如下:http://www.demodashi.com/demo/13845.html 前言 周末自己在家闲着没事,刷着微信,玩着手机,发现自己的微信头像该换了,就去网上找了一下头像,看着图片 ...

- Node.js 网页爬虫再进阶,cheerio助力

任务还是读取博文标题. 读取app2.js // 内置http模块,提供了http服务器和客户端功能 var http=require("http"); // cheerio模块, ...

- Node.js 网页瘸腿稍强点爬虫再体验

这回爬虫走得好点了,每次正常读取文章数目总是一样的,但是有程序僵住了情况,不知什么原因. 代码如下: // 内置http模块,提供了http服务器和客户端功能 var http=require(&qu ...

- Node.js 网页瘸腿爬虫初体验

延续上一篇,想把自己博客的文档标题利用Node.js的request全提取出来,于是有了下面的初哥爬虫,水平有限,这只爬虫目前还有点瘸腿,请看官你指正了. // 内置http模块,提供了http服务器 ...

- Python爬虫之网页图片抓取

一.引入 这段时间一直在学习Python的东西,以前就听说Python爬虫多厉害,正好现在学到这里,跟着小甲鱼的Python视频写了一个爬虫程序,能实现简单的网页图片下载. 二.代码 __author ...

- Python3简单爬虫抓取网页图片

现在网上有很多python2写的爬虫抓取网页图片的实例,但不适用新手(新手都使用python3环境,不兼容python2), 所以我用Python3的语法写了一个简单抓取网页图片的实例,希望能够帮助到 ...

随机推荐

- 如何将 Dapper 换成 SqlSuagr ORM

为什么要写这篇文章 因数我看到很多人虽然用着SqlSugar,但是同时也用着Dapper,因为SqlSugar兼容了Dapper所有API,所以既然你用了SqlSugar那么就没有必要在同一个项目中使 ...

- Kubernetes 最佳安全实践指南

原文链接:https://fuckcloudnative.io/posts/security-best-practices-for-kubernetes-pods/ 对于大部分 Kubernetes ...

- 浅谈强连通分量(Tarjan)

强连通分量\(\rm (Tarjan)\) --作者:BiuBiu_Miku \(1.\)一些术语 · 无向图:指的是一张图里面所有的边都是双向的,好比两个人打电话 \(U ...

- python去除文件中重复的行

去除文件中重复的行 import os with open('db.txt','r',encoding='utf-8') as read_f,\ open('.db.txt.swap','w',enc ...

- MySQL误删除用户怎么解决

前言:在不考虑到原来用户对关联数据库的授权问题的情况下,有以下两种思路解决 #1.安全模式修改 第一步:关闭数据库服务: [root@db01 ~]#/etc/init.d/mysqld stop 第 ...

- java中读取word文档里的内容

package com.cn.peitest.excel.word; import java.io.FileInputStream; import java.io.FileOutputStream; ...

- San Francisco Crime Classification非数值性多分类问题

给出了旧金山以往犯罪活动的相关信息,预测特定条件下的犯罪情况 分析数据集和测试集信息: 训练集给出的信息有: 1.Dates:时间日期和时间,这里考虑时间对犯罪活动有影响,日期和下边的周几有相似处,取 ...

- JDBC访问数据库的基本步骤是什么?

1.加载(注册)数据库驱动(到JVM) 2.建立(获取)数据库连接. 3.创建(获取)数据库操作对象. 4.定义操作的SQL语句. 5.执行数据库操作. 6.获取并操作结果集. 7.关闭对象,回收数据 ...

- devops持续集成

目录 Devops 版本控制系统 Git安装 Git使用 git四种状态 git基础命令 git分支 git合并冲突 git标签 git命令总结 Github使用 创建仓库 HTTP协议 SSH协议 ...

- MMDetection 快速开始,训练自定义数据集

本文将快速引导使用 MMDetection ,记录了实践中需注意的一些问题. 环境准备 基础环境 Nvidia 显卡的主机 Ubuntu 18.04 系统安装,可见 制作 USB 启动盘,及系统安装 ...