kubeadm安装kubernetes(v18.8.8)

1. 前言

kubernetes版本更新迭代非常快,上一篇写kubernetes搭建时,版本还是v1.15.0,现在已经更新到v1.18。看kubernetes在github的官方仓库,8月14日小版本已经到了v1.18.8。本篇文章基于kubeadm搭建kubernetes v1.18.8版。

本篇文章与上篇文章几点不同之处:

1. 操作系统采用CentOS。

2. master采用单节点,如果要搭建多master高可用集群可以参考上篇文章。

3. 解决无法访问kubernetes官方容器镜像仓库问题,上篇文章直接从kubernetes官方拉取镜像。

4. docker加速,解决从dockerhub拉镜像慢问题。

5. kube-proxy开启ivps,使用ipvs替代iptables转发流量。

6. 给出了一些常见的错误及排错思路。

话不多说,那就直奔主题,走起~~~

2. 环境准备

| 机器名称 | 机器配置 | 机器系统 | IP地址 | 角色 |

| master1 | 2C4G | CentOS7.6 | 10.13.1.11 | 主节点 |

| node1 | 2C4G | CentOS7.6 | 10.13.1.15 | 工作节点1 |

| node2 | 2C4G | CentOS7.6 | 10.13.1.16 | 工作节点2 |

说明:

硬件配置要求:2C2G +;

操作系统要求:CentOS7 +

防火墙说明:如果使用的是云厂商的虚拟机,主节点安全组需放行tcp端口6443、2379-2380、10250-12025,工作节点安全组需放行tcp端口:10250、30000-32767

3. 实操过程

3.1 关闭防火墙和selinux

root@master1 ~]# systemctl stop firewalld

[root@master1 ~]# setenforce

[root@master1 ~]# sed -i 's/^SELINUX=.*/SELINUX=disabled/' /etc/selinux/config

3.2 关闭交换分区

root@master1 ~]# swapoff -a

永久关闭,修改/etc/fstab,注释掉swap一行

3.3 修改hosts文件

[root@master1 ~]# cat >> /etc/hosts << EOF

10.13.1.11 master1

10.13.1.15 node1

10.13.1.16 node2

3.4 时间同步

[root@master1 ~]# yum install chrony -y

[root@master1 ~]# systemctl start chronyd

[root@master1 ~]# systemctl enable chronyd

[root@master1 ~]# chronyc sources

3.5 修改内核参数

让iptables能查看桥接流量

[root@master1 ~]# cat > /etc/sysctl.d/k8s.conf << EOF

net.ipv4.ip_forward =

net.bridge.bridge-nf-call-ip6tables =

net.bridge.bridge-nf-call-iptables =

[root@master1 ~]# sysctl --system

3.6 加载ipvs模块

[root@master1 ~]# modprobe -- ip_vs

[root@master1 ~]# modprobe -- ip_vs_rr

[root@master1 ~]# modprobe -- ip_vs_wrr

[root@master1 ~]# modprobe -- ip_vs_sh

[root@master1 ~]# modprobe -- nf_conntrack_ipv4

[root@master1 ~]# lsmod | grep ip_vs

[root@master1 ~]# lsmod | grep nf_conntrack_ipv4

[root@master1 ~]# yum install -y ipvsadm

3.7 安装并配置docker

3.7.1 修改docker的yum源为阿里源

[root@master1 ~]# wget https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo -O /etc/yum.repos.d/docker-ce.repo

或者

[root@master1 ~]# yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

3.7.2 安装docker

[root@master1 ~]# yum install -y docker-ce

[root@master1 ~]# docker --version

[root@master1 ~]# systemctl enable docker

[root@master1 ~]# systemctl start docker

3.7.3 配置docker加速并修改驱动

网上有很多大佬无私地提供了一些dockerhub加速地址,可以选择几个使用。

[root@master1 ~]# cat /etc/docker/daemon.json

{

"exec-opts": ["native.cgroupdriver=systemd"],

"registry-mirrors": [

"https://1nj0zren.mirror.aliyuncs.com",

"https://kfwkfulq.mirror.aliyuncs.com",

"https://2lqq34jg.mirror.aliyuncs.com",

"https://pee6w651.mirror.aliyuncs.com",

"http://hub-mirror.c.163.com",

"https://docker.mirrors.ustc.edu.cn",

"http://f1361db2.m.daocloud.io",

"https://registry.docker-cn.com"

]

}

[root@master1 ~]# systemctl restart docker

[root@master1 ~]# docker info | grep "Cgroup Driver"

Cgroup Driver: systemd

kubernetes官方建议docker驱动采用systemd,当然可以不修改,只是kubeadm init时会有warning([WARNING IsDockerSystemdCheck]: detected "cgroupfs" as the Docker cgroup driver. The recommended driver is "systemd". Please follow the guide at https://kubernetes.io/docs/setup/cri/)可以忽略,生产环境建议修改,因为更稳定。

3.8 安装kubernents组件

3.8.1 配置kubernentes的yum源为阿里源

因为国内无法访问kubernents的官方yum源,所以需要修改

[root@master1 ~]# cat <<EOF | sudo tee /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=

gpgcheck=

repo_gpgcheck=

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

3.8.2 安装组件

[root@master1 ~]# yum -y install kubelet kubeadm kubectl

[root@master1 ~]# kubelet --version

Kubernetes v1.18.8

[root@master1 ~]# systemctl start kubelet

此时kubelet处于不断重启状态,因为集群还没有初始化,kubelet等待kubeadm初始化完成后运行状态正常。

3.9 初始化集群

3.9.1 查看初始化需要的镜像

[root@master1 ~]# kubeadm config images list

W0822 ::54.182176 configset.go:] WARNING: kubeadm cannot validate component configs for API groups [kubelet.config.k8s.io kubeproxy.config.k8s.io]

k8s.gcr.io/kube-apiserver:v1.18.8

k8s.gcr.io/kube-controller-manager:v1.18.8

k8s.gcr.io/kube-scheduler:v1.18.8

k8s.gcr.io/kube-proxy:v1.18.8

k8s.gcr.io/pause:3.2

k8s.gcr.io/etcd:3.4.-

k8s.gcr.io/coredns:1.6.

3.9.2 kubeadm init介绍

初始化集群需使用kubeadm init命令,可以指定具体参数初始化,也可以指定配置文件初始化。

可选参数:

--apiserver-advertise-address apiserver的监听地址,有多块网卡时需要指定

--apiserver-bind-port apiserver的监听端口,默认是6443

--cert-dir 通讯的ssl证书文件,默认/etc/kubernetes/pki

--control-plane-endpoint 控制台平面的共享终端,可以是负载均衡的ip地址或者dns域名,高可用集群时需要添加

--image-repository 拉取镜像的镜像仓库,默认是k8s.gcr.io

--kubernetes-version 指定kubernetes版本

--pod-network-cidr pod资源的网段,需与pod网络插件的值设置一致

--service-cidr service资源的网段

--service-dns-domain service全域名的后缀,默认是cluster.local

3.9.3 kubeadm指定具体参数初始化

因为以上镜像都需要从kubernetes官方镜像仓库拉取,国内无法访问,所以需要设置国内的阿里镜像仓库。

但是目前至发稿位置,阿里的kube-apiserver、kube-controller、proxy镜像只更新到v1.18.6所以无法拉取到v1.18.8版镜像。

如果你需要安装的kubernetes版本是v1.18.6及以下那么请继续往下走,如果是v1.18.7及以上请跳过这一步进入下一步。

3.9.3.1 初始化

[root@master1 ~]# kubeadm init --kubernetes-version=v1.18.6 --apiserver-advertise-address 0.0.0.0 --image-repository registry.aliyuncs.com/google_containers --pod-network-cidr 192.168.0.0/ --service-cidr 10.10.0.0/

--kubernetes-version 请指定为你需要安装的v1..6及以下的版本。

初始化成功后会出现如下信息

3.9.3.2 开启ipvs

修改kube-proxy的configmap

[root@master1 ~]# kubectl edit cm kube-proxy -n=kube-system

修改mode: ipvs

3.9.4 kubeadm指定配置文件初始化

3.9.4.1 下载kubernetes所需的全部镜像

dockerhub上面已经有大佬已经上传了最新的1.18.8镜像,这里我们直接下载下来即可。

[root@master1 ~]# vim images.txt

kube-apiserver:v1.18.8 # node节点不需要

kube-controller-manager:v1.18.8 # node节点不需要

kube-scheduler:v1.18.8 # node节点不需要

kube-proxy:v1.18.8

pause:3.2

etcd:3.4.- # node节点不需要

coredns:1.6. # node节点不需要

[root@master1 ~]# vim images.sh

for image in `cat images.txt`

do

docker pull gotok8s/$image

docker tag gotok8s/$image k8s.gcr.io/$image

docker rmi gotok8s/$image

done

[root@master1 ~]# sh images.sh

3.9.4.2 配置初始化文件

[root@master1 ~]# kubeadm config print init-defaults > kubeadm.yaml

[root@master1 ~]# vim kubeadm.yaml

apiVersion: kubeadm.k8s.io/v1beta2

bootstrapTokens:

- groups:

- system:bootstrappers:kubeadm:default-node-token

token: abcdef.0123456789abcdef

ttl: 24h0m0s

usages:

- signing

- authentication

kind: InitConfiguration

localAPIEndpoint:

advertiseAddress: 0.0.0.0 # 修改为本机ip地址,多块网卡可以指定具体ip

bindPort:

nodeRegistration:

criSocket: /var/run/dockershim.sock

name: master1

taints:

- effect: NoSchedule

key: node-role.kubernetes.io/master

---

apiServer:

timeoutForControlPlane: 4m0s

apiVersion: kubeadm.k8s.io/v1beta2

certificatesDir: /etc/kubernetes/pki

clusterName: kubernetes

controllerManager: {}

dns:

type: CoreDNS

etcd:

local:

dataDir: /var/lib/etcd

imageRepository: k8s.gcr.io

kind: ClusterConfiguration

kubernetesVersion: v1.18.8 # 修改为最新版本

networking:

dnsDomain: cluster.local

serviceSubnet: 10.10.0.0/ # service网段

podSubnet: 192.168.0.0/ # pod网段,需与网络插件网段一致

scheduler: {}

---

apiVersion: kubeproxy.config.k8s.io/v1alpha1

kind: KubeProxyConfiguration

mode: ipvs # 开启ipvs

[root@master1 ~]# kubeadm init --config=kubeadm.yaml

可以看到久违的成功

3.9.4.3 配置kubectl与api-server交互

[root@master1 ~]# mkdir -p $HOME/.kube

[root@master1 ~]# sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

[root@master1 ~]# sudo chown $(id -u):$(id -g) $HOME/.kube/config

至此可以使用kubectl查看集群节点状态了

[root@master1 ~]# kubectl get nodes

可以看到版本是v1.18.8最新版,但是master状态是NotReady,因为此时还没有安装网络组件。

3.9.5 安装网络组件

[root@master1 ~]# wget https://docs.projectcalico.org/v3.14/manifests/calico.yaml

[root@master1 ~]# kubectl apply -f calico.yaml

此时再来看节点状态,已经正常

查组件状态

[root@master1 ~]# kubectl get cs

3.10 worker节点加入集群

[root@node1 ~]# kubeadm join 10.13.1.11: --token abcdef.0123456789abcdef --discovery-token-ca-cert-hash sha256:c214cf4c42766dd3d4ab2842c11efbefd54aa445993708ccdbdb8f111658445e

同样的第二个worker节点加入集群

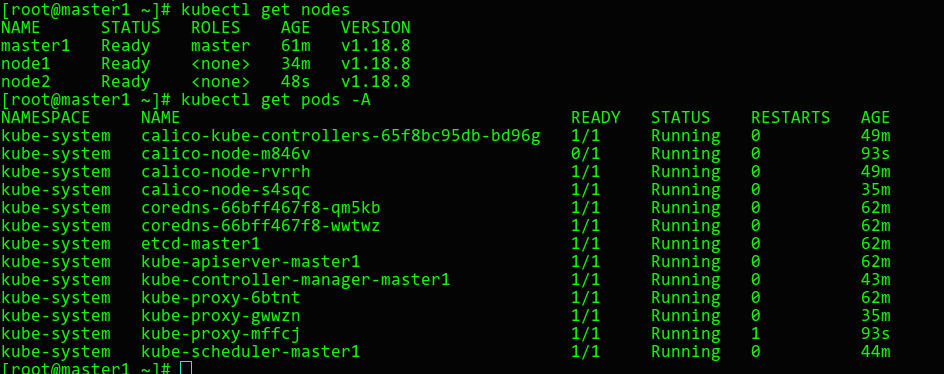

此次查看集群状态

[root@master1 ~]# kubectl get nodes

[root@master1 ~]# kubectl get pods -A

如果join的token之前没有记住,没关系,在master重新生成一下

[root@master1 ~]# kubeadm token create --print-join-command

可以看到节点和个组件的pod状态均正常,至此集群搭建完毕!

4. trouble shooting

出现了问题不可怕,因为如果不非常仔细,按照文档敲下来很有可能会出错。可怕的是,出错了连去网上多搜索一下都懒得搜,甚至开始抱怨。kubernets已经很成熟了,网上的资料非常多,出现的问题很多人也遇到过,在网上基本都有大佬给出回答。

4.1 初始化集群长期卡住,最终报错

拉镜像失败

执行拉镜像脚本

[root@master1 ~]# sh images.sh

4.2 网桥报错

W0822 ::25.135752 configset.go:] WARNING: kubeadm cannot validate component configs for API groups [kubelet.config.k8s.io kubeproxy.config.k8s.io]

[init] Using Kubernetes version: v1.18.8

[preflight] Running pre-flight checks

[WARNING Service-Kubelet]: kubelet service is not enabled, please run 'systemctl enable kubelet.service'

error execution phase preflight: [preflight] Some fatal errors occurred:

[ERROR FileContent--proc-sys-net-bridge-bridge-nf-call-iptables]: /proc/sys/net/bridge/bridge-nf-call-iptables contents are not set to

[preflight] If you know what you are doing, you can make a check non-fatal with `--ignore-preflight-errors=...`

To see the stack trace of this error execute with --v= or higher

检查前面的内核参数是否修改

net.ipv4.ip_forward = 1

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

4.3 kubelet-check报错健康问题检查

[kubelet-check] The HTTP call equal to 'curl -sSL http://localhost:10248/healthz' failed with error: Get http://localhost:10248/healthz: dial tcp: lookup localhost on 198.18.254.40:53: no such host.

[kubelet-check] It seems like the kubelet isn't running or healthy.

[kubelet-check] The HTTP call equal to 'curl -sSL http://localhost:10248/healthz' failed with error: Get http://localhost:10248/healthz: dial tcp: lookup localhost on 198.18.254.40:53: no such host.

[kubelet-check] It seems like the kubelet isn't running or healthy.

[kubelet-check] The HTTP call equal to 'curl -sSL http://localhost:10248/healthz' failed with error: Get http://localhost:10248/healthz: dial tcp: lookup localhost on 198.18.254.40:53: no such host.

[kubelet-check] It seems like the kubelet isn't running or healthy.

[kubelet-check] The HTTP call equal to 'curl -sSL http://localhost:10248/healthz' failed with error: Get http://localhost:10248/healthz: dial tcp: lookup localhost on 198.18.254.40:53: no such host.

[kubelet-check] It seems like the kubelet isn't running or healthy.

[kubelet-check] The HTTP call equal to 'curl -sSL http://localhost:10248/healthz' failed with error: Get http://localhost:10248/healthz: dial tcp: lookup localhost on 198.18.254.40:53: no such host.

检查hosts文件,本机地址解析是否被删除了

127.0.0.1 localhost

4.4 查看组件处于不健康状态

[root@master1 ~]# kubectl get cs

发现controller-manager和scheduler状态是不健康

如果节点都处于Ready后,实际上该状态是不影响的。

因为kubeadm v1.18.6及以后的版本,是默认不开启controller-manager的10252和scheduler的10251端口的,一般10251和10252是监听在http上面,不需要证书认证,属于不安全的端口。

查看机器监听端口,发现默认这两个端口没有监听

可以将/etc/kubernetes/manifests/kube-controller-manager.yaml、/etc/kubernetes/manifests/kube-scheduler.yaml中--port=0注释掉,再次kubect get cs组件状态,这时都是ok了。

默认不监听http端口,但是客户端查看组件状态有默认是检查http端口,不知道这算不算是kuberadm的一个小bug呢,哈哈~~~

4.5 worker节点加入集群后长期处于NotReady

查看node

查看pod状态,kube-proxy一直处于创建状态,网络组建caclio一直处于初始化

kubect describe pod查看报错:FailedCreatePodSandBox

说明节点没有pull基础镜像pause,到相应节点上面去拉取pause镜像即可。

4.6 node节点运行一段时间后出现错误

查看pod状态

查看报错的pod,发现cgroup报错

到node节点查看kubelet也在报错

原因是docker的驱动改为了systemd,但是kubelet的驱动没有改

kubelet的驱动是在kubeadm join初始化的时候与docker保持一致的,docker修改了,kubelet也需要修改

[root@node2 ~]# sed -i 's/--cgroup-driver=cgroupfs/--cgroup-driver=systemd/g' /var/lib/kubelet/kubeadm-flags.env

[root@node2 ~]# systemctl restart kubelet

同样如果node节点处于NotReady,kubelet一直在重启,也需要检查kubelet的cgroup驱动是否和docker的一致。

4.7 worker节点加入节点后,网络组件一直不ready,一直重启

该pod一直处于Running和CrashLoopBackOff交替状态

查看pod日志,发现有大量的健康检查错误

到node节点上查看hosts文件,本机地址解析是否被删除了

127.0.0.1 localhost

参考文档

https://kubernetes.io/docs/setup/production-environment/tools/kubeadm/install-kubeadm/

https://kubernetes.io/zh/docs/setup/production-environment/tools/kubeadm/install-kubeadm/

全剧终

kubeadm安装kubernetes(v18.8.8)的更多相关文章

- Centos7 使用 kubeadm 安装Kubernetes 1.13.3

目录 目录 什么是Kubeadm? 什么是容器存储接口(CSI)? 什么是CoreDNS? 1.环境准备 1.1.网络配置 1.2.更改 hostname 1.3.配置 SSH 免密码登录登录 1.4 ...

- kubeadm安装kubernetes V1.11.1 集群

之前测试了离线环境下使用二进制方法安装配置Kubernetes集群的方法,安装的过程中听说 kubeadm 安装配置集群更加方便,因此试着折腾了一下.安装过程中,也有一些坑,相对来说操作上要比二进制方 ...

- 使用kubeadm安装kubernetes高可用集群

kubeadm安装kubernetes高可用集群搭建 第一步:首先搭建etcd集群 yum install -y etcd 配置文件 /etc/etcd/etcd.confETCD_NAME=inf ...

- 使用kubeadm安装Kubernetes 1.12

使用kubeadm安装Kubernetes 1.12 https://blog.frognew.com/2018/10/kubeadm-install-kubernetes-1.12.html 测试环 ...

- 使用kubeadm安装kubernetes v1.14.1

使用kubeadm安装kubernetes v1.14.1 一.环境准备 操作系统:Centos 7.5 ⼀ 一台或多台运⾏行行着下列列系统的机器器: Ubuntu 16.04+ Debi ...

- 使用kubeadm 安装 kubernetes 1.15.1

简介: Kubernetes作为Google开源的容器运行平台,受到了大家的热捧.搭建一套完整的kubernetes平台,也成为试用这套平台必须迈过的坎儿.kubernetes1.5版本以及之前,安装 ...

- 使用 kubeadm 安装 kubernetes v1.16.0

近日通过kubeadm 安装 kubernetes v1.16.0,踩过不少坑,现记录下安装过程. 安装环境: 系 统:CentOS Linux release 7.6 Docke ...

- Kubernetes(K8s) 安装(使用kubeadm安装Kubernetes集群)

背景: 由于工作发生了一些变动,很长时间没有写博客了. 概述: 这篇文章是为了介绍使用kubeadm安装Kubernetes集群(可以用于生产级别).使用了Centos 7系统. 一.Centos7 ...

- kubeadm 安装Kubernetes 1.16.3 (CentOS7+IPVS+Calico)

目录 · . 一.更新系统内核(全部节点) · . 二.基础环境设置(全部节点) · . 1.修改 Host · . 2.修改 Hostname · . 3.主机时间同步 · . 4.关闭 ...

- 在CentOS 7.6 以 kubeadm 安装 Kubernetes 1.15 最佳实践

前言 Kubernetes作为容器编排工具,简化容器管理,提升工作效率而颇受青睐.很多新手部署Kubernetes由于"scientifically上网"问题举步维艰,本文以实战经 ...

随机推荐

- PDO::lastInsertId

PDO::lastInsertId — 返回最后插入行的ID或序列值(PHP 5 >= 5.1.0, PECL pdo >= 0.1.0) 说明 语法 string PDO::lastIn ...

- NodeJS 极简教程 <1> NodeJS 特点 & 使用场景

NodeJS 极简教程 <1> NodeJS 特点 & 使用场景 田浩 因为看开了所以才去较劲儿. 1. NodeJS是什么 1.1 Node.js is a JavaScri ...

- SSM三大框架的整合

好好学习,天天向上 本文已收录至我的Github仓库DayDayUP:github.com/RobodLee/DayDayUP,欢迎Star,更多文章请前往:目录导航 在Java后端开发领域,Spri ...

- .NetCore 入门

.net core是什么? .net core是一个可以用来构建现代.可伸缩和高性能的跨平台软件应用程序的通用开发框架. 我们为什么要使用.net core,也就是说.net core有什么好处? 跨 ...

- C++的常用输入及其优化以及注意事项

$\mathcal{P.S:}$ 对于输入方式及其优化有了解的大佬可直接阅读$\mathcal{Part}$ $\mathcal{2}$ 特别鸣谢:@归斋目录: $\mathcal{Part}$ $\ ...

- Nginx的基本使用和配置

2.1什么是Nginx Nginx 是一款高性能的 http 服务器/反向代理服务器及电子邮件(IMAP/POP3)代理服务器.由俄罗斯的程序设计师伊戈尔·西索夫(Igor Sysoev)所开发,官方 ...

- 在Spring Boot中动态实现定时任务配置

原文路径:https://zhuanlan.zhihu.com/p/79644891 在日常的项目开发中,往往会涉及到一些需要做到定时执行的代码,例如自动将超过24小时的未付款的单改为取消状态,自动将 ...

- 利用描述符自定制property

利用描述符自定制property class Lazyproperty: def __init__(self,func): # print('==========>',func) self.fu ...

- Java 集合框架综述,这篇让你吃透!

一.集合框架图 简化图: 说明:对于以上的框架图有如下几点说明 1.所有集合类都位于java.util包下.Java的集合类主要由两个接口派生而出:Collection和Map,Collection和 ...

- Java自学-图形界面 事件监听

Swing 如何进行事件监听 示例 1 : 按钮监听 创建一个匿名类实现ActionListener接口,当按钮被点击时,actionPerformed方法就会被调用 package gui; imp ...