莫烦PyTorch学习笔记(三)——激励函数

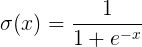

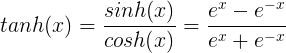

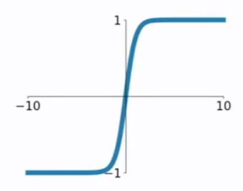

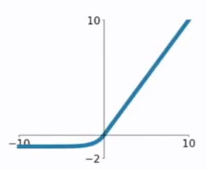

tanh是双曲正切函数,tanh函数和sigmod函数的曲线是比较相近的,咱们来比较一下看看。首先相同的是,这两个函数在输入很大或是很小的时候,输出都几乎平滑,梯度很小,不利于权重更新;不同的是输出区间,tanh的输出区间是在(-1,1)之间,而且整个函数是以0为中心的,这个特点比sigmod的好。

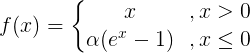

ELU函数是针对ReLU函数的一个改进型,相比于ReLU函数,在输入为负数的情况下,是有一定的输出的,而且这部分输出还具有一定的抗干扰能力。这样可以消除ReLU死掉的问题,不过还是有梯度饱和和指数运算的问题。

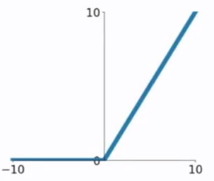

PReLU也是针对ReLU的一个改进型,在负数区域内,PReLU有一个很小的斜率,这样也可以避免ReLU死掉的问题。相比于ELU,PReLU在负数区域内是线性运算,斜率虽然小,但是不会趋于0,这算是一定的优势吧。

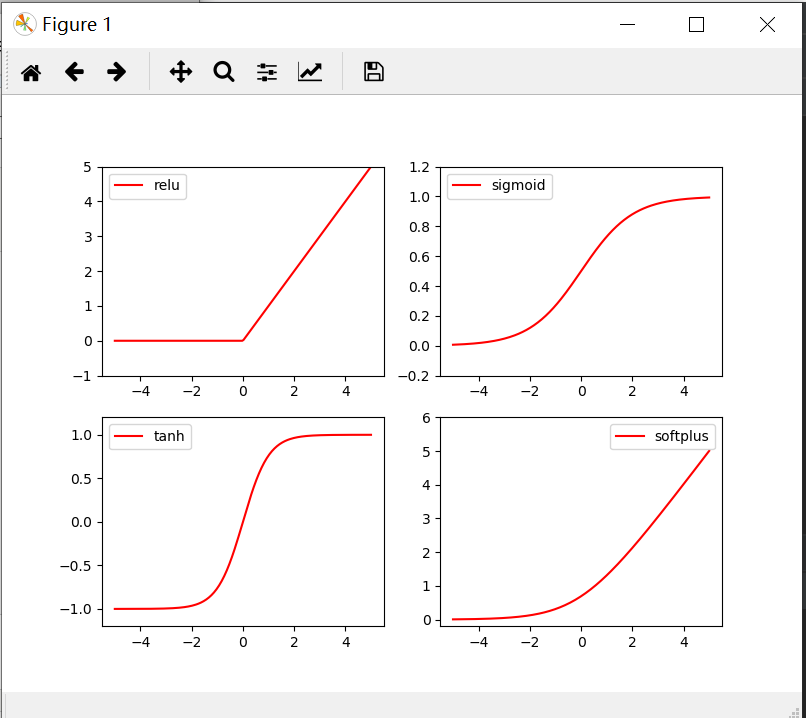

import torch

from torch.autograd import Variable

import matplotlib.pyplot as plt

import torch.nn.functional as F

x= torch.linspace(-,,)

x= Variable(x)

x_np=x.data.numpy() y_relu = torch.relu(x).data.numpy()

y_sigmoid =torch.sigmoid(x).data.numpy()

y_tanh = torch.tanh(x).data.numpy()

y_softplus = F.softplus(x).data.numpy() plt.figure(,figsize=(,))

plt.subplot()

plt.plot(x_np,y_relu,c='red',label='relu')

plt.ylim(-,)

plt.legend(loc='best') plt.subplot()

plt.plot(x_np,y_sigmoid,c='red',label='sigmoid')

plt.ylim(-0.2,1.2)

plt.legend(loc='best') plt.subplot()

plt.plot(x_np,y_tanh,c='red',label='tanh')

plt.ylim(-1.2,1.2)

plt.legend(loc='best') plt.subplot()

plt.plot(x_np,y_softplus,c='red',label='softplus')

plt.ylim(-0.2,)

plt.legend(loc='best')

plt.show()

莫烦PyTorch学习笔记(三)——激励函数的更多相关文章

- 莫烦pytorch学习笔记(八)——卷积神经网络(手写数字识别实现)

莫烦视频网址 这个代码实现了预测和可视化 import os # third-party library import torch import torch.nn as nn import torch ...

- 莫烦pytorch学习笔记(七)——Optimizer优化器

各种优化器的比较 莫烦的对各种优化通俗理解的视频 import torch import torch.utils.data as Data import torch.nn.functional as ...

- 莫烦PyTorch学习笔记(五)——模型的存取

import torch from torch.autograd import Variable import matplotlib.pyplot as plt torch.manual_seed() ...

- 莫烦PyTorch学习笔记(六)——批处理

1.要点 Torch 中提供了一种帮你整理你的数据结构的好东西, 叫做 DataLoader, 我们能用它来包装自己的数据, 进行批训练. 而且批训练可以有很多种途径. 2.DataLoader Da ...

- 莫烦pytorch学习笔记(二)——variable

.简介 torch.autograd.Variable是Autograd的核心类,它封装了Tensor,并整合了反向传播的相关实现 Variable和tensor的区别和联系 Variable是篮子, ...

- 莫烦 - Pytorch学习笔记 [ 二 ] CNN ( 1 )

CNN原理和结构 观点提出 关于照片的三种观点引出了CNN的作用. 局部性:某一特征只出现在一张image的局部位置中. 相同性: 同一特征重复出现.例如鸟的羽毛. 不变性:subsampling下图 ...

- 莫烦 - Pytorch学习笔记 [ 一 ]

1. Numpy VS Torch #相互转换 np_data = torch_data.numpy() torch_data = torch.from_numpy(np_data) #abs dat ...

- 莫烦PyTorch学习笔记(五)——分类

import torch from torch.autograd import Variable import torch.nn.functional as F import matplotlib.p ...

- 莫烦PyTorch学习笔记(四)——回归

下面的代码说明个整个神经网络模拟回归的过程,代码含有详细注释,直接贴下来了 import torch from torch.autograd import Variable import torch. ...

随机推荐

- 2019 牛客多校第一场 F Random Point in Triangle

题目链接:https://ac.nowcoder.com/acm/contest/881/F 题目大意 给定二维平面上 3 个整数表示的点 A,B,C,在三角形 ABC 内随机选一点 P,求期望$E ...

- boost库之pool编译错误

1,编译错误截图 2,解决方法 这是由于没有链接对应的库导致的错误,在编译命令中加上 -lboost_system选项即可.

- 2018湘潭大学程序设计竞赛【H】

题目链接:https://www.nowcoder.com/acm/contest/105/H 题意:两个操作,一个在[l,r]区间放颜色为c的球,一个统计在[l,r]里有多少不同颜色的球. 题解:哎 ...

- 转——调试寄存器 原理与使用:DR0-DR7

下面介绍的知识性信息来自intel IA-32手册(可以在intel的开发手册或者官方网站查到),提示和补充来自学习调试器实现时的总结. 希望能给你带去有用的信息. (DRx对应任意的一个调试寄存器. ...

- 几个实用的js函数

在阅读JavaScript DOM编程艺术这本书时看到了一些比较实用的代码. //加载多个window.onload事件 function addLoadEvent(func) { var oldon ...

- 7_API调用

0 查看 kifastcallentry 里面具体怎么调用 首先是 切换了 fs 为kpcr的选择子 然后 构造了 一个trap frame(保存3环-->0环 切换的上下文:如果0环不使用就没 ...

- Matplotlib---柱状图、直方图(高斯分布)

# _*_ coding: gbk _*_ # @Author: Wonde # bar 直方图 import matplotlib.pyplot as plt # 绘图 from matplotli ...

- 【JZOJ6384】珂学家

description analysis 注意配出来的饮料不可以再配成其他饮料,所以肯定有\(O(n^2)\)的枚举 而且可口度两两互不相同,搞得我以为这是神仙题 考虑把两个试剂\([l_1,r_1] ...

- scala 中List的简单使用

/** * scala 中List的使用 * */ object ListUse { def main(args: Array[String]): Unit = { def decorator(l:L ...

- for双重循环中的结构分离(语法结构问题)

//增加搜索列表 function addSearchList(){ $.get("/mall/h5_get_search_list.html","",func ...