论文解读()《Cluster Alignment with a Teacher for Unsupervised Domain Adaptation》

Note:[ wechat:Y466551 | 付费咨询,非诚勿扰 ]

论文信息

论文标题:Cluster Alignment with a Teacher for Unsupervised Domain Adaptation

论文作者:Zhijie Deng, Yucen Luo, Jun Zhu

论文来源:2020 ICCV

论文地址:download

论文代码:download

视屏讲解:click

1 介绍

2 方法

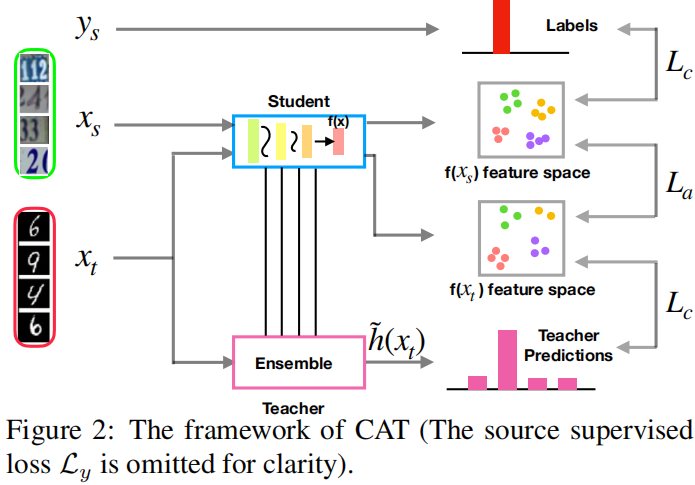

2.1 模型框架

2.2 Cluster Alignment with a Teacher

目标:discriminative learning 和 class-conditional alignment between domains?

$\min _{\theta} \mathcal{L}_{y}+\alpha\left(\mathcal{L}_{c}+\mathcal{L}_{a}\right) \quad(1)$

2.2.1 Discriminative clustering with a teacher

目标函数:

$\mathcal{L}_{c}\left(\mathcal{X}_{s}, \mathcal{X}_{t}\right)=\mathcal{L}_{c}\left(\mathcal{X}_{s}\right)+\mathcal{L}_{c}\left(\mathcal{X}_{t}\right)$

$\begin{aligned}\mathcal{L}_{c}(\mathcal{X})= \frac{1}{|\mathcal{X}|^{2}} \sum_{i=1}^{|\mathcal{X}|} \sum_{j=1}^{|\mathcal{X}|}\left[\delta_{i j} d\left(f\left(x^{i}\right), f\left(x^{j}\right)\right)+\right.\left.\left(1-\delta_{i j}\right) \max \left(0, m-d\left(f\left(x^{i}\right), f\left(x^{j}\right)\right)\right)\right]\end{aligned}$

其中 ,$\delta_{i j}$ 代表样本 $x_i$ 和 样本 $x_j$ 是不是同一类;

Note:目标域样本的标签(伪)由 教师分类器给出;

Note:可能会怀疑,教师分类器的错误预测是否会破坏训练的动态。然而,先前关于半监督学习[17,43]的研究已经验证了这种训练总是能导致良好的收敛性,并证明了对不正确标签的鲁棒性。

2.2.2 Cluster alignment via conditional feature matching

类条件特征对齐:

$\min _{\theta} \mathcal{D}\left(\mathcal{F}_{s, k} \| \mathcal{F}_{t, k}\right)$

其中,$\mathcal{F}_{s, k}\left(\mathcal{F}_{t, k}\right) $ 表示由属于源域(目标域)的类 $k$ 的所有特征组成的集合。

$\mathcal{L}_{a}\left(\mathcal{X}_{s}, \mathcal{Y}_{s}, \mathcal{X}_{t}\right)=\frac{1}{K} \sum_{k=1}^{K}\left\|\lambda_{s, k}-\lambda_{t, k}\right\|_{2}^{2}$

$\lambda_{t, k}=\frac{1}{\left|\mathcal{X}_{t, k}\right|} \sum_{x_{t}^{i} \in \mathcal{X}_{t, k}} f\left(x_{t}^{i}\right)$

2.3 Improved marginal distribution alignment

最后作者还做了一些提高,这是因为实验观察到:一开始训练的时候,teacher 对于目标域的判断并不果断,即分类结果更多聚集在分类边界附近,而不是类别中心。

目标函数:

$\begin{array}{c}\min _{\theta} \max _{\phi} \mathcal{L}_{d}\left(\mathcal{X}_{s}, \mathcal{X}_{t}\right)=\frac{1}{N} \sum_{i=1}^{N}\left[\log c\left(f\left(x_{s}^{i} ; \theta\right) ; \phi\right)\right]+ \frac{1}{\tilde{M}} \sum_{i=1}^{\tilde{M}}\left[\log \left(1-c\left(f\left(x_{t}^{i} ; \theta\right) ; \phi\right)\right) \gamma_{i}\right]\end{array}$

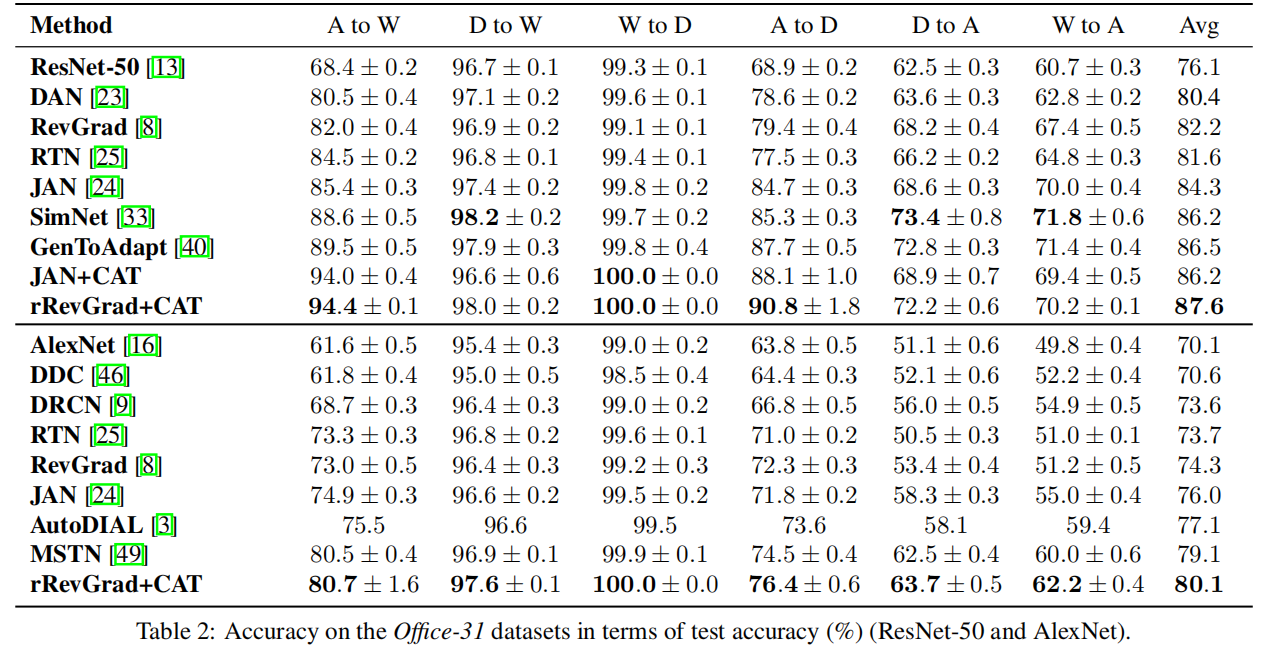

3 实验

论文解读()《Cluster Alignment with a Teacher for Unsupervised Domain Adaptation》的更多相关文章

- 《Population Based Training of Neural Networks》论文解读

很早之前看到这篇文章的时候,觉得这篇文章的思想很朴素,没有让人眼前一亮的东西就没有太在意.之后读到很多Multi-Agent或者并行训练的文章,都会提到这个算法,比如第一视角多人游戏(Quake ...

- ImageNet Classification with Deep Convolutional Neural Networks 论文解读

这个论文应该算是把深度学习应用到图片识别(ILSVRC,ImageNet large-scale Visual Recognition Challenge)上的具有重大意义的一篇文章.因为在之前,人们 ...

- 《Deep Feature Extraction and Classification of Hyperspectral Images Based on Convolutional Neural Networks》论文笔记

论文题目<Deep Feature Extraction and Classification of Hyperspectral Images Based on Convolutional Ne ...

- Quantization aware training 量化背后的技术——Quantization and Training of Neural Networks for Efficient Integer-Arithmetic-Only Inference

1,概述 模型量化属于模型压缩的范畴,模型压缩的目的旨在降低模型的内存大小,加速模型的推断速度(除了压缩之外,一些模型推断框架也可以通过内存,io,计算等优化来加速推断). 常见的模型压缩算法有:量化 ...

- Training Deep Neural Networks

http://handong1587.github.io/deep_learning/2015/10/09/training-dnn.html //转载于 Training Deep Neural ...

- Training (deep) Neural Networks Part: 1

Training (deep) Neural Networks Part: 1 Nowadays training deep learning models have become extremely ...

- [CVPR2015] Is object localization for free? – Weakly-supervised learning with convolutional neural networks论文笔记

p.p1 { margin: 0.0px 0.0px 0.0px 0.0px; font: 13.0px "Helvetica Neue"; color: #323333 } p. ...

- Training spiking neural networks for reinforcement learning

郑重声明:原文参见标题,如有侵权,请联系作者,将会撤销发布! 原文链接:https://arxiv.org/pdf/2005.05941.pdf Contents: Abstract Introduc ...

- CVPR 2018paper: DeepDefense: Training Deep Neural Networks with Improved Robustness第一讲

前言:好久不见了,最近一直瞎忙活,博客好久都没有更新了,表示道歉.希望大家在新的一年中工作顺利,学业进步,共勉! 今天我们介绍深度神经网络的缺点:无论模型有多深,无论是卷积还是RNN,都有的问题:以图 ...

- 论文翻译:BinaryConnect: Training Deep Neural Networks with binary weights during propagations

目录 摘要 1.引言 2.BinaryConnect 2.1 +1 or -1 2.2确定性与随机性二值化 2.3 Propagations vs updates 2.4 Clipping 2.5 A ...

随机推荐

- 新概念英语(New Concept English),前言

本书向读者提供了一套完整的,经过实践检验的英语学习体系,使得学生能够发挥自己的最大潜能. 听力 口语 阅读 写作 学习语言不在于掌握一套规则和积累大量词汇. 而在于如何运用所学的知识. 学习单词,必须 ...

- 2023-01-03:超过5名学生的课。编写一个SQL查询来报告 至少有5个学生 的所有班级,返回结果不限顺序。请问sql语句如何写? +---------+ | class | +-----

2023-01-03:超过5名学生的课.编写一个SQL查询来报告 至少有5个学生 的所有班级,返回结果不限顺序.请问sql语句如何写? ±--------+ | class | ±--------+ ...

- 2021-07-04:股票问题1。给定一个数组 prices ,它的第 i 个元素 prices[i] 表示一支给定股票第 i 天的价格。你只能选择某一天 买入这只股票,并选择在未来的某一个不同的日子

2021-07-04:股票问题1.给定一个数组 prices ,它的第 i 个元素 prices[i] 表示一支给定股票第 i 天的价格.你只能选择某一天 买入这只股票,并选择在未来的某一个不同的日子 ...

- uni-app Flex布局

Flexbox #Flex 容器 Flex 是 Flexible Box 的缩写,意为"弹性布局",用来为盒状模型提供最大的灵活性. nvue布局模型基于 CSS Flexbox, ...

- 蓝桥杯真题 k倍区间

考点: - 利用前缀和求子列和 - 同余作差是模的倍数 题目概要 给定一个长度为N的数列,A1, A2, - AN,如果其中一段连续的子序列Ai, Ai+1, - Aj(i <= j)之和是K的 ...

- 2023-05-22:给定一个长度为 n 的字符串 s ,其中 s[i] 是: D 意味着减少; I 意味着增加。 有效排列 是对有 n + 1 个在 [0, n] 范围内的整数的一个排列 perm

2023-05-22:给定一个长度为 n 的字符串 s ,其中 s[i] 是: D 意味着减少: I 意味着增加. 有效排列 是对有 n + 1 个在 [0, n] 范围内的整数的一个排列 perm ...

- CANoe学习笔记(三):CANoe的诊断功能和cdd文件

内容: UDS诊断学习 CDD文件配置 诊断功能 一.UDS诊断学习: ①.UDS请求命令4种构成方式: SIDSID+SF(Sub-function)SID+DID(Data Identifier) ...

- C++面试八股文:什么是RAII?

某日二师兄参加XXX科技公司的C++工程师开发岗位第13面: 面试官:什么是RAII? 二师兄:RAII是Resource Acquisition Is Initialization的缩写.翻译成中文 ...

- LLE算法在自然语言生成中的应用:实现文本到语音的情感迁移

目录 自然语言生成(Natural Language Generation,NLP)是人工智能领域的一个分支,它利用大量的文本数据训练出语言模型,从而实现对自然语言的生成和理解.在NLP中,情感迁移( ...

- ELK8.8部署安装并配置xpark认证

ELK8.8部署安装并配置xpark认证 介绍 主要记录下filebeat+logstash+elasticsearch+kibana抽取过滤存储展示应用日志文件的方式:版本基于8.8,并开启xp ...