mac安装Hadoop,mysql,hive,sqoop教程

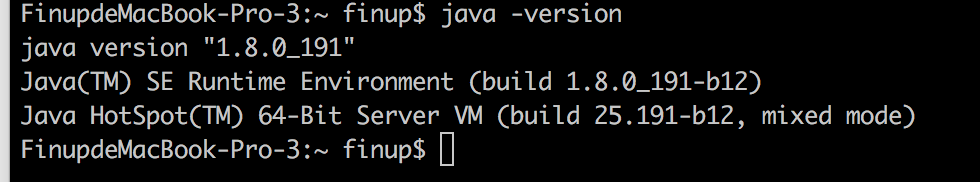

在安装Hadoop,mysql,hive之前,首先要保证电脑上安装了jdk

一.配置jdk

1. 下载jdk

http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html

2. 配置环境变量

(1)在终端使用 sudo su 命令进入root用户模式;

(2)使用 vim /etc/profile 命令打开profile文件,按下大写“I”进入编辑模式,在文件中添加以下信息:

JAVA_HOME对应的是你的JDK安装路径

JAVA_HOME="/Library/Java/JavaVirtualMachines/jdk1.8.0_151.jdk/Contents/Home"

CLASS_PATH="$JAVA_HOME/lib"

PATH=".;$PATH:$JAVA_HOME/bin"

export JAVA_HOME

(3)使用“esc”键推出编辑模式,按下“:”,输入wq并回车,保存且退出。

(4)退出终端并重新打开,输入java -version 命令查看jdk配置情况。

二.配置hadoop

1. 下载Hadoop

Hadoop 2.7.7镜像下载链接:https://mirrors.tuna.tsinghua.edu.cn/apache/hadoop/common/hadoop-2.7.7/hadoop-2.7.7.tar.gz

2. 将下载后的压缩文件复制到/Users/finup/opt目录下并解压

3. 配置Hadoop

(1).进入/Users/finup/opt/hadoop-2.7.7/etc/hadoop/目录下,修改hadoop-env.sh配置文件

首先要查看JAVA_HOME的安装路径:

输入以下命令:/usr/libexec/java_home

/usr/libexec/java_home

结果:/Library/Java/JavaVirtualMachines/jdk1.8.0_191.jdk/Contents/Home

然后修改hadoop-env.sh配置文件

export JAVA_HOME="/Library/Java/JavaVirtualMachines/jdk1.8.0_191.jdk/Contents/Home"

export HADOOP_OPTS="$HADOOP_OPTS -Djava.net.preferIPv4Stack=true -Djava.security.krb5.realm= -Djava.security.krb5.kdc="

(2).配置hdfs地址和端口

进入/Users/finup/opt/hadoop-2.7.7/etc/hadoop/目录下,修改core-site.xml配置文件

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/Users/finup/opt/hadoop-2.7.7/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

hadoop.tmp.dir 表示自己进程产生的一些数据要放入到该目录中

fs.defaultFS用于设置Hadoop的默认文件系统,设置为“hdfs://localhost:9000”。localhost表示namenade,9000表示端口号。 HDFS的守护程序通过该属性项来确定HDFS namenode的主机和端口。

(3).配置HDFS的默认参数副本数

进入/Users/finup/opt/hadoop-2.7.7/etc/hadoop/目录下,修改hdfs-site.xml配置文件

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/Users/finup/opt/hadoop-2.7.7/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/Users/finup/opt/hadoop-2.7.7/tmp/dfs/data</value>

</property>

</configuration>

dfs.replication 表示复本数,文件会被保存为几分。dfs.replication的value设置为“1”,这样HDFS就不会按默认设置将文件系统块复本设置为3。否则在单独一个datanode上运行时,HDFS无法将块复制到3个datanode上,所以会持续给出块复本不足的警告。

(4).配置mapreduce中jobtracker的地址和端口

进入/Users/finup/opt/hadoop-2.7.7/etc/hadoop/目录下,修改mapred-site.xml.template配置文件

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>localhost:9001</value>

</property>

</configuration>

(5).修改配置文件 yarn-site.xml

进入/Users/finup/opt/hadoop-2.7.7/etc/hadoop/目录下,修改yarn-site.xml配置文件

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

(6).文件系统初始化

进入到Hadoop安装路径的bin目录下,使用命令 ./hadoop namenode -format 进行初始化,初始化成功会输出以下信息,注意红框标记处。

(7).配置Hadoop环境变量

目的是方便在任意目录下全局开启关闭hadoop相关服务,而不需要到/Users/finup/opt/hadoop-2.7.7/sbin下去执行启动或关闭命令。使用命令 vim ~/.zshrac 进行编辑,添加以下内容:(注意:zshrac是自己创建的,不要纠结自己找不到这个文件)

export HADOOP_HOME=/Users/finup/opt/hadoop-2.7.7

export PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin

然后使用source ~/.zshrac命令使修改生效,以上关于Hadoop的配置全部结束。

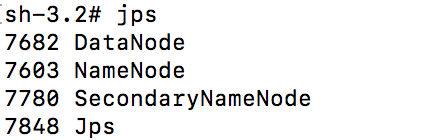

4.启动hadoop

(1).启动/关闭hadoop服务

进入sbin目录下,使用./start-dfs.sh命令启动,然后使用jps查看启动结果,启动成功如下图所示:

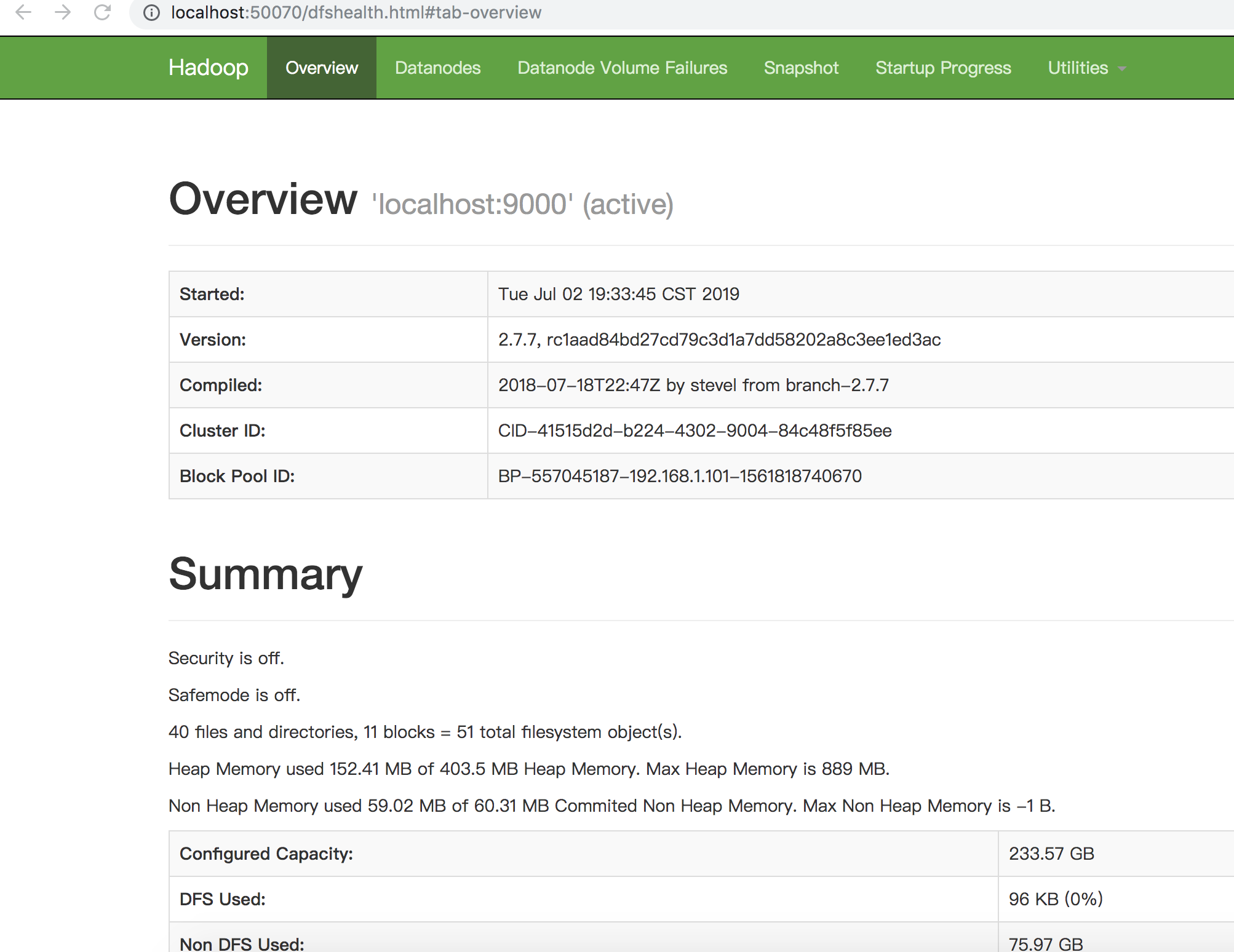

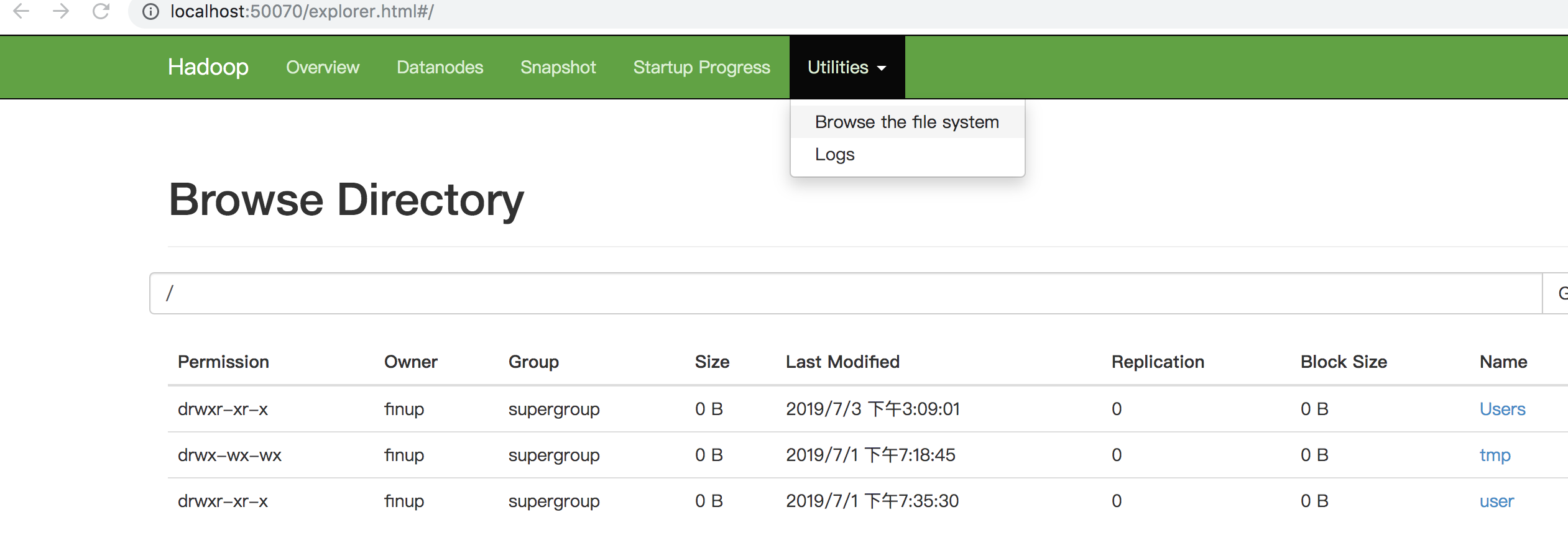

我们在浏览器中输入http://localhost:50070打开以下网页,可以查看 NameNode 和 Datanode 信息,还可以在线查看 HDFS 中的文件。

使用./stop-dfs.sh命令关闭hadoop服务

(2).启动/关闭yarn服务

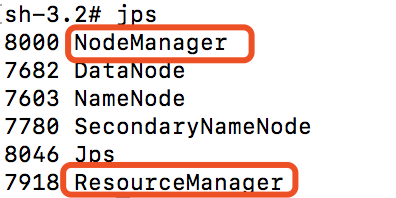

使用./start-yarn.sh命令启动yarn服务,让 yarn来负责资源管理与任务调度。启动成功后,使用jps命令可以输出以下信息:

比之前只启动Hadoop服务时多了一个NodeManager和ResourceManager,然后在浏览器中打开http://localhost:8088,可以通过 Web 界面查看任务的运行情况。

使用./stop-yarn.sh命令来关闭yarn服务。

(3) 快速启动和关闭

进入sbin目录下,直接使用命令 ./start-all.sh和./stop-all.sh命令可以同时启动和关闭hadoop和yarn服务,比依次启动和关闭方便很多。

三.安装mysql

可参考该链接:https://jingyan.baidu.com/article/fa4125ac0e3c2928ac709204.html

四.安装hive

首先要保证hadoop和mysql已经安装好了

1.在mysql数据库创建hive用户

mysql> create user 'hive' identified by 'hive';

2.将mysql的所有权限授权给hive用户

mysql> grant all on *.* to 'hive'@'localhost' identified by 'hive';

3.刷新mysql使1、2步骤生效

mysql> flush privileges;

4.输入sql语句查询hive用户是否存在

mysql> select host,user,authentication_string from mysql.user;

+-----------+---------------+-------------------------------------------+

| host | user | authentication_string |

+-----------+---------------+-------------------------------------------+

| localhost | root | *D391E96D137871ED52CDB352D867D3549815A718 |

| localhost | mysql.session | *THISISNOTAVALIDPASSWORDTHATCANBEUSEDHERE |

| localhost | mysql.sys | *THISISNOTAVALIDPASSWORDTHATCANBEUSEDHERE |

| % | hive | *4DF1D66463C18D44E3B001A8FB1BBFBEA13E27FC |

| localhost | hive | *4DF1D66463C18D44E3B001A8FB1BBFBEA13E27FC |

+-----------+---------------+-------------------------------------------+

5.使用hive用户登录mysql

wudejin:~ oldsix$ mysql -u hive -p

Enter password: hive

mysql>

6.创建hive数据库

mysql> create database hive;

7.查看是否创建成功

mysql> show databases;

+--------------------+

| Database |

+--------------------+

| information_schema |

| hive |

| mysql |

| performance_schema |

| sys |

| test |

+--------------------+

6 rows in set (0.00 sec)

至此,前期的准备工作已完成,接下来,我们进入hive的安装过程。

8.下载hive安装包并解压

下载地址:https://mirrors.tuna.tsinghua.edu.cn/apache/hive/

下载完成后,通过命令行解压:

tar -zxvf apache-hive-3.1.1-bin.tar.gz

解压完成之后,对解压出来的文件夹重命名

mv apache-hive-3.1.1-bin hive3.1.1

9.修改hive配置:

进入hive3.1.1目录下的bin目录下,修改hive-site.xml配置文件

bin目录下不存在hive-site.xml文件,我们需要先复制一份:

cp hive-default.xml.template hive-site.xml

修改hive-site.xml文件:

--修改数据库连接驱动名 (配置文件中需要将该配置去掉)

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

<description>Driver class name for a JDBC metastore</description>

</property> --修改数据库连接URL (配置文件中需要将该配置去掉)

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://localhost:3306/hive?characterEncoding=UTF-8</value>

<description>

JDBC connect string for a JDBC metastore.

To use SSL to encrypt/authenticate the connection, provide database-specific SSL flag in the connection URL.

For example, jdbc:postgresql://myhost/db?ssl=true for postgres database.

</description>

</property> --修改数据库连接用户名 (配置文件中需要将该配置去掉)

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>hive</value>

<description>Username to use against metastore database</description>

</property> --修改数据库连接密码 (配置文件中需要将该配置去掉)

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>hive</value>

<description>password to use against metastore database</description>

</property> --修改hive数据目录(三处) (配置文件中需要将该配置去掉)

<property>

<name>hive.querylog.location</name>

<value>/Users/finup/opt/hive3.1.1/iotmp</value>

<description>Location of Hive run time structured log file</description>

</property>

<property>

<name>hive.exec.local.scratchdir</name>

<value>/Users/finup/opt/hive3.1.1/iotmp</value>

<description>Local scratch space for Hive jobs</description>

</property>

<property>

<name>hive.downloaded.resources.dir</name>

<value>/Users/finup/opt/hive3.1.1/iotmp</value>

<description>Temporary local directory for added resources in the remote file system.</description>

</property> --可以将表头显示出来 (配置文件中需要将该配置去掉)

<property>

<name>hive.cli.print.header</name>

<value>true</value>

<description>Whether to print the names of the columns in query output.</description>

</property>

10.配置hive环境变量

cd ~

sudo vi .base_profile

设置HIVE_HOME,并添加到PATH

export HIVE_HOME=/Users/finup/opt/hive3.1.1

export PATH=$PATH:$HIVE_HOME/bin

保存退出,并使环境变量生效

source .base_profile

11.将对应数据库的驱动包放到hive目录下的lib目录下

下载mysql-connector-java-8.0.16.jar,并上传至hive的lib目录下

12.初始化元数据库:schematool -dbType mysql -initSchema

13.进入hadoop安装目录,启动hadoop

/sbin/start-all.sh

14.启动hive

进入hive的bin目录下,执行命令: ./hive

15.退出hive命令

exit

hive (zcfw_sda)> exit;

四.安装sqoop

1. 安装和配置

brew install sqoop

sqoop version cd /usr/local/Cellar/sqoop/1.4.6/libexec/conf

cp sqoop-env-template.sh sqoop-env.sh vim sqoop-env.sh export HADOOP_HOME="/Users/finup/opt/hadoop-2.7.7"

export HBASE_HOME="/usr/local"

export HIVE_HOME="/Users/finup/opt/hive3.1.1"

export HCAT_HOME="/usr/local"

export ZOOCFGDIR="/usr/local/etc/zookeeper"

export ZOOKEEPER_HOME="/usr/local/opt/zookeeper"

2. 测试

sqoop list-tables --connect jdbc:mysql://localhost/test --username root --password ***** sqoop eval --connect jdbc:mysql://localhost/test --username root --password ***** --query "select * from test.student"

3. 遇到的问题

问题1

java.lang.Exception: java.lang.RuntimeException:java.lang.ClassNotFoundException: Class example not found

原因和解决方法:hadoop 单机模式下无法找到执行目录,切换到伪分布模式可以解决

问题2

No primary key could be found for table test_table. Please specify one with –split-by or perform a sequential import with ‘-m 1’.

原因和解决方法:sqoop导入时依赖于MySQL原表的主键索引进行切片,没有添加主键索引会报错,给原表加上 primary key 或者 在 命令行末尾 加上 -m 1

4. 导入实例

# 创建mysql表

CREATE TABLE `example` (

`id` int(11) NOT NULL,

`name` varchar(20) DEFAULT NULL,

PRIMARY KEY (`id`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8 # 插入数据

mysql> select * from example;

+----+-------+

| id | name |

+----+-------+

| 1 | hello |

| 2 | world |

+----+-------+

2 rows in set (0.00 sec) # 创建 hive 表

create table example(id int, name string) row format delimited fields terminated by '\t' lines terminated by '\n'; # 将mysql表导入hadoop

sqoop import -connect jdbc:mysql://localhost/test --username root --password mima123456 --table example # 将生成的文件导入hive

load data inpath 'hdfs://localhost:9000/user/max/example/part-m-00000' into table example # 以上两步可以合并为一步完成

sqoop import --connect jdbc:mysql://localhost/test --username root --password mima123456 --table example --hive-import --hive-overwrite --hive-table example --fields-terminated-by '\t'

mac安装Hadoop,mysql,hive,sqoop教程的更多相关文章

- mac安装配置mysql

目录 mac安装配置mysql 1.mysql的安装 2.设置root用户的密码 3.分别执行一下命令 4.配置mysql环境变量 mac安装配置mysql 1.mysql的安装 安装过程十分简单 ...

- Mac 安装配置Mysql

Mac下安装配置Mysql By 白熊花田(http://blog.csdn.net/whiterbear) 转载需注明出处,谢谢. 下载安装 去官网下载Community版本号的mysql安装文件. ...

- Mac安装Windows 10的简明教程

每次在Mac上安装Windows都是一件非常痛苦的事情,曾经为了装Win8把整台Mac的硬盘数据都弄丢了,最后通过龟速系统恢复模式恢复了MacOSX(50M电信光纤下载了3天才把系统下载完),相信和我 ...

- 新手安装 hadoop、hive和hbase 笔记

系统是ubuntu 12.04 , hadoop版本是1.2.1 , hive版本是0.12 , hbase版本我忘记了,不好意思首先是配置好hostnamevi /etc/hosts写入你要配置的i ...

- MySQL 5.7.13解压版安装记录 mysql无法启动教程

1 解压缩 2 添加环境变量,这个不细说了 我的电脑->属性->高级->环境变量 选择PATH,在其后面添加: 你的mysql bin文件夹的路径 (如:C:\Program Fil ...

- mac安装navicat mysql破解版

下载破解中文版http://m6.pc6.com/xuh6/navicat12027pre.zip 完成下载后无法正常进行安装,此时应该打开命令行执行 sudo spctl --master-disa ...

- Docker for Mac 安装及Mysql安装使用

启动 mysql 镜像 docker run -d -p 127.0.0.1:3306:3306 –name mysql -v /Users/flyrPc/docker/mysql/data:/var ...

- Mac安装LNMP环境,升级php7

Mac安装nginx+mysql+php 安装nginx比较麻烦,要安装pcre ftp://ftp.csx.cam.ac.uk/pub/software/programming/pcre ...

- Hadoop Hive概念学习系列之HDFS、Hive、MySQL、Sqoop之间的数据导入导出(强烈建议去看)

Hive总结(七)Hive四种数据导入方式 (强烈建议去看) Hive几种数据导出方式 https://www.iteblog.com/archives/955 (强烈建议去看) 把MySQL里的数据 ...

随机推荐

- Java实现 蓝桥杯VIP 算法训练 数的划分

[题目描述] 将整数n分成k份,且每份不能为空,任意两份不能相同(不考虑顺序). 例如:n=7,k=3,下面三种分法被认为是相同的. 1,1,5: 1,5,1: 5,1,1: 问有多少种不同的分法. ...

- Java实现 蓝桥杯VIP 算法提高 乘法运算

算法提高 乘法运算 时间限制:1.0s 内存限制:512.0MB 问题描述 编制一个乘法运算的程序. 从键盘读入2个100以内的正整数,进行乘法运算并以竖式输出. 输入格式 输入只有一行,是两个用空格 ...

- java实现第五届蓝桥杯神奇算式

神奇算式 题目描述 由4个不同的数字,组成的一个乘法算式,它们的乘积仍然由这4个数字组成. 比如: 210 x 6 = 1260 8 x 473 = 3784 27 x 81 = 2187 都符合要求 ...

- PAT 德才论

宋代史学家司马光在<资治通鉴>中有一段著名的“德才论”:“是故才德全尽谓之圣人,才德兼亡谓之愚人,德胜才谓之君子,才胜德谓之小人.凡取人之术,苟不得圣人,君子而与之,与其得小人,不若得愚人 ...

- JavaWeb+SVN+Maven+Tomcat +jenkins搭建持续集成环境和自动部署

https://blog.csdn.net/wh52788/article/details/80900477 https://blog.csdn.net/liyong1028826685/articl ...

- 浅谈python中的赋值、浅拷贝与深拷贝:

1.赋值----------是对原对象的引用,指向同一片内存地址 浅拷贝和深拷贝对于容器类型对象才有意义 2.浅拷贝----------对于一个对象的顶层进行拷贝 浅拷贝有三种方式: (1)切片 (2 ...

- PMBOK 基础知识(1)

启动.结束过程 项目管理计划 第一章 引论 第2章项目运行环境 第3章 项目经理的角色 第4章 项目整合管理 第5章 项目范围管理 第6章 项目进度管理 第7章 项目成本管理 第8章 项目质量管理 ...

- Python抽象类以及元类

抽象基类: 继承的约束与协议 __doc__ = """ 抽象基类: 继承的约束与协议 # 抽象基类 --- 有点java的味道,也有点golang的味道,继承,协议,接 ...

- 其他函数-web_concurrent

web_concurrent_start函数是并发组开始的标记.组中所有的函数是并发执行的,并发组的结束符为web_concurrent_end 函数. 在并发组中,可以包含的函数有: web_url ...

- css方法1(清除ul边距间隙,两端对齐,字母大写,首字放大)

一.清除ul自带左边间距 ul{ margin:; padding:; } 二.ul li 与li 之间隙 1.ul 设置font-size:0 ; 子li 设置字体大小 2.把li写到一起,不换行 ...