【二】Spark 核心

spark 核心

spark core

RDD创建 >>> RDD转换 >>> RDD缓存 >>> RDD行动 >>> RDD输出

RDD[Resilient Distributed Dataset]

它是一个弹性分布式数据集,具有良好的通用性、容错性与并行处理数据的能力,为用户屏蔽了底层对数据的复杂抽象和处理,为用户提供了一组方便的数据转换与求值方法。

弹性

- 存储弹性:n内存与磁盘d额自动切换

- 容错弹性:数据丢失可以自动恢复

- j计算的弹性:计算出错重试机制

- 分片弹性:根据需要重新分片

容错

通常在不同机器上备份数据或者记录数据更新的方式完成容错,但这种对任务密集型任务代价很高

RDD采用数据应用变换(map,filter,join),若部分数据丢失,RDD拥有足够的信息得知这部分数据是如何计算得到的,可通过重新计算来得到丢失的数据

这种恢复数据方法很快,无需大量数据复制操作,可以认为Spark是基于RDD模型的系统

懒操作

- 延迟计算,action的时候才操作

瞬时性

- 用时才产生,用完就释放

Spark允许从以下四个方面构建RDD

- 从共享文件系统中获取,如从HDFS中读数据构建RDD

val RDD = sc.textFile(“/xxx/yyy/file”)

- 通过现有RDD转换得到

val RDD = a.map(x => (x, 1))

- 定义一个scala数组

val RDD = sc.parallelize(1 to 10, 1)

- 有一个已经存在的RDD通过持久化操作生成

val RDD = a.persist(), a. saveAsHadoopFile(“/xxx/yyy/zzz”)

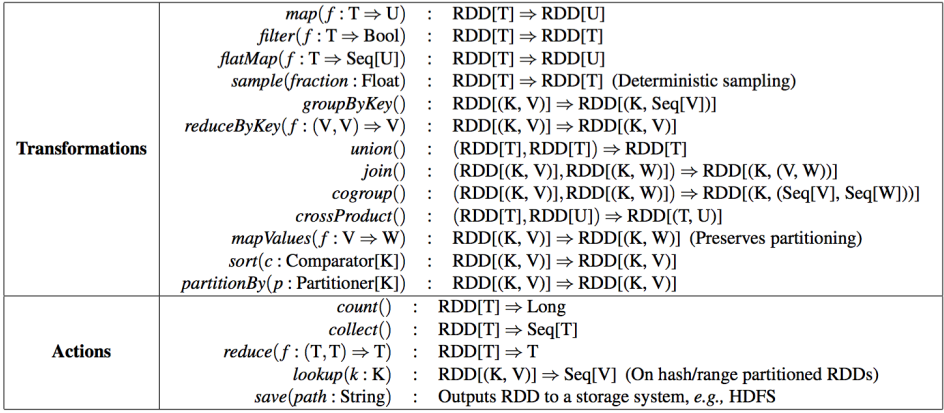

Spark针对RDD提供两类操作:transformations和action

transformations是RDD之间的变换,action会对数据执行一定的操作

transformations采用懒策略,仅在对相关RDD进行action提交时才触发计算

每个RDD包含了数据分块/分区(partition)的集合,每个partition是不可分割的

实际数据块的描述(实际数据到底存在哪,或者不存在)

其值依赖于哪些partition

与父RDD的依赖关系(rddA=>rddB)

宽依赖:B的每个partition依赖于A的所有partition

- 比如groupByKey、 reduceByKey、 join……,由A产生B时会先对A做shuffle分桶

窄依赖: B的每个partition依赖于A的常数个partition

- 比如map、 filter、 union……

RDD 依赖关系

窄依赖

每一个父RDD的Partition最多被子RDD的一个Partition使用

宽依赖

多个RDD的partition会依赖同一个父RDD的partition,会引起shuffle

【二】Spark 核心的更多相关文章

- spark浅谈(2):SPARK核心编程

一.SPARK-CORE 1.spark核心模块是整个项目的基础.提供了分布式的任务分发,调度以及基本的IO功能,Spark使用基础的数据结构,叫做RDD(弹性分布式数据集),是一个逻辑的数据分区的集 ...

- Spark核心—RDD初探

本文目的 最近在使用Spark进行数据清理的相关工作,初次使用Spark时,遇到了一些挑(da)战(ken).感觉需要记录点什么,才对得起自己.下面的内容主要是关于Spark核心-RDD的相关 ...

- Spark 核心篇-SparkContext

本章内容: 1.功能描述 本篇文章就要根据源码分析SparkContext所做的一些事情,用过Spark的开发者都知道SparkContext是编写Spark程序用到的第一个类,足以说明SparkCo ...

- Spark 核心篇-SparkEnv

本章内容: 1.功能概述 SparkEnv是Spark的执行环境对象,其中包括与众多Executor执行相关的对象.Spark 对任务的计算都依托于 Executor 的能力,所有的 Executor ...

- Netty 源码 Channel(二)核心类

Netty 源码 Channel(二)核心类 Netty 系列目录(https://www.cnblogs.com/binarylei/p/10117436.html) 一.Channel 类图 二. ...

- 科普Spark,Spark核心是什么,如何使用Spark(1)

科普Spark,Spark是什么,如何使用Spark(1)转自:http://www.aboutyun.com/thread-6849-1-1.html 阅读本文章可以带着下面问题:1.Spark基于 ...

- 2017.3.31 spring mvc教程(二)核心流程及配置详解

学习的博客:http://elf8848.iteye.com/blog/875830/ 我项目中所用的版本:4.2.0.博客的时间比较早,11年的,学习的是Spring3 MVC.不知道版本上有没有变 ...

- 大数据体系概览Spark、Spark核心原理、架构原理、Spark特点

大数据体系概览Spark.Spark核心原理.架构原理.Spark特点 大数据体系概览(Spark的地位) 什么是Spark? Spark整体架构 Spark的特点 Spark核心原理 Spark架构 ...

- spark核心优化详解

大家好!转眼又到了经验分享的时间了.吼吼,我这里没有摘要也没有引言,只有单纯的经验分享,请见谅哦! 言归正传,目前在大数据领域能够提供的核心计算的工具,如离线计算hadoop生态圈的mr计算模型,以及 ...

随机推荐

- ActiveMQ 用户名密码设置

用户名密码信息保存在conf/jetty-realm.properties文件中 按顺序分别是:用户名.密码.角色名 另:ActiveMQ使用的是jetty服务器, 可以通过设置conf/jetty. ...

- 《SQL必知必会》知识点汇总

select CustomerNo from dbo.Customers; 通配符的使用 select *from dbo.Customers; select CustomerNo from dbo. ...

- 深入浅出SharePoint2010——请假系统无代码篇之数据框架设计

文档库SOP:上传用户操作手册等系统相关文档. 员工信息列表EmployeeInfo:用来存储员工基本信息.直属领导和假卡信息. 请假申请列表LeaveRequest:申请人Requester填写请假 ...

- Redis数据的底层存储原理

redis底层是用什么结构来存储数据的呢? 我们从源码上去理解就会容易的多: redis底层是使用C语言来编写的,我们可以看到它的数据结构声明.一个 dict 有两个dictht,一个dictht ...

- 一个“日期”字符串进行比较的case

项目中有个功能是比较会员是否过期,review同事的代码,发现其写法比较奇葩,但线上竟也未出现bug. 实现大致如下: $expireTime = "2014-05-01 00:00:00& ...

- CF Gym 100637B Lunch(拆分子问题)

题意:在一条狭窄的沼泽上有一列数量为n的连续荷叶,编号为1-n.有一只蛤,在边s号荷叶上,其他荷叶上苍蝇,哈可以跳到相邻的荷叶上,或者越过一片荷叶,跳完以后原来的荷叶会沉,目标是f荷叶,在跳到f荷叶之 ...

- 组合数取模方法总结(Lucas定理介绍)

1.当n,m都很小的时候可以利用杨辉三角直接求. C(n,m)=C(n-1,m)+C(n-1,m-1): 2.n和m较大,但是p为素数的时候 Lucas定理是用来求 c(n,m) mod p,p为素数 ...

- 死磕salt系列-salt grains pillar 配置

grains 和 pillar 对比: Grains:存放静态数据,主要存储客户端的主机信息,重启grains会刷新. Pillar: 处理敏感数据, 处理差异性的文件. Grains数据系统 sal ...

- matlab中的unique函数详解

https://blog.csdn.net/sinat_40282753/article/details/78373532

- 【JavaScript】颜色选择器

颜色空间RGB与HSV(HSL)的转换 好文推荐:http://blog.csdn.net/jiangxinyu/article/details/8000999 从 HSV 到 RGB 的转换 类似的 ...