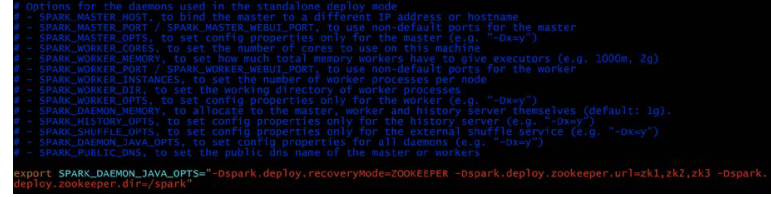

spark配置文件和执行部分代码

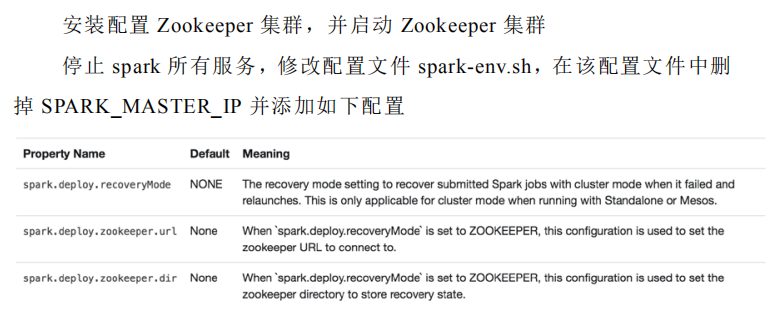

export SPARK_DAEMON_JAVA_OPTS="

-Dspark.deploy.recoveryMode=ZOOKEEPER

-Dspark.deploy.zookeeper.url=zk1,zk2,zk3

-Dspark.deploy.zookeeper.dir=/spark"

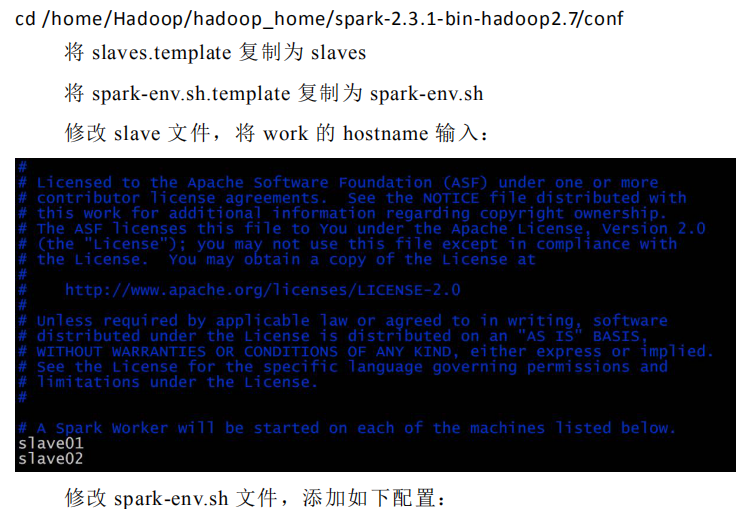

1.在 master01 节点上修改 slaves 配置文件内容指定 worker 节点

2.将配置文件同步到所有节点。

3.在 master01 上执行 sbin/start-all.sh 脚本,启动集群并启动第一个

master 节点,然后在 master02 上执行 sbin/start-master.sh 启动第二个 master

节点。

4.程序中 spark 集群的访问地址需要改成:

spark://master01:port1,master02:port2

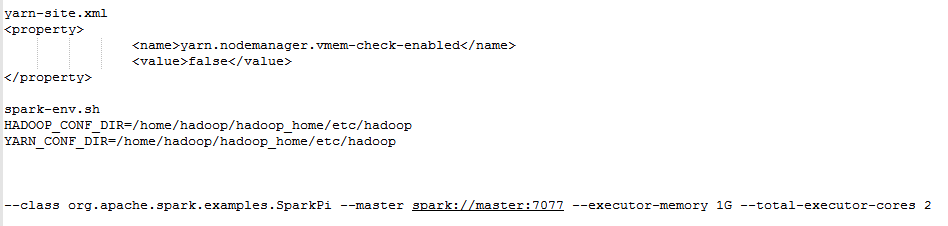

若想在集群上和yarn上运行,添加如下配置

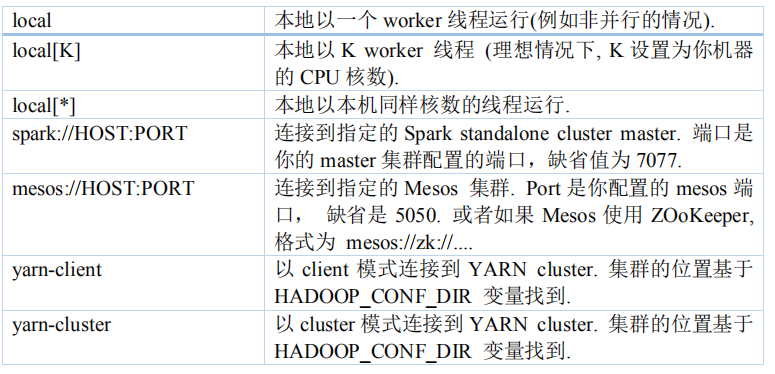

standalone client运行

spark-submit --master spark://master:7077 --class org.apache.spark.examples.SparkPi /home/hadoop/hadoop_home/spark/examples/jars/spark-examples_2.11-2.3.1.jar 100

standalone cluster运行

spark-submit --master spark://master:7077 --deploy-mode cluster --class org.apache.spark.examples.SparkPi /home/hadoop/hadoop_home/spark/examples/jars/spark-examples_2.11-2.3.1.jar 100

yarn client运行

spark-submit --master yarn --class org.apache.spark.examples.SparkPi /home/hadoop/hadoop_home/spark/examples/jars/spark-examples_2.11-2.3.1.jar 100

或者

spark-submit --master yarn --deploy-mode client --class org.apache.spark.examples.SparkPi /home/hadoop/hadoop_home/spark/examples/jars/spark-examples_2.11-2.3.1.jar 100

或者

spark-submit --master yarn-client --class org.apache.spark.examples.SparkPi /home/hadoop/hadoop_home/spark/examples/jars/spark-examples_2.11-2.3.1.jar 100

yarn cluster运行

spark-submit --master yarn-client --deploy-mode cluster --class org.apache.spark.examples.SparkPi /home/hadoop/hadoop_home/spark/examples/jars/spark-examples_2.11-2.3.1.jar 100

或者

spark-submit --master yarn-cluster --class org.apache.spark.examples.SparkPi /home/hadoop/hadoop_home/spark/examples/jars/spark-examples_2.11-2.3.1.jar 100

8080 是 Spark WEBUI 界面的端口,7077 是 Spark 任务提交的端口。

修改 master 的 WEBUI 端口:

修改 start-master.sh 即可。

spark配置文件和执行部分代码的更多相关文章

- 从源码剖析一个Spark WordCount Job执行的全过程

原文地址:http://mzorro.me/post/55c85d06e40daa9d022f3cbd WordCount可以说是分布式数据处理框架的”Hello World”,我们可以以它为 ...

- Spark性能调优之代码方面的优化

Spark性能调优之代码方面的优化 1.避免创建重复的RDD 对性能没有问题,但会造成代码混乱 2.尽可能复用同一个RDD,减少产生RDD的个数 3.对多次使用的RDD进行持久化(ca ...

- 【原创】大数据基础之Spark(3)Spark Thrift实现原理及代码实现

spark 2.1.1 一 启动命令 启动spark thrift命令 $SPARK_HOME/sbin/start-thriftserver.sh 然后会执行 org.apache.spark.de ...

- 大话Spark(3)-一图深入理解WordCount程序在Spark中的执行过程

本文以WordCount为例, 画图说明spark程序的执行过程 WordCount就是统计一段数据中每个单词出现的次数, 例如hello spark hello you 这段文本中hello出现2次 ...

- Spark源码执行逻辑分析【基于案例SparkPi】

一.案例SparkPi代码 package scala import org.apache.spark.sql.SparkSession import scala.math.random /** Co ...

- 大数据学习day34---spark14------1 redis的事务(pipeline)测试 ,2. 利用redis的pipeline实现数据统计的exactlyonce ,3 SparkStreaming中数据写入Hbase实现ExactlyOnce, 4.Spark StandAlone的执行模式,5 spark on yarn

1 redis的事务(pipeline)测试 Redis本身对数据进行操作,单条命令是原子性的,但事务不保证原子性,且没有回滚.事务中任何命令执行失败,其余的命令仍会被执行,将Redis的多个操作放到 ...

- Spring练习,使用Properties类型注入方式,注入MySQL数据库连接的基本信息,然后使用JDBC方式连接数据库,模拟执行业务代码后释放资源,最后在控制台输出打印结果。

相关 知识 >>> 相关 练习 >>> 实现要求: 使用Properties类型注入方式,注入MySQL数据库连接的基本信息,然后使用JDBC方式连接数据库,模拟执 ...

- Spark SQL底层执行流程详解

本文目录 一.Apache Spark 二.Spark SQL发展历程 三.Spark SQL底层执行原理 四.Catalyst 的两大优化 一.Apache Spark Apache Spark是用 ...

- Lua 学习笔记(七)编译、执行外部代码块

Lua称为解释型语言的原因:Lua允许在运行源代码之前,先将源代码预编译为一种中间形式.区别解释型语言的主要特征是在于编译器是否是语言运行时库的一部分,即有能力执行动态生成的代码.因为Lua中有dof ...

随机推荐

- PHP代码实现 1

$PHP-SRC/run-test.php 因为如果在同一个进程中执行, 测试就会停止,后面的测试也将无法执行,php中有很多将脚本隔离的方法比如: system(),exec()等函数,这样可以使用 ...

- Python 迭代对象、迭代器、生成器

原文出处: liuzhijun 本文源自RQ作者的一篇博文,原文是Iterables vs. Iterators vs. Generators,俺写的这篇文章是按照自己的理解做的参考翻译,算不上是原文 ...

- ASI和TS流有什么区别

TS流是信源码流,最高码率为44.209 Mbit/s,它是经过信源编码后的压缩码流,为了使欲传输的信源信息在传输速率一定的条件下更快更多地传输,还要把数据进行压缩,也就是通过信源编码去掉信息中多余的 ...

- eclipse 的安装和汉化

第一步:直接百度搜索eclipse,第一个就是官方网站 第二步:点击DOWNLOAD 64BIT进入下载页面 第三步:点击DOWNLOAD进行下载 If the download doesn't st ...

- WinForm各浏览器内核控件

WebKit.NET webkit-sharp CefSharp awesomium OpenWebKitSharp geckofx MozNet Web Component

- 微博短链接的生成算法(Java版本)

最近看到微博的短链接真是很火啊,新浪.腾讯.搜狐等微博网站都加入了短链接的功能.之所以要是使用短链接,主要是因为微博只允许发140 字,如果链接地址太长的话,那么发送的字数将大大减少.短链接的主要职责 ...

- mysql 8.0 初识

1 下载并安装mysql 8.0官网下载比较慢,这里选择163的镜像http://mirrors.163.com/mysql/Downloads/MySQL-8.0/下载版本mysql-8.0.14- ...

- hadoop2.6.0的eclipse插件编译和设置

编译hadoop2.6.0的eclipse插件 下载源码: git clone https://github.com/winghc/hadoop2x-eclipse-plugin.git 编译源码: ...

- android.support.v7.internal.widget.ActionBarOverlayLayout Couldn't Be Initialized

问题症状: Android Studio 1.2 (Build 141.1890965) 新建工程,自动build完成后,Layout Editor无法预览Layout文件,报错内容: Renderi ...

- js 各种距离

网页可见区域宽 document.body.clientWidth 网页可见区域高 document.body.clientHeight 网页可见区域宽(包括边线的宽) document.b ...