Spark2.1.0编译

1.下载spark源码包

http://spark.apache.org/downloads.html

2.安装Scala与maven,解压spark源码包

安装Scala:

tar zxf scala-2.11.8.tar

修改vim /etc/profile

export SCALA_HOME=/usr/scala/scala-2.11.8

export PATH=$PATH:$SCALA_HOME/bin

安装maven

tar zxf apache-maven-3.3.9.tar

修改vim /etc/profile

export MAVEN_HOME=/usr/maven/apache-maven-3.3.9

export PATH=${MAVEN_HOME}/bin:${PATH}

解压:

cd /opt/spark

tar zxf spark-2.1.0.tgz

3.maven编译spark

(1)添加内存

export MAVEN_OPTS="-Xmx8g -XX:MaxPermSize=512M -XX:ReservedCodeCacheSize=2048M"

(2)修改spark的pom.xml文件中央仓库

CDH的中央仓库https://repository.cloudera.com/content/repositories/releases/

阿里云的中央仓库http://maven.aliyun.com/nexus/content/groups/public/

(3)在spark的pom.xml文件修改hadoop版本

hadoop-2.6.0

(4)maven编译

mvn -Phadoop-2.6 -Dhadoop.version=2.6.0-CDH5.10.0 -Pyarn -Phive -Phive-thriftserver -DskipTests -T 4 -Uclean package

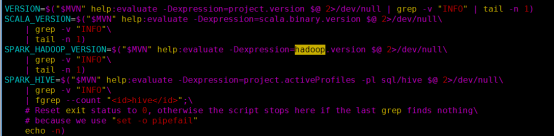

4.make-distribution.sh打包spark

(1)注释make-distribution.sh中maven部分

vim /opt/spark/spark-2.1.0/dev/make-distribution.sh

(2)添加版本号

VERSION=2.1.0

SCALA_VERSION=2.11.8

SPARK_HADOOP_VERSION=2.6.0-CDH5.10.0

SPARK_HIVE=1.2.1

(3)执行make-distribution.sh命令

./make-distribution.sh --tgz

(4)打包成功

spark-2.1.O-bin-2.6.0-CDH5.10.0.tgz

Spark2.1.0编译的更多相关文章

- Spark2.0编译

Spark2.0编译 1 前言 Spark2.0正式版于今天正式发布,本文基于CDH5.0.2的Spark编译. 2 编译步骤 #2.1 下载源码 wget https://github.com/ap ...

- mac os x 编译spark-2.1.0 for hadoop-2.7.3

mac os x maven编译spark-2.1.0 for hadoop-2.7.3 1.官方文档中要求安装Maven 3.3.9+ 和Java 8 ; 2.执行 export ...

- Spark记录-源码编译spark2.2.0(结合Hive on Spark/Hive on MR2/Spark on Yarn)

#spark2.2.0源码编译 #组件:mvn-3.3.9 jdk-1.8 #wget http://mirror.bit.edu.cn/apache/spark/spark-2.2.0/spark- ...

- spark2.1.0的源码编译

本文介绍spark2.1.0的源码编译 1.编译环境: Jdk1.8或以上 Hadoop2.7.3 Scala2.10.4 必要条件: Maven 3.3.9或以上(重要) 点这里下载 http:// ...

- Spark2.1.0——运行环境准备

学习一个工具的最好途径,就是使用它.这就好比<极品飞车>玩得好的同学,未必真的会开车,要学习车的驾驶技能,就必须用手触摸方向盘.用脚感受刹车与油门的力道.在IT领域,在深入了解一个系统的原 ...

- Spark2.1.0——Spark初体验

学习一个工具的最好途径,就是使用它.这就好比<极品飞车>玩得好的同学,未必真的会开车,要学习车的驾驶技能,就必须用手触摸方向盘.用脚感受刹车与油门的力道.在IT领域,在深入了解一个系统的原 ...

- Hadoop 3.1.2(HA)+Zookeeper3.4.13+Hbase1.4.9(HA)+Hive2.3.4+Spark2.4.0(HA)高可用集群搭建

目录 目录 1.前言 1.1.什么是 Hadoop? 1.1.1.什么是 YARN? 1.2.什么是 Zookeeper? 1.3.什么是 Hbase? 1.4.什么是 Hive 1.5.什么是 Sp ...

- spark最新源码下载并导入到开发环境下助推高质量代码(Scala IDEA for Eclipse和IntelliJ IDEA皆适用)(以spark2.2.0源码包为例)(图文详解)

不多说,直接上干货! 前言 其实啊,无论你是初学者还是具备了有一定spark编程经验,都需要对spark源码足够重视起来. 本人,肺腑之己见,想要成为大数据的大牛和顶尖专家,多结合源码和操练编程. ...

- Spark2.1.0模型设计与基本架构(上)

随着近十年互联网的迅猛发展,越来越多的人融入了互联网——利用搜索引擎查询词条或问题:社交圈子从现实搬到了Facebook.Twitter.微信等社交平台上:女孩子们现在少了逛街,多了在各大电商平台上的 ...

随机推荐

- ASP.NET MVC与WebForm对比

MVC优点:1.分离更彻底,分层清晰,易于维护和扩展.2.验证更加方便快捷.3.无ViewState,页面更加干净4.路由更容易定义url,对SEO比较好.5.强类型VIEW实现,更安全高效. Web ...

- spring学习总结(一)_Ioc基础(下)

本篇文章继续上篇文章讲解Ioc基础,这篇文章主要介绍零配置实现ioc,现在相信大家项目中也基本都是没有了xml配置文件.废话不多说.一起学习 代码示例 BookDao.java package com ...

- Lodop打印控件里SET_PRINT_STYLE和SET_PRINT_STYLEA

LODOP.SET_PRINT_STYLE 对该语句后面的打印项样式设置效果.LODOP.SET_PRINT_STYLEA 针对第一个参数设置的打印项样式设置效果.这两个语句,作用范围不同. 在设置字 ...

- BZOJ4551[Tjoi2016&Heoi2016]树——dfs序+线段树/树链剖分+线段树

题目描述 在2016年,佳媛姐姐刚刚学习了树,非常开心.现在他想解决这样一个问题:给定一颗有根树(根为1),有以下 两种操作:1. 标记操作:对某个结点打上标记(在最开始,只有结点1有标记,其他结点均 ...

- BZOJ1195[HNOI2006]最短母串——AC自动机+BFS+状态压缩

题目描述 给定n个字符串(S1,S2,„,Sn),要求找到一个最短的字符串T,使得这n个字符串(S1,S2,„,Sn)都是T的子串. 输入 第一行是一个正整数n(n<=12),表示给定的字符串的 ...

- Code First 重复外键

原因:在一个表中,我有如下字段 表名:orderInfo 列名:companySend,companyReceiver 先展示表结构,(手打了,见谅) public class OrderInfo { ...

- MT【8】和e有关的一个极限

解答: 评:这里涉及到e有关的极限的单调性,求导数得:

- 洛谷P2257 YY的GCD

今日份是数论 大概是..从小学奥数到渐渐毒瘤 那就简单列一下目录[大雾 同余 质数密度 唯一分解定理 互质 完全剩余系 简化剩余系 欧拉函数 逆元 斐蜀定理 阶(及其性质) 欧拉定理 费马小定理 原根 ...

- BZOJ 3526: [Poi2014]Card

3526: [Poi2014]Card Time Limit: 25 Sec Memory Limit: 64 MBSubmit: 267 Solved: 191[Submit][Status][ ...

- luogu2607/bzoj1040 [ZJOI2008]骑士 (基环树形dp)

N个点,每个点发出一条边,那么这个图的形状一定是一个基环树森林(如果有重边就会出现森林) 那我做f[0][x]和f[1][x]分别表示对于x子树,x这个点选还是不选所带来的最大价值 然后就变成了这好几 ...