【强化学习】python 实现 q-learning 例五(GUI)

本文作者:hhh5460

本文地址:https://www.cnblogs.com/hhh5460/p/10143579.html

感谢pengdali,本文的 class Maze 参考了他的博客,地址:https://blog.csdn.net/pengdali/article/details/79369966

0.问题情境

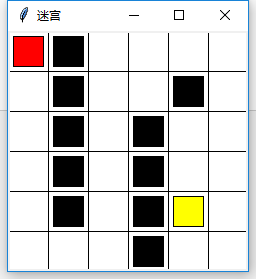

一个6*6的迷宫,左上角入口,右下角出口。红色矩形为玩家,黑色矩形为陷阱,黄色矩形为元宝。如图

1.问题分析

将二维问题转化为一维问题,并解决之。

状态集:[0,1,..,35],0~35,共36个。

动作集:['u', 'd', 'l', 'r'],上下左右,共4个。

奖励集:[0,-10,0,0,...,10],每个位置一个奖励值,共36个。其中空白位置0,陷阱-10,元宝3,出口10(随便)

那么,接下来需要从上三个集合中选择相应的元素或子集,用一维的方式比二维的方式更简便。其方法与前面的例子是类似的,只需要改变首末两行、两列的值即可!这里不细说了。

2.完整代码

import pandas as pd

import random

import time

import pickle

import pathlib

import os

import tkinter as tk '''

6*6 的迷宫:

-------------------------------------------

| 入口 | 陷阱 | | | | |

-------------------------------------------

| | 陷阱 | | | 陷阱 | |

-------------------------------------------

| | 陷阱 | | 陷阱 | | |

-------------------------------------------

| | 陷阱 | | 陷阱 | | |

-------------------------------------------

| | 陷阱 | | 陷阱 | 元宝 | |

-------------------------------------------

| | | | 陷阱 | | 出口 |

------------------------------------------- 作者:hhh5460

时间:20181219

地点:Tai Zi Miao

''' class Maze(tk.Tk):

'''环境类(GUI)'''

UNIT = 40 # pixels

MAZE_H = 6 # grid height

MAZE_W = 6 # grid width def __init__(self):

'''初始化'''

super().__init__()

self.title('迷宫')

h = self.MAZE_H * self.UNIT

w = self.MAZE_W * self.UNIT

self.geometry('{0}x{1}'.format(h, w)) #窗口大小

self.canvas = tk.Canvas(self, bg='white', height=h, width=w)

# 画网格

for c in range(0, w, self.UNIT):

self.canvas.create_line(c, 0, c, h)

for r in range(0, h, self.UNIT):

self.canvas.create_line(0, r, w, r)

# 画陷阱

self._draw_rect(1, 0, 'black')

self._draw_rect(1, 1, 'black')

self._draw_rect(1, 2, 'black')

self._draw_rect(1, 3, 'black')

self._draw_rect(1, 4, 'black')

self._draw_rect(3, 2, 'black')

self._draw_rect(3, 3, 'black')

self._draw_rect(3, 4, 'black')

self._draw_rect(3, 5, 'black')

self._draw_rect(4, 1, 'black')

# 画奖励

self._draw_rect(4, 4, 'yellow')

# 画玩家(保存!!)

self.rect = self._draw_rect(0, 0, 'red')

self.canvas.pack() # 显示画作! def _draw_rect(self, x, y, color):

'''画矩形, x,y表示横,竖第几个格子'''

padding = 5 # 内边距5px,参见CSS

coor = [self.UNIT * x + padding, self.UNIT * y + padding, self.UNIT * (x+1) - padding, self.UNIT * (y+1) - padding]

return self.canvas.create_rectangle(*coor, fill = color) def move_to(self, state, delay=0.01):

'''玩家移动到新位置,根据传入的状态'''

coor_old = self.canvas.coords(self.rect) # 形如[5.0, 5.0, 35.0, 35.0](第一个格子左上、右下坐标)

x, y = state % 6, state // 6 #横竖第几个格子

padding = 5 # 内边距5px,参见CSS

coor_new = [self.UNIT * x + padding, self.UNIT * y + padding, self.UNIT * (x+1) - padding, self.UNIT * (y+1) - padding]

dx_pixels, dy_pixels = coor_new[0] - coor_old[0], coor_new[1] - coor_old[1] # 左上角顶点坐标之差

self.canvas.move(self.rect, dx_pixels, dy_pixels)

self.update() # tkinter内置的update!

time.sleep(delay) class Agent(object):

'''个体类'''

def __init__(self, alpha=0.1, gamma=0.9):

'''初始化'''

self.states = range(36) # 状态集。0~35 共36个状态

self.actions = list('udlr') # 动作集。上下左右 4个动作

self.rewards = [0,-10,0, 0, 0, 0,

0,-10,0, 0,-10, 0,

0,-10,0,-10, 0, 0,

0,-10,0,-10, 0, 0,

0,-10,0,-10, 3, 0,

0, 0,0,-10, 0,10,] # 奖励集。出口奖励10,陷阱奖励-10,元宝奖励5

self.hell_states = [1,7,13,19,25,15,31,37,43,10] # 陷阱位置 self.alpha = alpha

self.gamma = gamma self.q_table = pd.DataFrame(data=[[0 for _ in self.actions] for _ in self.states],

index=self.states,

columns=self.actions) def save_policy(self):

'''保存Q table'''

with open('q_table.pickle', 'wb') as f:

# Pickle the 'data' dictionary using the highest protocol available.

pickle.dump(self.q_table, f, pickle.HIGHEST_PROTOCOL) def load_policy(self):

'''导入Q table'''

with open('q_table.pickle', 'rb') as f:

self.q_table = pickle.load(f) def choose_action(self, state, epsilon=0.8):

'''选择相应的动作。根据当前状态,随机或贪婪,按照参数epsilon'''

#if (random.uniform(0,1) > epsilon) or ((self.q_table.ix[state] == 0).all()): # 探索

if random.uniform(0,1) > epsilon: # 探索

action = random.choice(self.get_valid_actions(state))

else:

#action = self.q_table.ix[state].idxmax() # 利用 当有多个最大值时,会锁死第一个!

#action = self.q_table.ix[state].filter(items=self.get_valid_actions(state)).idxmax() # 重大改进!然鹅与上面一样

s = self.q_table.ix[state].filter(items=self.get_valid_actions(state))

action = random.choice(s[s==s.max()].index) # 从可能有多个的最大值里面随机选择一个!

return action def get_q_values(self, state):

'''取给定状态state的所有Q value'''

q_values = self.q_table.ix[state, self.get_valid_actions(state)]

return q_values def update_q_value(self, state, action, next_state_reward, next_state_q_values):

'''更新Q value,根据贝尔曼方程'''

self.q_table.ix[state, action] += self.alpha * (next_state_reward + self.gamma * next_state_q_values.max() - self.q_table.ix[state, action]) def get_valid_actions(self, state):

'''取当前状态下所有的合法动作'''

valid_actions = set(self.actions)

if state % 6 == 5: # 最后一列,则

valid_actions -= set(['r']) # 无向右的动作

if state % 6 == 0: # 最前一列,则

valid_actions -= set(['l']) # 无向左

if state // 6 == 5: # 最后一行,则

valid_actions -= set(['d']) # 无向下

if state // 6 == 0: # 最前一行,则

valid_actions -= set(['u']) # 无向上

return list(valid_actions) def get_next_state(self, state, action):

'''对状态执行动作后,得到下一状态'''

#u,d,l,r,n = -6,+6,-1,+1,0

if state % 6 != 5 and action == 'r': # 除最后一列,皆可向右(+1)

next_state = state + 1

elif state % 6 != 0 and action == 'l': # 除最前一列,皆可向左(-1)

next_state = state - 1

elif state // 6 != 5 and action == 'd': # 除最后一行,皆可向下(+2)

next_state = state + 6

elif state // 6 != 0 and action == 'u': # 除最前一行,皆可向上(-2)

next_state = state - 6

else:

next_state = state

return next_state def learn(self, env=None, episode=1000, epsilon=0.8):

'''q-learning算法'''

print('Agent is learning...')

for i in range(episode):

current_state = self.states[0] if env is not None: # 若提供了环境,则重置之!

env.move_to(current_state) while current_state != self.states[-1]:

current_action = self.choose_action(current_state, epsilon) # 按一定概率,随机或贪婪地选择

next_state = self.get_next_state(current_state, current_action)

next_state_reward = self.rewards[next_state]

next_state_q_values = self.get_q_values(next_state)

self.update_q_value(current_state, current_action, next_state_reward, next_state_q_values)

current_state = next_state #if next_state not in self.hell_states: # 非陷阱,则往前;否则待在原位

# current_state = next_state if env is not None: # 若提供了环境,则更新之!

env.move_to(current_state)

print(i)

print('\nok') def test(self):

'''测试agent是否已具有智能'''

count = 0

current_state = self.states[0]

while current_state != self.states[-1]:

current_action = self.choose_action(current_state, 1.) # 1., 贪婪

next_state = self.get_next_state(current_state, current_action)

current_state = next_state

count += 1 if count > 36: # 没有在36步之内走出迷宫,则

return False # 无智能 return True # 有智能 def play(self, env=None, delay=0.5):

'''玩游戏,使用策略'''

assert env != None, 'Env must be not None!' if not self.test(): # 若尚无智能,则

if pathlib.Path("q_table.pickle").exists():

self.load_policy()

else:

print("I need to learn before playing this game.")

self.learn(env, episode=1000, epsilon=0.5)

self.save_policy() print('Agent is playing...')

current_state = self.states[0]

env.move_to(current_state, delay)

while current_state != self.states[-1]:

current_action = self.choose_action(current_state, 1.) # 1., 贪婪

next_state = self.get_next_state(current_state, current_action)

current_state = next_state

env.move_to(current_state, delay)

print('\nCongratulations, Agent got it!') if __name__ == '__main__':

env = Maze() # 环境

agent = Agent() # 个体(智能体)

#agent.learn(env, episode=1000, epsilon=0.6) # 先学习

#agent.save_policy()

#agent.load_policy()

agent.play(env) # 再玩耍 #env.after(0, agent.learn, env, 1000, 0.8) # 先学

#env.after(0, agent.save_policy) # 保存所学

#env.after(0, agent.load_policy) # 导入所学

#env.after(0, agent.play, env) # 再玩

env.mainloop()

重大改进:Agent.choose_action()。之前贪婪的时候直接用idxmax(),会锁死第一个最大值对应的方向!

【强化学习】python 实现 q-learning 例五(GUI)的更多相关文章

- 深度强化学习(DQN-Deep Q Network)之应用-Flappy Bird

深度强化学习(DQN-Deep Q Network)之应用-Flappy Bird 本文系作者原创,转载请注明出处:https://www.cnblogs.com/further-further-fu ...

- 机器学习之强化学习概览(Machine Learning for Humans: Reinforcement Learning)

声明:本文翻译自Vishal Maini在Medium平台上发布的<Machine Learning for Humans>的教程的<Part 5: Reinforcement Le ...

- 深度强化学习(Deep Reinforcement Learning)入门:RL base & DQN-DDPG-A3C introduction

转自https://zhuanlan.zhihu.com/p/25239682 过去的一段时间在深度强化学习领域投入了不少精力,工作中也在应用DRL解决业务问题.子曰:温故而知新,在进一步深入研究和应 ...

- 【转】【强化学习】Deep Q Network(DQN)算法详解

原文地址:https://blog.csdn.net/qq_30615903/article/details/80744083 DQN(Deep Q-Learning)是将深度学习deeplearni ...

- [Reinforcement Learning] 强化学习介绍

随着AlphaGo和AlphaZero的出现,强化学习相关算法在这几年引起了学术界和工业界的重视.最近也翻了很多强化学习的资料,有时间了还是得自己动脑筋整理一下. 强化学习定义 先借用维基百科上对强化 ...

- Deep Learning专栏--强化学习之从 Policy Gradient 到 A3C(3)

在之前的强化学习文章里,我们讲到了经典的MDP模型来描述强化学习,其解法包括value iteration和policy iteration,这类经典解法基于已知的转移概率矩阵P,而在实际应用中,我们 ...

- 深度强化学习(DRL)专栏(一)

目录: 1. 引言 专栏知识结构 从AlphaGo看深度强化学习 2. 强化学习基础知识 强化学习问题 马尔科夫决策过程 最优价值函数和贝尔曼方程 3. 有模型的强化学习方法 价值迭代 策略迭代 4. ...

- (转) 深度强化学习综述:从AlphaGo背后的力量到学习资源分享(附论文)

本文转自:http://mp.weixin.qq.com/s/aAHbybdbs_GtY8OyU6h5WA 专题 | 深度强化学习综述:从AlphaGo背后的力量到学习资源分享(附论文) 原创 201 ...

- 强化学习论文(Scalable agent alignment via reward modeling: a research direction)

原文地址: https://arxiv.org/pdf/1811.07871.pdf ======================================================== ...

- Ubuntu下常用强化学习实验环境搭建(MuJoCo, OpenAI Gym, rllab, DeepMind Lab, TORCS, PySC2)

http://lib.csdn.net/article/aimachinelearning/68113 原文地址:http://blog.csdn.net/jinzhuojun/article/det ...

随机推荐

- EventBus结合rxjava2和retrofit2网络获取

依赖: compile 'com.squareup.retrofit2:converter-gson:2.3.0'compile 'com.squareup.retrofit2:retrofit:2. ...

- gitlab-ci的注意点

在使用gitlab搭配gitlab-runner进行ci配置时,发现两个问题,略记如下备忘: 1. 若发现ci job控制台显示无法下载该项目,但当前提交代码人和ci用户都确实具备该项目的访问权限时, ...

- Django 知识总结(一)

Django已经学过的知识点: 1. Urls.py 路由系统: 正则 分组匹配 --> 位置参数 分组命名匹配 --> 关键字参数 分级路由 include 给路由起别名 name=&q ...

- EF的CodeFirst模式自动迁移(适用于开发环境)

EF的CodeFirst模式自动迁移(适用于开发环境) 1.开启EF数据迁移功能 NuGet包管理器------>程序包管理控制台---------->Enable-Migrations ...

- HCNA网络技术命令

1.display version 显示系统软件版本及硬件信息 2.system-view 切换到系统视图 3.quit 切换回用户视图 4.return 从任意非用户视图退回到用户视图 5.sysn ...

- SQL 三范式

第一范式:无重复的列,一列只能包含一个字段 第二范式:主键约束,一行只能被唯一标识 第三范式:非主键字段要严格依赖于主键字段

- Git命令实现本地文件推送到git仓库

前提: ①确定本机(windows环境)已经安装git(https://git-scm.com/downloads) ②建立好远程Git仓库 1.在你想推送的文件夹下:右键→选择Git Bath ...

- C#接口的显隐实现

显示接口实现与隐式接口实现 何为显式接口实现.隐式接口实现?简单概括,使用接口名作为方法名的前缀,这称为“显式接口实现”:传统的实现方式,称为“隐式接口实现”.下面给个例子. IChineseGree ...

- 使用requests模块post payload请求

import json import requests import datetime postUrl = 'https://sellercentral.amazon.com/fba/profitab ...

- python第四十五课——继承性之多继承

测试模块 演示多继承的结构和使用: 子类:Child 直接父类(多个):Father.Mother 注意: 由于有多个直接父类,多个父类都要自己给其属性赋值, 避免混淆,我们使用类名.__init__ ...