057 Java中kafka的Producer程序实现

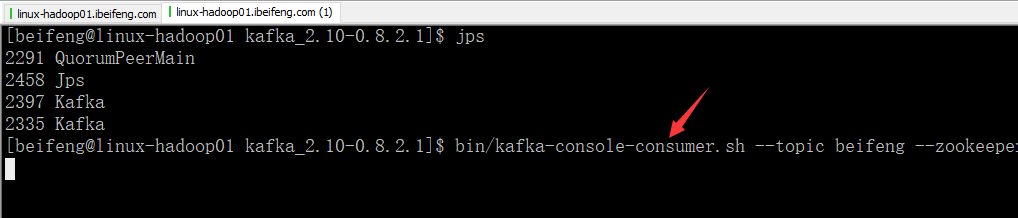

1.需要启动的服务

这里启动的端口是9092。

bin/kafka-console-consumer.sh --topic beifeng --zookeeper linux-hadoop01.ibeifeng.com:2181/kafka

2.producer的程序

package com.jun.it;

import kafka.javaapi.producer.Producer;

import kafka.producer.KeyedMessage;

import kafka.producer.ProducerConfig;

import java.util.Properties;

import java.util.Random;

import java.util.concurrent.atomic.AtomicBoolean;

public class JavaKafkaProducer {

public static final char[] chars = "qazwsxedcrfvtgbyhnujmikolp0123456789".toCharArray();

public static final int charsLength = chars.length;

public static final Random random = new Random(System.currentTimeMillis());

private Producer<String, String> producer = null; private String topicName = null;

private String brokerList = null;

private boolean isSync = true; // 默认为同步 /**

* 构造函数

*

* @param topicName

* @param brokerList

*/

public JavaKafkaProducer(String topicName, String brokerList) {

this(topicName, brokerList, true);

} /**

* 构造函数,主要是产生producer

*

* @param topicName

* @param brokerList

* @param isSync

*/

public JavaKafkaProducer(String topicName, String brokerList, boolean isSync) {

// 赋值

this.topicName = topicName;

this.brokerList = brokerList;

this.isSync = isSync; // 1. 给定配置信息:参考http://kafka.apache.org/082/documentation.html#producerconfigs

Properties props = new Properties();

// kafka集群的连接信息

props.put("metadata.broker.list", this.brokerList);

// kafka发送数据方式

if (this.isSync) {

// 同步发送数据

props.put("producer.type", "sync");

} else {

// 异步发送数据

props.put("producer.type", "async");

/**

* 0: 不等待broker的返回

* 1: 表示至少等待1个broker返回结果

* -1:表示等待所有broker返回数据接收成功的结果

*/

props.put("request.required.acks", "0");

}

// key/value数据序列化的类

/**

* 默认是:DefaultEncoder, 指发送的数据类型是byte类型

* 如果发送数据是string类型,必须更改StringEncoder

*/

props.put("serializer.class", "kafka.serializer.StringEncoder"); // 2. 构建Kafka的Producer Configuration上下文

ProducerConfig config = new ProducerConfig(props); // 3. 构建Kafka的生产者:Producerr

this.producer = new Producer<String, String>(config);

} /**

* 关闭producer连接

*/

public void closeProducer() {

producer.close();

} /**

* 提供给外部应用调用的直接运行发送数据代码的方法

*

* @param threadNumbers

* @param isRunning

*/

public void run(int threadNumbers, final AtomicBoolean isRunning) {

for (int i = 0; i < threadNumbers; i++) {

new Thread(new Runnable() {

public void run() {

int count = 0;

while (isRunning.get()) {

// 只有在运行状态的情况下,才发送数据

KeyedMessage<String, String> message = generateMessage();

// 发送数据

producer.send(message);

count++;

// 打印一下

if (count % 100 == 0) {

System.out.println("Count = " + count + "; message:" + message);

} // 假设需要休息一下

try {

Thread.sleep(random.nextInt(100) + 10);

} catch (InterruptedException e) {

// nothings

}

}

System.out.println("Thread:" + Thread.currentThread().getName() + " send message count is:" + count);

}

}).start();

}

} /**

* 产生一个随机的Kafka的KeyedMessage对象

*

* @return

*/

public KeyedMessage<String, String> generateMessage() {

String key = generateString(3) + "_" + random.nextInt(10);

StringBuilder sb = new StringBuilder();

int numWords = random.nextInt(5) + 1; // [1,5]单词

for (int i = 0; i < numWords; i++) {

String word = generateString(random.nextInt(5) + 1); // 单词中字符最少1个最多5个

sb.append(word).append(" ");

}

String message = sb.toString().trim();

return new KeyedMessage(this.topicName, key, message);

} /**

* 随机生产一个给定长度的字符串

*

* @param numItems

* @return

*/

public static String generateString(int numItems) {

StringBuilder sb = new StringBuilder();

for (int i = 0; i < numItems; i++) {

sb.append(chars[random.nextInt(charsLength)]);

}

return sb.toString();

}

}

3.测试类

package com.jun.it;

import java.util.concurrent.atomic.AtomicBoolean;

public class JavaKafkaProducerTest {

public static void main(String[] args) {

String topicName = "beifeng";

String brokerList = "linux-hadoop01.ibeifeng.com:9092,linux-hadoop01.ibeifeng.com:9093";

int threadNums = 10;

AtomicBoolean isRunning = new AtomicBoolean(true);

JavaKafkaProducer producer = new JavaKafkaProducer(topicName, brokerList);

producer.run(threadNums, isRunning);

// 停留60秒后,进行关闭操作

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

// nothings

}

isRunning.set(false);

// 关闭连接

producer.closeProducer();

}

}

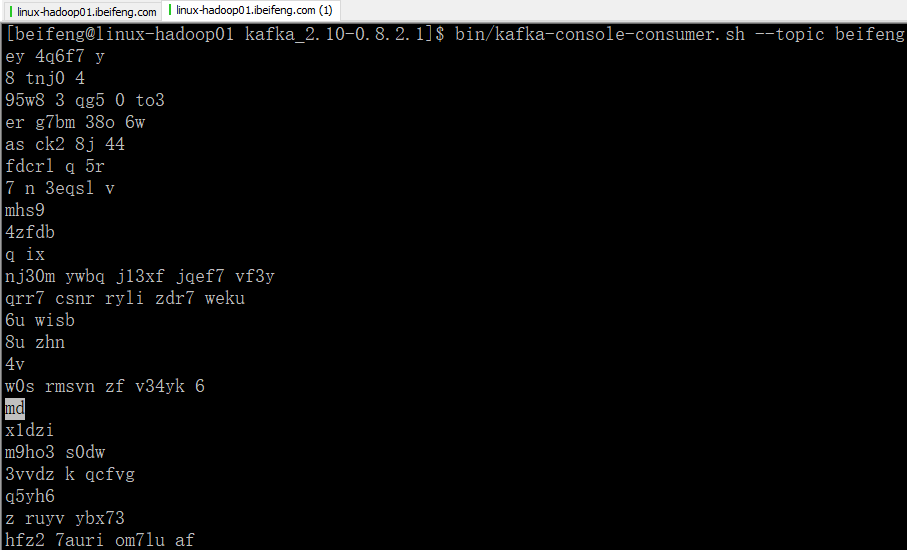

4.效果

二:使用自定义的分区器

1.分区器

package com.jun.it; import kafka.producer.Partitioner;

import kafka.utils.VerifiableProperties; public class JavaKafkaPartitioner implements Partitioner {

/**

* 默认无参构造函数

*/

public JavaKafkaPartitioner() {

this(new VerifiableProperties());

} /**

* 该构造函数必须给定

*

* @param properties 初始化producer的时候给定的配置信息

*/

public JavaKafkaPartitioner(VerifiableProperties properties) {

// nothings

} @Override

public int partition(Object key, int numPartitions) {

String tmp = (String) key;

int index = tmp.lastIndexOf('_');

int number = Integer.valueOf(tmp.substring(index + 1));

return number % numPartitions;

}

}

2.producer类重新修改

package com.jun.it;

import kafka.javaapi.producer.Producer;

import kafka.producer.KeyedMessage;

import kafka.producer.ProducerConfig;

import java.util.Properties;

import java.util.Random;

import java.util.concurrent.atomic.AtomicBoolean;

public class JavaKafkaProducer {

public static final char[] chars = "qazwsxedcrfvtgbyhnujmikolp0123456789".toCharArray();

public static final int charsLength = chars.length;

public static final Random random = new Random(System.currentTimeMillis());

private Producer<String, String> producer = null; private String topicName = null;

private String brokerList = null;

private boolean isSync = true; // 默认为同步

private String partitionerClass = null; // 数据分区器class类 /**

* 构造函数

*

* @param topicName

* @param brokerList

*/

public JavaKafkaProducer(String topicName, String brokerList) {

this(topicName, brokerList, true, null);

} /**

* 构造函数

*

* @param topicName

* @param brokerList

* @param partitionerClass

*/

public JavaKafkaProducer(String topicName, String brokerList, String partitionerClass) {

this(topicName, brokerList, true, partitionerClass);

} /**

* 构造函数,主要是产生producer

*

* @param topicName

* @param brokerList

* @param isSync

*/

public JavaKafkaProducer(String topicName, String brokerList, boolean isSync, String partitionerClass) {

// 赋值

this.topicName = topicName;

this.brokerList = brokerList;

this.isSync = isSync;

this.partitionerClass = partitionerClass; // 1. 给定配置信息:参考http://kafka.apache.org/082/documentation.html#producerconfigs

Properties props = new Properties();

// kafka集群的连接信息

props.put("metadata.broker.list", this.brokerList);

// kafka发送数据方式

if (this.isSync) {

// 同步发送数据

props.put("producer.type", "sync");

} else {

// 异步发送数据

props.put("producer.type", "async");

/**

* 0: 不等待broker的返回

* 1: 表示至少等待1个broker返回结果

* -1:表示等待所有broker返回数据接收成功的结果

*/

props.put("request.required.acks", "0");

}

// key/value数据序列化的类

/**

* 默认是:DefaultEncoder, 指发送的数据类型是byte类型

* 如果发送数据是string类型,必须更改StringEncoder

*/

props.put("serializer.class", "kafka.serializer.StringEncoder"); // 给定分区器的class参数

if (this.partitionerClass != null && !this.partitionerClass.trim().isEmpty()) {

// 默认是:DefaultPartiioner,基于key的hashCode进行hash后进行分区

props.put("partitioner.class", this.partitionerClass.trim());

} // 2. 构建Kafka的Producer Configuration上下文

ProducerConfig config = new ProducerConfig(props); // 3. 构建Kafka的生产者:Producerr

this.producer = new Producer<String, String>(config);

} /**

* 关闭producer连接

*/

public void closeProducer() {

producer.close();

} /**

* 提供给外部应用调用的直接运行发送数据代码的方法

*

* @param threadNumbers

* @param isRunning

*/

public void run(int threadNumbers, final AtomicBoolean isRunning) {

for (int i = 0; i < threadNumbers; i++) {

new Thread(new Runnable() {

public void run() {

int count = 0;

while (isRunning.get()) {

// 只有在运行状态的情况下,才发送数据

KeyedMessage<String, String> message = generateMessage();

// 发送数据

producer.send(message);

count++;

// 打印一下

if (count % 100 == 0) {

System.out.println("Count = " + count + "; message:" + message);

} // 假设需要休息一下

try {

Thread.sleep(random.nextInt(100) + 10);

} catch (InterruptedException e) {

// nothings

}

}

System.out.println("Thread:" + Thread.currentThread().getName() + " send message count is:" + count);

}

}).start();

}

} /**

* 产生一个随机的Kafka的KeyedMessage对象

*

* @return

*/

public KeyedMessage<String, String> generateMessage() {

String key = generateString(3) + "_" + random.nextInt(10);

StringBuilder sb = new StringBuilder();

int numWords = random.nextInt(5) + 1; // [1,5]单词

for (int i = 0; i < numWords; i++) {

String word = generateString(random.nextInt(5) + 1); // 单词中字符最少1个最多5个

sb.append(word).append(" ");

}

String message = sb.toString().trim();

return new KeyedMessage(this.topicName, key, message);

} /**

* 随机生产一个给定长度的字符串

*

* @param numItems

* @return

*/

public static String generateString(int numItems) {

StringBuilder sb = new StringBuilder();

for (int i = 0; i < numItems; i++) {

sb.append(chars[random.nextInt(charsLength)]);

}

return sb.toString();

}

}

3.测试类

package com.jun.it;

import java.util.concurrent.atomic.AtomicBoolean;

public class JavaKafkaProducerTest {

public static void main(String[] args) {

String topicName = "beifeng";

String brokerList = "linux-hadoop01.ibeifeng.com:9092,linux-hadoop01.ibeifeng.com:9093";

String partitionerClass = "com.jun.it.JavaKafkaPartitioner";

int threadNums = 10;

AtomicBoolean isRunning = new AtomicBoolean(true);

JavaKafkaProducer producer = new JavaKafkaProducer(topicName, brokerList,partitionerClass);

producer.run(threadNums, isRunning);

// 停留60秒后,进行关闭操作

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

// nothings

}

isRunning.set(false);

// 关闭连接

producer.closeProducer();

}

}

4.效果

057 Java中kafka的Producer程序实现的更多相关文章

- java中子类继承父类程序执行顺序

java中子类继承父类程序执行顺序 FatherTest.java public class FatherTest { private String name; public FatherTest() ...

- java中子类继承父类程序执行顺序问题

Java中,new一个类的对象,类里面的静态代码块.非静态代码.无参构造方法.有参构造方法.类的一般方法等部分,它们的执行顺序相对来说比较简单,用程序也很容易验证.比如新建一个测试父类. public ...

- 对上次“对字符串进行简单的字符数字统计 探索java中的List功能 ”程序,面向对象的改进

之前的随笔中的程序在思考后发现,运用了太多的static 函数,没有将面向对象的思想融入,于是做出了一下修改: import java.util.ArrayList; import java.util ...

- Java 中,编写多线程程序的时候你会遵循哪些最佳实践?

这是我在写 Java 并发程序的时候遵循的一些最佳实践: a)给线程命名,这样可以帮助调试. b)最小化同步的范围,而不是将整个方法同步,只对关键部分做同步. c)如果可以,更偏向于使用 volati ...

- JAVA中处理事务的程序--多条更新SQL语句的执行(包括回滚)

在与数据库操作时,如果执行多条更新的SQL语句(如:update或insert语句),在执行第一条后如果出现异常或电脑断电, 则后面的SQL语句执行不了,这时候设定我们自己提交SQL语句,不让JDBC ...

- Java中native关键字

Java中native关键字 标签: Java 2016-08-17 11:44 54551人阅读 评论(0) 顶(23453) 收藏(33546) 今日在hibernate源代码中遇到了nati ...

- Java中long类型直接赋值大数字 注意事项

在java中,我们都知道有八种基本数据类型:byte. char. short .int. long. float. double .boolean 下面列出以下四种数据类型及其取值范围: 本文主要讲 ...

- Java中native的用法

原文来自:http://blog.csdn.net/funneies/article/details/8949660 native关键字说明其修饰的方法是一个原生态方法,方法对应的实现不是在当前文件, ...

- 关于JAVA中的static方法、并发问题以及JAVA运行时内存模型

一.前言 最近在工作上用到了一个静态方法,跟同事交流的时候,被一个问题给问倒了,只怪基础不扎实... 问题大致是这样的,“在多线程环境下,静态方法中的局部变量会不会被其它线程给污染掉?”: 我当时的想 ...

随机推荐

- [转]MySQL常用Json函数和MySQL常用字符串函数

MySQL常用Json函数:https://www.cnblogs.com/waterystone/p/5626098.html MySQL常用字符串函数:https://www.cnblogs.co ...

- 解决layui选中项下一页清空问题

项目中遇到给用户在所有产品中匹配一部分产品.用layui 第一页选好之后到第二页再选,等回到第一页时之前选择的都没了,解决这个问题的办法如下: //勾选的产品id集合 var chooseAdids ...

- 实体类和json互相转换

/// <summary> /// 将实体类转换为json数据 /// </summary> /// <returns></returns> publi ...

- Oracle定时备份数据库

1.导出命令:exp cpzxoa/cpzxoa@FENG file=D:\OracleBak\%date:~11,4%\jjmis_test.dmp log=D:\OracleBak\%date:~ ...

- 走进科学之揭开神秘的"零拷贝"

前言 "零拷贝"这三个字,想必大家多多少少都有听过吧,这个技术在各种开源组件中都使用了,比如kafka,rocketmq,netty,nginx等等开源框架都在其中引用了这项技术. ...

- linux之各目录作用

/opt目录 目录用来安装附加软件包,用户调用软件包程序放在目录/opt/package_name/bin下,package_name是安装软件包的名称 /etc目录 是用来放一些核心的配置文件 附各 ...

- axis 数据流

产生数据流的代码 模板 重新修改了下 :]axis_data_cnt='d0; :]axis_data_frame_cnt='d0; :]delay_cnt='d0; initial begin ...

- JPA核心类与使用

点击访问:JPA环境配置(一) Persistence: Persistence用于获取EntityManagerFactory实例,这个类中包含一个名为createEntityManagerFact ...

- Python基础之模块与包

一.模块 1.什么是模块? 一个模块就是一个包含了python定义和声明的文件,文件名就是模块名字加上.py的后缀. 2.为何要使用模块? 如果你退出python解释器然后重新进入,那么你之前定义的函 ...

- PDF如何去除背景,PDF去除背景颜色

PDF文件在使用的时候大多都是单调的白色背景,但是也有小伙伴再制作PDF文件的时候会给PDF文件添加背景颜色,会有影响文字阅读的情况,这个时候就需要把背景颜色去除了,那么该怎么做呢,不会的小伙们就跟小 ...