GoogleNet

NET-IN-NET

- 采用net-in-net 结构(不使用传统线性卷积,使用Mlpconv)

- 采用全局均值池化来提高传统CNN 网络中最后全连接层参数过于复杂的特点。(全连接层造成网络泛化能力差,alexnet中使用dropout 来提高)

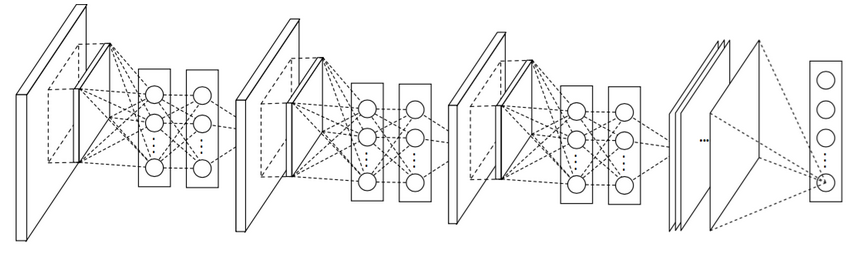

网络结构: 4层 net-in-net结构+ 全局均值池化层

使用1*1 的卷积核(net-in-net)

self.feed('data').conv(11, 11, 96, 4, 4, padding='VALID', name='conv1').conv(1, 1, 96, 1, 1, name='cccp1') # 1*1 的卷积核 也称为cross channel pooling.conv(1, 1, 96, 1, 1, name='cccp2').max_pool(3, 3, 2, 2, name='pool1')NIN 增加了网络的深度,使用aver_pooling 减少了网络的参数改变网络结构的重要点:

1. 提取更优的特征

2. 加快训练(减少参数)如果单纯增加网络层数,有更大的model参数,由于模型过复杂会过拟合。Inception module

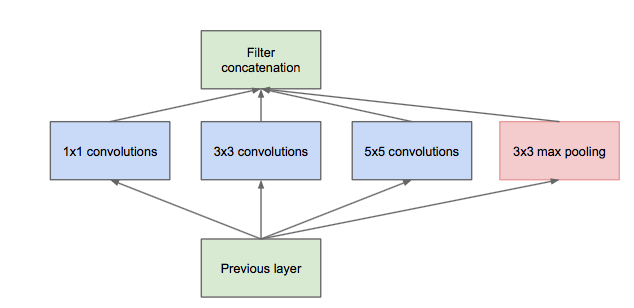

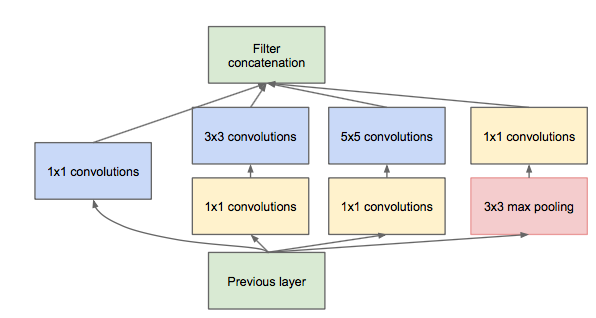

不同size 的卷积核能够得到不同cluster的信息,但是各种分支的filters综合,经过多层model的数量将会变得很大。(使用net-in-net 的1*1 的卷积核进行降维,inception module with dimension reduction。

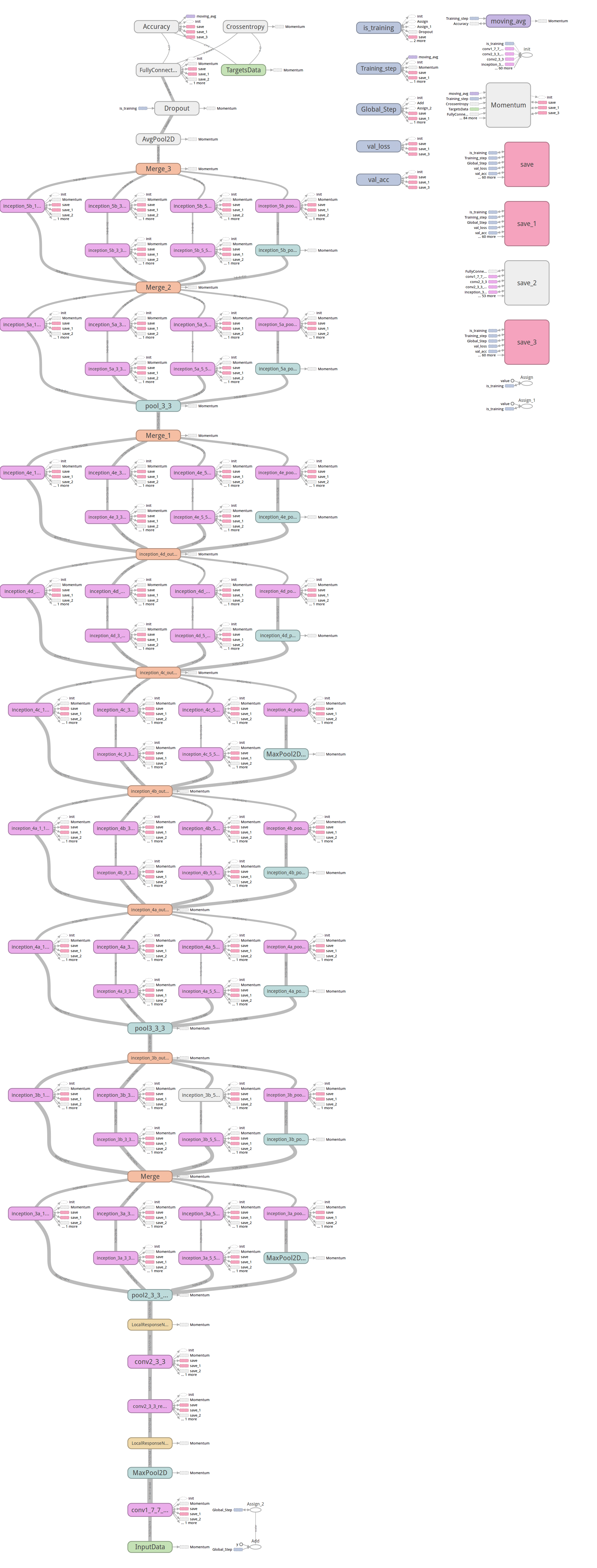

在Googlenet中主要加入了几组inception 模块:

GoogleNet的更多相关文章

- #Deep Learning回顾#之LeNet、AlexNet、GoogLeNet、VGG、ResNet

CNN的发展史 上一篇回顾讲的是2006年Hinton他们的Science Paper,当时提到,2006年虽然Deep Learning的概念被提出来了,但是学术界的大家还是表示不服.当时有流传的段 ...

- GoogleNet tips

Inception Module googlenet的Inception Module Idea 1: Use 1x1, 3x3, and 5x5 convolutions in parallel t ...

- Drawing with GoogLeNet

Drawing with GoogLeNet In my previous post, I showed how you can use deep neural networks to generat ...

- 解读(GoogLeNet)Going deeper with convolutions

(GoogLeNet)Going deeper with convolutions Inception结构 目前最直接提升DNN效果的方法是increasing their size,这里的size包 ...

- GoogLeNet学习心得

转自:http://blog.csdn.net/liumaolincycle/article/details/50471289#t0 综述: http://blog.csdn.net/sunbaigu ...

- GoogleNet:inceptionV3论文学习

Rethinking the Inception Architecture for Computer Vision 论文地址:https://arxiv.org/abs/1512.00567 Abst ...

- 【深度学习系列】用PaddlePaddle和Tensorflow实现经典CNN网络GoogLeNet

前面讲了LeNet.AlexNet和Vgg,这周来讲讲GoogLeNet.GoogLeNet是由google的Christian Szegedy等人在2014年的论文<Going Deeper ...

- Caffe-5.2-(GPU完整流程)训练(依据googlenet微调)

上一篇使用caffenet的模型微调.但由于caffenet有220M太大,測试速度太慢.因此换为googlenet. 1. 训练 迭代了2800次时死机,大概20分钟. 使用的是2000次的模型. ...

- 【深度学习系列】用PaddlePaddle和Tensorflow实现GoogLeNet InceptionV2/V3/V4

上一篇文章我们引出了GoogLeNet InceptionV1的网络结构,这篇文章中我们会详细讲到Inception V2/V3/V4的发展历程以及它们的网络结构和亮点. GoogLeNet Ince ...

- 经典卷积神经网络(LeNet、AlexNet、VGG、GoogleNet、ResNet)的实现(MXNet版本)

卷积神经网络(Convolutional Neural Network, CNN)是一种前馈神经网络,它的人工神经元可以响应一部分覆盖范围内的周围单元,对于大型图像处理有出色表现. 其中 文章 详解卷 ...

随机推荐

- 牛客练习赛43 Tachibana Kanade Loves Probability(快速幂)

链接:https://ac.nowcoder.com/acm/contest/548/B来源:牛客网 题目描述 立华奏在学习初中数学的时候遇到了这样一道大水题: “设箱子内有 n 个球,其中给 m 个 ...

- 【SDOI2008】仪仗队

//裸的欧拉函数//y=kx//求不同的k有多少#include<bits/stdc++.h> #define ll long long #define N 40010 using nam ...

- 软件在 win7 上运行时显示乱码

一个用户反应后,我当时就蒙圈了,因为之前从未遇到过: 百度一下后,发现用户的这种情况比较特殊,从表面上看,[控制面板]和[注册表]相关项设置都正常,为什么还显示乱码呢? 到最后一步如果已经是(简体,中 ...

- ERRORS: ?: (staticfiles.E002) The STATICFILES_DIRS setting should not contain the STATIC_ROOT setting.

Ubuntu下,运行django项目的时候失败,报错: (env36) root@JD:~/xueyiwang# python manage.py runserver 0.0.0.0:8000 Per ...

- 第十五篇-EditText做简单的登录框

TextView和EditText的简单应用. MainActivity.java package com.example.aimee.edittexttest; import android.sup ...

- Day17--Python--面向对象--成员

成员 class Person: def __init__(self, name, num, gender,birthday): # 成员变量(实例变量) self.name = name self. ...

- 洛谷 P1879 玉米田(状压DP入门题)

传送门 https://www.cnblogs.com/violet-acmer/p/9852294.html 题解: 相关变量解释: int M,N; int plant[maxn][maxn];/ ...

- AVL平衡二叉树

AVL树 1.若它的左子树不为空,则左子树上所有的节点值都小于它的根节点值. 2.若它的右子树不为空,则右子树上所有的节点值均大于它的根节点值. 3.它的左右子树也分别可以充当为二叉查找树. 例如: ...

- Linux 中用 dd 命令来测试硬盘读写速度

dd 是 Linux/UNIX 下的一个非常有用的命令,作用是用指定大小的块拷贝一个文件,并在拷贝的同时进行指定的转换. dd 命令通用语法格式如下: dd if=path/to/input_file ...

- eclipse新建maven项目默认jre为1.5的问题

在maven的settings.xml中添加如下内容解决 <profiles> <profile> <id>jdk-1.8</id> <activ ...