RDD

scala> val rdd1=sc.parallelize(Array("coffe","coffe","hellp","hellp","pandas","mokey") )

rdd1: org.apache.spark.rdd.RDD[String] = ParallelCollectionRDD[8] at parallelize at <console>:24

scala> val rdd1=sc.parallelize(Array("coffe","coffe","hellp","hellp","pandas","mokey"))

rdd1: org.apache.spark.rdd.RDD[String] = ParallelCollectionRDD[9] at parallelize at <console>:24

scala> val rdd2=sc.parallelize(Array("coe","coe","help","help","pandas","mokey"))

rdd2: org.apache.spark.rdd.RDD[String] = ParallelCollectionRDD[10] at parallelize at <console>:24

scala> val rdd1_distinct=rdd1.distinct()

rdd1_distinct: org.apache.spark.rdd.RDD[String] = MapPartitionsRDD[13] at distinct at <console>:25

scala> rdd1_distinct.foreach(println)

hellp

mokey

pandas

coffe

scala> val rdd_union=rdd1.union(rdd2)

rdd_union: org.apache.spark.rdd.RDD[String] = UnionRDD[14] at union at <console>:27

scala> rdd1_union.foreach(println)

<console>:24: error: not found: value rdd1_union

rdd1_union.foreach(println)

^

scala> rdd_union.foreach(println)

pandas

mokey

coffe

hellp

coffe

hellp

pandas

mokey

coe

help

help

coe

scala> val rdd_intersection=rdd1.intersession(rdd2)

<console>:27: error: value intersession is not a member of org.apache.spark.rdd.RDD[String]

val rdd_intersection=rdd1.intersession(rdd2)

^

scala> val rdd_intersection=rdd1.intersection(rdd2)

rdd_intersection: org.apache.spark.rdd.RDD[String] = MapPartitionsRDD[20] at intersection at <console>:27

scala> rdd_intersection.foreach(println)

mokey

pandas

scala> val rdd_sub=rdd1.subtract(rdd2)

rdd_sub: org.apache.spark.rdd.RDD[String] = MapPartitionsRDD[24] at subtract at <console>:27

scala> rdd_sub.foreach(prinln)

<console>:26: error: not found: value prinln

rdd_sub.foreach(prinln)

^

scala> rdd_sub.foreach(println)

coffe

coffe

hellp

hellp

scala>

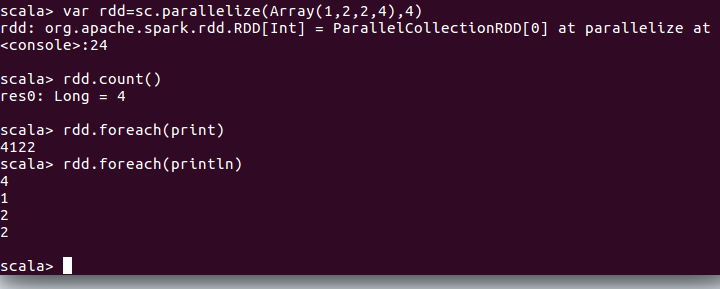

scala> val rdd=sc.parallelize(Array(1,2,2,3))

rdd: org.apache.spark.rdd.RDD[Int] = ParallelCollectionRDD[25] at parallelize at <console>:24

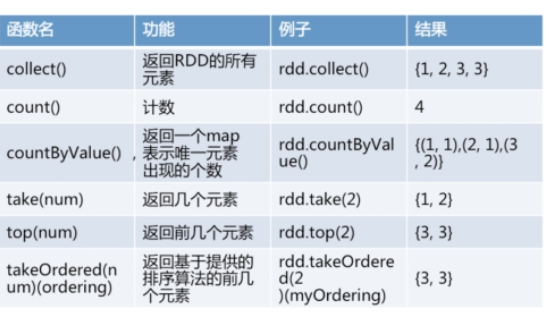

scala> rdd.collect()

res16: Array[Int] = Array(1, 2, 2, 3)

scala> rdd.reduce((x,y)=>x+y)

res18: Int = 8

scala> rdd.take(2)

res19: Array[Int] = Array(1, 2)

scala> rdd.take(3)

res20: Array[Int] = Array(1, 2, 2)

scala>

scala> rdd.top(1)

res21: Array[Int] = Array(3)

scala> rdd.top(2)

res22: Array[Int] = Array(3, 2)

scala> rdd.top(3)

res23: Array[Int] = Array(3, 2, 2)

RDD的更多相关文章

- Spark RDD 核心总结

摘要: 1.RDD的五大属性 1.1 partitions(分区) 1.2 partitioner(分区方法) 1.3 dependencies(依赖关系) 1.4 compute(获取分区迭代列表) ...

- Spark笔记:复杂RDD的API的理解(下)

本篇接着谈谈那些稍微复杂的API. 1) flatMapValues:针对Pair RDD中的每个值应用一个返回迭代器的函数,然后对返回的每个元素都生成一个对应原键的键值对记录 这个方法我最开始接 ...

- Spark笔记:复杂RDD的API的理解(上)

本篇接着讲解RDD的API,讲解那些不是很容易理解的API,同时本篇文章还将展示如何将外部的函数引入到RDD的API里使用,最后通过对RDD的API深入学习,我们还讲讲一些和RDD开发相关的scala ...

- Spark笔记:RDD基本操作(下)

上一篇里我提到可以把RDD当作一个数组,这样我们在学习spark的API时候很多问题就能很好理解了.上篇文章里的API也都是基于RDD是数组的数据模型而进行操作的. Spark是一个计算框架,是对ma ...

- Spark笔记:RDD基本操作(上)

本文主要是讲解spark里RDD的基础操作.RDD是spark特有的数据模型,谈到RDD就会提到什么弹性分布式数据集,什么有向无环图,本文暂时不去展开这些高深概念,在阅读本文时候,大家可以就把RDD当 ...

- Spark核心——RDD

Spark中最核心的概念为RDD(Resilient Distributed DataSets)中文为:弹性分布式数据集,RDD为对分布式内存对象的 抽象它表示一个被分区不可变且能并行操作的数据集:R ...

- 【原】Learning Spark (Python版) 学习笔记(一)----RDD 基本概念与命令

<Learning Spark>这本书算是Spark入门的必读书了,中文版是<Spark快速大数据分析>,不过豆瓣书评很有意思的是,英文原版评分7.4,评论都说入门而已深入不足 ...

- Spark Rdd coalesce()方法和repartition()方法

在Spark的Rdd中,Rdd是分区的. 有时候需要重新设置Rdd的分区数量,比如Rdd的分区中,Rdd分区比较多,但是每个Rdd的数据量比较小,需要设置一个比较合理的分区.或者需要把Rdd的分区数量 ...

- RDD/Dataset/DataFrame互转

1.RDD -> Dataset val ds = rdd.toDS() 2.RDD -> DataFrame val df = spark.read.json(rdd) 3.Datase ...

- 深入理解Spark(一):Spark核心概念RDD

RDD全称叫做弹性分布式数据集(Resilient Distributed Datasets),它是一种分布式的内存抽象,表示一个只读的记录分区的集合,它只能通过其他RDD转换而创建,为此,RDD支持 ...

随机推荐

- I/O 机制的介绍(Linux 中直接 I/O 机制的介绍)

IO连接的建立方式 1.缓存IO.流式IO: 2.映射IO.块式IO: 3.直接IO. IO的方式: 同步.异步.定时刷新: MMAP与内核空间 mmap使用共享用户空间与内核空间实现: 直接 I/O ...

- 11g SPA (sql Performance Analyze) 进行升级测试

注;转自http://ju.outofmemory.cn/entry/77139 11G的新特性SPA(SQL Performance Analyze)现在被广泛的应用到升级和迁移的场景.当然还有一些 ...

- metamask的使用

Metamask 我是在火狐浏览器安装它的,所以一开始安装了Firefox:http://www.firefox.com.cn/ 然后是下载metamask,它的官方网站是https://metama ...

- Spring Security(十四):5.4 Authorize Requests

Our examples have only required users to be authenticated and have done so for every URL in our appl ...

- 获得数值型数组的所有元素之和(分别使用增强for循环和普通for循环)

package com.Summer_0419.cn; /** * @author Summer * 获得数值型数组的所有元素之和 */public class Test_Method13 { pub ...

- lower_bound

头文件: #include<algorithm> 作用: 查找第一个大于或等于给定数的元素或位置 在从小到大的排列数组中 注意注意: 是排列好的, 一般都是从小到大, 但从大到小也可以, ...

- Android自动化测试学习路线

最近在整理Android自动化测试的相关资料,大体上把一些知识点梳理了,这里做一个简单的分享! Android里面测试相关的工具和框架太多了.你应该从以下几个方面入手. 编程语言的选择 如果你要学习的 ...

- IOException: Sharing violation on path *****

Unity代码中删除文件或者文件夹时,可能会报这个错.翻译成白话文就是:你在其它地方打开了这个文件/文件夹 把打开的地方关了就是了.

- 使用python进行utf9编码和解码

在2005年4月1日(也就是愚人节),IEEE的rfc4042文件规定了utf9和utf18这2个所谓的Unicode的高效转换格式. 具体的格式说明,有兴趣的话点击上面的rfc4042链接去观看. ...

- Google 宣布在 4 月 1 日关闭站内搜索

今春,Google 计划终止又一项产品,它就是“站内搜索”(Site Search)功能.这项产品主要出售给 web 出版商,让它们可以在自家网站内运用业内领先的搜索技术.虽然该公司并未公开宣布此事, ...