Scrapy爬虫框架之爬取校花网图片

Scrapy

Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架。 其可以应用在数据挖掘,信息处理或存储历史数据等一系列的程序中。

其最初是为了页面抓取 (更确切来说, 网络抓取 )所设计的, 也可以应用在获取API所返回的数据(例如 Amazon Associates Web Services ) 或者通用的网络爬虫。Scrapy用途广泛,可以用于数据挖掘、监测和自动化测试。

一、安装

注:windows平台需要依赖pywin32,请根据自己系统32/64位选择下载安装

https://sourceforge.net/projects/pywin32/files/pywin32/

linux:

yum install libxml2-devel libxslt-devel sqlite-devel

pip install lxml

pip install pyOpenSSL

pip install pysqlite

|

1

|

pip install Scrapy

|

二、基本使用

1、创建项目

运行命令:

|

1

|

scrapy startproject your_project_name |

自动创建目录:

|

1

2

3

4

5

6

7

8

9

|

project_name/ scrapy.cfg project_name/ __init__.py items.py pipelines.py settings.py spiders/ __init__.py |

文件说明:

- scrapy.cfg 项目的配置信息,主要为Scrapy命令行工具提供一个基础的配置信息。(真正爬虫相关的配置信息在settings.py文件中)

- items.py 设置数据存储模板,用于结构化数据,如:Django的Model

- pipelines 数据处理行为,如:一般结构化的数据持久化

- settings.py 配置文件,如:递归的层数、并发数,延迟下载等

- spiders 爬虫目录,如:创建文件,编写爬虫规则

注意:一般创建爬虫文件时,以网站域名命名

2、编写爬虫

在spiders目录中新建 xiaohuar_spider.py 文件

- #!/usr/bin/env python

- # -*- coding:utf-8 -*-

- import scrapy

- class XiaoHuarSpider(scrapy.spiders.Spider):

- name = "xiaohuar"

- allowed_domains = ["xiaohuar.com"]

- start_urls = [

- "http://www.xiaohuar.com/hua/",

- ]

- def parse(self, response):

- # print(response, type(response))

- # from scrapy.http.response.html import HtmlResponse

- # print(response.body_as_unicode())

- current_url = response.url

- body = response.body

- #unicode_body = response.body_as_unicode()

- print body #爬取结果

3、运行

进入project_name目录,运行命令

|

1

|

scrapy crawl spider_name --nolog |

4、递归的访问

以上的爬虫仅仅是爬去初始页,而我们爬虫是需要源源不断的执行下去,直到所有的网页被执行完毕

爬取页面中所有的图片

注:可以修改settings.py 中的配置文件,以此来指定“递归”的层数,如: DEPTH_LIMIT = 1

- #!/usr/bin/env python

- #encoding: utf-8

- import scrapy

- from scrapy.http import Request

- from scrapy.selector import HtmlXPathSelector

- import re

- import urllib

- import os

- class XiaoHuarSpider(scrapy.spiders.Spider):

- name = "xiaohuar"

- allowed_domains = ["xiaohuar.com"]

- start_urls = [

- "http://www.xiaohuar.com/list-1-1.html",

- ]

- def parse(self, response):

- # 分析页面

- # 找到页面中符合规则的内容(校花图片),保存

- # 找到所有的a标签,再访问其他a标签,一层一层的搞下去

- hxs = HtmlXPathSelector(response)

- # 如果url是 http://www.xiaohuar.com/list-1-\d+.html

- if re.match('http://www.xiaohuar.com/list-1-\d+.html', response.url):

- items = hxs.select('//div[@class="item_list infinite_scroll"]/div')

- for i in range(len(items)):

- src = hxs.select('//div[@class="item_list infinite_scroll"]/div[%d]//div[@class="img"]/a/img/@src' % i).extract()

- name = hxs.select('//div[@class="item_list infinite_scroll"]/div[%d]//div[@class="img"]/span/text()' % i).extract()

- school = hxs.select('//div[@class="item_list infinite_scroll"]/div[%d]//div[@class="img"]/div[@class="btns"]/a/text()' % i).extract()

- if src:

- ab_src = "http://www.xiaohuar.com" + src[0]

- #file_name = "%s_%s.jpg" % (school[0].encode('utf-8'), name[0].encode('utf-8'))

- #file_path = os.path.join("/Users/wupeiqi/PycharmProjects/beauty/pic", file_name)

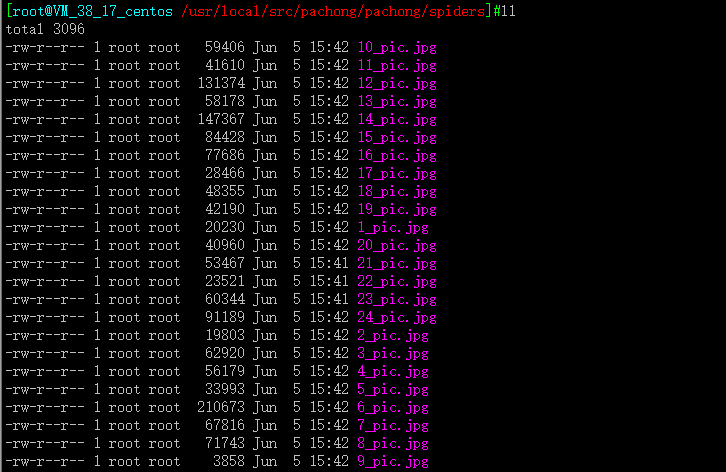

- file_name = '%d_pic.jpg'%i

- urllib.urlretrieve(ab_src, file_name)

- # 获取所有的url,继续访问,并在其中寻找相同的url

- all_urls = hxs.select('//a/@href').extract()

- for url in all_urls:

- if url.startswith('http://www.xiaohuar.com/list-1-'):

- yield Request(url, callback=self.parse)

开始爬取

#scrapy crawl xiaohuar --nolog

打包传到windows打开

Scrapy爬虫框架之爬取校花网图片的更多相关文章

- python爬虫基础应用----爬取校花网视频

一.爬虫简单介绍 爬虫是什么? 爬虫是首先使用模拟浏览器访问网站获取数据,然后通过解析过滤获得有价值的信息,最后保存到到自己库中的程序. 爬虫程序包括哪些模块? python中的爬虫程序主要包括,re ...

- Go语言实战-爬取校花网图片

一.目标网站分析 爬取校花网http://www.xiaohuar.com/大学校花所有图片. 经过分析,所有图片分为四个页面,http://www.xiaohuar.com/list-1-0.htm ...

- python实战项目 — 爬取 校花网图片

重点: 1. 指定路径创建文件夹,判断是否存在 2. 保存图片文件 # 获得校花网的地址,图片的链接 import re import requests import time import os ...

- scrapy爬取校花网男神图片保存到本地

爬虫四部曲,本人按自己的步骤来写,可能有很多漏洞,望各位大神指点指点 1.创建项目 scrapy startproject xiaohuawang scrapy.cfg: 项目的配置文件xiaohua ...

- windows下使用python的scrapy爬虫框架,爬取个人博客文章内容信息

scrapy作为流行的python爬虫框架,简单易用,这里简单介绍如何使用该爬虫框架爬取个人博客信息.关于python的安装和scrapy的安装配置请读者自行查阅相关资料,或者也可以关注我后续的内容. ...

- 第六篇 - bs4爬取校花网

环境:python3 pycharm 模块:requests bs4 urlretrieve os time 第一步:获取网页源代码 import requests from bs4 imp ...

- scrapy从安装到爬取煎蛋网图片

下载地址:https://www.lfd.uci.edu/~gohlke/pythonlibs/pip install wheelpip install lxmlpip install pyopens ...

- Python-爬取校花网视频(单线程和多线程版本)

一.参考文章 python爬虫爬取校花网视频,单线程爬取 爬虫----爬取校花网视频,包含多线程版本 上述两篇文章都是对校花网视频的爬取,由于时间相隔很久了,校花网上的一些视频已经不存在了,因此上述文 ...

- Java基础-爬虫实战之爬去校花网网站内容

Java基础-爬虫实战之爬去校花网网站内容 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 爬虫这个实现点我压根就没有把它当做重点,也没打算做网络爬虫工程师,说起爬虫我更喜欢用Pyt ...

随机推荐

- apache重写规则 rewrite

Rewrite规则表达式的说明: . 匹配任何单字符 [chars] 匹配字符串:chars [^chars] 不匹配字符串:chars text1|text2 可选择的字符串:text1或text2 ...

- 官方下拉刷新控件SwipeRefreshLayout的使用

今天看博客,发现有了这个下拉刷新的控件,效果看上去还蛮好的,于是我也想研究的是使用一下,写个demo.其实使用很简单的,但就是为了能使用这个新组建我下了好久的更新,后来还是直接去官网下载最新的ADT得 ...

- spring通过工厂模式解决页面耦合问题

spring通过工厂模式解决页面耦合问题

- 【Java并发编程】之十一:线程间通信中notify通知的遗漏

notify通知的遗漏很容易理解,即threadA还没开始wait的时候,threadB已经notify了,这样,threadB通知是没有任何响应的,当threadB退出synchronized代码块 ...

- QML——添加自定义模块

一.模块的定义 在使用QML时,我们常常看到类似这样的语句: import QtQuick 2.0 import QtSensors 5.0 通过这些import语句,我们就能使用QML中的相关控件了 ...

- 【大数据】Hadoop的高可用HA

第1章 HA高可用 1.1 HA概述 1)所谓HA(high available),即高可用(7*24小时不中断服务). 2)实现高可用最关键的策略是消除单点故障(single point of fa ...

- P4838 P哥破解密码

题目背景 P哥是一个经常丢密码条的男孩子. 在ION 8102赛场上,P哥又弄丢了密码条,笔试满分的他当然知道这可是要扣5分作为惩罚的,于是他开始破解ION Xunil系统的密码. 题目描述 定义一个 ...

- Candies CodeForces - 991C(二分水题)

就是二分暴力就好了 为什么要记下来 呵呵....emm你说为什么... 行吧 好吧 我一直以为我的二分出问题了 原来不是 依旧很帅 统计的时候求的减了多少次 然后用次数乘了mid 这样做会使那个人获 ...

- 【BZOJ1052】覆盖问题(贪心)

[BZOJ1052]覆盖问题(贪心) 题面 BZOJ 洛谷 题解 这题好神仙啊. 很明显可以看出来要二分一个边长. 那么如何\(check\)呢? 我们把所有点用一个最小矩形覆盖, 那么必定每个边界上 ...

- linux内核分析 第五周读书笔记

第18章 调试 内核调试的难度大于用户级 一.准备开始 开始之前需要的是: 一个行为可靠且定义明确的bug 一个隐匿bug的内核版本 相关内核代码的知识和运气 想要成功的调试,取决于能不能将这些bug ...