Kubernetes1.11.1 使用Nvidia显卡配置方法

一、安装

1.1、kubernetes硬件支持问题说明

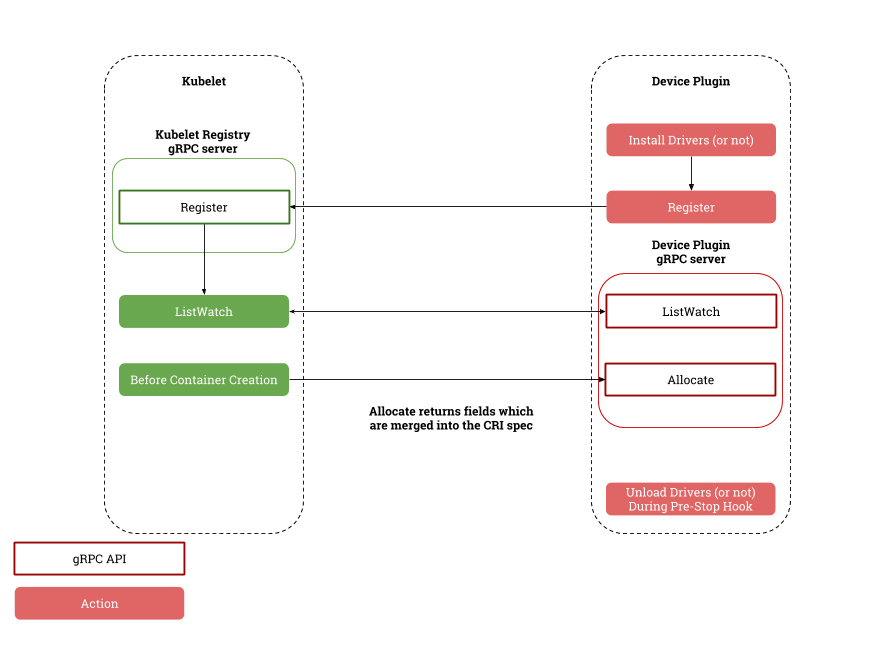

Kubernetes目前主要在很小程度上支持CPU和内存的发现。Kubelet本身处理的设备非常少。

Kubernetes对于硬件都使用都依赖于硬件厂商的自主研发kubernetes插件,通过硬件厂商的插件从而让kubernetes进行硬件支持。

实现的逻辑如下:

1.2、适用于Kubernetes的NVIDIA设备插件说明

Kubernetes的NVIDIA设备插件是一个Daemonset,允许您自动:

公开群集的每个节点上的GPU数量

跟踪GPU的运行状况

在Kubernetes集群中运行启用GPU的容器。

该存储库包含NVIDIA的Kubernetes设备插件的官方实现。

1.3、使用Kubernetes的NVIDIA设备插件条件(官方)

运行Kubernetes NVIDIA设备插件的先决条件列表如下所述:

- NVIDIA驱动程序〜= 361.93

- nvidia-docker version> 2.0(请参阅如何安装及其先决条件)

- docker配置了nvidia作为默认运行时。

- Kubernetes版本>= 1.11

运行nvidia-docker 2.0 先决条件列表如下所述:

- 内核版本> 3.10的GNU / Linux x86_64

- Docker> = 1.12

- 采用架构的NVIDIA GPU> Fermi(2.1)

- NVIDIA驱动程序〜= 361.93(旧版本未经测试)

1.4、删除nvidia-docker 1.0

在继续之前,必须彻底删除nvidia-docker软件包的1.0版。

您必须停止并删除所有使用nvidia-docker 1.0启动的容器。

1.4.1、Ubuntu发行版删除nvidia-docker 1.0

docker volume ls -q -f driver = nvidia-docker | xargs -r -I {} -n1 docker ps -q -a -f volume = {} | xargs -r docker rm -f

sudo apt-get purge nvidia-docker

1.4.2、CentOS发行版删除nvidia-docker 1.0

docker volume ls -q -f driver=nvidia-docker | xargs -r -I{} -n1 docker ps -q -a -f volume={} | xargs -r docker rm -f

sudo yum remove nvidia-docker

1.5、安装nvidia-docker 2.0

确保已为您的发行版安装了NVIDIA驱动程序和受支持的Docker 版本(请参阅先决条件)。

如果有自定义/etc/docker/daemon.json,则nvidia-docker2程序包可能会覆盖它,先做好相关备份。

1.5.1、Ubuntu发行版安装nvidia-docker 2.0

安装nvidia-docker2软件包并重新加载Docker守护程序配置:

sudo apt-get install nvidia-docker2

sudo pkill -SIGHUP dockerd

1.5.2、CentOS发行版安装nvidia-docker 2.0

安装nvidia-docker2软件包并重新加载Docker守护程序配置:

sudo yum install nvidia-docker2

sudo pkill -SIGHUP dockerd

1.5.3、较旧版本的Docker安装nvidia-docker 2.0(不推荐)

如果必须要使用旧版本的docker进行安装nvidia-docker 2.0

必须固定nvidia-docker2以及nvidia-container-runtime安装时的版本,例如:

sudo apt-get install -y nvidia-docker2=2.0.1+docker1.12.6-1 nvidia-container-runtime=1.1.0+docker1.12.6-1

使用

apt-cache madison nvidia-docker2 nvidia-container-runtime

或

yum search --showduplicates nvidia-docker2 nvidia-container-runtime

列出可用版本。

基本用法

nvidia-docker向Docker守护程序注册一个新的容器运行时。使用时必须选择nvidia运行时docker run:

docker run --runtime=nvidia --rm nvidia/cuda nvidia-smi

nvidia-docker 2.0安装和使用方法详见《docker在Ubuntu下1小时快速学习》

二、配置

2.1、配置docker

需要启用nvidia运行时作为节点上的默认运行时。需要编辑docker守护进程配置文件,该文件通常出现在/etc/docker/daemon.json,配置内容如下:

{

"default-runtime": "nvidia",

"runtimes": {

"nvidia": {

"path": "/usr/bin/nvidia-container-runtime",

"runtimeArgs": []

}

}

}

如果runtimes不存在,请重新安装nvidia-docker,或参考nvidia-docker官方页面

2.2、Kubernetes启用GPU支持

在您希望使用的所有 GPU节点上启用此选项后,您可以通过部署以下Daemonset在群集中启用GPU支持:

kubectl create -f https://raw.githubusercontent.com/NVIDIA/k8s-device-plugin/v1.11/nvidia-device-plugin.yml

2.3、运行GPU作业

可以使用资源属性nvidia.com/gpu配置,来通过容器级资源使用NVIDIA GPU要求:

apiVersion: v1

kind: Pod

metadata:

name: gpu-pod

spec:

containers:

- name: cuda-container

image: nvidia/cuda:9.0-devel

resources:

limits:

nvidia.com/gpu: 2 #请求2个GPU

- name: digits-container

image: nvidia/digits:6.0

resources:

limits:

nvidia.com/gpu: 2 #请求2个GPU

警告: 如果在使用带有NVIDIA映像的设备插件时,未配置GPU请求个数,则宿主机上所有GPU都将暴露在容器内。

2.4、Kubernetes运行GPU容器

2.4.1、使用告示

- Nvidia的GPU设备插件功能是Kubernetes v1.11的测试版

- NVIDIA设备插件仍被视为测试版并且缺失

- 更全面的GPU健康检查功能

- GPU清理功能

- ...

- 仅为官方NVIDIA设备插件提供支持。

2.4.2、kubernetes在依赖Docker下运行GPU容器

1、获取镜像

方法1,从Docker Hub中提取预构建的映像:

docker pull nvidia/k8s-device-plugin:1.11

方法2,不使用镜像,采用官方build方法:

docker build -t nvidia/k8s-device-plugin:1.11 https://github.com/NVIDIA/k8s-device-plugin.git#v1.11

方法3,采用自定义build文件方法:

git clone https://github.com/NVIDIA/k8s-device-plugin.git && cd k8s-device-plugin

docker build -t nvidia/k8s-device-plugin:1.11 .

2、在本地运行

docker run --security-opt=no-new-privileges --cap-drop=ALL --network=none -it -v /var/lib/kubelet/device-plugins:/var/lib/kubelet/device-plugins nvidia/k8s-device-plugin:1.11

3、kubernetes部署为守护进程集:

kubectl create -f nvidia-device-plugin.yml

2.4.3、kubernetes不依赖Docker下运行GPU容器

1、构建

C_INCLUDE_PATH=/usr/local/cuda/include LIBRARY_PATH=/usr/local/cuda/lib64 go build

2、在本地运行

./k8s-device-plugin

Kubernetes1.11.1 使用Nvidia显卡配置方法的更多相关文章

- 【ubuntu-18.04】ubuntu18.04进行Nvidia显卡配置

转自https://blog.csdn.net/qq_37935670/article/details/80377196 2.显卡驱动配置 网上有些攻略非常非常复杂,又要禁用nouveau驱动,又要进 ...

- Ubuntu18.04 NVIDIA显卡驱动 安装大全

离线安装NVIDIA显卡驱动 费了一天的劲,走了好多的坑,最主要的原因是gcc版本的问题,一定要用最新版本的gcc!!! 1)官网下载显卡驱动 2)apt 下载gcc包及其依赖包,可用apt-cach ...

- Linux操作系统安装Nvidia显卡驱动

一直以来,Linux分支系统使用过程中都有驱动适配麻烦,完全适配的驱动也不多.对于Nvidia显卡而言,一般Linux各分支操作系统虽然提供了N卡开源驱动工程Nouveau,但是性能上还是有待提高.下 ...

- Linux 桌面玩家指南:11. 在同一个硬盘上安装多个 Linux 发行版以及为 Linux 安装 Nvidia 显卡驱动

特别说明:要在我的随笔后写评论的小伙伴们请注意了,我的博客开启了 MathJax 数学公式支持,MathJax 使用$标记数学公式的开始和结束.如果某条评论中出现了两个$,MathJax 会将两个$之 ...

- Kali-linux安装并配置NVIDIA显卡驱动

显卡驱动程序就是用来驱动显卡的程序,它是硬件所对应的软件.驱动程序即添加到操作系统中的一小块代码,其中包含有关硬件设备的信息.有了此信息,计算机就可以与设备进行通信.驱动程序是硬件厂商根据操作系统编写 ...

- 安装Nvidia显卡驱动、CUDA和cuDNN的方法(jsxyhelu整编)

Nvidia显卡驱动.CUDA和cuDNN一般都是同时安装的,这里整理的是我成功运行的最简单的方法. 一.Nvidia显卡驱动 1.1 在可以进入图形界面的情况下 直接在"软件和更新&quo ...

- Ubuntu18.04 + NVidia显卡 + Anaconda3 + Tensorflow-GPU 安装、配置、测试 (无需手动安装CUDA)

其中其决定作用的是这篇文章 https://www.pugetsystems.com/labs/hpc/Install-TensorFlow-with-GPU-Support-the-Easy-Wa ...

- docker挂载NVIDIA显卡运行pytorch

本文为作者原创,转载请注明出处(http://www.cnblogs.com/mar-q/)by 负赑屃 写在前面: 请参考之前的文章安装好CentOS.NVIDIA相关驱动及软件.docker及 ...

- Gnome Ubuntu16安装Nvidia显卡396驱动,CUDA9.2以及cudnn9.2

深度学习环境配置,安装Nvidia显卡驱动,CUDA以及cudnn OS:ubuntu 16.04;driver: nvidia 396;CUDA: 9.2cudnn: 9.2 卸载原有Nvidia驱 ...

随机推荐

- go语言new和make

1.new func new(Type) *Type 内建函数,内建函数 new 用来分配内存,它的第一个参数是一个类型,它的返回值是一个指向新分配类型默认值的指针! 2.make func make ...

- JavaScript对象及面向对象

1.创建对象(1)自定义对象 语法:var 对象名称=new Object();(2)内置对象 String(字符串)对象. Date(对象)对象 Array(数组)对象 Boll ...

- Kubernetes集群部署(yum部署)

环境准备 Kubernetes-Master:192.168.37.134 #yum install kubernetes-master etcd flannel -y Kubernetes-n ...

- tar加密码

tar -zcvf - *** | openssl des3 -salt -k pass | dd of=.his dd if=.his | openssl des3 -d -k pass| tar ...

- Multi-shot Pedestrian Re-identification via Sequential Decision Making

Multi-shot Pedestrian Re-identification via Sequential Decision Making 2019-07-31 20:33:37 Paper: ht ...

- 微信小程序的跳转navigateTo()和redirectTo()用法和区别

原文链接:https://blog.csdn.net/u013128651/article/details/79736410 wx.navigateTo({}) ,保留当前页面,跳转到应用内的某个页 ...

- 使用yarn代替npm作为node.js的模块管理器

使用yarn代替npm作为node.js的模块管理器 转 https://www.jianshu.com/p/bfe96f89da0e Fast, reliable, and secure d ...

- openresty开发系列40--nginx+lua实现获取客户端ip所在的国家信息

openresty开发系列40--nginx+lua实现获取客户端ip所在的国家信息 为了实现业务系统针对不同地区IP访问,展示包含不同地区信息的业务交互界面.很多情况下系统需要根据用户访问的IP信息 ...

- Java算法 -- 桶排序

桶排序(Bucket sort)或所谓的箱排序,是一个排序算法,工作的原理是将数组分到有限数量的桶里.每个桶再个别排序(有可能再使用别的排序算法或是以递归方式继续使用桶排序进行排序).桶排序是鸽巢排序 ...

- Extjs与Vue技术优劣势比较

此技术只变更PLM的表单化的页面显示风格,不涉及不影响整个现有平台的架构和蓝图