Spark基于自定义聚合函数实现【列转行、行转列】

一.分析

Spark提供了非常丰富的算子,可以实现大部分的逻辑处理,例如,要实现行转列,可以用hiveContext中支持的concat_ws(',', collect_set('字段'))实现。但是这有明显的局限性【sqlContext不支持】,因此,基于编码逻辑或自定义聚合函数实现相同的逻辑就显得非常重要了。

二.列转行代码实现

package utils

import com.hankcs.hanlp.tokenizer.StandardTokenizer

import org.apache.log4j.{Level, Logger}

import org.apache.spark.sql.{SparkSession, Row}

import org.apache.spark.sql.types.{StringType, StructType, StructField}

/**

* Created by Administrator on 2019/12/17.

*/

object Column2Row {

/**

* 设置日志级别

*/

Logger.getLogger("org").setLevel(Level.WARN)

def main(args: Array[String]) {

val spark = SparkSession.builder().master("local[2]").appName(s"${this.getClass.getSimpleName}").getOrCreate()

val sc = spark.sparkContext

val sqlContext = spark.sqlContext val array : Array[String] = Array("spark-高性能大数据解决方案", "spark-机器学习图计算", "solr-搜索引擎应用广泛", "solr-ES灵活高效")

val rdd = sc.parallelize(array) val termRdd = rdd.map(row => { // 标准分词,挂载Hanlp分词器

var result = ""

val type_content = row.split("-")

val termList = StandardTokenizer.segment(type_content(1))

for(i <- 0 until termList.size()){

val term = termList.get(i)

if(!term.nature.name.contains("w") && !term.nature.name().contains("u") && !term.nature.name().contains("m")){

if(term.word.length > 1){

result += term.word + " "

}

}

}

Row(type_content(0),result)

}) val structType = StructType(Array(

StructField("arth_type", StringType, true),

StructField("content", StringType, true)

)) val termDF = sqlContext.createDataFrame(termRdd,structType)

termDF.show(false)

/**

* 列转行

*/

val termCheckDF = termDF.rdd.flatMap(row =>{

val arth_type = row.getAs[String]("arth_type")

val content = row.getAs[String]("content")

var res = Seq[Row]()

val content_array = content.split(" ")

for(con <- content_array){

res = res :+ Row(arth_type,con)

}

res

}).collect() val termListDF = sqlContext.createDataFrame(sc.parallelize(termCheckDF), structType)

termListDF.show(false) sc.stop()

}

}

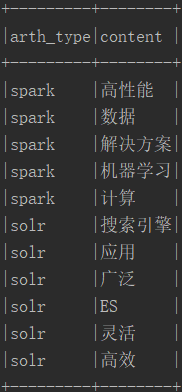

三.列转行执行结果

列转行之前:

列转行:

四.行转列代码实现

package test

import org.apache.log4j.{Level, Logger}

import org.apache.spark.sql.expressions.{MutableAggregationBuffer, UserDefinedAggregateFunction}

import org.apache.spark.sql.types._

import org.apache.spark.sql.{Row, SparkSession}

/**

* 自定义聚合函数实现行转列

*/

object AverageUserDefinedAggregateFunction extends UserDefinedAggregateFunction{

//聚合函数输入数据结构

override def inputSchema:StructType = StructType(StructField("input", StringType) :: Nil)

//缓存区数据结构

override def bufferSchema: StructType = StructType(StructField("result", StringType) :: Nil)

//结果数据结构

override def dataType : DataType = StringType

// 是否具有唯一性

override def deterministic : Boolean = true

//初始化

override def initialize(buffer : MutableAggregationBuffer) : Unit = {

buffer(0) = ""

}

//数据处理 : 必写,其它方法可选,使用默认

override def update(buffer: MutableAggregationBuffer, input: Row): Unit = {

if(input.isNullAt(0)) return

if(buffer.getString(0) == null || buffer.getString(0).equals("")){

buffer(0) = input.getString(0) //拼接字符串

}else{

buffer(0) = buffer.getString(0) + "," + input.getString(0) //拼接字符串

}

}

//合并

override def merge(bufferLeft: MutableAggregationBuffer, bufferRight: Row): Unit ={

if(bufferLeft(0) == null || bufferLeft(0).equals("")){

bufferLeft(0) = bufferRight.getString(0) //拼接字符串

}else{

bufferLeft(0) = bufferLeft(0) + "," + bufferRight.getString(0) //拼接字符串

}

}

//计算结果

override def evaluate(buffer: Row): Any = buffer.getString(0)

}

/**

* Created by Administrator on 2019/12/17.

*/

object Row2Columns {

/**

* 设置日志级别

*/

Logger.getLogger("org").setLevel(Level.WARN)

def main(args: Array[String]): Unit = {

val spark = SparkSession.builder().master("local[2]").appName(s"${this.getClass.getSimpleName}").getOrCreate()

val sc = spark.sparkContext

val sqlContext = spark.sqlContext

val array : Array[String] = Array("大数据-Spark","大数据-Hadoop","大数据-Flink","搜索引擎-Solr","搜索引擎-ES")

val termRdd = sc.parallelize(array).map(row => { // 标准分词,挂载Hanlp分词器

val content = row.split("-")

Row(content(0), content(1))

})

val structType = StructType(Array(

StructField("arth_type", StringType, true),

StructField("content", StringType, true)

))

val termDF = sqlContext.createDataFrame(termRdd,structType)

termDF.show()

termDF.createOrReplaceTempView("term")

/**

* 注册udaf

*/

spark.udf.register("concat_ws", AverageUserDefinedAggregateFunction)

spark.sql("select arth_type,concat_ws(content) content from term group by arth_type").show()

}

}

五.行转列执行结果

行转列之前:

行转列:

Spark基于自定义聚合函数实现【列转行、行转列】的更多相关文章

- mysql列转行 行转列

列转行 SELECT flag ,substring_index(substring_index(t.context,), ) as result FROM ( select 'aa' as flag ...

- Sqlserver 列转行 行转列

sqlserver的行转列 列转行问题 行转列:1 使用Case when 方式 CREATE TABLE [StudentScores]( [UserName] NVARCHAR(20), --学生 ...

- SQL 横转竖 、竖专横(转载) 列转行 行转列

普通行列转换 问题:假设有张学生成绩表(tb)如下: 姓名 课程 分数 张三 语文 张三 数学 张三 物理 李四 语文 李四 数学 李四 物理 想变成(得到如下结果): 姓名 语文 数学 物理 --- ...

- ORACLE 自定义聚合函数

用户可以自定义聚合函数 ODCIAggregate,定义了四个聚集函数:初始化.迭代.合并和终止. Initialization is accomplished by the ODCIAggrega ...

- SQL Server 自定义聚合函数

说明:本文依据网络转载整理而成,因为时间关系,其中原理暂时并未深入研究,只是整理备份留个记录而已. 目标:在SQL Server中自定义聚合函数,在Group BY语句中 ,不是单纯的SUM和MAX等 ...

- oracle 自定义 聚合函数

Oracle自定义聚合函数实现字符串连接的聚合 create or replace type string_sum_obj as object ( --聚合函数的实质就是一个对象 sum ...

- sql内置函数pivot强大的行转列功能

原文:sql内置函数pivot强大的行转列功能 语法: PIVOT用于将列值旋转为列名(即行转列),在SQL Server 2000可以用聚合函数配合CASE语句实现 PIVOT的一般语法是:PIVO ...

- SQL Server 动态行转列(参数化表名、分组列、行转列字段、字段值)

一.本文所涉及的内容(Contents) 本文所涉及的内容(Contents) 背景(Contexts) 实现代码(SQL Codes) 方法一:使用拼接SQL,静态列字段: 方法二:使用拼接SQL, ...

- sql server 2012 自定义聚合函数(MAX_O3_8HOUR_ND) 计算最大的臭氧8小时滑动平均值

采用c#开发dll,并添加到sql server 中. 具体代码,可以用visual studio的向导生成模板. using System; using System.Collections; us ...

随机推荐

- windbg是如何搜索符号文件的?

来个样例 我的符号目录设置是: 用我们在windows下调试必须用到的ntdll.dll模块来讲下windbg加载符号文件的过程.windbg加载符号文件时,会首先根据配置的符号目录信息,在本地符号目 ...

- IE与标准浏览器对事件处理的区别?(监听、阻止冒泡、阻止默认等)

谷歌 IE:监听:addEventListener attachEvent--------要在事件名称前面加on解绑:removeEventListener detachEvent--- ...

- pytest--运行指定的测试和参数化

mark pytest提供了标记机制,允许你使用marker对测试函数做标记,一个测试函数可以有多个marker,一个marker也可以用来标记多个测试函数 比如我们需要进行冒烟测试,不可能把所有的用 ...

- c博客作业-数组

0. 1.本章学习总结 1.1学习内容总结 1.1.1一维数组 1.一般定义形式:类型名 数组名 [数组长度];类型名指定数组中每个元素的类型,数组名是数组变量的名称,是一个合法的标识符,数组长度是一 ...

- shell中使用expect命令进行远程执行命令脚本

expect是用来实现自动交互功能的工具之一,使用expect-send来实现交互过程. 注意: 1.脚本的执行方法与bash shell不一样,比如:expect example.sh 2.向一个脚 ...

- WGS 全基因组测序数据分析

1. DNA测序技术 https://www.jianshu.com/p/6122cecec54a 2.FASTA和FASTQ文件格式 https://www.jianshu.com/p/50ff30 ...

- 第01组 Alpha事后诸葛亮

目录 一.总结思考 1.设想和目标 ①我们的软件要解决什么问题?是否定义得很清楚?是否对典型用户和典型场景有清晰的描述? ②我们达到目标了么(原计划的功能做到了几个? 按照原计划交付时间交付了么? 原 ...

- 【ASP.NET Core分布式项目实战】(四)使用mysql/mysql-server安装mysql

Docker安装Mysql 拉取镜像 docker pull mysql/mysql-server 运行mysql docker run -d -p : --name mysql01 mysql/my ...

- SCIE和SCI

SCI和SCIE(SCI Expanded)分别是科学引文索引及科学引文索引扩展版(即网络版),主要是收录自然科学.工程技术领域最具影响力的重要期刊,包括2000多种外围刊. SCIE和SCI一样吗? ...

- 【C/C++开发】STL内嵌数据类型: value_type

使用stl库的时候一直对value_type这个东西理解的不是很好,可以说就是不理解.今天看了<STL源码剖析>才恍然大悟.这里稍作记录. 每个STL中的类都有value_type这种东西 ...