python3抓取异步百度瀑布流动态图片(二)get、json下载代码讲解

制作解析网址的get

- def gethtml(url,postdata):

- header = {'User-Agent':

- 'Mozilla/5.0 (Windows NT 10.0; WOW64; rv:46.0) Gecko/20100101 Firefox/46.0',

- 'Referer':

- 'http://image.baidu.com',

- 'Host': 'image.baidu.com',

- 'Accept': 'text/plain, */*; q=0.01',

- 'Accept-Encoding':'gzip, deflate',

- 'Accept-Language':'zh-CN,zh;q=0.8,en-US;q=0.5,en;q=0.3',

- 'Connection':'keep-alive'}

- # 解析网页

- html_bytes = requests.get(url, headers=header,params = postdata)

- return html_bytes

头部的构造请参考上一篇博文:

python3抓取异步百度瀑布流动态图片(一)查找post并伪装头方法

分析网址:

- http://image.baidu.com/search/acjson?tn=resultjson_com&ipn=rj&ct=201326592&is=&fp=result&queryWord=gif&cl=2&lm=-1&ie=utf-8&oe=utf-8&adpicid=&st=-1&z=&ic=0&word=gif&s=&se=&tab=&width=&height=&face=0&istype=2&qc=&nc=1&fr=&pn=30&rn=30&gsm=1e&1472364207674=

分解为:

- url = 'http://image.baidu.com/search/acjson?' + postdata + lasturl

lasturl为时间戳,精确到后三位小数的时间戳,构造这个时间戳,后三位小数我就随机生成一个三位数了:

- import time

- import random

- timerandom = random.randint(100,999)

- nowtime = int(time.time())

- lasturl = str(nowtime) + str(timerandom) + '='

最后制作postdata:

- # 构造post

- postdata = {

- 'tn':'resultjson_com',

- 'ipn':'rj',

- 'ct':201326592,

- 'is':'',

- 'fp':'result',

- 'queryWord': keyword,

- 'cl': 2,

- 'lm': -1,

- 'ie': 'utf-8',

- 'oe': 'utf-8',

- 'adpicid': '',

- 'st': -1,

- 'z':'',

- 'ic': 0,

- 'word': keyword,

- 's': '',

- 'se': '',

- 'tab': '',

- 'width': '',

- 'height': '',

- 'face': 0,

- 'istype': 2,

- 'qc': '',

- 'nc': 1,

- 'fr': '',

- 'pn': pn,

- 'rn': 30,

- 'gsm': '1e'

- }

其中页数pn和搜索关键字keywork为:

- # 搜索的关键字

- # keywork = input('请输入你要查找的关键字')

- keyword = 'gif'

- # 页数

- # pn = int(input('你要抓取多少页:'))

- pn = 30

将得到的信息保存在本地,当所有都保存下来了再去下载图片:

- # 解析网址

- contents = gethtml(url,postdata)

- # 将文件以json的格式保存在json文件夹

- file = open('../json/' + str(pn) + '.json', 'wb')

- file.write(contents.content)

- file.close()

读取文件夹里面的所有文件:

- # 找出文件夹下所有xml后缀的文件

- def listfiles(rootdir, prefix='.xml'):

- file = []

- for parent, dirnames, filenames in os.walk(rootdir):

- if parent == rootdir:

- for filename in filenames:

- if filename.endswith(prefix):

- file.append(rootdir + '/' + filename)

- return file

- else:

- pass

遍历json文件夹,读取里面的东西:

- # 找到json文件夹下的所有文件名字

- files = listfiles('../json/', '.json')

- for filename in files:

- print(filename)

- # 读取json得到图片网址

- doc = open(filename, 'rb')

- # ('UTF-8')('unicode_escape')('gbk','ignore')

- doccontent = doc.read().decode('utf-8', 'ignore')

- product = doccontent.replace(' ', '').replace('\n', '')

- product = json.loads(product)

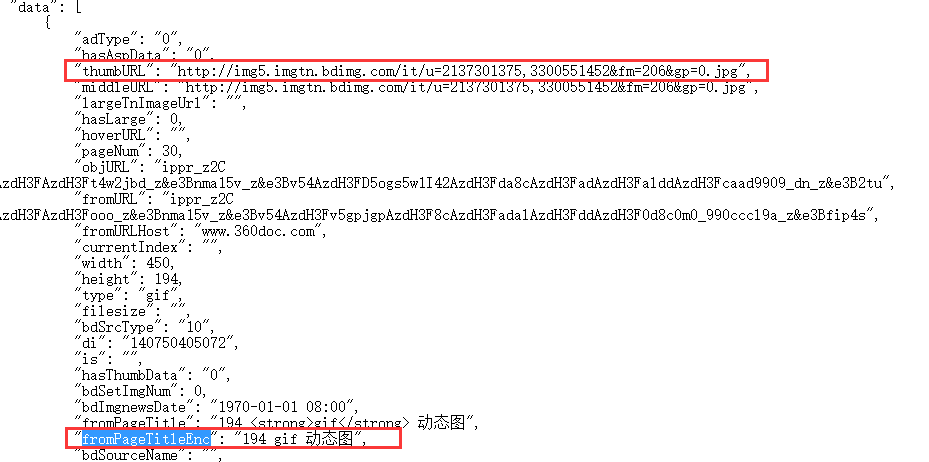

查询字典data:

- # 得到字典data

- onefile = product['data']

将字典里面的图片网址和图片名称放到数组里面:

制作一个解析头来解析图片下载:

- def getimg(url):

- # 制作一个专家

- opener = urllib.request.build_opener()

- # 打开专家头部

- opener.addheaders = [('User-Agent',

- 'Mozilla/5.0 (Windows NT 10.0; WOW64; rv:46.0) Gecko/20100101 Firefox/46.0'),

- ('Referer',

- 'http://image.baidu.com'),

- ('Host', 'image.baidu.com')]

- # 分配专家

- urllib.request.install_opener(opener)

- # 解析img

- html_img = urllib.request.urlopen(url)

- return html_img

最后将图片下载到本地的gif文件夹:

- for item in onefile:

- try:

- pic = getimg(item['thumbURL'])

- # 保存地址和名称

- filenamep = '../gif/' + validateTitle(item['fromPageTitleEnc'] + '.gif')

- # 保存为gif

- filess = open(filenamep, 'wb')

- filess.write(pic.read())

- filess.close()

- # 每一次下载都暂停1-3秒

- loadimg = random.randint(1, 3)

- print('图片' + filenamep + '下载完成')

- print('暂停' + loadimg + '秒')

- time.sleep(loadimg)

- except Exception as err:

- print(err)

- print('暂停' + loadimg + '秒')

- time.sleep(loadimg)

- pass

得到效果如下:

本文只是编程,处理这种网址最重要的是思想,思想我写在上一篇博文:

python3抓取异步百度瀑布流动态图片(一)查找post并伪装头方法

思想有了,程序是很简单的问题而已。

python3抓取异步百度瀑布流动态图片(二)get、json下载代码讲解的更多相关文章

- python3抓取异步百度瀑布流动态图片(一)查找post并伪装头方法

打开流程: 用火狐打开百度图片-->打开firebug-->输入GIF图-->搜索-->点击网络-->全部 观察页面: 首先要观察的对象是“域”,图片的json一般是放在 ...

- 如何利用Python网络爬虫抓取微信朋友圈的动态(上)

今天小编给大家分享一下如何利用Python网络爬虫抓取微信朋友圈的动态信息,实际上如果单独的去爬取朋友圈的话,难度会非常大,因为微信没有提供向网易云音乐这样的API接口,所以很容易找不到门.不过不要慌 ...

- Java学习-046-日志抓取合并后排序问题解决方案之 --- log4j 二次定制,实现日志输出添加延时10ms

自3月25至今,已经好久没有写学习日志了,今天在写日志抓取合并的小方法,发现抓取后的日志并米有依据系统执行的日志顺序排序.日志抓取排列逻辑如下: 通过日志标识,从各个日志文件(例如 use.log,e ...

- 【js】【图片瀑布流】js瀑布流显示图片20180315

js实现把图片用瀑布流显示,只需要“jquery-1.11.2.min.js”. js: //瀑布流显示图片 var WaterfallImg = { option: { maxWidth: 850, ...

- 利用wget 抓取 网站网页 包括css背景图片

利用wget 抓取 网站网页 包括css背景图片 wget是一款非常优秀的http/ftp下载工具,它功能强大,而且几乎所有的unix系统上都有.不过用它来dump比较现代的网站会有一个问题:不支持c ...

- 简单的抓取淘宝关键字信息、图片的Python爬虫|Python3中级玩家:淘宝天猫商品搜索爬虫自动化工具(第一篇)

Python3中级玩家:淘宝天猫商品搜索爬虫自动化工具(第一篇) 淘宝改字段,Bugfix,查看https://github.com/hunterhug/taobaoscrapy.git 由于Gith ...

- Python3抓取javascript生成的html网页

用urllib等抓取网页,只能读取网页的静态源文件,而抓不到由javascript生成的内容. 究其原因,是因为urllib是瞬时抓取,它不会等javascript的加载延迟,所以页面中由javasc ...

- python3抓取淘宝评论内容

好久没有写爬虫了,今天研究了下淘宝商品评论的内容. 一开始用最简单的方法,挂代理,加请求头,对网页请求,是抓不到数据的,在网上找了一些相关文章,也基本已经过时了,就是网站逻辑有改动,用旧的方法是抓不到 ...

- Python3 抓取豆瓣电影Top250

利用 requests 抓取豆瓣电影 Top 250: import re import requests def main(url): global num headers = {"Use ...

随机推荐

- CSS样式选择器

<!-- css样式选择器 HTML选择器 类选择器 ID选择器 关联选择器 组合选择器 伪元素选择器 selector{ /* selector是样式选择器 property:value; / ...

- Connection to DB

Connect to MySQL PHP5 and later can work with a MySQL database using MySQLi extension PDO PDO will w ...

- IOS源码封装成.bundle和.a文件,以及加入xib的具体方法,翻遍网络,仅此一家完美翻译!! IOS7!!(3) 完美结局

以上翻译有误解之处,现在简单做法如下: 经过深入研究,才感觉明白了内部机制,现在简单介绍于下,主要步骤:xcode5 创建库项目,删掉测试文件和默认创建的类,添加viewController类带xib ...

- Margaritas on the River Walk_背包

Description One of the more popular activities in San Antonio is to enjoy margaritas in the park alo ...

- HDU 1811

http://acm.hdu.edu.cn/showproblem.php?pid=1811 中文码题 对于等号的情况,用并查集合并(因为编号不同一定可以分出先后) 然后判断能否构成拓扑排序,以及拓扑 ...

- HDU 1109

http://acm.hdu.edu.cn/showproblem.php?pid=1109 一个范围内给一堆点,求到这些点的最短距离最大 模拟退火,温度是步长 #include <iostre ...

- Play Framework常用标签list,set,如何遍历list、map类型数据

最近一段时间的项目都是在Play这个框架上进行开发的,挺强大的,但不足之处也挺多的.今天分享下play中强大的标签,遍历list,map类型的数据的用法. 遍历单纯的list数据,例如:List< ...

- ubuntu 挂载优盘

不知道为什么重装一次ubuntu后无法自动挂载优盘,只好手动: sudo mount /dev/sdb1 /media/YCC_FD/ 注意,这里优盘是sdb 而非sda 查找自己优盘在什么地方,可以 ...

- poj 1990 MooFest

题目大意: FJ有n头牛,排列成一条直线(不会在同一个点),给出每头牛在直线上的坐标x.另外,每头牛还有一个自己的声调v,如果两头牛(i和j)之间想要沟通的话,它们必须用同个音调max(v[i],v[ ...

- sprintf 用法

字符串格式化命令,主要功能是把格式化的数据写入某个字符串中 试试下面的代码就知道了 #include<cstdio> #include<cstdlib> using names ...