PCA原理推导及其在数据降维中的应用

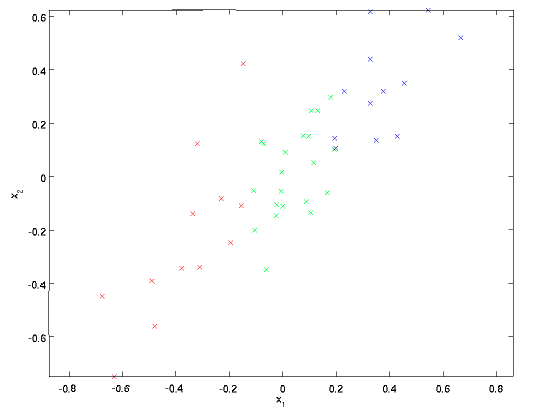

一个信号往往包含多个维度,各个维度之间可能包含较强的相关性。下图表示的是一组二维信号x=(x1,x2),可以看到数据点基本上分布在x2=x1这条直线上,二者存在很强的相关性(也就是确定x1之后,就能确定x2的大致范围)。

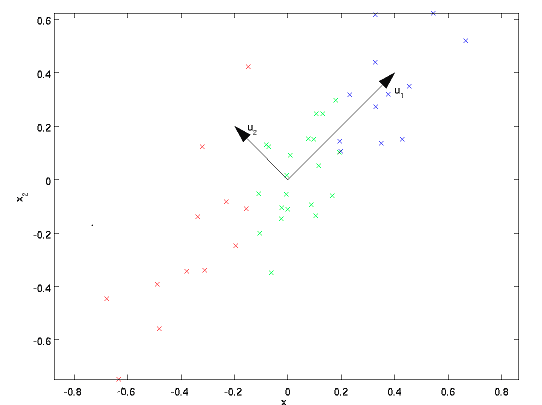

主成分分析(Principal Component Analysis, PCA)的目的在于寻找到一组基,将信号投影到这组基上面,从而能够去除信号各个维度之间的相关性。如下图,u1和u2是通过PCA找到的两个基向量,将信号投影到该基向量上,信号各维度之间的相关性就基本被去除了。

信号各维度之间的相关性可以用相关系数来表示。假设一个维度为x1,另一个维度为x2,二者都相当于随机变量。那么相关系数为:

\]

如果两个变量没有相关性,那么相关系数为0。PCA的目的就在于使得信号任意两个维度之间的相关系数都变成0。上式分子为协方差,我们只考虑将协方差变为0。协方差公式如下:

\]

假设有一组信号,将它们表示为一个矩阵\(X_0\),维度为d*N。\(X_0\)的每一列代表一个信号,d表示信号的维度,N表示有N个信号。X表示各维度去除均值之后的信号。那么信号各维度两两之间的协方差可以表示为一个协方差矩阵:

\]

要去除各维度之间的相关性,相当于让S的非对角元素全变为0,使S对角化。因此我们需要找到一个矩阵U,使S对角化:

\]

正好,S的特征向量组成的矩阵能达到这一目的,因此把S的特征向量放入U的每一列中即可。U的列向量即为主成分向量。D为S的特征值组成的对角阵。我们把信号投影到特征向量中,得到的信号为:

\]

那么Z的协方差矩阵为:

\]

可见,投影后的信号Z各维度之间不存在相关性。实际中我们不需要将X投影到所有的主成分向量上。可以证明,只需要将X投影到前k个最大特征值对应的特征向量上即可,其余特征向量上的投影分量为噪声。k的数量往往远小于信号原来的维度,因此PCA可以对信号进行降维。只需要通过前k个主成分分量,即可复原原信号,并使恢复误差任意小。

S的维度为d*d。由于实际情况下d很大,远远大于信号个数N,直接求S的特征向量复杂度很高。考虑下面的矩阵:

\]

\]

\]

\]

可见,可以先求出\(S_0\)征向量\(u_0\),\(S\)的特征向量为\(Xu_0\)。由于\(S_0\)的维度较低,计算量极大地减少。要求\(S_0\)的特征向量,最直接的方法是做特征值分解。不过由于\(S_0\)是半正定矩阵,也可以通过SVD来求解。下面证明SVD分解与特征值分解之间的关系。对于一个矩阵A(不一定是方阵),SVD分解如下:

\]

\]

\]

上述第三个等式相当于对\(AA^T\)做特征值分解,U为\(AA^T\)的特征值向量矩阵,\(\Sigma^2\)为特征值矩阵。由此可见,要求\(AA^T\)的特征向量,只需对A做SVD分解,取A的左特征向量矩阵即可。

下面给出MATLAB代码示例。通过PCA分解对ORL人脸库中的人脸图片做降维处理,并用前k个主成分(即最大的k个特征值对应的特征向量)将人脸复原。

PCA代码:

function [avg,U]=fastPCA(X,k)% X: X的每一列代表一张人脸图片% k: 降维后的信号维度%%avg=mean(X,2);X=bsxfun(@minus,X,avg);[~,N]=size(X);S0=1/N*(X'*X);[U0,~]=eig(S0);U0=U0(:,end:-1:1); % V0原本是按特征值升序排列的,要调换顺序U=X*U0(:,1:k); % 得到真正协方差矩阵的主成分向量for i=1:size(U,2)U(:,i)=U(:,i)/norm(U(:,i)); % 向量归一化end

主函数:

% 通过少量几个主成分来恢复人脸clear;load orl_data.mat; % 人脸库,每行代表一张人脸图像k=350; % 把人脸降到k维,用k个主成分恢复人脸X=Faces; % 矩阵的每一列代表一张人脸tic;[avg,U]=fastPCA(X,k);toc;X_extract=bsxfun(@minus,X,avg); % 减去均值X_lowdim=U'*X_extract; % 降维后的图像表达X_recv=U*X_lowdim; % 用k个主成分分量恢复人脸X_recv=bsxfun(@plus,X_recv,avg); % 加上均值im=reshape(X_recv(:,1),[112,92]);figure,imshow(im,[]);% 显示前16个主成分u=zeros(112,92);figurefor i=1:16u(:)=U(:,i);subplot(4,4,i),imshow(u,[]);end

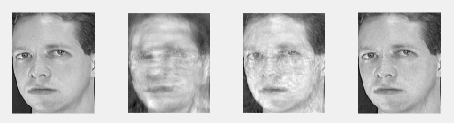

下图图1为原图,分别用50个主成分、200个主成分和350个主成分复原人脸图像,结果如下:

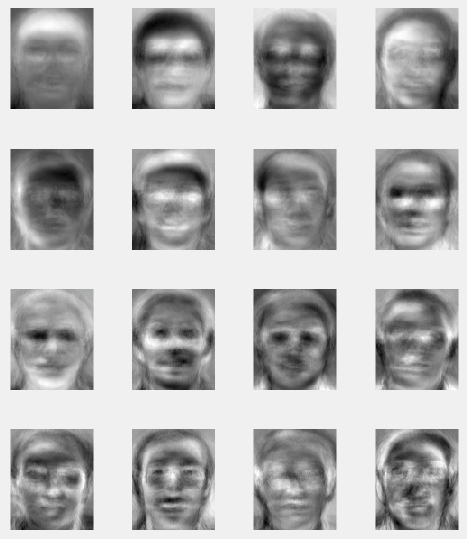

以下为前16个主成分人脸。可以看到越往后的脸,越不平滑。实际上是因为靠后的脸代表的是人脸的高频分量,包含了更多的细节信息,而靠前的人脸是低频分量,更多地包含了人脸的轮廓。这一点和小波变换是有点像的。

PCA原理推导及其在数据降维中的应用的更多相关文章

- 降维算法----PCA原理推导

1.从几何的角度去理解PCA降维 以平面坐标系为例,点的坐标是怎么来的? 图1 ...

- [机器学习]-PCA数据降维:从代码到原理的深入解析

&*&:2017/6/16update,最近几天发现阅读这篇文章的朋友比较多,自己阅读发现,部分内容出现了问题,进行了更新. 一.什么是PCA:摘用一下百度百科的解释 PCA(Prin ...

- 主成分分析PCA数据降维原理及python应用(葡萄酒案例分析)

目录 主成分分析(PCA)——以葡萄酒数据集分类为例 1.认识PCA (1)简介 (2)方法步骤 2.提取主成分 3.主成分方差可视化 4.特征变换 5.数据分类结果 6.完整代码 总结: 1.认识P ...

- (数据科学学习手札20)主成分分析原理推导&Python自编函数实现

主成分分析(principal component analysis,简称PCA)是一种经典且简单的机器学习算法,其主要目的是用较少的变量去解释原来资料中的大部分变异,期望能将现有的众多相关性很高的变 ...

- 数据降维-PCA主成分分析

1.什么是PCA? PCA(Principal Component Analysis),即主成分分析方法,是一种使用最广泛的数据降维算法.PCA的主要思想是将n维特征映射到k维上,这k维是全新的正交特 ...

- 机器学习实战(Machine Learning in Action)学习笔记————10.奇异值分解(SVD)原理、基于协同过滤的推荐引擎、数据降维

关键字:SVD.奇异值分解.降维.基于协同过滤的推荐引擎作者:米仓山下时间:2018-11-3机器学习实战(Machine Learning in Action,@author: Peter Harr ...

- 主成分分析(PCA)原理及推导

原文:http://blog.csdn.net/zhongkejingwang/article/details/42264479 什么是PCA? 在数据挖掘或者图像处理等领域经常会用到主成分分析,这样 ...

- PCA主成分分析算法的数学原理推导

PCA(Principal Component Analysis)主成分分析法的数学原理推导1.主成分分析法PCA的特点与作用如下:(1)是一种非监督学习的机器学习算法(2)主要用于数据的降维(3)通 ...

- 初识PCA数据降维

PCA要做的事降噪和去冗余,其本质就是对角化协方差矩阵. 一.预备知识 1.1 协方差分析 对于一般的分布,直接代入E(X)之类的就可以计算出来了,但真给你一个具体数值的分布,要计算协方差矩阵,根据这 ...

随机推荐

- [BZOJ2654]:tree(Kruskal+WQS二分)

题目传送门 题目描述 给你一个无向带权连通图,每条边是黑色或白色.让你求一棵最小权的恰好有need条白色边的生成树.题目保证有解. 输入格式 开始标号),边权,颜色(0白色1黑色). 输出格式 一行表 ...

- 常用的vi快捷方式

一般情况来说: 0代表行首,$代表行末 $,G代表最后一行 光标移动 0 移动到本行最前面 $ 移动到本行最后 G 移动文件最后一行 nG 移动到文件第n行 gg 移动到文件第一行 n[space]移 ...

- 初始化Thread

此处初始化的步骤和上文中介绍的一样,也是调用runClinit方法.首先设置初始化线程为CurrentThread,然后由于其父类Object此时的状态为CLASS_READY,因此就不需要初始化父类 ...

- python调用c++/c 共享库,开发板上编译的一些坑!

1.对于python,ctypes只能load动态库,但现在我的对象是一个静态库,而且我没有源代码,静态库在编译过程中没有加--fPIC参数,所以我也没办法将其编译为动态库,有没有什么方法在pytho ...

- [VBA]获得工作表名称

sub 获得工作表名称() Dim i As Integer For i = 1 To Worksheets.Count Cells(i, 2) = Worksheets(i).Name Next E ...

- 使用Callable或DeferredResult实现springmvc的异步请求

使用Callable实现springmvc的异步请求 如果一个请求中的某些操作耗时很长,会一直占用线程.这样的请求多了,可能造成线程池被占满,新请求无法执行的情况.这时,可以考虑使用异步请求,即主线程 ...

- rocketMQ 通信协议格式

rocketMQ 使用 netty 通信,端对端的通信,为了避免粘包.分包,需要指定发送数据的边界. 使用的解码器是 LengthFieldBasedFrameDecoder // org.apach ...

- 【HANA系列】SAP HANA SQL获取当前日期

公众号:SAP Technical 本文作者:matinal 原文出处:http://www.cnblogs.com/SAPmatinal/ 原文链接:[HANA系列]SAP HANA SQL获取当前 ...

- 配置数据源和jdbc的使用

一. 配置数据源无论选择Spring的哪种数据访问方式,你都需要配置一个数据源的引用.Spring提供了在Spring上下文中配置数据源bean的多种方式,包括: 通过JDBC驱动程序定义的数据源通过 ...

- 基于 Timer是一种定时器工具

没有依赖 通过Timer中的schedule方法启动定时任务 一般不采用此方法 /** * ------------------------------------------------------ ...