5分钟学习spark streaming之 轻松在浏览器运行和修改Word Counts

方案一:根据官方实例,下载预编译好的版本,执行以下步骤:

- nc -lk 9999 作为实时数据源

- ./bin/run-example org.apache.spark.examples.sql.streaming.StructuredNetworkWordCount localhost 9999

- 在第一步的terminal 窗口输入一些句子

- 第二步的output 就是实时执行结果

此方案的问题有

- 探索其中的api 比较困难,比如我想试试另外一种写法,需要改源码,然后编译,时间就变长了

- 如果是一个裸机的话,需要安装好java 环境,spark和java版本之间的依赖也要特别小心

方案二(2个docker 命令,你就可以为所欲为的在浏览器里面运行,更改Word counts这个hello word了)

除去下载docker img的时间,5min没法完成以下步骤,请立即私信给我,有奖,哈哈

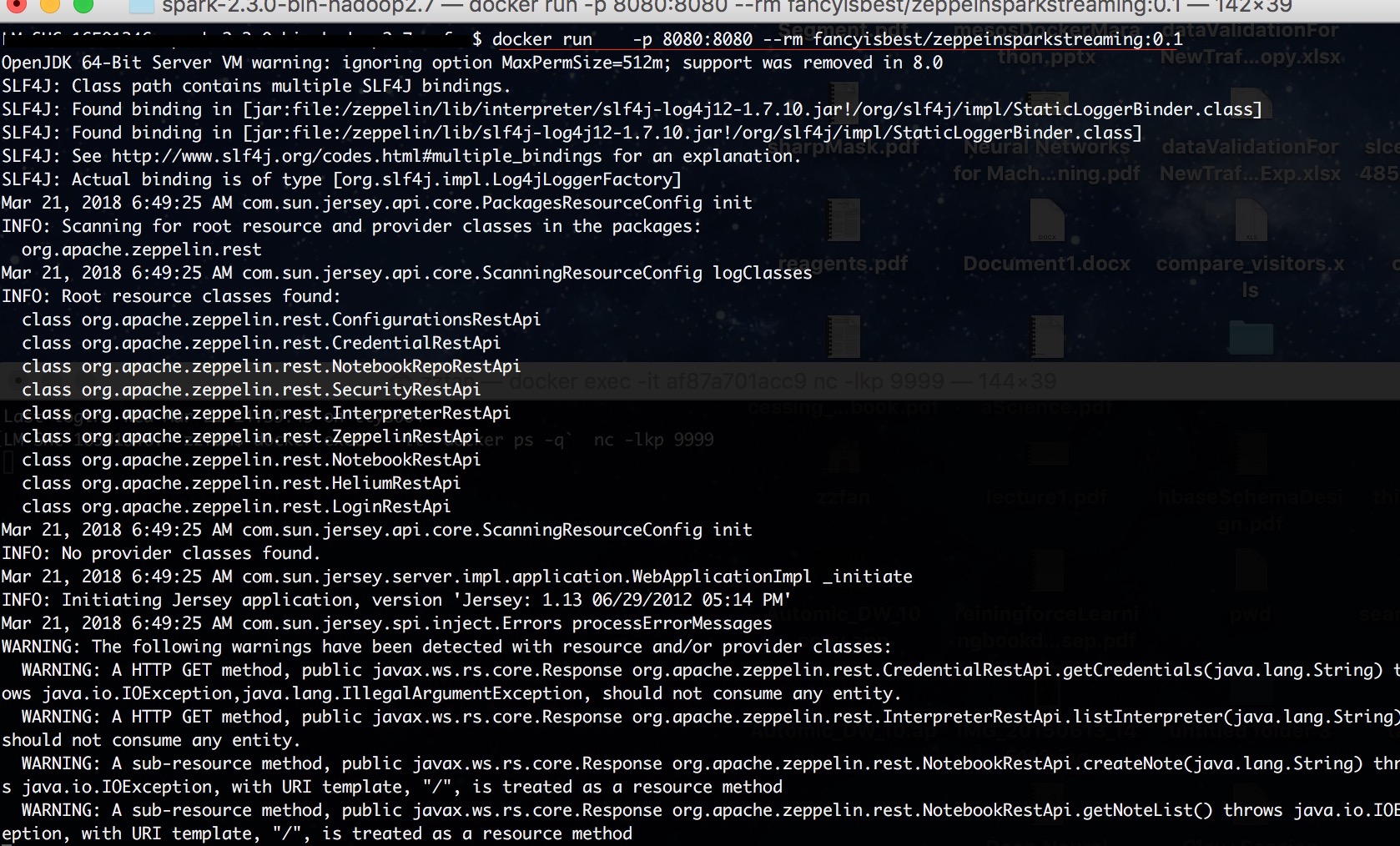

- docker run -p 8080:8080 --rm fancyisbest/zeppeinsparkstreaming:0.1 (第一次会花很长时间在pull img)

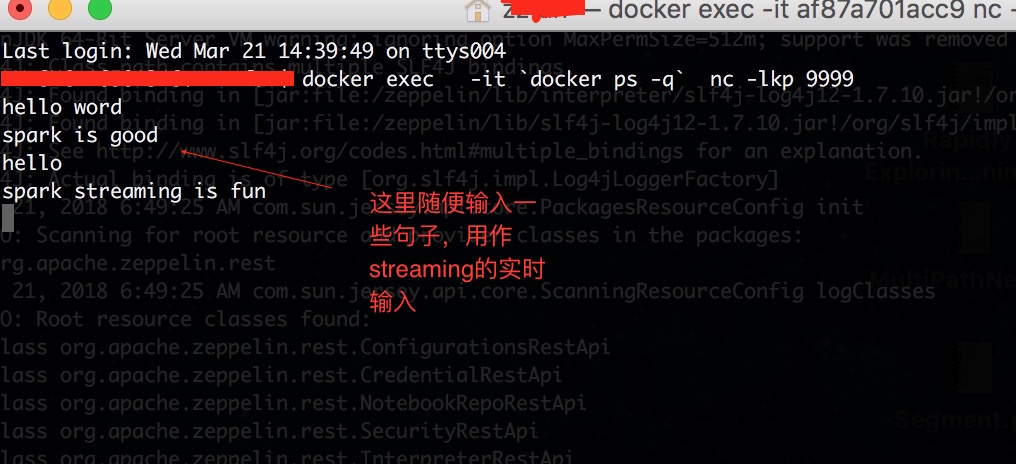

- docker exec -it `docker ps -q` nc -lkp 9999 (注意如果你有多个container在运行,请把`docker ps -q` 替换成上一个的container id)

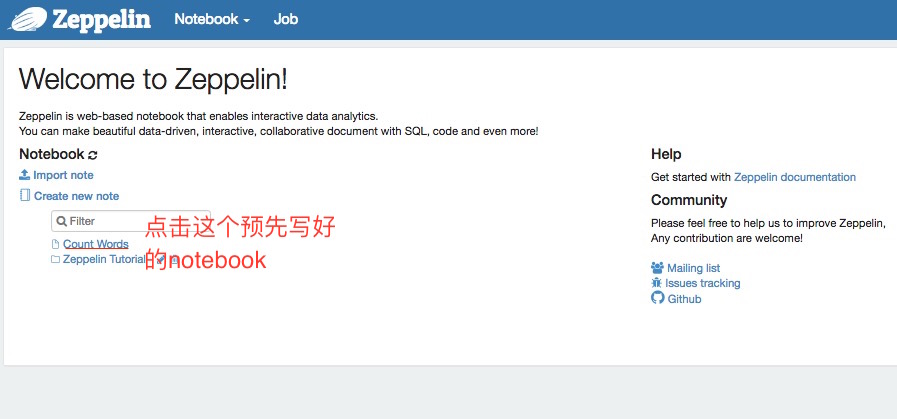

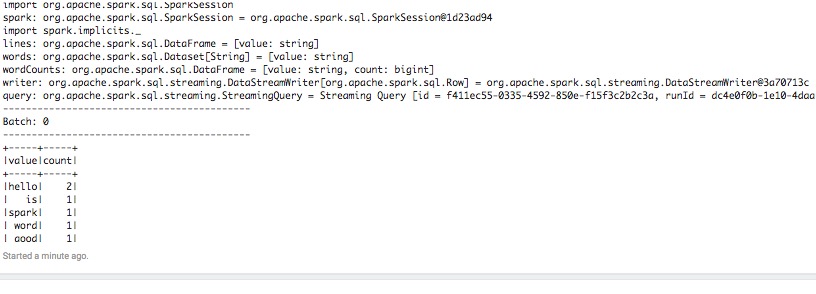

- 打开浏览器输入http://localhost:8080/#/, 左下角有Word counts,点击进入notebook,点击运行所有段落。

- 在第二步termial输入些句子,你就可以在notebook里面观察到streaming 在执行。

此方案的优势

- 除了docker,不需要安装任何依赖,这很dev ops

- 可以狠狠地改代码,改完就可以立即执行,不用担心会破坏任何环境,探索你的世界,你做主。

提示:

- 此方案的技术堆是:docker+zeppelin+spark

- docker img是我在zeppelin img上加入了必要的命令和notebook 打包成的img,请放心使用。

- 如果你对docker,zeppelin不熟悉,不要担心,它们都很简单,只要稍微花点时间就可以掌握,请记住我们的目标是学习spark streaming

参考:

zeppelin 官网http://zeppelin.apache.org/

5分钟学习spark streaming之 轻松在浏览器运行和修改Word Counts的更多相关文章

- 5分钟学习spark streaming 表格和图形化的文档-概览

看图回答以下问题: 1. spark streaming 架构以及功能特性 2. spark streaming mode?以及每个mode主要特性?包括延迟和语义保证.

- Dream_Spark-----Spark 定制版:005~贯通Spark Streaming流计算框架的运行源码

Spark 定制版:005~贯通Spark Streaming流计算框架的运行源码 本讲内容: a. 在线动态计算分类最热门商品案例回顾与演示 b. 基于案例贯通Spark Streaming的运 ...

- 【Streaming】30分钟概览Spark Streaming 实时计算

本文主要介绍四个问题: 什么是Spark Streaming实时计算? Spark实时计算原理流程是什么? Spark 2.X下一代实时计算框架Structured Streaming Spark S ...

- 基于案例贯通 Spark Streaming 流计算框架的运行源码

本期内容 : Spark Streaming+Spark SQL案例展示 基于案例贯穿Spark Streaming的运行源码 一. 案例代码阐述 : 在线动态计算电商中不同类别中最热门的商品排名,例 ...

- 5.Spark Streaming流计算框架的运行流程源码分析2

1 spark streaming 程序代码实例 代码如下: object OnlineTheTop3ItemForEachCategory2DB { def main(args: Array[Str ...

- 贯通Spark Streaming流计算框架的运行源码

本章节内容: 一.在线动态计算分类最热门商品案例回顾 二.基于案例贯通Spark Streaming的运行源码 先看代码(源码场景:用户.用户的商品.商品的点击量排名,按商品.其点击量排名前三): p ...

- Spark Streaming概念学习系列之SparkStreaming运行原理

SparkStreaming运行原理 Spark Streaming不断的从数据源获取数据(连续的数据流),并将这些数据按照周期划分为batch. Spark Streaming将每个batch的数据 ...

- spark streaming 接收kafka消息之四 -- 运行在 worker 上的 receiver

使用分布式receiver来获取数据使用 WAL 来实现 exactly-once 操作: conf.set("spark.streaming.receiver.writeAheadLog. ...

- Spark Streaming:大规模流式数据处理的新贵(转)

原文链接:Spark Streaming:大规模流式数据处理的新贵 摘要:Spark Streaming是大规模流式数据处理的新贵,将流式计算分解成一系列短小的批处理作业.本文阐释了Spark Str ...

随机推荐

- @EnableAsync @Asnc 以及4种拒绝策略

根据不同的场景,可以选择不同的拒绝策略,如果任务非常重要,线程池队列满了,可以交由调用者线程同步处理. 如果是一些不太重要日志,可以直接丢弃掉. 如果一些可以丢弃,但是又需要知道被丢弃了,可以使用Th ...

- eclipse导入/编译hadoop源代码

1. 确保安装好JDK和eclipse 详细教程见: http://blog.csdn.net/kangdakangdaa/article/details/11364985 2. 安装 Subclip ...

- 借助TZImagePickerController三方库理解自定义相册

借助TZImagePickerController三方库理解自定义相册 1.整体架构分析 整体框架大致可以分为几个部分 <1>工具类-TZImageManager:这个类主要是工作是提供一 ...

- 【Android测试工具】Android抓包解析全过程

需求原因 在android开发中,遇到socket编程,无法从log日志中查看到与之通讯的socket发送和返回的数据包是什么,这里介绍一个工具,tcpdump工具和wireshark工具查看抓到的内 ...

- 一句python,一句R︱模块导入与查看、数据读写出入、数据查看函数、数据类型、遍历文件

先学了R,最近刚刚上手python,所以想着将python和R结合起来互相对比来更好理解python.最好就是一句python,对应写一句R. pandas中有类似R中的read.table的功能,而 ...

- Stanford Word Segmenter使用

1,下载 Stanford Word Segmenter软件包: Download Stanford Word Segmenter version 2014-06-16 2,在eclipse上建立一个 ...

- 芝麻HTTP:Python爬虫利器之Xpath语法与lxml库的用法

安装 pip install lxml 利用 pip 安装即可 XPath语法 XPath 是一门在 XML 文档中查找信息的语言.XPath 可用来在 XML 文档中对元素和属性进行遍历.XPat ...

- 芝麻HTTP:Python爬虫入门之URLError异常处理

1.URLError 首先解释下URLError可能产生的原因: 网络无连接,即本机无法上网 连接不到特定的服务器 服务器不存在 在代码中,我们需要用try-except语句来包围并捕获相应的异常.下 ...

- CentOS时钟同步服务器

①本地时钟服务器需要安装chrony服务,可以通过yum.rpm.源码包安装,chrony支持C/S模式 ②编辑本地时钟服务,使其指向提供标准时间服务器,例如:中国国家授时中心NTP服务器. 修改配置 ...

- 决策树系列(五)——CART

CART,又名分类回归树,是在ID3的基础上进行优化的决策树,学习CART记住以下几个关键点: (1)CART既能是分类树,又能是分类树: (2)当CART是分类树时,采用GINI值作为节点分裂的依据 ...