Python开发爬虫之理论篇

爬虫简介

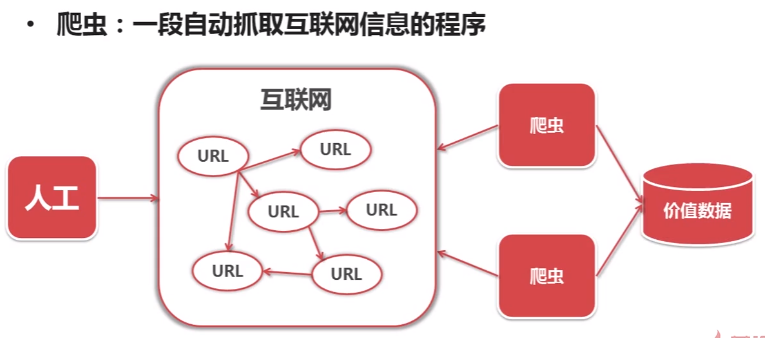

爬虫:一段自动抓取互联网信息的程序。

什么意思呢?

互联网是由各种各样的网页组成。每一个网页对应一个URL,而URL的页面上又有很多指向其他页面的URL。这种URL之间相互的指向关系就形成了一个网络,这就是互联网。

正常情况下就是我们采用人工点击的方式,去获取互联网上指定的信息,这种方式的特点是覆盖面小。

那有没有可能有一种方式,是当我们设定了一个互联网上感兴趣的目标,然后自动地从互联网上去获取我们所需要的数据呢?

有,这就是爬虫。它可以从一个URL出发访问该URL所关联的所有URL,并且从每个页面上提取出我们所需要的价值数据。

也就是说,爬虫就是自动访问互联网,并且提取数据的程序。

爬虫技术的价值

互联网数据,为我所用。

Python简单爬虫架构

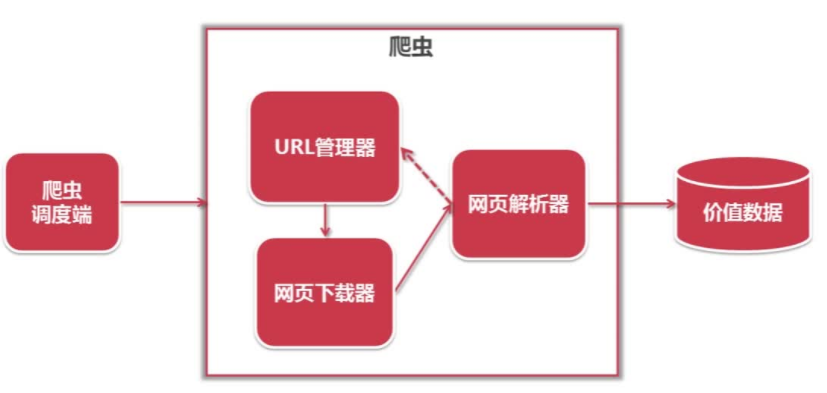

1)首先,我们需要一个爬虫调度端。爬虫调度端的作用:启动爬虫,停止爬虫,监视爬虫运行情况。

2)在爬虫程序中有三个模块:URL管理器、网页下载器、网页解析器。

3)URL管理器:对将要爬取的和已经爬取过的URL进行管理;可取出待爬取的URL,将其传送给“网页下载器”。

4)网页下载器:将URL指定的网页下载,存储成一个字符串,在传送给“网页解析器”。

5)网页解析器:解析网页可解析出

①有价值的数据

②另一方面,每个网页都包含有指向其他网页的URL,解析出来后可补充进“URL管理器”

此时,这三个模块就形成了一个循环,只要有感兴趣的URL,这三个模块就会一直循环下去。

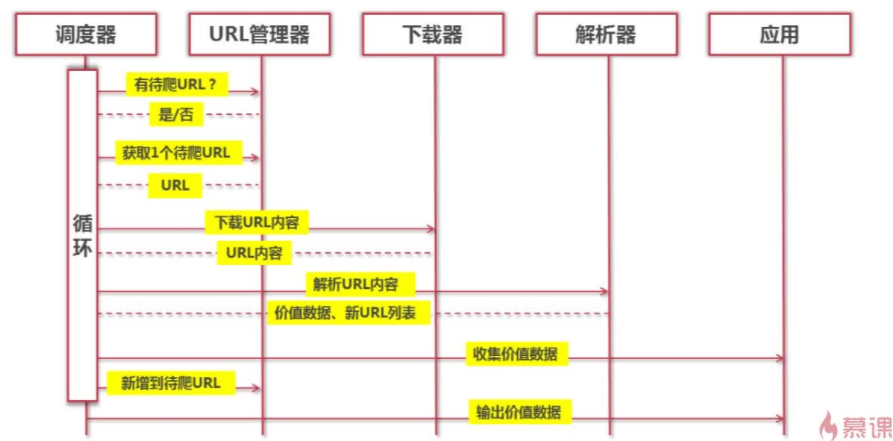

Python简单爬虫架构的动态运行流程(以时序图的方式展示)

Python爬虫URL管理

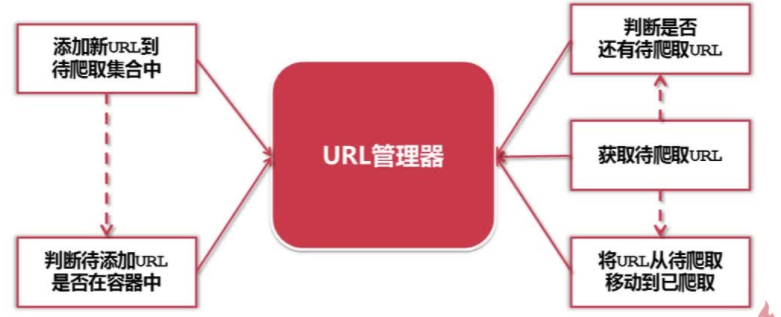

URL管理器:管理待抓取URL集合和已抓取URL集合。

目的:防止重复抓取、防止循环抓取。

Python爬虫URL管理器的实现方式

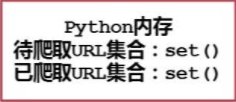

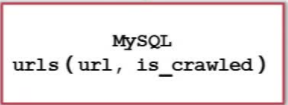

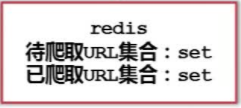

Python爬虫URL管理器的实现方式具体有三种:

1)使用内存,在Python中主要使用set集合(方便去除重复的元素)

2)使用关系数据库,使用两个字段:url和is_crawled(用来标记是否被爬取)

3)使用缓存数据库,同样使用set集合

其中,大型公司一般选择高性能的缓存数据库。个人,小公司一般使用内存。若是想永久存储,常使用关系数据库。

Python爬虫网页下载器简介

网页下载器:一个工具,通过URL将互联网上对应的的网页以HTML的形式下载到本地存储成本地文件或内存字符串,后进行后续处理;

Python有哪几种网页下载器:urllib2(Python官方模块,基础模块)、requests(第三方模块,功能强大)。

Python爬虫urlib2下载器网页的三种方法

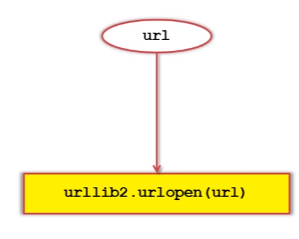

1)urllib2下载网页方法1:最简洁方法

将url直接传给urllib2的urlopen()方法。

对应代码:

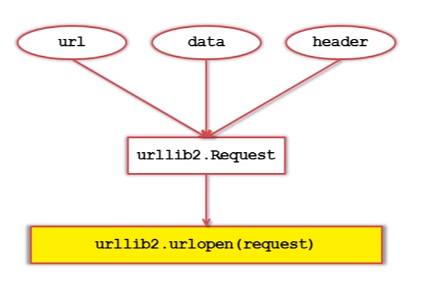

2)urllib2下载网页方法2:除url外,添加data、http header。

进行增强处理。

其中,data向服务器提交需要用户输入的数据。

http header用来向服务器提交http的头信息。

对应代码:

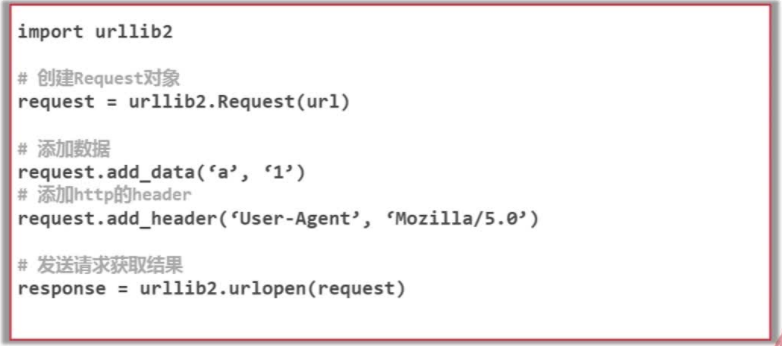

代码中request.add_data('a','1') #添加的数据类型为键值对,即a=1。

request.add_header() #可以对url请求进行伪装

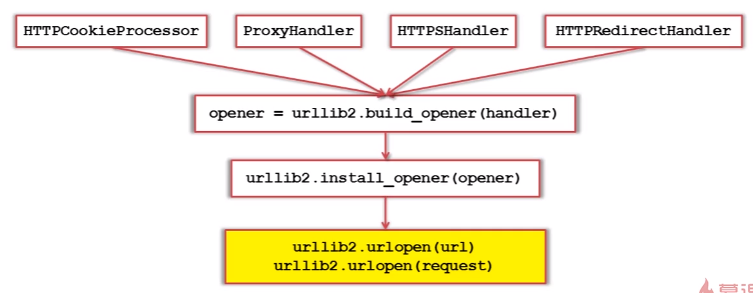

3)urllib2下载网页方法3:添加特殊情景的处理器

更大更强的功能处理能力。

对应代码(举例:增强cookie的处理)

Python爬虫urlib2实例代码演示

import urllib2, cookielib

url ="http://www.baidu.com"

print '第一种方法'

respones1 = urllib2.urlopen(url)

print respones1.getcode()

print len(respones1.read())

print "第二种方法"

request = urllib2.Request(url)

request.add_header("user-agent","Mozillla/5.0")

respones2 = urllib2.urlopen(request)

print respones2.getcode()

print len(respones2.read()) print '第三种方法'

cj =cookielib.CookieJar()

opener = urllib2.bulid_opener(urllib2.HTTPCookieProcessor(cj))

urllib2.install_opener(opener)

print respones3.getcode()

print cj

print respones3.read()

Python爬虫网页解析器简介

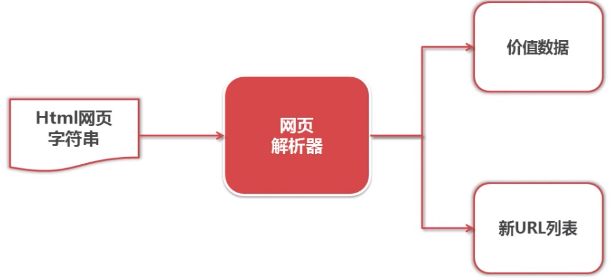

网页解析器:从网页中提取有价值数据的工具。

功能:

1)提取出新的待爬取URL列表;

2)解析出有价值的数据:

网页解析器会以下载好的html网页字符串作为输入,提取出有价值的数据以及新的待爬取的URL列表。

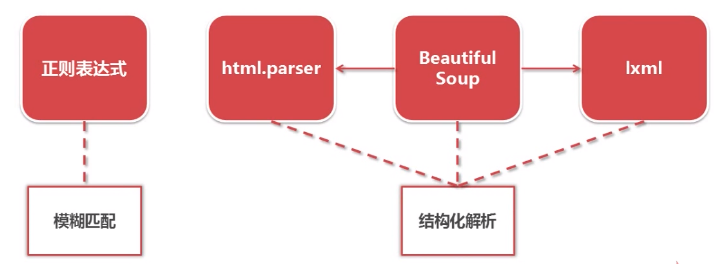

Python有哪些网页解析器呢?

1)正则表达式。最直观的一种。将网页文档down成一个字符串,采用模糊匹配的方式进行提取有价值的数据。虽然直观,但是当网页文档十分复杂的时候,这种方式将十分复杂。

2)使用Python自带的html.parser模块进行解析。

3)使用Beautiful Soup这个第三方插件来解析网页。功能强大的Beautiful Soup可以用html.parser或者lxml作为它的解析器。

4)使用lxml这个第三方插件来解析html网页或者xml文档。

结构化解析——DOM(DOcument Object Model)树

BeautifulSoup第三方模块

BeautifulSoup官网:https://www.crummy.com/software/BeautifulSoup/

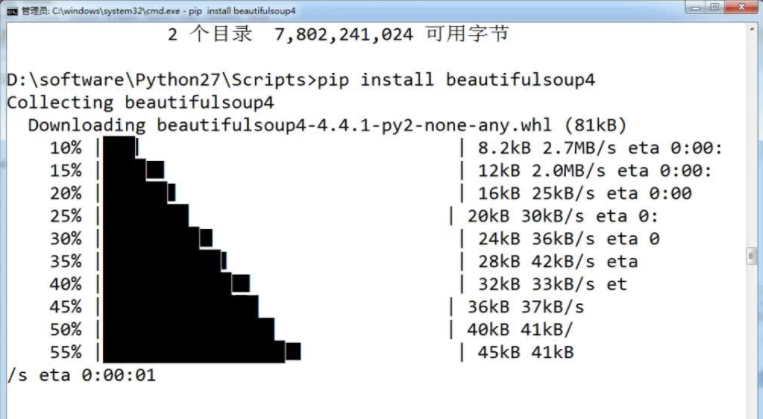

安装BeautifulSoup:

如果你安装了pip,那么就简单了,无需从官网下载,打开命令提示符页面。

进入到Python安装目录下的Scripts文件夹路径下,输入“pip install beautifulsoup4”,即可进行自动安装。

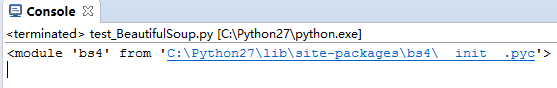

安装完,在eclipse中进行测试,新建一个Python模块,输入:

import bs4

print bs4

输出为:

证明安装成功。

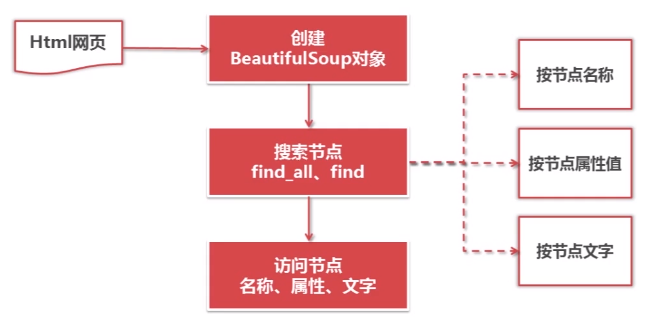

BeautifulSoup的语法

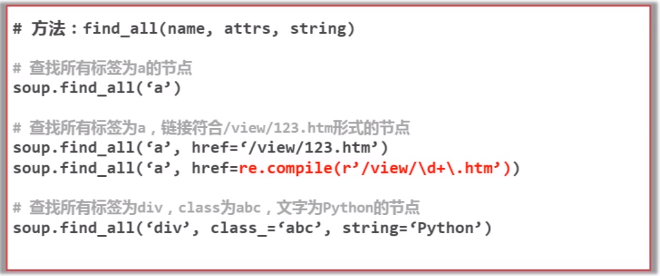

其中搜索节点的find_all()方法可以搜索出所有符合要求的节点,而find()方法则只是搜索出符合条件的第一个节点。但是两个函数的参数是完全相同的。

对应代码:

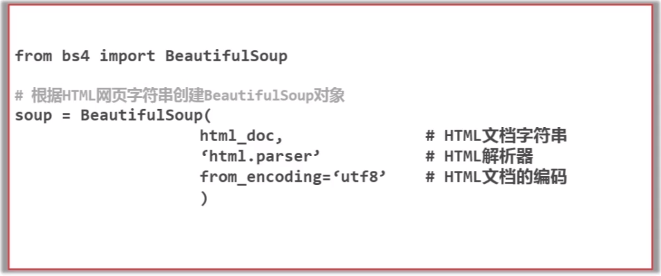

1)创建BeautifulSoup对象

2)搜索节点(find_all、find)

其中红色部分为正则表达式形式。

最后一句之所以"class_"要加上下划线是因为要和Python的关键字"class"进行区分。

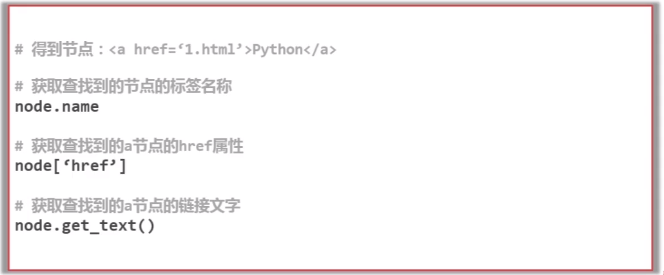

3)访问节点信息

4)BeautifulSoup的实例测试

# coding:utf-8

from bs4 import BeautifulSoup

import re

print("Python3 的代码如下")

html_doc = """

因字数限制,省略。请到 http://www.crummy.com/software/BeautifulSoup/bs4/doc/#searching-the-tree 复制吧

""" soup = BeautifulSoup(html_doc, 'html.parser')

print("获取所有的链接")

links = soup.find_all('a')

for link in links:

print(link.name, link['href'], link.get_text()) print("获取lacie的链接")

link_node = soup.find('a', href="http://example.com/lacie")

print(link_node.name, link_node['href'], link_node.get_text())

print("正则匹配")

link_node = soup.find('a', href=re.compile(r"ill"))

print(link_node.name, link_node['href'], link_node.get_text()) print("获取p段落文字")

p_node = soup.find('p', class_="title")

print(p_node.name, p_node.get_text())

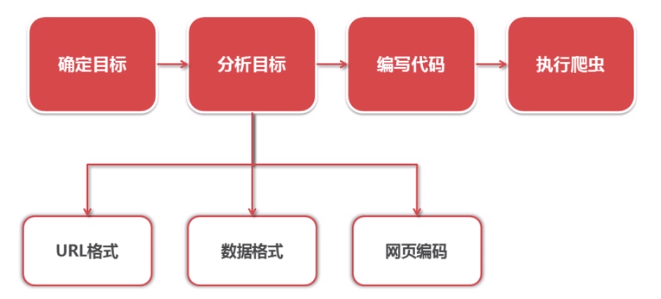

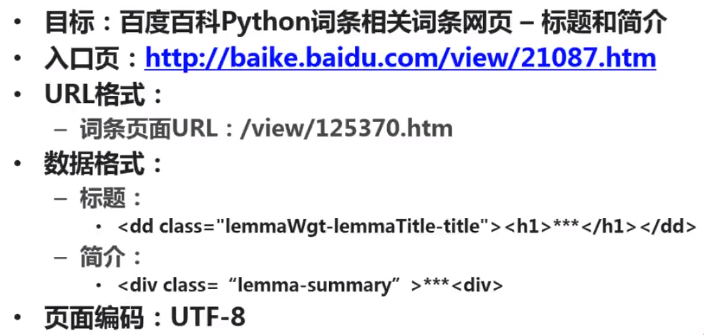

实战演练:爬取百度百科1000个页面的数据

1) 实例爬虫操作步骤

2)Python爬虫实例-分析目标

本篇博客参考慕课网课程:https://www.imooc.com/video/10683

Python开发爬虫之理论篇的更多相关文章

- Python开发【第七篇】:面向对象 和 python面向对象进阶篇(下)

Python开发[第七篇]:面向对象 详见:<Python之路[第五篇]:面向对象及相关> python 面向对象(进阶篇) 上一篇<Python 面向对象(初级篇)> ...

- 【转】Eclipse和PyDev搭建完美Python开发环境(Ubuntu篇)

原文网址:http://www.cnblogs.com/Realh/archive/2010/10/10/1847251.html 前两天在Windows下成功地搭好了一个Python开发环境,这次转 ...

- Python开发【第二十三篇】:持续更新中...

Python开发[第二十三篇]:持续更新中...

- Python开发【第二十一篇】:Web框架之Django【基础】

Python开发[第二十一篇]:Web框架之Django[基础] 猛击这里:http://www.cnblogs.com/wupeiqi/articles/5237704.html Python之 ...

- Python开发【第二十篇】:缓存

Python开发[第二十篇]:缓存redis&Memcache 点击这里 Python之路[第九篇]:Python操作 RabbitMQ.Redis.Memcache.SQLAlchemy ...

- Python开发【第十三篇】:jQuery--无内容点击-不进去(一)

Python开发[第十三篇]:jQuery--无内容点击-不进去(一)

- Python开发【第十篇】:CSS --无内容点击-不进去(一)

Python开发[第十篇]:CSS --无内容点击-不进去(一)

- BT网站--Python开发爬虫代替.NET

BT网站-奥修磁力-Python开发爬虫代替.NET写的爬虫,主要演示访问速度和在一千万左右的HASH记录中索引效率. IBMID 磁力下载- WWW.IBMID.COM 现在用的是Python + ...

- Python开发爬虫之BeautifulSoup解析网页篇:爬取安居客网站上北京二手房数据

目标:爬取安居客网站上前10页北京二手房的数据,包括二手房源的名称.价格.几室几厅.大小.建造年份.联系人.地址.标签等. 网址为:https://beijing.anjuke.com/sale/ B ...

随机推荐

- 多媒体文件格式(三):M3U8 格式

一.M3U8 格式标准介绍 M3U8文件是指UTF-8编码格式的M3U文件.M3U文件是记录了一个索引纯文本文件,打开它时播放软件并不是播放它,而是根据它的索引找到对应的音视频文件的网络地址进行在线播 ...

- idea 启动调试模式总提示端口58346被占用问题

在开发的时候,莫名其妙没法用jrebel调试模式启动了tomcat了,最开始以为是后台端口占用问题,然而把后台java程序全部关了都没用.仔细排查,根据提示发现是端口58346被占用了, 于是便在 w ...

- CS231n 第一次作业KNN中本地CIFAR10数据集的载入

一.问题描述 网上绝大多数作业参考都是在jupyter下运行的,数据集载入过程一般如下: from cs231n.data_utils import load_CIFAR10 #导入数据集,并打印出数 ...

- ansible基础-Jinja2模版 | 测试

一 简介 注:本文demo使用ansible2.7稳定版 Jinja2的测试语句被用来评估一个条件表达式,并且最终返回True或False,经常和「when」语句搭配使用. 测试语句和过滤器的相同点: ...

- [Swift]LeetCode377. 组合总和 Ⅳ | Combination Sum IV

Given an integer array with all positive numbers and no duplicates, find the number of possible comb ...

- [Swift]LeetCode753. 破解保险箱 | Cracking the Safe

There is a box protected by a password. The password is n digits, where each letter can be one of th ...

- [Swift]LeetCode840. 矩阵中的幻方 | Magic Squares In Grid

A 3 x 3 magic square is a 3 x 3 grid filled with distinct numbers from 1 to 9 such that each row, co ...

- 微信小程序自定义导航栏

微信小程序需要自定义导航栏,特别是左上角的自定义设置,可以设置返回按钮,菜单按钮,配置如下: 1.在app.json的window属性中增加: navigationStyle:custom 顶部导航栏 ...

- Mac下安装配置Python2和Python3并相互切换使用

mac os 以前没有使用过,这次使用了一把,的确还是比较不顺手的,估计从今以后,就要把平台逐渐切换到mac了.今后好的文章,专门会开一个macos专栏,专门记录macos的使用过程中的心得,体会,以 ...

- python glob的安装和使用

基本概念 glob是python自己带的一个文件操作相关模块,用它可以查找符合自己目的的文件,类似于Windows下的文件搜索,支持通配符操作.*,?,[]这三个通配符,*代表0个或多个字符,?代表一 ...