千图网爬图片(BeautifulSoup)

import requests

from bs4 import BeautifulSoup

import os #导入os模块 class TuKuSpider():

"""docstring for TuKuSpider"""

def __init__(self):

self.headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36'}

self.url='http://588ku.com/tuku/jiepai.html'

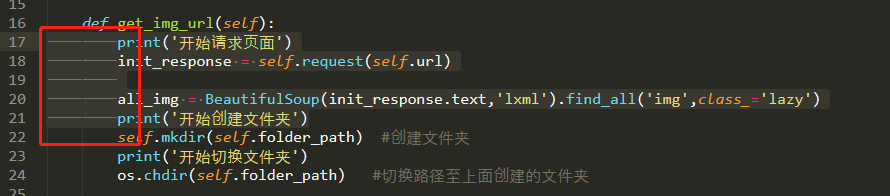

self.folder_path='E:\TuKuImg' def get_img_url(self):

print('开始请求页面')

init_response = self.request(self.url) all_img = BeautifulSoup(init_response.text,'lxml').find_all('img',class_='lazy')

print('开始创建文件夹')

self.mkdir(self.folder_path) #创建文件夹

print('开始切换文件夹')

os.chdir(self.folder_path) #切换路径至上面创建的文件夹 for each in all_img:

img_url = each.get('data-original')

img_name = each.get('alt')

if img_name == None:

img_name = 'NoName'

if img_url[-3:]=='png':

img_url_final = 'http:'+img_url

img_response = self.request(img_url_final)

self.save_png(img_url_final,img_name) else:

img_url = img_url[:img_url.index('.jpg')+4]

img_url_final = 'http:'+img_url

img_response = self.request(img_url_final)

self.save_jpg(img_url_final,img_name) def request(self,url):

r=requests.get(url,headers=self.headers)

return r def save_jpg(self, url, name): ##保存图片

print('开始请求图片地址,过程会有点长...')

img = self.request(url)

file_name = name + '.jpg'

print('开始保存图片')

f = open(file_name, 'ab')

f.write(img.content)

print(file_name,'图片保存成功!')

f.close() def save_png(self, url, name): ##保存图片

print('开始请求图片地址,过程会有点长...')

img = self.request(url)

file_name = name + '.png'

print('开始保存图片')

f = open(file_name, 'ab')

f.write(img.content)

print(file_name,'图片保存成功!')

f.close() def mkdir(self, path): ##这个函数创建文件夹

path = path.strip()

isExists = os.path.exists(path)

if not isExists:

print('创建名字叫做', path, '的文件夹')

os.makedirs(path)

print('创建成功!')

else:

print(path, '文件夹已经存在了,不再创建') a = TuKuSpider()

a.get_img_url()

这个是针对千图网里面,搜索“街拍”弹出的结果进行一个爬虫编写。纯粹是为了练习,只爬15张图没什么必要写爬虫,手动都下载完了。

下面写一下这个爬虫的一些关键点:

一、图片URL所在位置:包含在属性class是lazy的IMG标签内,data-original内。

二、图片的URL需要进行文本处理,有些需要,有些不需要,要写个if判断。

三、图片保存的时候,在命名时要注意,后缀除了JPG以外,还有PNG,我的处理是加多了一个保存PNG的类。

踩的一些坑:

一、逻辑主体里面,有时在sublime text复制来复制去的时候,前面没有了空格,python会报错,只有前面是实线时,才是正确的,圆点是会报错的。

二、URL必须带“http://”不然requests无法识别,或者文本处理后的URL有误,都会报错:requests.exceptions.MissingSchema: Invalid URL

千图网爬图片(BeautifulSoup)的更多相关文章

- 【Python爬虫实战】 图片爬虫-淘宝图片爬虫--千图网图片爬虫

所谓图片爬虫,就是从互联网中自动把对方服务器上的图片爬下来的爬虫程序.有些图片是直接在html文件里面,有些是隐藏在JS文件中,在html文件中只需要我们分析源码就能得到如果是隐藏在JS文件中,那么就 ...

- python爬虫实战(二)--------千图网高清图

相关代码已经修改调试----2017-3-21 实现:千图网上高清图片的爬取 程序运行20小时,爬取大约162000张图片,一共49G,存入百度云.链接:http://pan.baidu.com/s/ ...

- 爬虫实战--基于requests 和 Beautiful的7160美图网爬取图片

import requests import os from bs4 import BeautifulSoup import re # 初始地址 all_url = 'http://www.7160. ...

- 好看的UI设计网站 www.ui.cn 和 插画网站 www.pixiv.net 千图网,界面很不错~

http://www.ui.cn/?t=share#project http://www.pixiv.net/ http://www.flaticon.com/ www.58pic.com 那张 给人 ...

- python爬取千库网

url:https://i588ku.com/beijing/0-0-default-0-8-0-0-0-0-1/ 有水印 但是点进去就没了 这里先来测试是否有反爬虫 import requests ...

- 爬取斗图网图片,使用xpath格式来匹配内容,对请求伪装成浏览器, Referer 防跨域请求

6.21自我总结 一.爬取斗图网 1.摘要 使用xpath匹配规则查找对应信息文件 将请求伪装成浏览器 Referer 防跨域请求 2.爬取代码 #导入模块 import requests #爬取网址 ...

- 每天一个小程序—0013题(爬图片+正则表达式 or BeautifulSoup)

第 0013 题: 用 Python 写一个爬图片的程序,爬 这个链接里的日本妹子图片 :-) 关于python3的urllib模块,可以看这篇博客:传送门 首先是用urlopen打开网站并且获取网页 ...

- python爬取斗图网中的 “最新套图”和“最新表情”

1.分析斗图网 斗图网地址:http://www.doutula.com 网站的顶部有这两个部分: 先分析“最新套图” 发现地址栏变成了这个链接,我们在点击第二页 可见,每一页的地址栏只有后面的pag ...

- 【Python还能干嘛】爬取微信好友头像完成马赛克拼图(千图成像)~

马赛克拼图 何谓马赛克拼图(千图成像),简单来说就是将若干小图片平凑成为一张大图,如下图路飞一样,如果放大看你会发现里面都是一些海贼王里面的图片. Our Tragets 爬取所有微信好友的头像

随机推荐

- [GO]new函数的使用

new函数的作用其实就是动态分配一个空间,我们只需要进行使用,不需要考虑它的内存释放的它的生命周期 package main import "fmt" func main() { ...

- QT背景

Qt是一个跨平台的C++图形用户界面应用程序框架.它为应用程序开发者提供建立基于window界面所需的功能. Qt是诺基亚公司的一个产品.1996年,Qt进入商业领域,已成为全世界范围内数千种成功的应 ...

- C# return、continue、break

return 终止当前进程 可用循环判断,验证,等功能 if (ew == v) { PublicControlLib.Class.PublicProperties.ShowSuccess(); re ...

- Dynamically loading unmanaged OCX in C#

You'll have to perform a number of steps that are normally taken of automatically when you use the t ...

- WinForm中ListBox的使用

获取选中数据:listbox.SelectedItem as XXX 重绘每一行item DrawMode设置为DrawMode.OwnerDrawVariable 然后实现DrawItem(obje ...

- 20165219 《Java程序设计》实验三(敏捷开发与XP实践)实验报告

20165219 <Java程序设计>实验三(敏捷开发与XP实践)实验报告 一.实验报告封面 课程:Java程序设计 班级:1652班 姓名:王彦博 学号:20165219 成绩: 指导教 ...

- (原创)数据结构之利用KMP算法解决串的模式匹配问题

给定一个主串S(长度<=10^6)和一个模式T(长度<=10^5),要求在主串S中找出与模式T相匹配的子串,返回相匹配的子串中的第一个字符在主串S中出现的位置. 输入格式: 输入有两行 ...

- servlet 核心技术

servlet 核心技术 servlet 生命周期 在 servlet 生命周期中,servlet 容器完成加载 servlet 类和实例化一个 servlet 实例,并通过3个方法来完成生命周期中的 ...

- 题解 CF500D 【New Year Santa Network】

题目链接 这道题首先是要看看该如何化简,先把三元组化成二元组. 之后统计经过某条边的 次数$*$权值 的和. 最后除以总基数 $tot$ 其中,每条边被计算的次数为 子树的点数$*$非子树的点数 ( ...

- loj #2013. 「SCOI2016」幸运数字

#2013. 「SCOI2016」幸运数字 题目描述 A 国共有 n nn 座城市,这些城市由 n−1 n - 1n−1 条道路相连,使得任意两座城市可以互达,且路径唯一.每座城市都有一个幸运数字,以 ...