python 下载小说

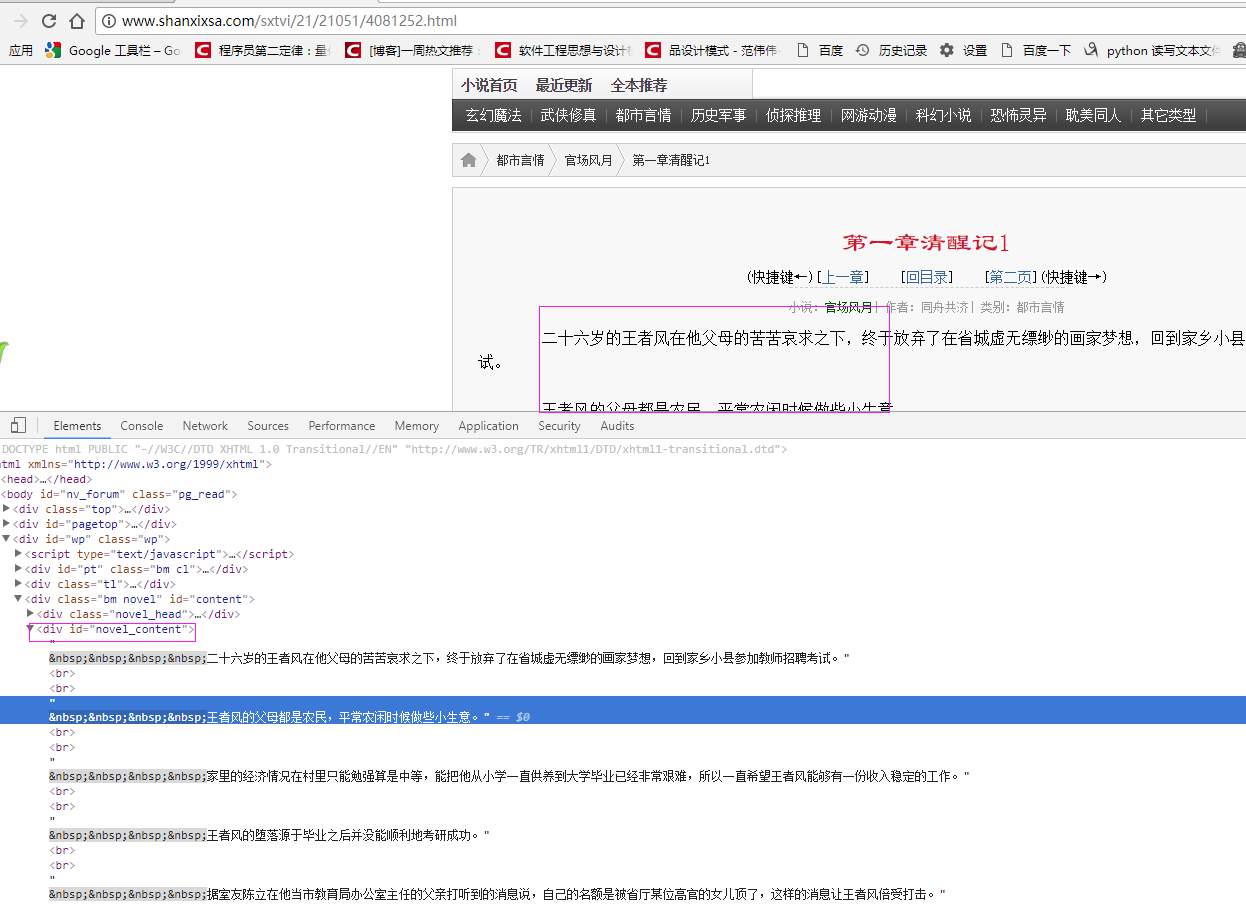

以下载官场风月小说为例:

具体代码:

# coding=utf-8

import os

import re

from selenium import webdriver

from selenium.common.exceptions import TimeoutException

import selenium.webdriver.support.ui as ui

import time

from datetime import datetime

from selenium.webdriver.common.action_chains import ActionChains # from threading import Thread

from pyquery import PyQuery as pq

import LogFile import urllib

class downfile(object):

def __init__(self,websearch_url,novelname):

self.driver = webdriver.PhantomJS()

# self.driver.set_page_load_timeout(10)

self.driver.maximize_window()

novel_name = unicode(novelname,'utf8')

logfile = os.path.join(os.getcwd(), 'novel\\' + novel_name + '.txt')

self.log = LogFile.LogFile(logfile)

self.websearch_url = websearch_url def scroll_foot(self):

'''

滚动条拉到底部

:return:

'''

js = ""

# 如何利用chrome驱动或phantomjs抓取

if self.driver.name == "chrome" or self.driver.name == 'phantomjs':

js = "var q=document.body.scrollTop=10000"

# 如何利用IE驱动抓取

elif self.driver.name == 'internet explorer':

js = "var q=document.documentElement.scrollTop=10000"

return self.driver.execute_script(js) def scrapy_date(self):

self.driver.get( self.websearch_url)

htext = self.driver.execute_script("return document.documentElement.outerHTML")

dochtml = pq(htext)

Elements = dochtml('div[class="novel_list"]').find('ul').find('li').find('a') for e in Elements.items():

url = 'http://www.shanxixsa.com/sxtvi/21/21051/'+e.attr('href')

txt = e.text().encode('utf8').strip()

print txt

self.log.WriteLog(txt)

self.driver.get(url)

shtext = self.driver.execute_script("return document.documentElement.outerHTML")

sdochtml = pq(shtext) sElements = sdochtml('div[ID="novel_content"]')

for se in sElements.items():

stxt = se.text().encode('utf8').strip()

self.log.WriteLog(stxt) obj = downfile('http://www.shanxixsa.com/sxtvi/21/21051/index.html','官场风月')

obj.scrapy_date() # -*- coding: utf-8 -*- import os

import codecs

import datetime

import time

import logging #封装logging日志

class LogFile:

# def __init__(self,fileName):

# self.fileName = os.path.join(os.getcwd(), fileName)

# def WriteLog(self,message):

# strMessage = '\r\n%s: %s' % (time.strftime('%Y-%m-%d_%H-%M-%S'), message)

# with open(self.fileName, 'a') as f:

# f.write(strMessage)

#构造函数 fileName:文件名

def __init__(self,fileName,level=logging.INFO):

fh = logging.FileHandler(fileName)

self.logger = logging.getLogger()

self.logger.setLevel(level)

# formatter = logging.Formatter('%(asctime)s : %(message)s','%Y-%m-%d %H:%M:%S')

formatter = logging.Formatter('%(message)s', '%Y-%m-%d %H:%M:%S')

fh.setFormatter(formatter)

self.logger.addHandler(fh) def WriteLog(self,message):

self.logger.info(message) def WriteErrorLog(self,message):

self.logger.setLevel(logging.ERROR)

self.logger.error(message)

python 下载小说的更多相关文章

- 批量下载小说网站上的小说(python爬虫)

随便说点什么 因为在学python,所有自然而然的就掉进了爬虫这个坑里,好吧,主要是因为我觉得爬虫比较酷,才入坑的. 想想看,你可以批量自动的采集互联网上海量的资料数据,是多么令人激动啊! 所以我就被 ...

- python爬虫之小说网站--下载小说(正则表达式)

python爬虫之小说网站--下载小说(正则表达式) 思路: 1.找到要下载的小说首页,打开网页源代码进行分析(例:https://www.kanunu8.com/files/old/2011/244 ...

- 使用Python开发小说下载器,不再为下载小说而发愁 #华为云·寻找黑马程序员#

需求分析 免费的小说网比较多,我看的比较多的是笔趣阁.这个网站基本收费的章节刚更新,它就能同步更新,简直不要太叼.既然要批量下载小说,肯定要分析这个网站了- 在搜索栏输入地址后,发送post请求获取数 ...

- 【Python 爬虫系列】从某网站下载小说《鬼吹灯》,正则解析html

import re import urllib.request import urllib.parse import urllib.error as err import time # 下载 seed ...

- 从网上下载小说_keywords:python、multiprocess

# -*- coding: utf-8 -*- __author__ = "YuDian" from multiprocessing import Pool # Pool用来创建进 ...

- Python下载网页的几种方法

get和post方式总结 get方式:以URL字串本身传递数据参数,在服务器端可以从'QUERY_STRING'这个变量中直接读取,效率较高,但缺乏安全性,也无法来处理复杂的数据(只能是字符串,比如在 ...

- 【python 下载】-各种版本都有!

python 是一种全功能的语言,2.7很稳定,成熟的版本,且有很多开源的模块. 小编个人觉得python有一个很大的优点,就是语法简练,甚至可以说简单.比起pascal或者 C什么的,简单的难以置信 ...

- Python下载Yahoo!Finance数据

Python下载Yahoo!Finance数据的三种工具: (1)yahoo-finance package. (2)ystockquote. (3)pandas.

- [转] 三种Python下载url并保存文件的代码

原文 三种Python下载url并保存文件的代码 利用程序自己编写下载文件挺有意思的. Python中最流行的方法就是通过Http利用urllib或者urllib2模块. 当然你也可以利用ftplib ...

随机推荐

- HDU1018 (斯特林公式)

Big Number Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 65536/32768 K (Java/Others)Total ...

- c语言中Triplet是什么意思?

此词条多出现于三元组抽象数据类型的定义. 例如: 数据结构编程试验中,构造三元组类型. 1.三元组抽象数据类型的定义 ADT Triplet { 数据对象:D={e1, e2, e3| e1, e2, ...

- MySQL阅读笔记

左连接:包含所有的左边表中的记录甚至是右边表中没有和它匹配的记录.右连接:包含所有的右边表中的记录甚至是左边表中没有和它匹配的记录. select ename,deptname from emp le ...

- PHP实现innodb的数据回滚

//实例化的数据库对象$model = new Model();//开启事务$model->startTrans();//默认结果$judge = true;//数据操作$sql1 =" ...

- 安装Team Services Agent Win7

现状:项目现时使用的是Team Services,使用Team Services可以控制其中的一台Build Server,从Github提取代码,并在Build Server进入编译打包处理(son ...

- HDU 1280 前m大的数【排序 / hash】

前m大的数 Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 65536/32768 K (Java/Others)Total Submi ...

- ( 转 ) mysql 实战 or、in与union all 的查询效率

OR.in和union all 查询效率到底哪个快. 网上很多的声音都是说union all 快于 or.in,因为or.in会导致全表扫描,他们给出了很多的实例. 但真的union all真的快于o ...

- ZOJ 3949 Edge to the Root(树形DP)

[题目链接] http://acm.zju.edu.cn/onlinejudge/showProblem.do?problemCode=3949 [题目大意] 给出一棵根为1的树,每条边边长为1,请你 ...

- [UOJ198]时空旅行

看懂题目就知道$y,z$是没用的,这题相当于是给一堆$(x_i,c_i)$和询问$x_q$,要求$(x_q-x_i)^2+c_i$的最大值 先把这个式子拆开:$-2x_ix_q+x_i^2+c_i+x ...

- 【匈牙利算法模板】BZOJ1191-超级英雄

#include<iostream> #include<cstdio> #include<cstring> #include<algorithm> us ...