超详细:Python(wordcloud+jieba)生成中文词云图

# coding: utf-8

import jieba

from scipy.misc import imread # 这是一个处理图像的函数

from wordcloud import WordCloud, STOPWORDS, ImageColorGenerator

import matplotlib.pyplot as plt back_color = imread('o_002.jpg') # 解析该图片 wc = WordCloud(background_color='white', # 背景颜色

max_words=1000, # 最大词数

mask=back_color, # 以该参数值作图绘制词云,这个参数不为空时,width和height会被忽略

max_font_size=100, # 显示字体的最大值

stopwords=STOPWORDS.add('苟利国'), # 使用内置的屏蔽词,再添加'苟利国'

font_path="C:/Windows/Fonts/STFANGSO.ttf", # 解决显示口字型乱码问题,可进入C:/Windows/Fonts/目录更换字体

random_state=42, # 为每个词返回一个PIL颜色

# width=1000, # 图片的宽

# height=860 #图片的长

)

# WordCloud各含义参数请点击 wordcloud参数 # 添加自己的词库分词,比如添加'金三胖'到jieba词库后,当你处理的文本中含有金三胖这个词,

# 就会直接将'金三胖'当作一个词,而不会得到'金三'或'三胖'这样的词

jieba.add_word('金三胖') # 打开词源的文本文件

text = open('cnword.txt').read() # 该函数的作用就是把屏蔽词去掉,使用这个函数就不用在WordCloud参数中添加stopwords参数了

# 把你需要屏蔽的词全部放入一个stopwords文本文件里即可

def stop_words(texts):

words_list = []

word_generator = jieba.cut(texts, cut_all=False) # 返回的是一个迭代器

with open('stopwords.txt') as f:

str_text = f.read()

unicode_text = unicode(str_text, 'utf-8') # 把str格式转成unicode格式

f.close() # stopwords文本中词的格式是'一词一行'

for word in word_generator:

if word.strip() not in unicode_text:

words_list.append(word)

return ' '.join(words_list) # 注意是空格 text = stop_words(text) wc.generate(text)

# 基于彩色图像生成相应彩色

image_colors = ImageColorGenerator(back_color)

# 显示图片

plt.imshow(wc)

# 关闭坐标轴

plt.axis('off')

# 绘制词云

plt.figure()

plt.imshow(wc.recolor(color_func=image_colors))

plt.axis('off')

# 保存图片

wc.to_file('19th.png')

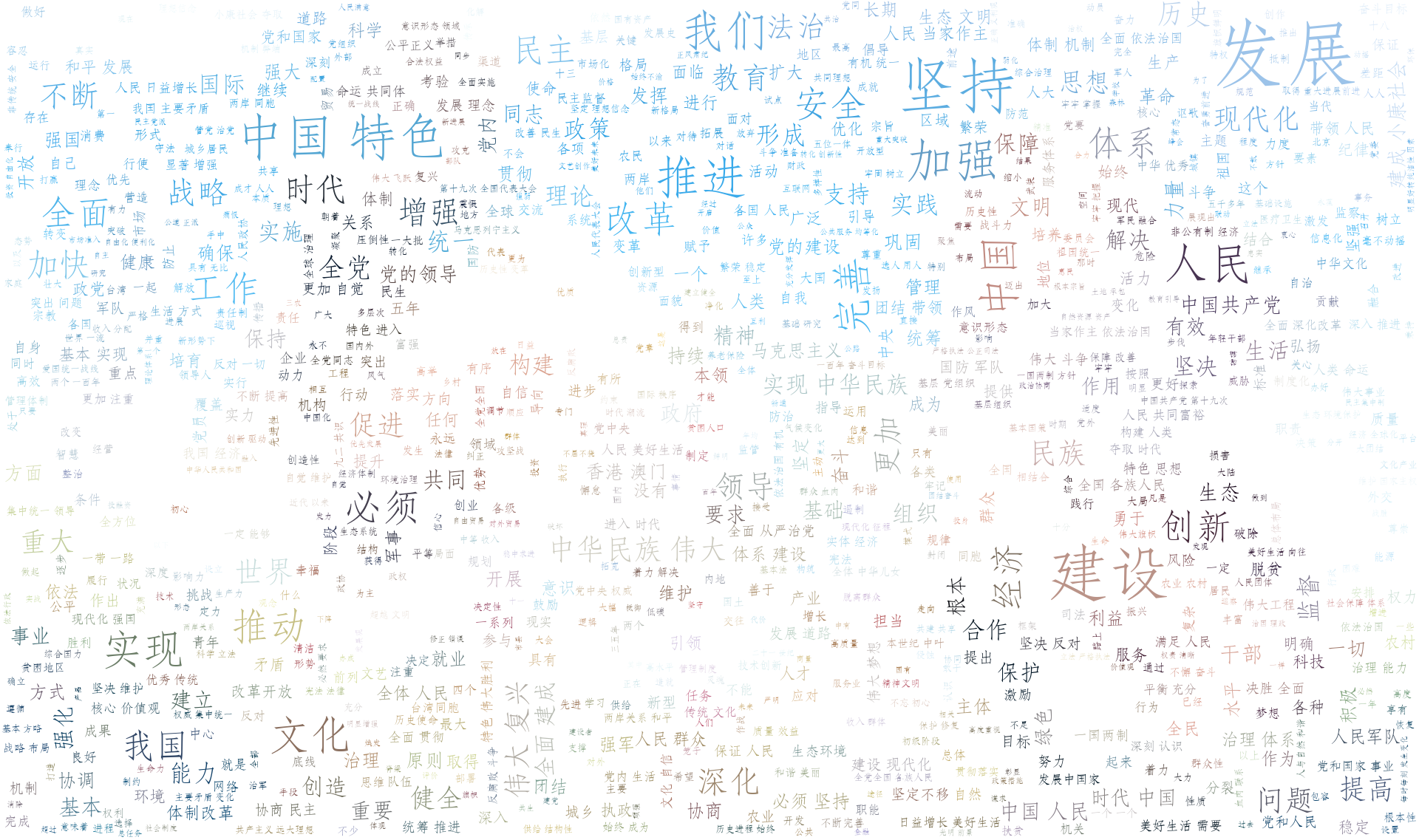

cnword.txt文本中的是十九大习大大讲话内容,太多了就不放上来了

stopwords.txt文本中有以下这几个词

社会主义

制度

国家

政治

背景颜色图

生成的词云图,与颜色图对应不是很明显,想明显的话可以使用一些色差大的图

超详细:Python(wordcloud+jieba)生成中文词云图的更多相关文章

- Python基于jieba的中文词云

今日学习了python的词云技术 from os import path from wordcloud import WordCloud import matplotlib.pyplot as plt ...

- Python 爬取生成中文词云以爬取知乎用户属性为例

代码如下: # -*- coding:utf-8 -*- import requests import pandas as pd import time import matplotlib.pyplo ...

- wordcloud + jieba 生成词云

利用jieba库和wordcloud生成中文词云. jieba库:中文分词第三方库 分词原理: 利用中文词库,确定汉字之间的关联概率,关联概率大的生成词组 三种分词模式: 1.精确模式:把文本精确的切 ...

- 【Python成长之路】词云图制作

[写在前面] 以前看到过一些大神制作的词云图 ,觉得效果很有意思.如果有朋友不了解词云图的效果,可以看下面的几张图(图片都是网上找到的): 网上找了找相关的软件,有些软件制作 还要付费.结果前几天在大 ...

- python绘制中文词云图

准备工作 主要用到Python的两个第三方库 jieba:中文分词工具 wordcloud:python下的词云生成工具 步骤 准备语料库,词云图需要的背景图片 使用jieba进行分词,去停用词,词频 ...

- [Python] 基于 jieba 的中文分词总结

目录 模块安装 开源代码 基本用法 启用Paddle 词性标注 调整词典 智能识别新词 搜索引擎模式分词 使用自定义词典 关键词提取 停用词过滤 模块安装 pip install jieba jieb ...

- python利用jieba进行中文分词去停用词

中文分词(Chinese Word Segmentation) 指的是将一个汉字序列切分成一个一个单独的词. 分词模块jieba,它是python比较好用的分词模块.待分词的字符串可以是 unicod ...

- [python] 使用Jieba工具中文分词及文本聚类概念

声明:由于担心CSDN博客丢失,在博客园简单对其进行备份,以后两个地方都会写文章的~感谢CSDN和博客园提供的平台. 前面讲述了很多关于Python爬取本体Ontology.消息盒Inf ...

- 超详细Gitlab Runner环境配置中文教程

配置GitlabRunner环境 GitLab Runner 是一个开源项目, 它用来运行你定制的任务(jobs)并把结果返回给 GitLab. GitLab Runner 配合GitLab CI(G ...

随机推荐

- HTML 和 JavaScript 编写简单的 404 界面

编写简单的 404 界面,也可以用来做 500 报错界面,还会飘东西,特别好,蛮漂亮的! <!DOCTYPE html> <html> <head> <met ...

- C++for的几种方式

#include <algorithm> #include <vector> ////////////////////////////////////////////// , ...

- 为 Android 8.0 添加开机启动脚本【转】

本文转载自:https://zhuanlan.zhihu.com/p/32868074 本人对于 SELinux for Android 理解不深,下文中的各文件及安全规则虽都是我所编写,但也是一边查 ...

- PHP开发者的路书

初学者 作为初学者,通常情况下,我们都会买一本PHP教材,或者在网上看免费教程,这当然是学习的好途径.因为,这些书籍和网上的免费教程,基本上都是由浅入深的渐进式教学方式,基础知识居多,高级知识占少量的 ...

- HDU 2157(矩阵快速幂)题解

How many ways?? Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 32768/32768 K (Java/Others) ...

- 【查看内存参数详解】Linux free -m 详细说明

free 命令相对于top 提供了更简洁的查看系统内存使用情况:$ free total used ...

- 使用PDFminer3k解析pdf为文字遇到:WARING:root:GBK-EUC-H

最近需要把PDF解析为文字,查了查python的模块,发现PDFminer3k能满足需求.我使用的是 windows平台下的python3.6,python2的则下载pdfminer. 首先下载:直接 ...

- (02) 任务(Jobs)和触发器(Triggers)

Quart 的 API Quartz API 中的关键接口和类如下: IScheduler-与调度器(scheduler)进行交互的主要 API: IJob-被组件继承和实现,由调度器来执行的接口: ...

- poj 2762 Going from u to v or from v to u? trajan+拓扑

Going from u to v or from v to u? Description In order to make their sons brave, Jiajia and Wind t ...

- Jenkins + Ant + Jmeter 对项目的接口进行CI持续集成的配置 外加发送邮件 sendEmail

Step1:安装Jenkins,从指定git上拉代码[安装步骤忽略] Step2:在项目安装的linux server上安装Ant 和Jmeter,我都安装在了自己的目录上,如下图 Step3:编写b ...