Apache Spark-1.0.1集群搭建

欢迎经验交流!本文Blog地址:http://www.cnblogs.com/fesh/p/3866791.html

Apache Spark a fast and general engine for large-scale data processing

Spark是一个高效的分布式计算系统,相比Hadoop,它在性能上比Hadoop要高100倍。Spark是发源于美国加州大学伯克利分校AMPLab的集群计算平台,它克服了MapReduce在迭代式计算和交互式计算方面的不足,通过引入RDD(Resilient Distributed Datasets)数据表示模型,能够很好地解决MapReduce不易解决的问题。相比于MapReduce,Spark能够充分利用内存资源提高计算效率。

一、基本环境

包含三个节点:

master(Ubuntu Desktop版本) 192.168.145.128

slave1(Ubuntu Server版本) 192.168.145.129

slave2(Ubuntu Server版本) 192.168.145.130

操作系统:Ubuntu14.04 x64

JDK版本:jdk1.8.0_11

Hadoop版本:Hadoop-2.2.0

Scala版本:2.10.4(官网要求2.10.X)

Spark版本:1.0.1

取得《Spark-1.0.1 的make-distribution.sh编译、SBT编译、Maven编译 三种编译方法》中编译好的 spark-1.0.1-bin-2.2.0.tgz

Hadoop-2.2.0集群的安装见http://www.cnblogs.com/fesh/p/3766656.html

Scala的安装见 http://www.cnblogs.com/fesh/p/3805611.html

(注:Scala在master节点上安装好后,直接用scp命令分发到slave1、slave2,并在slave1和slave2配置环境变量即可)

在master节点和slave1节点分别配置/etc/hosts和/etc/hostname:(下面这些应该在安装Hadoop集群时已经配置好了)

/etc/hosts

192.168.145.128 master

192.168.145.129 slave1

192.168.145.130 slave2

/etc/hostname (master)

master

/etc/hostname (slave1)

slave1

/etc/hostname (slave2)

slave2

二、Spark配置

1、master节点文件配置

在master节点:

解压spark-1.0.1-bin-2.2.0.tgz

tar -zxvf spark-1.0.-bin-2.2..tgz

在/etc/profile中配置环境变量

#Set SPARK_HOME

export SPARK_HOME=/home/fesh/spark-1.0.-bin-2.2.

export PATH=$PATH:$SPARK_HOME/bin

在spark-1.0.1-bin-2.2.0/conf下配置文件spark-env.sh和slaves:

cp spark-env.sh.template spark-env.sh

sudo gedit spark-env.sh

在文件spark-env.sh末尾添加:

export HADOOP_CONF_DIR=/home/fesh/hadoop-2.2./etc/hadoop

export JAVA_HOME=/usr/lib/jvm/jdk1..0_11

export SCALA_HOME=/home/fesh/scala-2.10.

export SPARK_MASTER_IP=master

export SPARK_WORKER_MEMORY=512M

export SPARK_EXECUTOR_MEMORY=512M export SPARK_EXECUTOR_INSTANCES= (下面这几项可以不配置,采用默认就可以了)

export SPARK_EXECUTOR_CORES=

export SPARK_DRIVER_MEMORY=512M

export SPARK_YARN_APP_NAME="spark 1.0.1"

在文件slaves中去掉localhohst并设置

master

slave1

slave2

2、分发文件

分发spark-1.0.1-bin-2.2.0文件到slave1节点

scp -r spark-1.0.-bin-2.2. slave1:~/

分发spark-1.0.1-bin-2.2.0文件到slave2节点

scp -r spark-1.0.1-bin-2.2.0 slave2:~/

三、启动Spark集群

首先启动Hadoop-2.2.0集群,然后在spark-1.0.1-bin-2.2.0根目录下启动Spark集群

sbin/start-all.sh

对于slave1节点

对于slave2节点

四、查看信息

1、进入Spark集群的Web页面

在master节点上,浏览器访问: http://master:8080

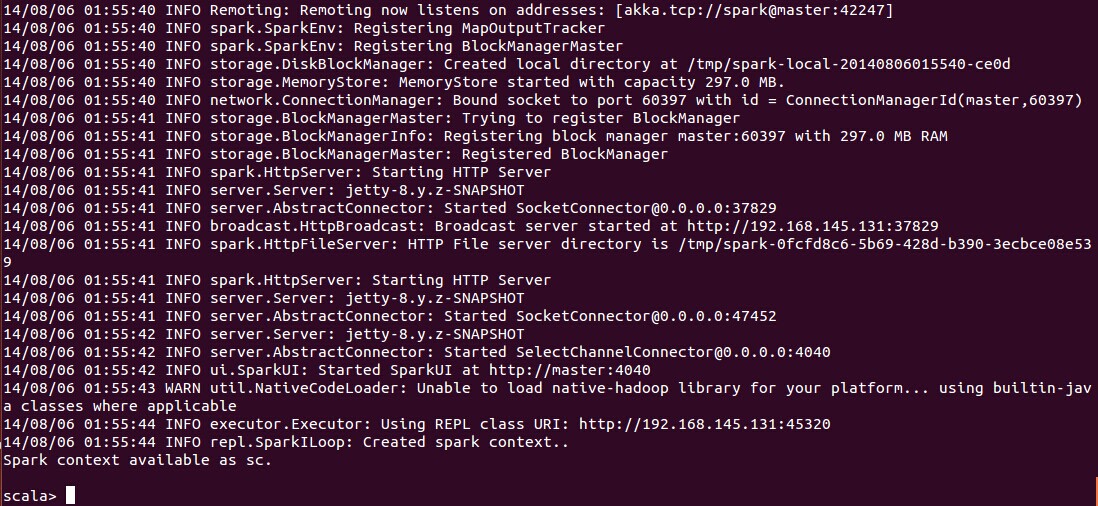

2、控制台查看

进入{SPARK_HOME}/bin目录,使用 spark-shell 控制台

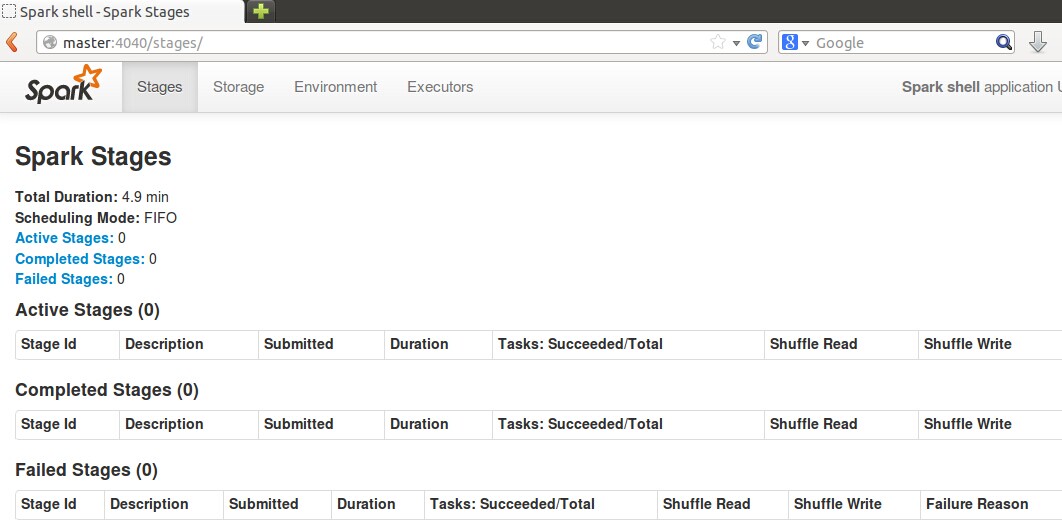

3、Web查看SparkUI

在master节点,浏览器进入 http://master:4040

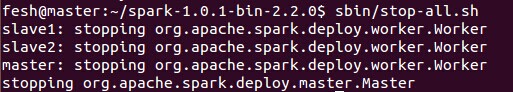

五、停止Spark集群

sbin/stop-all.sh

参考:

1、http://spark.apache.org/docs/latest/running-on-yarn.html

2、http://spark.apache.org/docs/latest/configuration.html

Apache Spark-1.0.1集群搭建的更多相关文章

- spark 2.0.2 集群搭建

由于之前已经搭建过hadoop相关环境,现在搭建spark的预备工作只有scala环境了 一,配置scala环境 1.解压tar包后,编辑/etc/profile 2.source /etc/prof ...

- 【原创 Hadoop&Spark 动手实践 5】Spark 基础入门,集群搭建以及Spark Shell

Spark 基础入门,集群搭建以及Spark Shell 主要借助Spark基础的PPT,再加上实际的动手操作来加强概念的理解和实践. Spark 安装部署 理论已经了解的差不多了,接下来是实际动手实 ...

- Redis 5.0.5集群搭建

Redis 5.0.5集群搭建 一.概述 Redis3.0版本之后支持Cluster. 1.1.redis cluster的现状 目前redis支持的cluster特性: 1):节点自动发现 2):s ...

- 大数据学习系列之七 ----- Hadoop+Spark+Zookeeper+HBase+Hive集群搭建 图文详解

引言 在之前的大数据学习系列中,搭建了Hadoop+Spark+HBase+Hive 环境以及一些测试.其实要说的话,我开始学习大数据的时候,搭建的就是集群,并不是单机模式和伪分布式.至于为什么先写单 ...

- CDH 6.0.1 集群搭建 「Before install」

从这一篇文章开始会有三篇文章依次介绍集群搭建 「Before install」 「Process」 「After install」 继上一篇使用 docker 部署单机 CDH 的文章,当我们使用 d ...

- HADOOP+SPARK+ZOOKEEPER+HBASE+HIVE集群搭建(转)

原文地址:https://www.cnblogs.com/hanzhi/articles/8794984.html 目录 引言 目录 一环境选择 1集群机器安装图 2配置说明 3下载地址 二集群的相关 ...

- Hadoop2.0 HA集群搭建步骤

上一次搭建的Hadoop是一个伪分布式的,这次我们做一个用于个人的Hadoop集群(希望对大家搭建集群有所帮助): 集群节点分配: Park01 Zookeeper NameNode (active) ...

- CDH 6.0.1 集群搭建 「After install」

集群搭建完成之后其实还有很多配置工作要做,这里我列举一些我去做的一些. 首先是去把 zk 的角色重新分配一下,不知道是不是我在配置的时候遗漏了什么在启动之后就有报警说目前只能检查到一个节点.去将 zk ...

- ubuntu18.04 flink-1.9.0 Standalone集群搭建

集群规划 Master JobManager Standby JobManager Task Manager Zookeeper flink01 √ √ flink02 √ √ flink03 √ √ ...

- java_redis3.0.3集群搭建

redis3.0版本之后支持Cluster,具体介绍redis集群我就不多说,了解请看redis中文简介. 首先,直接访问redis.io官网,下载redis.tar.gz,现在版本3.0.3,我下面 ...

随机推荐

- ural 1057Amount of Degrees ——数位DP

link:http://acm.timus.ru/problem.aspx?space=1&num=1057 论文: 浅谈数位类统计问题 刘聪 #include <iostream&g ...

- linux下oracle 10g的sqlplus无法使用

问题如标题所示. 解决办法, 1,root用户登录,建立软连接 cd / cd /usr/bin ln -s /home/oracle/product/10.2.0/db_1/bin/sqlplus ...

- noip2013 火柴排序

涵涵有两盒火柴,每盒装有 n 根火柴,每根火柴都有一个高度.现在将每盒中的火柴各自排成一列,同一列火柴的高度互不相同,两列火柴之间的距离定义为: ,其中 ai 表示第一列火柴中第 i 个火柴的高度,b ...

- hmtl初学

hmtl+css实现小车轮子转动! <!DOCTYPE html> <html> <head lang="en"> <meta ...

- Fortran学习心得

编译调试: 服务器上所用的编译器可以编译.F90的文件,同时,经过测试已经知道有两款编译器:gfortran和ifort. 另外,查看编译器的bash命令是:gfortran -v. 编程算法思想与C ...

- 论文笔记之:Deep Generative Image Models using a Laplacian Pyramid of Adversarial Networks

Deep Generative Image Models using a Laplacian Pyramid of Adversarial Networks NIPS 2015 摘要:本文提出一种 ...

- C#里Attribute属性

系统内置属性 系统内置的Attribute属性Obsolete,被个这属性标记的方法在别的地方被调用的时候会有警告提示; 这个属性还可以指定第二个布尔参数,设置编译时是否报错; 例: [Obsolet ...

- 鼠标滚动事件兼容性 wheel、onwheel

wheelEvent = "onwheel" in document.createElement("div") ? "wheel" : // ...

- [zz] demand require request用法辨析

http://zhidao.baidu.com/link?url=9Q50HiOF1fWav1nSnREbc_H1jTuAHxAjeVLbZoB5bGO3ZehPxLhQdob4oGO3slMRl0W ...

- LVS-DR工作原理图文详解

为了阐述方便,我根据官方原理图另外制作了一幅图,如下图所示:VS/DR的体系结构: 我将结合这幅原理图及具体的实例来讲解一下LVS-DR的原理,包括数据包.数据帧的走向和转换过程. 官方的原理说明:D ...