Spark RDD概念学习系列之RDD的创建(六)

RDD的创建

两种方式来创建RDD:

1)由一个已经存在的Scala集合创建

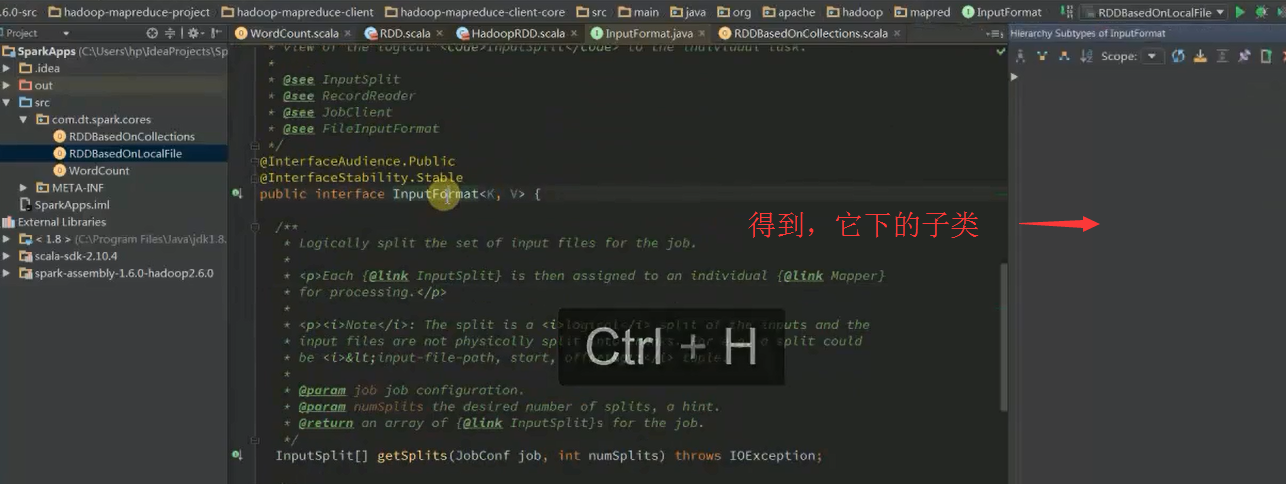

2)由外部存储系统的数据集创建,包括本地文件系统,还有所有Hadoop支持的数据集,比如HDFS、Cassandra、HBase、Amazon S3等。

RDD只能基于在稳定物理存储中的数据集和其他已有的RDD上执行确定性操作来创建。这些确定性操作称为转换,如map、filter、groupBy、join。

第1个RDD:代表了spark应用程序输入数据的来源,通过Transformation来对RDD进行各种算子的转换和实现算法。

初始RDD(或第1个RDD)创建的几个方式:(有300多种)

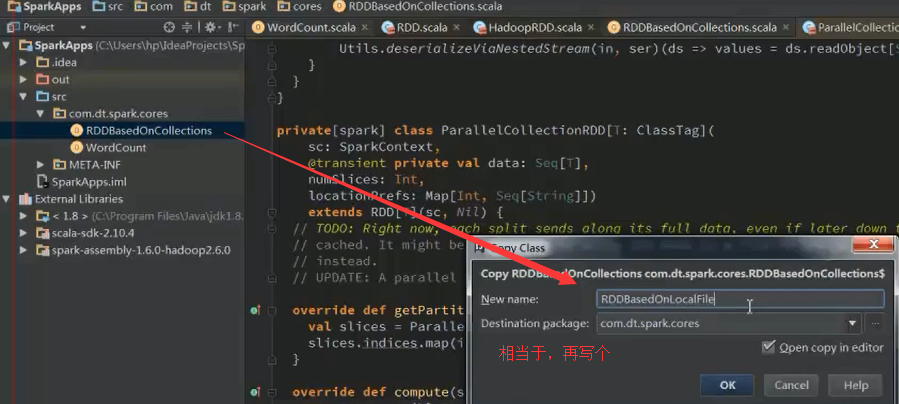

1、 使用程序中的集合创建RDD; 意义是:测试

2、 使用本地文件系统创建RDD; 意义是:测试大量数据的文件

3、 使用HDFS创建RDD; 意义是:生产环境里最常用

4、 基于DB创建RDD;

5、 基于NoSQL,例如HBase

6、 基于S3创建RDD;

7、 基于数据流创建RDD;

以上是典型的7种,我们这里重点讲解前3种方式。

SparkContext.scala里, SparkContext.createTaskScheduler,进入该方法

我们进一步,来学习

原来如此,所以是32。

以上是并行度,默认为1。

会利用最大,即32 = 8 X 4台worker

现在,我们来采取并行度为10,来玩玩。

问:实际上spark的并行度到底应该设置为多少呢?

答:最佳是,2-4 partitions for each CPU core。

如我们这里的CPU core是32个。每个worker给的是8个。共4台机器。

32 X 2 =64 32 X 4 = 128 即64~128之间。

说明的是,跟数据规模没关系,只跟每个task在计算partitions时的CPU使用时间和内存使用情况有关。

oom是内存溢出。

RDDBaseedOnLocalFile.scala

假如,计算每行的长度总和

好的,关于此处的源码解读,自行去深究。不多赘述。

以上是在local模式下,下面开始

集群模式

Spark RDD概念学习系列之RDD的创建(六)的更多相关文章

- Spark RDD概念学习系列之RDD的转换(十)

RDD的转换 Spark会根据用户提交的计算逻辑中的RDD的转换和动作来生成RDD之间的依赖关系,同时这个计算链也就生成了逻辑上的DAG.接下来以“Word Count”为例,详细描述这个DAG生成的 ...

- Spark RDD概念学习系列之RDD的checkpoint(九)

RDD的检查点 首先,要清楚.为什么spark要引入检查点机制?引入RDD的检查点? 答:如果缓存丢失了,则需要重新计算.如果计算特别复杂或者计算耗时特别多,那么缓存丢失对于整个Job的影响是不容 ...

- Spark RDD概念学习系列之RDD的操作(七)

RDD的操作 RDD支持两种操作:转换和动作. 1)转换,即从现有的数据集创建一个新的数据集. 2)动作,即在数据集上进行计算后,返回一个值给Driver程序. 例如,map就是一种转换,它将数据集每 ...

- Spark RDD概念学习系列之RDD是什么?(四)

RDD是什么? 通俗地理解,RDD可以被抽象地理解为一个大的数组(Array),但是这个数组是分布在集群上的.详细见 Spark的数据存储 Spark的核心数据模型是RDD,但RDD是个抽象类 ...

- Spark RDD概念学习系列之RDD的缺点(二)

RDD的缺点? RDD是Spark最基本也是最根本的数据抽象,它具备像MapReduce等数据流模型的容错性,并且允许开发人员在大型集群上执行基于内存的计算. 为了有效地实现容错,(详细见ht ...

- Spark RDD概念学习系列之RDD的缓存(八)

RDD的缓存 RDD的缓存和RDD的checkpoint的区别 缓存是在计算结束后,直接将计算结果通过用户定义的存储级别(存储级别定义了缓存存储的介质,现在支持内存.本地文件系统和Tachyon) ...

- Spark RDD概念学习系列之RDD的依赖关系(宽依赖和窄依赖)(三)

RDD的依赖关系? RDD和它依赖的parent RDD(s)的关系有两种不同的类型,即窄依赖(narrow dependency)和宽依赖(wide dependency). 1)窄依赖指的是每 ...

- Spark RDD概念学习系列之rdd的依赖关系彻底解密(十九)

本期内容: 1.RDD依赖关系的本质内幕 2.依赖关系下的数据流视图 3.经典的RDD依赖关系解析 4.RDD依赖关系源码内幕 1.RDD依赖关系的本质内幕 由于RDD是粗粒度的操作数据集,每个Tra ...

- Spark RDD概念学习系列之RDD的5大特点(五)

RDD的5大特点 1)有一个分片列表,就是能被切分,和Hadoop一样,能够切分的数据才能并行计算. 一组分片(partition),即数据集的基本组成单位,对于RDD来说,每个分片都会被一个计 ...

随机推荐

- JSON 之 SuperObject(9): TSuperType

unit Unit1; interface uses Windows, Messages, SysUtils, Variants, Classes, Graphics, Controls, For ...

- How to install ruby on mac/ change ruby source in china

his one is tailor made for the Basix users among you. If you've been itching to try out Ruby and/or ...

- java.lang.ClassNotFoundException

在项目的properties中的Java Build Path里将Order and Export里的类库勾选上.

- Android之项目推荐使用的第三方库

1. 使用上拉更多,下拉刷新:https://github.com/JosephPeng/XListView-Android 这个是github上面更为火爆的:https://github.com/c ...

- LA 3027 Corporative Network

这题感觉和 POJ 1988 Cube Stacking 很像,在路径压缩的同时递归出来的时候跟新distant数组 我发现我一直WA的原因是,命令结束是以字母o结束的,而不是数字0!! //#def ...

- UVa 136 Ugly Numbers【优先队列】

题意:给出丑数的定义,不能被除2,3,5以外的素数整除的的数称为丑数. 和杭电的那一题丑数一样--这里学的紫书上的用优先队列来做. 用已知的丑数去生成新的丑数,利用优先队列的能够每次取出当前最小的丑数 ...

- erl_0011 erlang 定时器相关

转自:http://blog.chinaunix.net/xmlrpc.php?r=blog/article&uid=20764167&id=4470124 3.1 The time ...

- nodejs开发阶段利器supervisor

在开始学习nodejs时,往往一般写代码,一边看效果.先停止node,再重新运行.非常耗时. 这时supervisor派上了用场. 安装 推荐使用npm,本人一直使用局部安装,这样可以将全部文件安装在 ...

- openssl rsa 加解密

<h4>1.openssl进行rsa加密解密</h4>首先介绍下命令台下openssl工具的简单使用:生成一个密钥:<pre lang="c" esc ...

- 最新 Arduino 驱动 12接口/户外 LED显示屏/LED点阵屏/LED单元板

起因 现有的驱动LED显示屏的资料,比较好的只有这个.但是它驱动的是08接口的室内显示屏,而我要驱动的是12接口的户外显示屏.两种屏幕的区别在于户外屏幕点阵比较稀疏,而且二者的扫描方式,驱动方式都不太 ...