CausalVAE: Disentangled Representation Learning via Neural Structural Causal Models

概

隐变量的因果表示.

主要内容

我们通常希望隐变量\(z\)能够表示一些特别的特征, 通过改变\(z\)使得生成的图形某些属性发生相应的变换, 但是这种设定的方式并不具备因果的关系, 比方说

这个摆锤, 其隐变量\(z\)是光照, 摆锤的角度, 影子的长短.

我们可以改变摆锤的角度, 一般的生成模型摆锤的角度变了, 但是光照和影子长短没有发生变化, 实际上由于摆锤角度的变化, 对于的隐变量:影子的长短也应该发生相应的变化以满足物理的规律. 如何把这些因果关系融入到普通的VAE中是本文的独到之处.

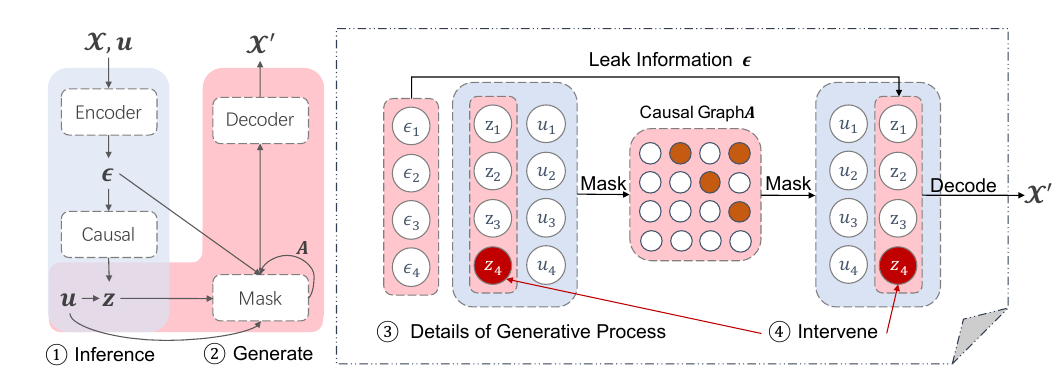

模型

Encoder 部分:

\]

\(\epsilon\)可以看成是一个临时的隐变量;

\]

Decoder部分:

\]

这一部分是重构\(z\), 正是这一步的存在使得我们能够干预\(z_i\)使得其它的\(z_j\)也发生相应的改变.

\]

联合分布为:

p_{\theta}(x|z,\epsilon,u) = p_{\theta}(x|z) = p_{\xi}(x-f(z)), \\

p_{\theta}(\epsilon,z|u) = p_{\epsilon}(\epsilon) p_{\theta}(z|u), \quad p_{\epsilon}(\epsilon) = \mathcal{N}(0, I), \\

p_{\theta}(z|u) = \prod_{i=1}^n p_{\theta}(z_i|u_i), \quad p_{\theta}(z_i|u_i) = \mathcal{N}(\lambda_1(u_i), \lambda_2^2(\mu_i)).

\]

估计的后验分布为:

q(z|\epsilon) = \delta (z=(I-A)^{-1}\epsilon).

\]

注: \(z, u, \epsilon \in \mathbb{R}^n, x \in \mathbb{R}^d.\)

ELBO

由此可以推出ELBO:

\]

由于\(p(z|\epsilon) = \delta(z=(I-A)^{-1}\epsilon)\), 所以上式可以进一步化为:

\]

关于\(A\)

正如在这儿所论述的, \(A\)需要对应一个有向无环图, 本文采取的策略是:

\]

这里\(c\)是任意正数.

同时为了满足\(z\)重构, 需要以下条件满足:

\]

注: 这里\(z_i\)是重构前的.

特别的, 为了更好地用额外信息(不是很认同, 感觉得看实际情况吧):

\]

所以最终的损失为:

\]

注: 本文不像别的方法一样用augmented Lagrange 求解.

注: 作者设计的实验实在是非常有趣.

CausalVAE: Disentangled Representation Learning via Neural Structural Causal Models的更多相关文章

- 论文解读(S^3-CL)《Structural and Semantic Contrastive Learning for Self-supervised Node Representation Learning》

论文信息 论文标题:Structural and Semantic Contrastive Learning for Self-supervised Node Representation Learn ...

- Self-Supervised Representation Learning

Self-Supervised Representation Learning 2019-11-11 21:12:14 This blog is copied from: https://lilia ...

- (转)Predictive learning vs. representation learning 预测学习 与 表示学习

Predictive learning vs. representation learning 预测学习 与 表示学习 When you take a machine learning class, ...

- 翻译 Improved Word Representation Learning with Sememes

翻译 Improved Word Representation Learning with Sememes 题目 Improved Word Representation Learning with ...

- 论文阅读笔记 Improved Word Representation Learning with Sememes

论文阅读笔记 Improved Word Representation Learning with Sememes 一句话概括本文工作 使用词汇资源--知网--来提升词嵌入的表征能力,并提出了三种基于 ...

- 【论文笔记】Learning Convolutional Neural Networks for Graphs

Learning Convolutional Neural Networks for Graphs 2018-01-17 21:41:57 [Introduction] 这篇 paper 是发表在 ...

- (zhuan) Notes on Representation Learning

this blog from: https://opendatascience.com/blog/notes-on-representation-learning-1/ Notes on Repr ...

- 网络表示学习Network Representation Learning/Embedding

网络表示学习相关资料 网络表示学习(network representation learning,NRL),也被称为图嵌入方法(graph embedding method,GEM)是这两年兴起的工 ...

- Machine Learning:Neural Network---Representation

Machine Learning:Neural Network---Representation 1.Non-Linear Classification 假设还採取简单的线性分类手段.那么会面临着过拟 ...

随机推荐

- 日常Java 2021/9/28

字符串反转 package m; public class m { public static void main(String[] args) { //定义一个字符串 String str = &q ...

- Identity Server 4 从入门到落地(七)—— 控制台客户端

前面的部分: Identity Server 4 从入门到落地(一)-- 从IdentityServer4.Admin开始 Identity Server 4 从入门到落地(二)-- 理解授权码模式 ...

- 在JTable单元格上 加入组件,并赋予可编辑能力 [转]

表格(单元格放置组件) 对于JTable单元格的渲染主要是通过两个接口来实现的,一个是TableCellRenderer另一个是TableCellEditor,JTable默认是用的是DefaultC ...

- k8s配置中心-configmap,Secret密码

目录 k8s配置中心-configmap,Secret 创建ConfigMap 使用ConfigMap subPath参数 Secret 官方文档 编写secret清单 使用secret 在 Pod ...

- 案例 stm32单片机,adc的双通道+dma 内部温度

可以这样理解 先配置adc :有几个通道就配置几个通道. 然后配置dma,dma是针对adc的,而不是针对通道的. 一开始我以为一个adc通道对应一个dma通道.(这里是错的,其实是我想复杂了) 一个 ...

- C++ 之杂记

今天做了一个题,代码不难,但是编译的时候就恼火,老是报错,也不告诉我错哪了.... 之前的代码是这样的,在main函数中调用这个类的构造函数,就一直报错,但是不知道原因,后来加上了const 就好了. ...

- 利用extern共享全局变量

方法: 在xxx.h中利用extern关键字声明全局变量 extern int a; 在xxx.cpp中#include<xxx.h> 再定义 int a; 赋不赋初值无所谓,之后该全局变 ...

- 虚机扩大容量与vm减少所占容量

Linux的虚拟机碎片整理 sudo dd if=/dev/zero of=/free bs=1M sudo rm -f /free 镜像压缩 移动镜像 VBoxManage internalcomm ...

- vue 第三方图标库

"font-awesome": "^4.7.0", "dependencies": { "axios": "^ ...

- Servlet(3):Cookie和Session

一. Cookie Cookie是客户端技术,程序把每个用户的数据以cookie的形式写给用户各自的浏览器.当用户使用浏览器再去访问服务器中的web资源时,就会带着各自的数据去.这样,web资源处理的 ...