Flink(八)【Flink的窗口机制】

Flink的窗口机制

1.窗口概述

在流处理应用中,数据是连续不断的,因此我们不可能等到所有数据都到了才开始处理。当然我们可以每来一个消息就处理一次,但是有时我们需要做一些聚合类的处理,例如:在过去的1分钟内有多少用户点击了我们的网页。在这种情况下,我们必须定义一个窗口,用来收集最近一分钟内的数据,并对这个窗口内的数据进行计算。

流式计算是一种被设计用于处理无限数据集的数据处理引擎,而无限数据集是指一种不断增长的本质上无限的数据集,而Window窗口是一种切割无限数据为有限块进行处理的手段。

在Flink中, 窗口(window)是处理无界流的核心. 窗口把流切割成有限大小的多个"存储桶"(bucket), 我们在这些桶上进行计算。

2.窗口分类

窗口分为2类:

基于时间的窗口(时间驱动)

基于元素个数的(数据驱动)

基于时间的窗口

时间窗口包含一个开始时间戳(包括)和结束时间戳(不包括), 这两个时间戳一起限制了窗口的尺寸.

在代码中, Flink使用TimeWindow这个类来表示基于时间的窗口. 这个类提供了key查询开始时间戳和结束时间戳的方法, 还提供了针对给定的窗口获取它允许的最大时间差的方法(maxTimestamp())

时间窗口又分4种:

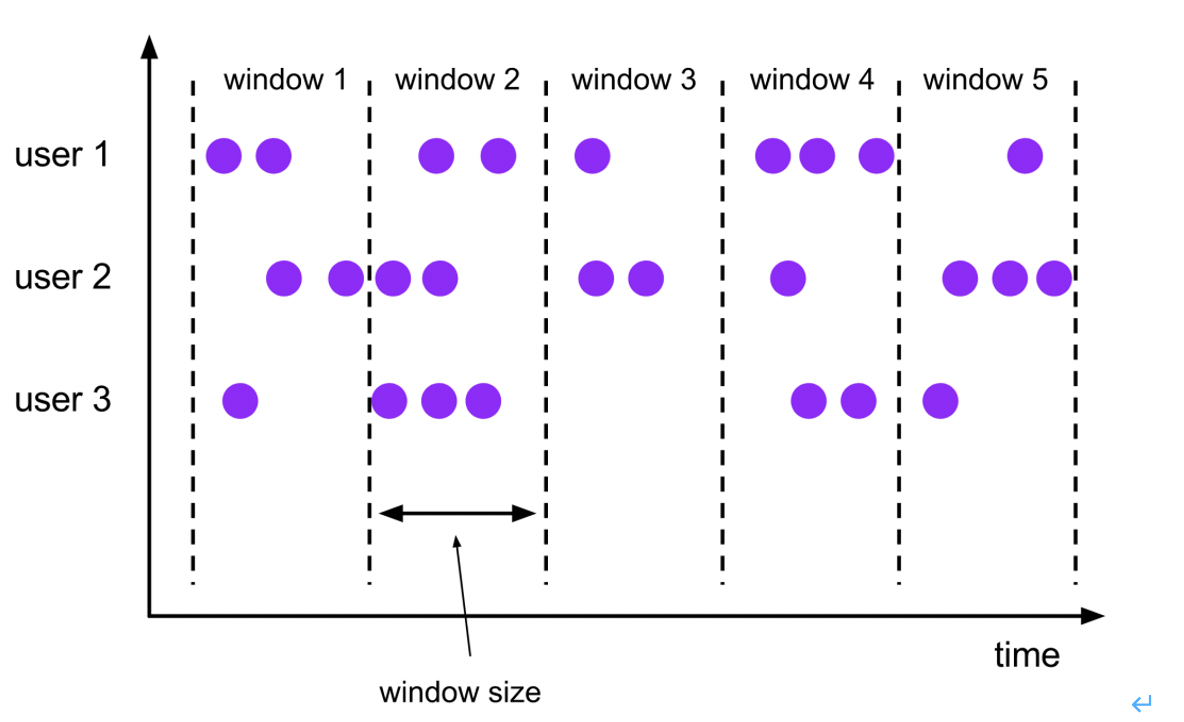

滚动窗口(Tumbling Windows)

滚动窗口有固定的大小, 窗口与窗口之间不会重叠也没有缝隙.比如,如果指定一个长度为5分钟的滚动窗口, 当前窗口开始计算, 每5分钟启动一个新的窗口.

滚动窗口能将数据流切分成不重叠的窗口,每一个事件只能属于一个窗口。

java代码

package com.flink.day04_window;

import org.apache.flink.api.common.functions.FlatMapFunction;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.windowing.assigners.TumblingProcessingTimeWindows;

import org.apache.flink.streaming.api.windowing.time.Time;

import org.apache.flink.util.Collector;

import java.util.Arrays;

/**

* @description: TODO 滚动时间窗口

* 1. 时间间隔可以通过: Time.milliseconds(x), Time.seconds(x), Time.minutes(x),等等来指定.

* 2. 我们传递给window函数的对象叫窗口分配器.

* @author: HaoWu

* @create: 2021年05月14日

*/

public class Flink01_Window_Tumbling {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.setParallelism(2);

env.socketTextStream("localhost",9999)

.flatMap(new FlatMapFunction<String, Tuple2<String,Integer>>() {

@Override

public void flatMap(String value, Collector<Tuple2<String, Integer>> out) throws Exception {

// String[] datas = value.split(",");

// for (int i = 0; i < datas.length-1; i++) {

// out.collect(Tuple2.of(datas[i],1));

// }

Arrays.stream(value.split(",")).forEach(word -> out.collect(Tuple2.of(word, 1)));

}

})

.keyBy(t->t.f0)

.window(TumblingProcessingTimeWindows.of(Time.seconds(5)))

.sum(1)

.print();

env.execute();

}

}

说明:

时间间隔可以通过: Time.milliseconds(x), Time.seconds(x), Time.minutes(x),等等来指定.

我们传递给window函数的对象叫窗口分配器.

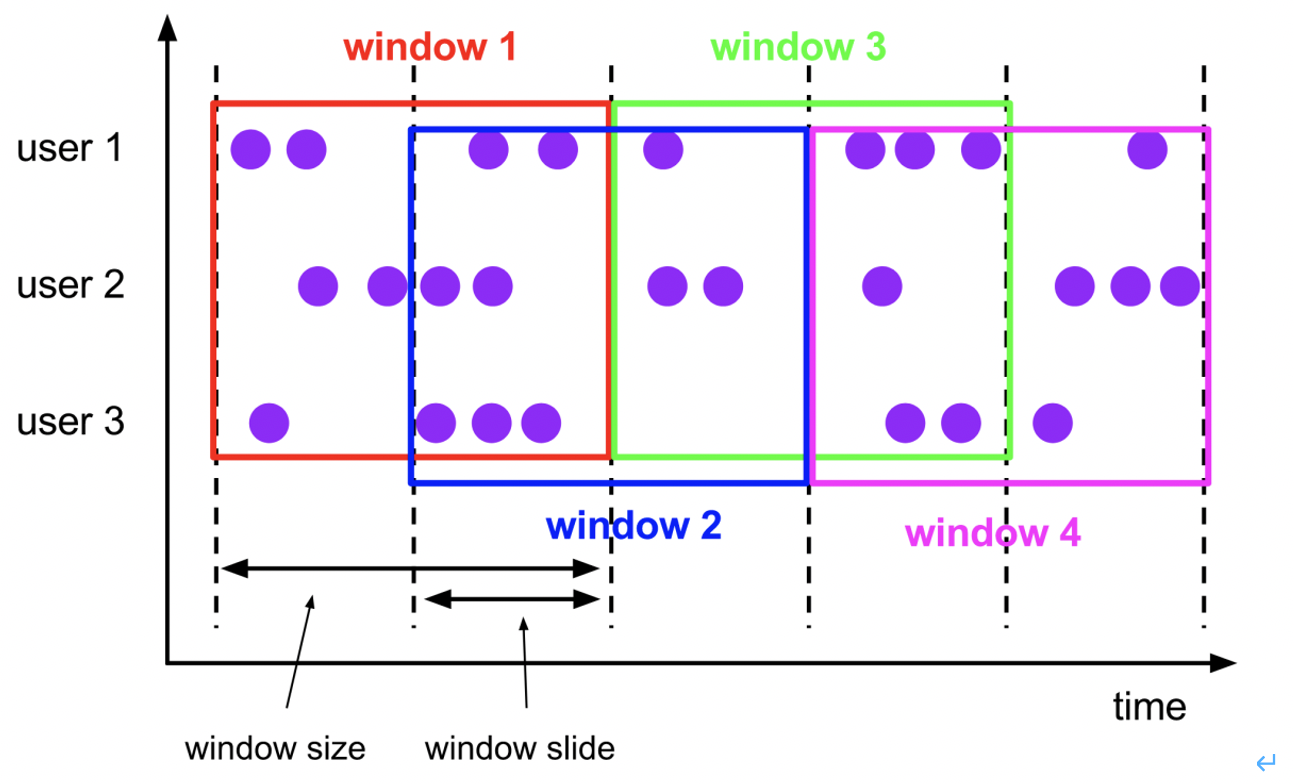

滑动窗口(Sliding Windows)

与滚动窗口一样, 滑动窗口也是有固定的长度. 另外一个参数我们叫滑动步长, 用来控制滑动窗口启动的频率.

所以, 如果滑动步长小于窗口长度, 滑动窗口会重叠. 这种情况下, 一个元素可能会被分配到多个窗口中

例如, 滑动窗口长度10分钟, 滑动步长5分钟, 则, 每5分钟会得到一个包含最近10分钟的数据.

java代码

package com.flink.day04_window;

import org.apache.flink.api.common.functions.FlatMapFunction;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.windowing.ProcessWindowFunction;

import org.apache.flink.streaming.api.windowing.assigners.SlidingProcessingTimeWindows;

import org.apache.flink.streaming.api.windowing.time.Time;

import org.apache.flink.streaming.api.windowing.windows.TimeWindow;

import org.apache.flink.util.Collector;

import java.util.Arrays;

/**

* @description: TODO 滑动窗口

* @author: HaoWu

* @create: 2021年05月17日

*/

public class Flink02_Window_Sliding {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.setParallelism(2);

env.socketTextStream("localhost",9999)

.flatMap(new FlatMapFunction<String, Tuple2<String,Integer>>() {

@Override

public void flatMap(String value, Collector<Tuple2<String, Integer>> out) throws Exception {

String[] datas = value.split(",");

Arrays.stream(datas).forEach(ele->{out.collect(Tuple2.of(ele,1));});

}

})

.keyBy(t->t.f0)

.window(SlidingProcessingTimeWindows.of(Time.seconds(5),Time.seconds(1)))

.process(new ProcessWindowFunction<Tuple2<String, Integer>, String, String, TimeWindow>() {

Integer count=0;

@Override

public void process(String s, Context context, Iterable<Tuple2<String, Integer>> elements, Collector<String> out) throws Exception {

for (Tuple2<String, Integer> element : elements) {

count++;

}

long start = context.window().getStart();

long end = context.window().getEnd();

out.collect("当前key:"+s+",窗口:["+start+","+end+"),count:"+count);

}

}).print();

env.execute();

}

}

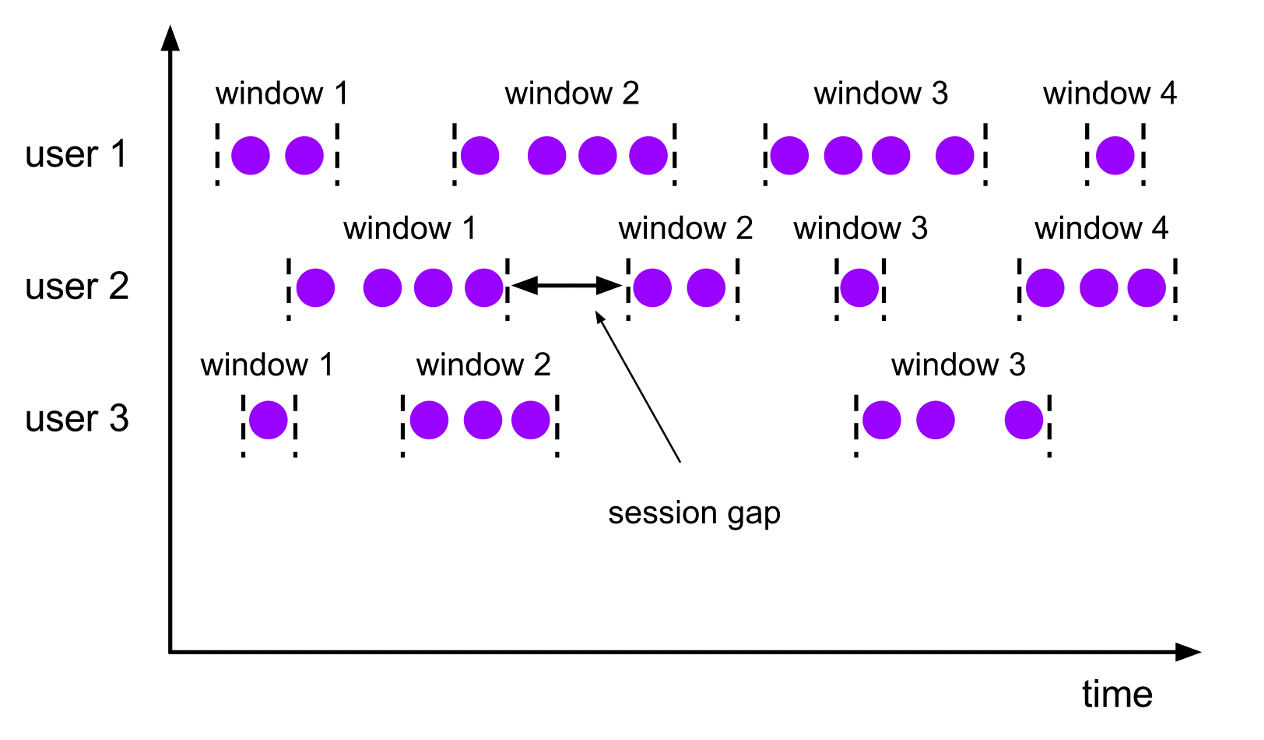

会话窗口(Session Windows)

会话窗口分配器会根据活动的元素进行分组. 会话窗口不会有重叠, 与滚动窗口和滑动窗口相比, 会话窗口也没有固定的开启和关闭时间.

如果会话窗口有一段时间没有收到数据, 会话窗口会自动关闭, 这段没有收到数据的时间就是会话窗口的gap(间隔).

我们可以配置静态的gap, 也可以通过一个gap extractor 函数来定义gap的长度. 当时间超过了这个gap, 当前的会话窗口就会关闭, 后序的元素会被分配到一个新的会话窗口.

示例代码

1.静态gap

.window(ProcessingTimeSessionWindows.withGap(Time.seconds(10)))

2.动态gap

.window(ProcessingTimeSessionWindows.withDynamicGap(new SessionWindowTimeGapExtractor<Tuple2<String, Long>>() {

@Override

public long extract(Tuple2<String, Long> element) { // 返回 gap值, 单位毫秒

return element.f0.length() * 1000;

}

}))

创建原理

因为会话窗口没有固定的开启和关闭时间, 所以会话窗口的创建和关闭与滚动,滑动窗口不同. 在Flink内部, 每到达一个新的元素都会创建一个新的会话窗口, 如果这些窗口彼此相距比较定义的gap小, 则会对他们进行合并. 为了能够合并, 会话窗口算子需要合并触发器和合并窗口函数: ReduceFunction, AggregateFunction, or ProcessWindowFunction

全局窗口(Global Windows)

全局窗口分配器会分配相同key的所有元素进入同一个 Global window. 这种窗口机制只有指定自定义的触发器时才有用. 否则, 不会做任务计算, 因为这种窗口没有能够处理聚集在一起元素的结束点.

示例代码:

.window(GlobalWindows.create());

基于元素个数的窗口

按照指定的数据条数生成一个Window,与时间无关

滚动窗口

默认的CountWindow是一个滚动窗口,只需要指定窗口大小即可,当元素数量达到窗口大小时,就会触发窗口的执行。

示例代码

.countWindow(3)

说明:那个窗口先达到3个元素, 哪个窗口就关闭. 不影响其他的窗口.

滑动窗口

滑动窗口和滚动窗口的函数名是完全一致的,只是在传参数时需要传入两个参数,一个是window_size,一个是sliding_size。下面代码中的sliding_size设置为了2,也就是说,每收到两个相同key的数据就计算一次,每一次计算的window范围最多是3个元素。

实例代码

.countWindow(3, 2)

3.窗口函数

前面指定了窗口的分配器, 接着我们需要来指定如何计算, 这事由window function来负责. 一旦窗口关闭, window function 去计算处理窗口中的每个元素.

window function 可以是ReduceFunction,AggregateFunction,or ProcessWindowFunction中的任意一种.

ReduceFunction,AggregateFunction更加高效, 原因就是Flink可以对到来的元素进行增量聚合 ProcessWindowFunction 可以得到一个包含这个窗口中所有元素的迭代器, 以及这些元素所属窗口的一些元数据信息.

ProcessWindowFunction不能被高效执行的原因是Flink在执行这个函数之前, 需要在内部缓存这个窗口上所有的元素

ReduceFunction(增量聚合函数)

package com.flink.day04_window;

import org.apache.flink.api.common.functions.FlatMapFunction;

import org.apache.flink.api.common.functions.ReduceFunction;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.windowing.assigners.TumblingProcessingTimeWindows;

import org.apache.flink.streaming.api.windowing.time.Time;

import org.apache.flink.util.Collector;

import java.util.Arrays;

/**

* @description: TODO 窗口函数之增量聚合函数:reduce

* 注意:第一个元素不会进入reduce方法

* @author: HaoWu

* @create: 2021年05月17日

*/

public class Flink03_Window_Function_ReduceFunction {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.setParallelism(2);

env.socketTextStream("localhost",9999)

.flatMap(new FlatMapFunction<String, Tuple2<String,Integer>>() {

@Override

public void flatMap(String value, Collector<Tuple2<String, Integer>> out) throws Exception {

Arrays.stream(value.split(",")).forEach(word -> out.collect(Tuple2.of(word, 1)));

}

})

.keyBy(t->t.f0)

.window(TumblingProcessingTimeWindows.of(Time.seconds(5)))

// value1是上次聚合的结果. 所以遇到每个窗口的第一个元素时, 这个函数不会进来

.reduce(new ReduceFunction<Tuple2<String, Integer>>() {

@Override

public Tuple2<String, Integer> reduce(Tuple2<String, Integer> value1, Tuple2<String, Integer> value2) throws Exception {

System.out.println(value1+"----------"+value2);

return Tuple2.of(value1.f0,value1.f1+value2.f1);

}

}).print();

env.execute();

}

}

AggregateFunction(增量聚合函数)

package com.flink.day04_window;

import org.apache.flink.api.common.functions.AggregateFunction;

import org.apache.flink.api.common.functions.FlatMapFunction;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.windowing.assigners.TumblingProcessingTimeWindows;

import org.apache.flink.streaming.api.windowing.time.Time;

import org.apache.flink.util.Collector;

import java.util.Arrays;

/**

* @description: TODO 窗口函数之增量聚合函数:aggregate

* @author: HaoWu

* @create: 2021年05月25日

*/

public class Flink04_Window_Function_AggregateFunction {

public static void main(String[] args) throws Exception {

//1.创建执行环境

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

//2.逻辑处理

env.socketTextStream("localhost", 9999)

.flatMap(new FlatMapFunction<String, Tuple2<String, Long>>() {

@Override

public void flatMap(String value, Collector<Tuple2<String, Long>> out) throws Exception {

String[] arr = value.split(",");

Arrays.stream(arr).forEach(x -> out.collect(Tuple2.of(x, 1L)));

}

})

.keyBy(x -> x.f0)

.window(TumblingProcessingTimeWindows.of(Time.seconds(5)))

.aggregate(new AggregateFunction<Tuple2<String, Long>, Long, Long>() {

// 创建累加器: 初始化中间值

@Override

public Long createAccumulator() {

System.out.println("createAccumulator");

return 0L;

}

// 累加器操作

@Override

public Long add(Tuple2<String, Long> value, Long accumulator) {

System.out.println("add");

return accumulator + value.f1;

}

// 获取结果

@Override

public Long getResult(Long accumulator) {

System.out.println("getResult");

return accumulator;

}

// 累加器的合并: 只有会话窗口才会调用

@Override

public Long merge(Long a, Long b) {

System.out.println("merge");

return a + b;

}

}

).print();

//3.执行程序

env.execute();

}

}

ProcessWindowFunction(全窗口函数)

package com.flink.day04_window;

import org.apache.flink.api.common.functions.FlatMapFunction;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.windowing.ProcessWindowFunction;

import org.apache.flink.streaming.api.windowing.assigners.TumblingProcessingTimeWindows;

import org.apache.flink.streaming.api.windowing.time.Time;

import org.apache.flink.streaming.api.windowing.windows.TimeWindow;

import org.apache.flink.util.Collector;

import java.util.Arrays;

/**

* @description: TODO 窗口函数之 全窗口函数

* @author: HaoWu

* @create: 2021年05月25日

*/

public class Flink05_Window_Function_ProcessWindowFunction {

public static void main(String[] args) throws Exception {

//1.创建执行环境

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.setParallelism(2);

//2.逻辑处理

env.socketTextStream("localhost", 9999)

.flatMap(new FlatMapFunction<String, Tuple2<String, Long>>() {

@Override

public void flatMap(String value, Collector<Tuple2<String, Long>> out) throws Exception {

String[] arr = value.split(",");

Arrays.stream(arr).forEach(x -> out.collect(Tuple2.of(x, 1L)));

}

})

.keyBy(x -> x.f0)

.window(TumblingProcessingTimeWindows.of(Time.seconds(5)))

.process(new ProcessWindowFunction<Tuple2<String, Long>, Tuple2<String,Long>, String, TimeWindow>() {

// 参数1: key 参数2: 上下文对象 参数3: 这个窗口内所有的元素 参数4: 收集器, 用于向下游传递数据

@Override

public void process(String key, Context context, Iterable<Tuple2<String, Long>> elements, Collector<Tuple2<String, Long>> out) throws Exception {

System.out.println("窗口开始:"+context.window().getStart());

long sum = 0L;

for (Tuple2<String, Long> t : elements) {

sum += t.f1;

}

out.collect(Tuple2.of(key, sum));

System.out.println("窗口结束:"+context.window().getEnd());

}

}).print();

//3.执行程序

env.execute();

}

}

4.Key和No Key的窗口区别

其实, 在用window前首先需要确认应该是在keyBy后的流上用, 还是在没有keyBy的流上使用.

在keyed streams上使用窗口, 窗口计算被并行的运用在多个task上, 可以认为每个task都有自己单独窗口. 正如前面的代码所示.

在非non-keyed stream上使用窗口, 流的并行度只能是1, 所有的窗口逻辑只能在一个单独的task上执行.

示例代码

.windowAll(TumblingProcessingTimeWindows.of(Time.seconds(10)))

需要注意的是: 非key分区的流, 即使把并行度设置为大于1 的数, 窗口也只能在某个分区上使用

Flink(八)【Flink的窗口机制】的更多相关文章

- Flink Window窗口机制

总览 Window 是flink处理无限流的核心,Windows将流拆分为有限大小的"桶",我们可以在其上应用计算. Flink 认为 Batch 是 Streaming 的一个特 ...

- 总结Flink状态管理和容错机制

本文来自8月11日在北京举行的 Flink Meetup会议,分享来自于施晓罡,目前在阿里大数据团队部从事Blink方面的研发,现在主要负责Blink状态管理和容错相关技术的研发. 本文主要内容如 ...

- Flink状态管理和容错机制介绍

本文主要内容如下: 有状态的流数据处理: Flink中的状态接口: 状态管理和容错机制实现: 阿里相关工作介绍: 一.有状态的流数据处理# 1.1.什么是有状态的计算# 计算任务的结果不仅仅依赖于输入 ...

- 《从0到1学习Flink》—— Flink 中几种 Time 详解

前言 Flink 在流程序中支持不同的 Time 概念,就比如有 Processing Time.Event Time 和 Ingestion Time. 下面我们一起来看看这几个 Time: Pro ...

- 《从0到1学习Flink》—— Flink 写入数据到 ElasticSearch

前言 前面 FLink 的文章中我们已经介绍了说 Flink 已经有很多自带的 Connector. 1.<从0到1学习Flink>-- Data Source 介绍 2.<从0到1 ...

- 《从0到1学习Flink》—— Flink Data transformation(转换)

前言 在第一篇介绍 Flink 的文章 <<从0到1学习Flink>-- Apache Flink 介绍> 中就说过 Flink 程序的结构 Flink 应用程序结构就是如上图 ...

- Android窗口机制分析与UI管理系统

类图关系 在看Android的窗口机制之前,先看看其主要的类图关系以及层级之间的依赖与调用关系 1.window在当前的android系统的中的呈现形式是PhoneWindow (frameworks ...

- TCP的滑动窗口机制【转】

原文链接:http://www.cnblogs.com/luoquan/p/4886345.html TCP这个协议是网络中使用的比较广泛,他是一个面向连接的可靠的传输协议.既然是一个可靠的 ...

- 【Android】窗口机制分析与UI管理系统

类图关系 在看Android的窗口机制之前,先看看其主要的类图关系以及层级之间的依赖与调用关系 1.window在当前的android系统的中的呈现形式是PhoneWindow (frameworks ...

随机推荐

- 便宜的回文串(区间DP)

题目链接:便宜的回文串 这道题刚开始其实还是没有思路的.没办法,只能看题解了... 其实我们在思考问题时,考虑到一段串增或减时会改变它的长度,所以转移时会麻烦... 但其实不用考虑那么多的问题,我们只 ...

- k8s入坑之路(15)kubernetes共享存储与StatefulSet有状态

共享存储 docker默认是无状态,当有状态服务时需要用到共享存储 为什么需要共享存储: 1.最常见有状态服务,本地存储有些程序会把文件保存在服务器目录中,如果容器重新启停则会丢失. 2.如果使用vo ...

- Java学到什么程度能找到一份还不错的工作

我的读者里有很多 Java 新人,新人是指正在学 Java 的.以及工作时间不长的年轻人,他们经常问我一个问题: Java 学到什么程度才能找到一份还不错的工作? 今天我就从我自己面试新人的角度来回答 ...

- Navicat for MySQL 批量执行多个 SQL 文件

文件合并 type *.sql >> aaa.sql 执行sql文件 右键点击数据库

- 服务端渲染技术NUXT

什么是服务端渲染 服务端渲染又称SSR (Server Side Render),是在服务端完成页面的内容,而不是在客户端通过AJAX获取数据. 服务器端渲染(SSR)的优势主要在于:更好的 SE ...

- 手把手教你学Dapr - 5. 状态管理

上一篇:手把手教你学Dapr - 4. 服务调用 介绍 使用状态管理,您的应用程序可以将数据作为键/值对存储在支持的状态存储中. 您的应用程序可以使用 Dapr 的状态管理 API 使用状态存储组件来 ...

- go闭包使用

1.带参数闭包函数 func main() { //先调用闭包外面的方法传给变量 add_func := add(1, 2) //再调用里面的方法,因为有了i++ 同一个内存地址 在一次编译中i的值会 ...

- 问题 N: 非洲小孩

题目描述 家住非洲的小孩,都很黑.为什么呢? 第一,他们地处热带,太阳辐射严重. 第二,他们不经常洗澡.(常年缺水,怎么洗澡.) 现在,在一个非洲部落里,他们只有一个地方洗澡,并且,洗澡时间很短,瞬间 ...

- 问题 L: Yougth的最大化

题目描述 Yougth现在有n个物品的重量和价值分别是Wi和Vi,你能帮他从中选出k个物品使得单位重量的价值最大吗? 输入 有多组测试数据 每组测试数据第一行有两个数n和k,接下来一行有n个数Wi和V ...

- Effective C++ 总结笔记(一)

一.让自己习惯C++ 01.视C++为一个语言联邦 c++是多重范型编程 语言,视c++包括4种次语言: 1:C 2:Object-Oreinted C++: 3:Template C++: 4:ST ...