TensorFlow模型保存和提取方法

一、TensorFlow模型保存和提取方法

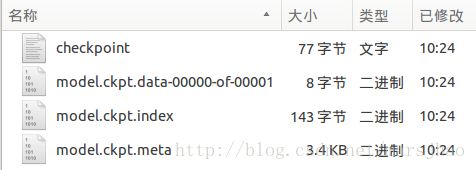

1. TensorFlow通过tf.train.Saver类实现神经网络模型的保存和提取。tf.train.Saver对象saver的save方法将TensorFlow模型保存到指定路径中,saver.save(sess,"Model/model.ckpt"),实际在这个文件目录下会生成4个人文件:

checkpoint文件保存了一个录下多有的模型文件列表,model.ckpt.meta保存了TensorFlow计算图的结构信息,model.ckpt保存每个变量的取值,此处文件名的写入方式会因不同参数的设置而不同,但加载restore时的文件路径名是以checkpoint文件中的“model_checkpoint_path”值决定的。

2. 加载这个已保存的TensorFlow模型的方法是saver.restore(sess,"./Model/model.ckpt"),加载模型的代码中也要定义TensorFlow计算图上的所有运算并声明一个tf.train.Saver类,不同的是加载模型时不需要进行变量的初始化,而是将变量的取值通过保存的模型加载进来,注意加载路径的写法。若不希望重复定义计算图上的运算,可直接加载已经持久化的图,saver =tf.train.import_meta_graph("Model/model.ckpt.meta")。

3.tf.train.Saver类也支持在保存和加载时给变量重命名,声明Saver类对象的时候使用一个字典dict重命名变量即可,{"已保存的变量的名称name": 重命名变量名},saver = tf.train.Saver({"v1":u1, "v2": u2})即原来名称name为v1的变量现在加载到变量u1(名称name为other-v1)中。

4. 上一条做的目的之一就是方便使用变量的滑动平均值。如果在加载模型时直接将影子变量映射到变量自身,则在使用训练好的模型时就不需要再调用函数来获取变量的滑动平均值了。载入时,声明Saver类对象时通过一个字典将滑动平均值直接加载到新的变量中,saver = tf.train.Saver({"v/ExponentialMovingAverage": v}),另通过tf.train.ExponentialMovingAverage的variables_to_restore()函数获取变量重命名字典。

此外,通过convert_variables_to_constants函数将计算图中的变量及其取值通过常量的方式保存于一个文件中。

二、TensorFlow程序实现

- # 本文件程序为配合教材及学习进度渐进进行,请按照注释分段执行

- # 执行时要注意IDE的当前工作过路径,最好每段重启控制器一次,输出结果更准确

- # Part1: 通过tf.train.Saver类实现保存和载入神经网络模型

- # 执行本段程序时注意当前的工作路径

- import tensorflow as tf

- v1 = tf.Variable(tf.constant(1.0, shape=[1]), name="v1")

- v2 = tf.Variable(tf.constant(2.0, shape=[1]), name="v2")

- result = v1 + v2

- saver = tf.train.Saver()

- with tf.Session() as sess:

- sess.run(tf.global_variables_initializer())

- saver.save(sess, "Model/model.ckpt")

- # Part2: 加载TensorFlow模型的方法

- import tensorflow as tf

- v1 = tf.Variable(tf.constant(1.0, shape=[1]), name="v1")

- v2 = tf.Variable(tf.constant(2.0, shape=[1]), name="v2")

- result = v1 + v2

- saver = tf.train.Saver()

- with tf.Session() as sess:

- saver.restore(sess, "./Model/model.ckpt") # 注意此处路径前添加"./"

- print(sess.run(result)) # [ 3.]

- # Part3: 若不希望重复定义计算图上的运算,可直接加载已经持久化的图

- import tensorflow as tf

- saver = tf.train.import_meta_graph("Model/model.ckpt.meta")

- with tf.Session() as sess:

- saver.restore(sess, "./Model/model.ckpt") # 注意路径写法

- print(sess.run(tf.get_default_graph().get_tensor_by_name("add:0"))) # [ 3.]

- # Part4: tf.train.Saver类也支持在保存和加载时给变量重命名

- import tensorflow as tf

- # 声明的变量名称name与已保存的模型中的变量名称name不一致

- u1 = tf.Variable(tf.constant(1.0, shape=[1]), name="other-v1")

- u2 = tf.Variable(tf.constant(2.0, shape=[1]), name="other-v2")

- result = u1 + u2

- # 若直接生命Saver类对象,会报错变量找不到

- # 使用一个字典dict重命名变量即可,{"已保存的变量的名称name": 重命名变量名}

- # 原来名称name为v1的变量现在加载到变量u1(名称name为other-v1)中

- saver = tf.train.Saver({"v1": u1, "v2": u2})

- with tf.Session() as sess:

- saver.restore(sess, "./Model/model.ckpt")

- print(sess.run(result)) # [ 3.]

- # Part5: 保存滑动平均模型

- import tensorflow as tf

- v = tf.Variable(0, dtype=tf.float32, name="v")

- for variables in tf.global_variables():

- print(variables.name) # v:0

- ema = tf.train.ExponentialMovingAverage(0.99)

- maintain_averages_op = ema.apply(tf.global_variables())

- for variables in tf.global_variables():

- print(variables.name) # v:0

- # v/ExponentialMovingAverage:0

- saver = tf.train.Saver()

- with tf.Session() as sess:

- sess.run(tf.global_variables_initializer())

- sess.run(tf.assign(v, 10))

- sess.run(maintain_averages_op)

- saver.save(sess, "Model/model_ema.ckpt")

- print(sess.run([v, ema.average(v)])) # [10.0, 0.099999905]

- # Part6: 通过变量重命名直接读取变量的滑动平均值

- import tensorflow as tf

- v = tf.Variable(0, dtype=tf.float32, name="v")

- saver = tf.train.Saver({"v/ExponentialMovingAverage": v})

- with tf.Session() as sess:

- saver.restore(sess, "./Model/model_ema.ckpt")

- print(sess.run(v)) # 0.0999999

- # Part7: 通过tf.train.ExponentialMovingAverage的variables_to_restore()函数获取变量重命名字典

- import tensorflow as tf

- v = tf.Variable(0, dtype=tf.float32, name="v")

- # 注意此处的变量名称name一定要与已保存的变量名称一致

- ema = tf.train.ExponentialMovingAverage(0.99)

- print(ema.variables_to_restore())

- # {'v/ExponentialMovingAverage': <tf.Variable 'v:0' shape=() dtype=float32_ref>}

- # 此处的v取自上面变量v的名称name="v"

- saver = tf.train.Saver(ema.variables_to_restore())

- with tf.Session() as sess:

- saver.restore(sess, "./Model/model_ema.ckpt")

- print(sess.run(v)) # 0.0999999

- # Part8: 通过convert_variables_to_constants函数将计算图中的变量及其取值通过常量的方式保存于一个文件中

- import tensorflow as tf

- from tensorflow.python.framework import graph_util

- v1 = tf.Variable(tf.constant(1.0, shape=[1]), name="v1")

- v2 = tf.Variable(tf.constant(2.0, shape=[1]), name="v2")

- result = v1 + v2

- with tf.Session() as sess:

- sess.run(tf.global_variables_initializer())

- # 导出当前计算图的GraphDef部分,即从输入层到输出层的计算过程部分

- graph_def = tf.get_default_graph().as_graph_def()

- output_graph_def = graph_util.convert_variables_to_constants(sess,

- graph_def, ['add'])

- with tf.gfile.GFile("Model/combined_model.pb", 'wb') as f:

- f.write(output_graph_def.SerializeToString())

- # Part9: 载入包含变量及其取值的模型

- import tensorflow as tf

- from tensorflow.python.platform import gfile

- with tf.Session() as sess:

- model_filename = "Model/combined_model.pb"

- with gfile.FastGFile(model_filename, 'rb') as f:

- graph_def = tf.GraphDef()

- graph_def.ParseFromString(f.read())

- result = tf.import_graph_def(graph_def, return_elements=["add:0"])

- print(sess.run(result)) # [array([ 3.], dtype=float32)]

TensorFlow模型保存和提取方法的更多相关文章

- tensorflow 模型保存与加载 和TensorFlow serving + grpc + docker项目部署

TensorFlow 模型保存与加载 TensorFlow中总共有两种保存和加载模型的方法.第一种是利用 tf.train.Saver() 来保存,第二种就是利用 SavedModel 来保存模型,接 ...

- TensorFlow模型保存和加载方法

TensorFlow模型保存和加载方法 模型保存 import tensorflow as tf w1 = tf.Variable(tf.constant(2.0, shape=[1]), name= ...

- TensorFlow 模型保存/载入

我们在上线使用一个算法模型的时候,首先必须将已经训练好的模型保存下来.tensorflow保存模型的方式与sklearn不太一样,sklearn很直接,一个sklearn.externals.jobl ...

- Tensorflow模型保存与加载

在使用Tensorflow时,我们经常要将以训练好的模型保存到本地或者使用别人已训练好的模型,因此,作此笔记记录下来. TensorFlow通过tf.train.Saver类实现神经网络模型的保存和提 ...

- 10 Tensorflow模型保存与读取

我们的模型训练出来想给别人用,或者是我今天训练不完,明天想接着训练,怎么办?这就需要模型的保存与读取.看代码: import tensorflow as tf import numpy as np i ...

- 一份快速完整的Tensorflow模型保存和恢复教程(译)(转载)

该文章转自https://blog.csdn.net/sinat_34474705/article/details/78995196 我在进行图像识别使用ckpt文件预测的时候,这个文章给我提供了极大 ...

- 转 tensorflow模型保存 与 加载

使用tensorflow过程中,训练结束后我们需要用到模型文件.有时候,我们可能也需要用到别人训练好的模型,并在这个基础上再次训练.这时候我们需要掌握如何操作这些模型数据.看完本文,相信你一定会有收获 ...

- tensorflow 模型保存后的加载路径问题

import tensorflow as tf #保存模型 saver = tf.train.Saver() saver.save(sess, "e://code//python//test ...

- tensorflow 模型保存

1.首先 saver = tf.train.Saver(max_to_keep=1)新建一个saver,max_to_keep是说只保留最后一轮的训练结果 2.使用save方法保存模型 saver.s ...

随机推荐

- Android面试题整理

1. 请描述下Activity的生命周期. 2. 如果后台的Activity由于某原因被系统回收了,如何在被系统回收之前保存当前状态? 3. 如何将一个Activity设置成窗口的样 ...

- 0GDB调试程序进阶

http://www.cnblogs.com/azraelly/archive/2012/12/22/2829256.html 下面只列举我认为重要的 0.反汇编命令disas/disass/disa ...

- 如何创建 Visual Studio 2017 RC 离线安装包

创建 Visual Studio 的离线安装计划 首先下载相应版本的可执行文件,例如:vs_community.exe.vs_enterprise.exe 或 vs_professional 在 cm ...

- 高级C/C++编译技术之读书笔记(二)之库的概念

最近有幸阅读了<高级C/C++编译技术>深受启发,该书深入浅出地讲解了构建过程(编译.链接)中的各种细节,从多个角度展示了程序与库文件或代码的集成方法,提出了面向代码复用和系统集成的软件架 ...

- LOJ#2351. 「JOI 2018 Final」毒蛇越狱

LOJ#2351. 「JOI 2018 Final」毒蛇越狱 https://loj.ac/problem/2351 分析: 首先有\(2^{|?|}\)的暴力非常好做. 观察到\(min(|1|,| ...

- 文本溢出显示省略号,CSS未加载时a标签仍可用处理方法

一.文本溢出打点 (1)单行文本 overflow: hidden; text-overflow:ellipsis; white-space: nowrap; (2)多行文本 overflow : h ...

- ASP.NET 2.0缓存

MSDN上缓存概述: http://msdn2.microsoft.com/zh-cn/library/726btaeh(VS.80).aspx 一.页输出缓存 1.设置 ASP.NET 页缓存的两种 ...

- (装)Android杂谈--禁止TimePicker控件通过keyboard输入

Android 4.1版本以上用的是类似与ios的滚动时间控件,但是4.1以下,用的TimePicker确实通过点击上下按钮来更改时间的,虽然也提供了编辑框编辑,但是可能会超出编辑范围 如果要禁止编辑 ...

- RK3288 Android5.1系统编译

输入指令时一定要注意当前路径 1.编译之前需要安装JDK7,并配置JAVA环境变量. xxx@build:~/RK3288$ export JAVA_HOME=/usr/lib/jvm/java-7- ...

- optimize table tablename

optimize 优化表OPTIMIZE 命令支持的引擎MyIsam, InnoDB, ARCHVE当对表有大量的增删改操作时,需要用optimize对表进行优化,可以减少空间与提高I/O性能,命令o ...