【python爬虫】用python编写LOL战绩查询

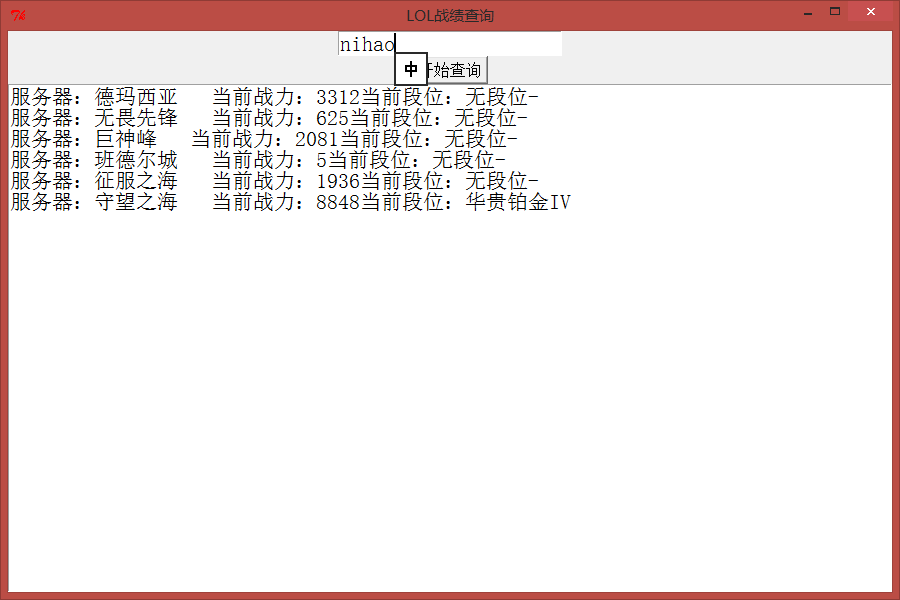

介绍一个简单的python爬虫,通过Tkinter创建一个客户端,当输入要查询的LOL用户名称的时候,可以显示出当前用户的所在服务器,当前战力和当前段位。

爬取网页地址:http://lol.duowan.com/zdl/

python版本:2.7

需要用到的模块:Tkinter urllib2 json sys

实例代码:

import urllib2, json, threading

from Tkinter import *

import sys reload(sys)

sys.setdefaultencoding('utf-8') def get_zhanji():

name = str(et.get())

url = 'http://api.lolbox.duowan.com/api/v2/player/search/?player_name_list=%s&callback=jQuery111200161216930093' \

'95033_1470488155157&_=1470488155158' % name

res = urllib2.urlopen(url)

html = res.read()[44:-1]

print html

zhanji = json.loads(html)[u'player_list']

t.delete(0.0, END)

for i in zhanji:

print '服务器:%s 当前战力:%s' % (i['game_zone']['alias'], i['box_score'])

print '当前段位:%s' % (i['tier_rank']['tier']['full_name_cn'] + i['tier_rank']['rank']['name'])

# print i['game_zone']['alias']

# print zhangji

# print html

t.insert(END, '服务器:%s 当前战力:%s' % (i['game_zone']['alias'], i['box_score']))

t.insert(END, '当前段位:%s\n' % (i['tier_rank']['tier']['full_name_cn'] + i['tier_rank']['rank']['name'])) def rukou():

if et.get() == '':

print '请输入召唤师名称'

else:

get_zhanji() # def qidong():

# t1 = threading.Thread(target=rukou)

# t1.start()

# get_zhanji()

# print len(jQuery11120016121693009395033_1470488155157() root = Tk()

root.title('LOL战绩查询')

root.geometry() et = Entry(root, font=('宋体, 16'))

et.grid() b = Button(root, text='开始查询', font=('宋体, 12'), command=rukou)

b.grid() t = Text(root, font=('宋体, 16'))

t.grid() root.mainloop()

界面效果展示:

【python爬虫】用python编写LOL战绩查询的更多相关文章

- python爬虫之12306网站--火车票信息查询

python爬虫之12306网站--火车票信息查询 思路: 1.火车票信息查询是基于车站信息查询,先完成车站信息查询,然后根据车站信息查询生成的url地址去查询当前已知出发站和目的站的所有车次车票信息 ...

- 零基础学习Python web开发、Python爬虫、Python数据分析,从基础到项目实战!

随着大数据和人工智能的发展,目前Python语言的上升趋势比较明显,而且由于Python语言简单易学,所以不少初学者往往也会选择Python作为入门语言. Python语言目前是IT行业内应用最为广泛 ...

- python爬虫之12306网站--车站信息查询

python爬虫查询车站信息 目录: 1.找到要查询的url 2.对信息进行分析 3.对信息进行处理 python爬虫查询全拼相同的车站 目录: 1.找到要查询的url 2.对信息进行分析 3.对信息 ...

- Python爬虫《Python网络爬虫相关基础概念》

引入 之前在授课过程中,好多同学都问过我这样的一个问题:为什么要学习爬虫,学习爬虫能够为我们以后的发展带来那些好处?其实学习爬虫的原因和为我们以后发展带来的好处都是显而易见的,无论是从实际的应用还是从 ...

- Python 爬虫+tkinter界面 实现历史天气查询

文章目录 一.实现效果 1. python代码 2. 运行效果 二.基本思路 1. 爬虫部分 2. tkinter界面 一.实现效果 很多人学习python,不知道从何学起.很多人学习python,掌 ...

- 【Python爬虫】第四课(查询照片拍摄地址)

首先,要能够查询到照片地址,查询的照片必须要开GPS拍,且上传时用原图…… 查询图片的exif信息,使用exifread包 import exifread img = exifread.process ...

- [Python爬虫]使用Selenium操作浏览器订购火车票

这个专题主要说的是Python在爬虫方面的应用,包括爬取和处理部分 [Python爬虫]使用Python爬取动态网页-腾讯动漫(Selenium) [Python爬虫]使用Python爬取静态网页-斗 ...

- 一个Python爬虫工程师学习养成记

大数据的时代,网络爬虫已经成为了获取数据的一个重要手段. 但要学习好爬虫并没有那么简单.首先知识点和方向实在是太多了,它关系到了计算机网络.编程基础.前端开发.后端开发.App 开发与逆向.网络安全. ...

- python 爬虫使用

python爬虫架构 Python 爬虫架构主要由五个部分组成,分别是 调度器.URL管理器.网页下载器.网页解析器.应用程序. 调度器:相当于一台电脑的CPU,主要负责调度URL管理器.下载器.解析 ...

随机推荐

- 【转】Android Android属性动画深入分析

转载请注明出处:http://blog.csdn.net/singwhatiwanna/article/details/17841165 开篇 像设计模式一样,我们也提出一个问题来引出我们的内容. 问 ...

- 停止Nginx服务

查询nginx进程信息 chen@ubuntu:~$ ps -ef |grep nginx root : ? :: nginx: master process /usr/sbin/nginx -g d ...

- xmlreader与xmlwriter里的几个坑与解决方案

加载超过100M的xml文件时(可能不是很常见),XmlDocument这种全部加载到内存里的模式就有点不友好了,耗时长.内存高. 这时用xmlreader就会有自行车换超跑的感觉,但其间遇到几个坑, ...

- WinForm中的焦点

窗口打开后默认的焦点在TabIndex为0的元素上,即使代码中在其他元素上设置了Focus(),也没用,所以初始状态最好通过TabIndex来控制. WebForm中点其他如空白地方,之前的控件就会失 ...

- raiden_graph

使用mermaid描述 raiden 通道 AB,正常状态 graph LR A-- 60,100,S_100 ---B 通道 AB closed graph LR A((A)) -. 60,100 ...

- 比较php字符串连接的效率

php字符串连接有三种方式 1)使用 . 链接 2)使用 .= 连接 3)implode 函数连接数组元素 /*以下测试在ci框架进行*/ private function get_mcrotime( ...

- lamp centos下一键安装

系统需求 系统支持:CentOS 6+/Debian 7+/Ubuntu 12+ 内存要求:≥ 512MB 硬盘要求:至少 5GB 以上的剩余空间 服务器必须配置好 软件源 和 可连接外网 必须具有系 ...

- 最新cenos执行service httpd restart 报错Failed to restart httpd.service: Unit not found.

原来是需要将Apache注册到Linux服务里面啊!注册Apache到Linux服务在Linux下用源代码方式编译安装完Apache后,启动关闭Apache可以通过如下命令实现: /usr/local ...

- centos安装mysql57

下载源安装文件 https://dev.mysql.com/downloads/repo/yum/ wget http://repo.mysql.com//mysql57-community-rele ...

- scrapy的 安装 及 流程 转

安装 linux 和 mac 直接 pip install scrapy 就行 windows 安装步骤 a. pip3 install wheel b. 下载twist ...